一、背景

随着企业不断发展,企业产生大量数据,对数据进行处理时,为了不影响业务系统的使用,由于企业数据分析需要,需要将业务系统的数据转存到数据分析系统,将大量数据从一个库同步到另一个库当中,以供专门的数据分析所用。

二、遇到的问题

1、企业传统数据不足方式,是采用select+ insert的方式,进行一张表一张表补数据。存在效率较低,运维工作量大,客户难理解难操作的问题。

2、有一定开发能力的公司,会采用数据库日志解析的方式,但采用这种方式的情况下,由于源库日志解析效率、源库与目标库负载、稳定性等原因,有时会出现数据差异情况。差异发生后,若不能及时处理,将大大降低业务效率。

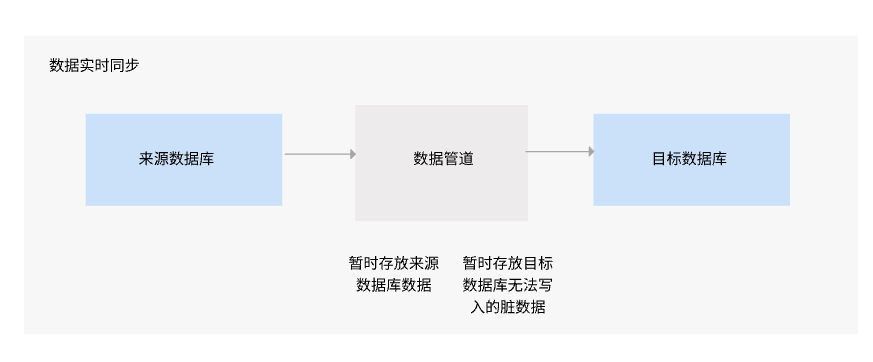

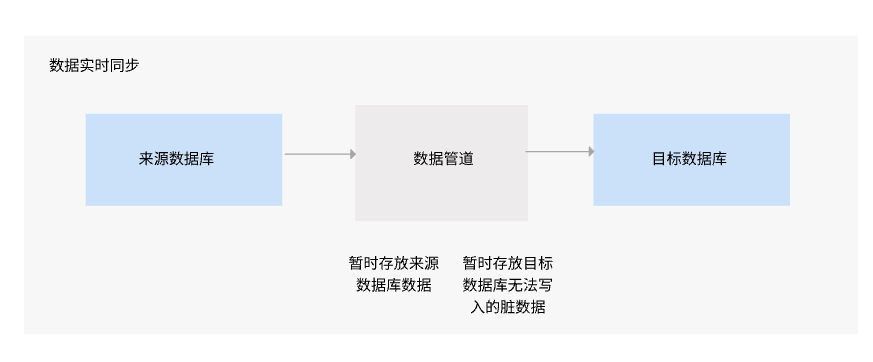

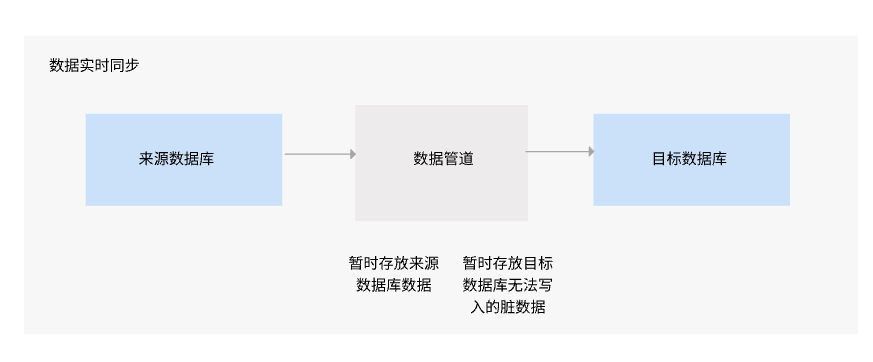

(一)全库原表原样实时数据同步

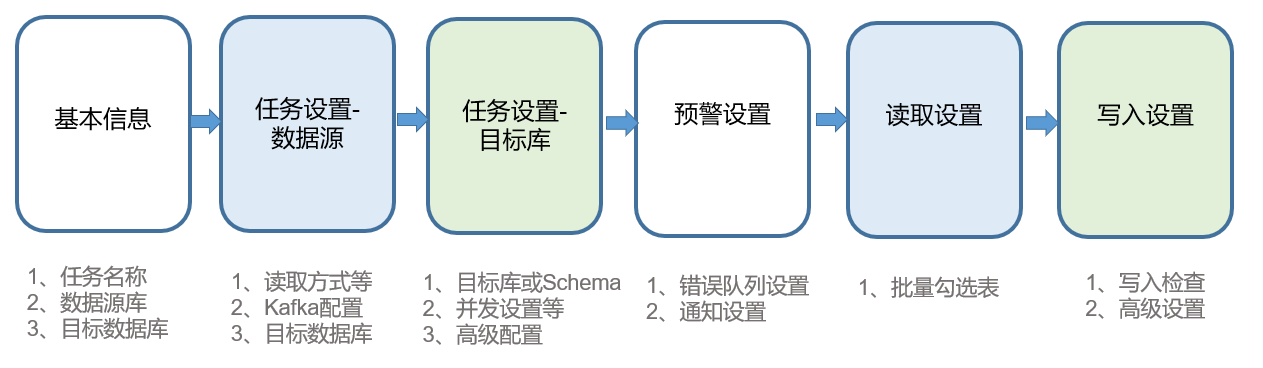

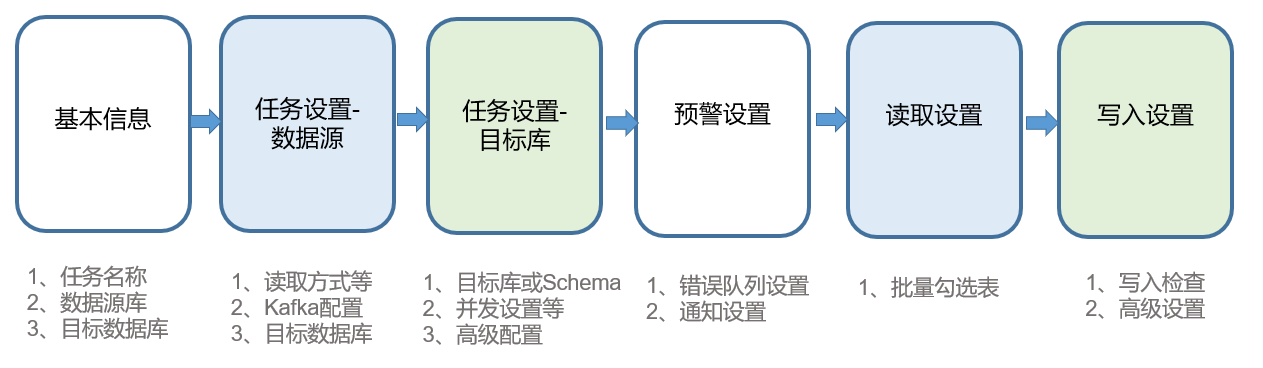

FineDataLink数据集成平台中的数据管道模块提供全库原表原样实时同步,相对于传统一张表一张表的流式数据同步方式。数据管道可以实现批量选表、从一个库到另一个库的批量数据实时同步。

例如,企业需对 MySQL库中的一千张表导入另一个库中,以往需要业务人员一张表一张表进行处理,操作复杂,耗时长。使用数据管道后,只需一键勾选想要导入的库,就能做到全库原表原样批量实时数据同步。

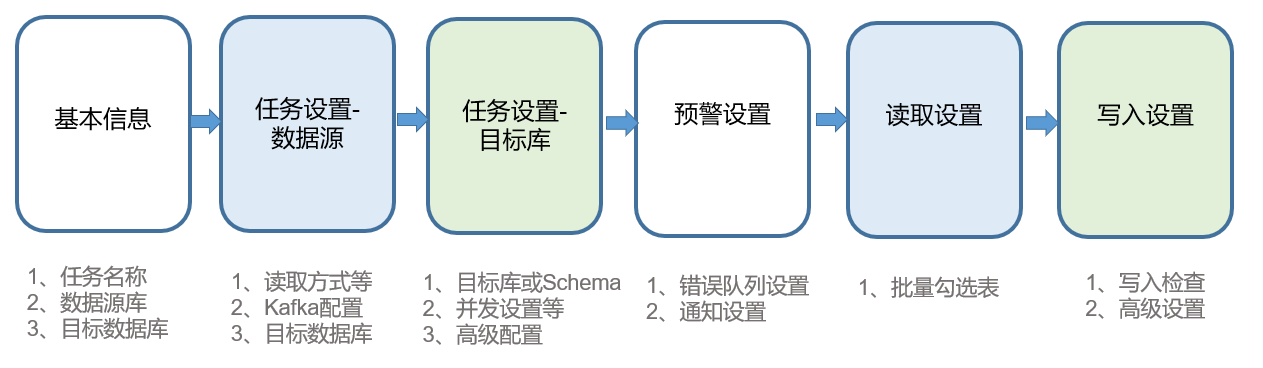

同时,FineDataLink将数据管道任务运行情况可视化,便于业务人员操作。支持创建实时数据管道任务、启动和暂停任务、查看任务详情以及删除该任务。

(二)重新同步存量数据

当用户发现部分表数据存在差异时,FineDataLink数据管道的用户操作由原来的自行配置对应流任务重新同步,简化为一键快速重新同步,提升了问题处理效率,降低了运维的复杂度和压力。可以快速便捷地处理差异,减少数据异常对业务的影响时间,保证源侧与目标侧数据一致。

例如,管道数据同步任务使用的数据源为 MySQL,若源库的 binlog 日志保留日期有7天,但是任务中断了3天没有运行,当3天后启动任务时,可以从数据源端的 binlog 保存的断点处开始继续进行数据解析同步,从而保证数据的一致性。

(三)实时消息提醒,设置错误队列

为帮助用户更好的管理数据任务,数据管道还提供消息列表。每次发起操作请求时,就会记录该条信息进入消息列表,每条消息包含:时间、操作人、发生的事件信息。若该操作失败,将在消息列表提示用户操作失败。

为了帮助用户更快速地处理错误信息,FineDataLink数据管道还增加错误队列功能。

错误队列实时收集所有的数据同步相关错误,并展现给数据工程师。数据工程师针对每一个数据任务设定不同阈值,错误队列的错误率达到对应值时会对数据任务采取不同的预警方式,包括对任务的暂停,后置处理数据同步相关问题等,由此规避了数据错误导致的执行效率问题,并减轻了数据工程师的工作压力。

FineDataLink数据集成平台还有更多值的探索!

除上述功能外,FineDataLink数据集成平台支持在线流、批处理的多引擎任务开发,开发者通过拖拉拽的方式进行数据流处理,提供零代码Data API 开发管理、敏捷发布,为企业BI、报表等提供快速的数据支撑,为数字化转型提供支持。

产品更多介绍:点击此处,直达官网