怎么确保数据准确性与完整性?一步步带你优化ETL过程!

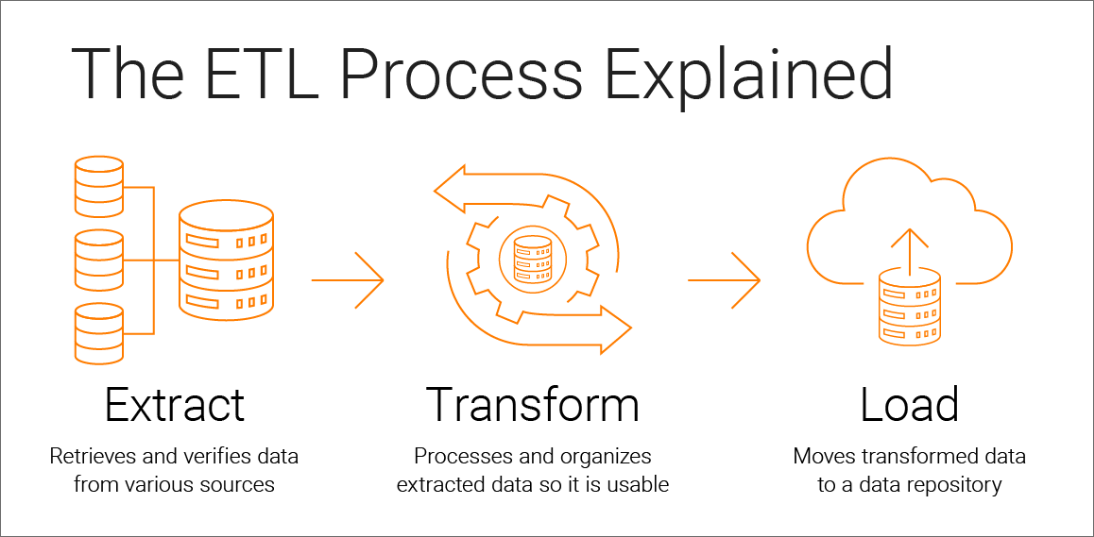

在数据仓库中,ETL(抽取、转换、加载)过程是确保数据准确性和完整性的核心步骤。然而,由于多种原因(如数据质量问题和源数据变更),ETL过程中常常会出现错误。为了保证数据处理的稳定性和可靠性,有效的错误处理和回滚策略是必不可少的。

一、错误处理

在ETL过程中,常见的错误类型包括数据类型不匹配、数据丢失和数据重复等。

这些错误可能由于数据源结构变更、数据采集不完整或处理逻辑错误等原因引起。若不及时发现和处理这些错误,可能会导致数据仓库中的数据不准确或不完整,进而影响后续的数据分析和业务决策。

1、数据类型不匹配

数据类型不匹配是指源数据和目标数据表之间的数据类型不一致。例如,在数据抽取过程中,源数据中的一个字段为字符串类型,而目标数据表中对应字段为整数类型,这样的数据类型不匹配可能导致数据转换错误或丢失精度。为应对这种情况,ETL过程中应该有严格的数据类型映射规则,并在数据加载前进行数据类型转换或者数据校验,确保数据类型的一致性。

2、数据丢失

数据丢失是指源数据中的部分记录在ETL过程中未能正确抽取或加载到目标数据表中。可能的原因包括源数据源头数据缺失、ETL过程中的筛选条件问题或数据加载失败等。为防止数据丢失,应该建立全面的数据源监控机制,及时发现源数据变更或数据源异常,确保数据采集的完整性。

3、数据重复

数据重复是指在目标数据表中出现重复的记录。这可能是由于ETL过程中未对重复数据进行去重操作或者数据加载规则不严谨导致的。数据重复会浪费存储空间,并在数据分析时引入偏差。为避免数据重复,ETL过程应该设计合理的去重策略,并在数据加载前进行重复数据的检查和处理。

为了优化ETL过程,除了以上提到的策略外,还可以考虑以下补充措施:

1、数据合理性检查:

在ETL过程中,引入数据合理性检查是非常重要的。通过设定规则和规范数据的取值范围,可以排除不符合要求的异常数据,提高数据质量。

2、增量抽取:

对于数据量较大的数据源,可以采用增量抽取的方式,只抽取新增或更新的数据,以减少ETL过程的时间和资源消耗,并保持数据的实时性。

3、定期性能优化:

随着数据量的增长和业务的变化,ETL过程可能会出现性能下降的情况。定期进行性能优化和调整是必要的,以确保ETL过程的高效运行。

4、持续监控和反馈:

建立持续监控机制,定期检查ETL过程中的错误日志和数据质量情况。同时,充分借助用户反馈和数据分析结果,不断改进ETL过程,以满足不断变化的业务需求。

确保数据准确性的回滚策略

1、原子性操作

将相关操作封装成原子性,确保出现错误时可以回滚到最近的操作点,维持数据一致性。

2、 事务管理

采用事务管理机制,保证ETL过程中的数据操作要么全部成功,要么全部回滚,避免数据不一致性。

3、数据备份和恢复

定期进行数据备份,并确保备份数据的可用性。在发生错误时,通过恢复备份数据回滚到上一次正常状态。

ETL过程中的错误处理和回滚策略对于保证数据准确性和完整性至关重要。通过细致的数据质量检查、异常处理机制和合理的回滚策略,可以提高数据处理的稳定性和可靠性。补充措施和持续优化将进一步提升ETL过程的效率和质量,为数据仓库的建设贡献更多价值。

FineDataLink 是一款低代码/高时效的ETL数据集成平台,支持数据准确性和完整性,以及优化的错误处理和回滚策略,有助于在数据处理中取得卓越成果。

立即沟通

立即沟通