想要实现实时数据同步?五步教你玩转实时数据管道

在构建数据仓库和中间库时,如果企业业务数据量级较大,将会面临以下两个问题:

· 使用数据同步批量定时同步数据:很难做到高性能的增量同步。

· 使用清空目标表再写入数据的方式:面临目标表一段时间不可用、抽取耗时长等问题。

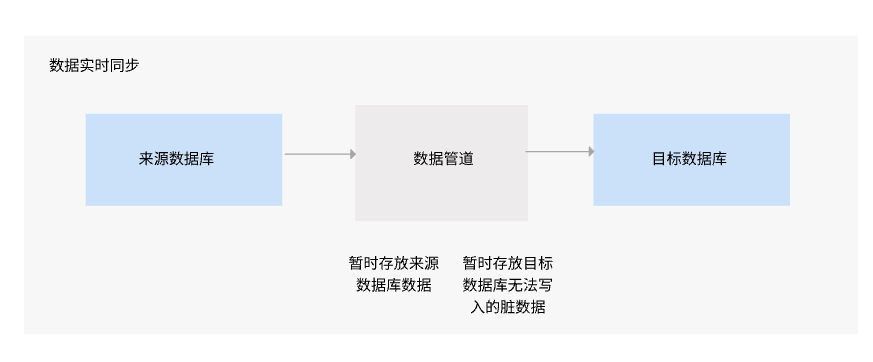

因此,我们希望能在数据库数据量级较大或表结构较规范的情况下,实现高性能的数据实时同步,那么就需要使用数据集成工具来配置实时数据管道。

帆软软件推出的数据集成工具FineDataLink可以实现数据管道,帮助企业快速构建高效稳定的数据处理流程,提高数据处理的效率和质量。使用帆软FDL实时数据管道任务的配置如下:

1、消息队列配置

读写两端分离,暂存不能正常写入目标库的脏数据,从而实现高性能,保证数据的完整性。

2、异构数据源和目的地选择

屏蔽不同业务系统的独特性和差异性,从底层数据存储入手,扩大支撑范围,让数据实时同步简单易用。目前帆软FDL支持从MySQL、SQL Server、Oracle、PostgreSQL、GaussDB 200、GreenPlum等之间的整库全部表、多表进行数据实时同步。

目标库的表的选择如下:

· 自动创建:自动创建新的目标表

· 已存在表:用于历史任务迁移、目标表已存在等场景。

数据实时同步时,如果来源端结构因业务调整等原因发生变动,如增删表、增删字段、修改字段名称、修改字段类型等,目标端也可以自动同步这些来源端的调整,不需要进行人为的调整适配。

3、自动表字段映射

当需要异构数据库同步时,字段自动映射功能,不用手动进行自动映射,提高配置环节效率。同时支持目标端的更多自定义修改,例如编辑表名,编辑、删除、重命名字段名,新增字段主键、非空等配置,规范数据输出标准。

4、管道控制

遇到脏数据等问题时,可以通过设置阈值使整个数据实时同步过程正常运行。当脏数据到达一定程度,平台会自动发送短信、邮件或企业微信等进行通知,然后进行异常数据处理。

5、任务监控

整个数据实时同步过程完全透明,完成任务配置就可以在监控页面看到读取、输出的总量和速度,以及是否存在脏数据和待同步数据。

FineDataLink——中国领先的低代码/高时效数据集成工具,能够为企业提供一站式的数据服务,通过快速连接、高时效融合多种数据,提供低代码Data API敏捷发布平台,帮助企业解决数据孤岛难题,有效提升企业数据价值。

立即沟通

立即沟通