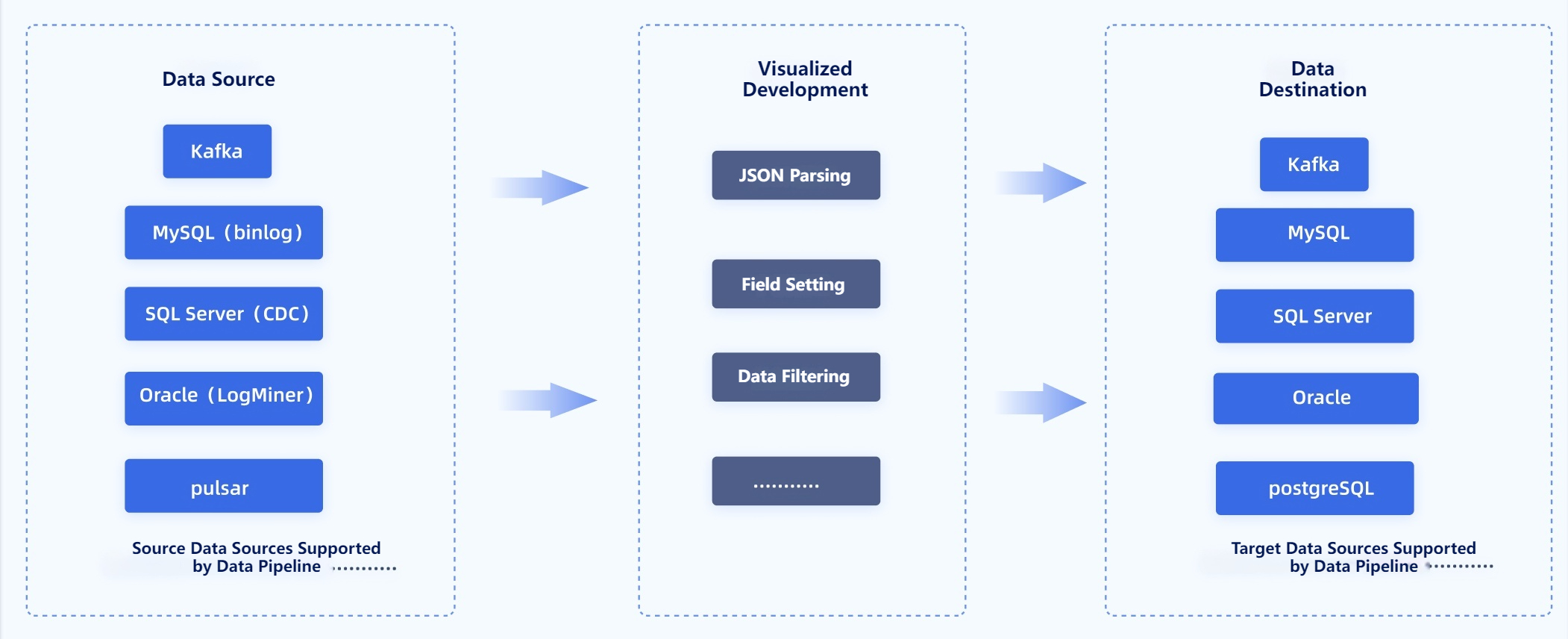

Data pipeline adalah rangkaian proses yang digunakan untuk mengumpulkan, memindahkan, dan mengolah data dari berbagai sumber hingga mencapai tujuan akhir. Proses ini memastikan data dapat diakses dengan cepat dan dalam format yang sesuai untuk analisis. Dalam pengelolaan data modern, data pipeline memegang peran penting karena membantu organisasi mengatasi tantangan seperti data yang terfragmentasi, format yang beragam, dan kebutuhan analisis real-time. Dengan data pipeline, Anda dapat mengoptimalkan alur data untuk mendukung pengambilan keputusan yang lebih baik.

Data pipeline adalah sistem yang dirancang untuk mengelola aliran data dari satu titik ke titik lainnya. Sistem ini mencakup proses otomatis seperti ekstraksi, transformasi, dan pemuatan data (ETL/ELT). Dengan data pipeline, Anda dapat menentukan bagaimana data dikumpulkan, diproses, dan disimpan untuk mendukung kebutuhan bisnis.

Bayangkan data pipeline seperti pipa yang mengalirkan air. Data dari berbagai sumber masuk ke dalam pipa, diproses sesuai kebutuhan, dan akhirnya mencapai tujuan akhir dalam bentuk yang siap digunakan. Proses ini memastikan data yang dihasilkan relevan, akurat, dan dapat diandalkan untuk analisis atau pengambilan keputusan.

Beberapa langkah utama dalam data pipeline meliputi:

Data pipeline terdiri dari beberapa komponen penting yang bekerja secara sinergis untuk memastikan alur data berjalan lancar. Berikut adalah komponen utamanya:

Setiap komponen ini memainkan peran penting dalam memastikan data yang dihasilkan berkualitas tinggi dan siap digunakan. Dengan data pipeline yang dirancang dengan baik, Anda dapat mengurangi risiko kesalahan, meningkatkan efisiensi, dan mempercepat proses pengambilan keputusan.

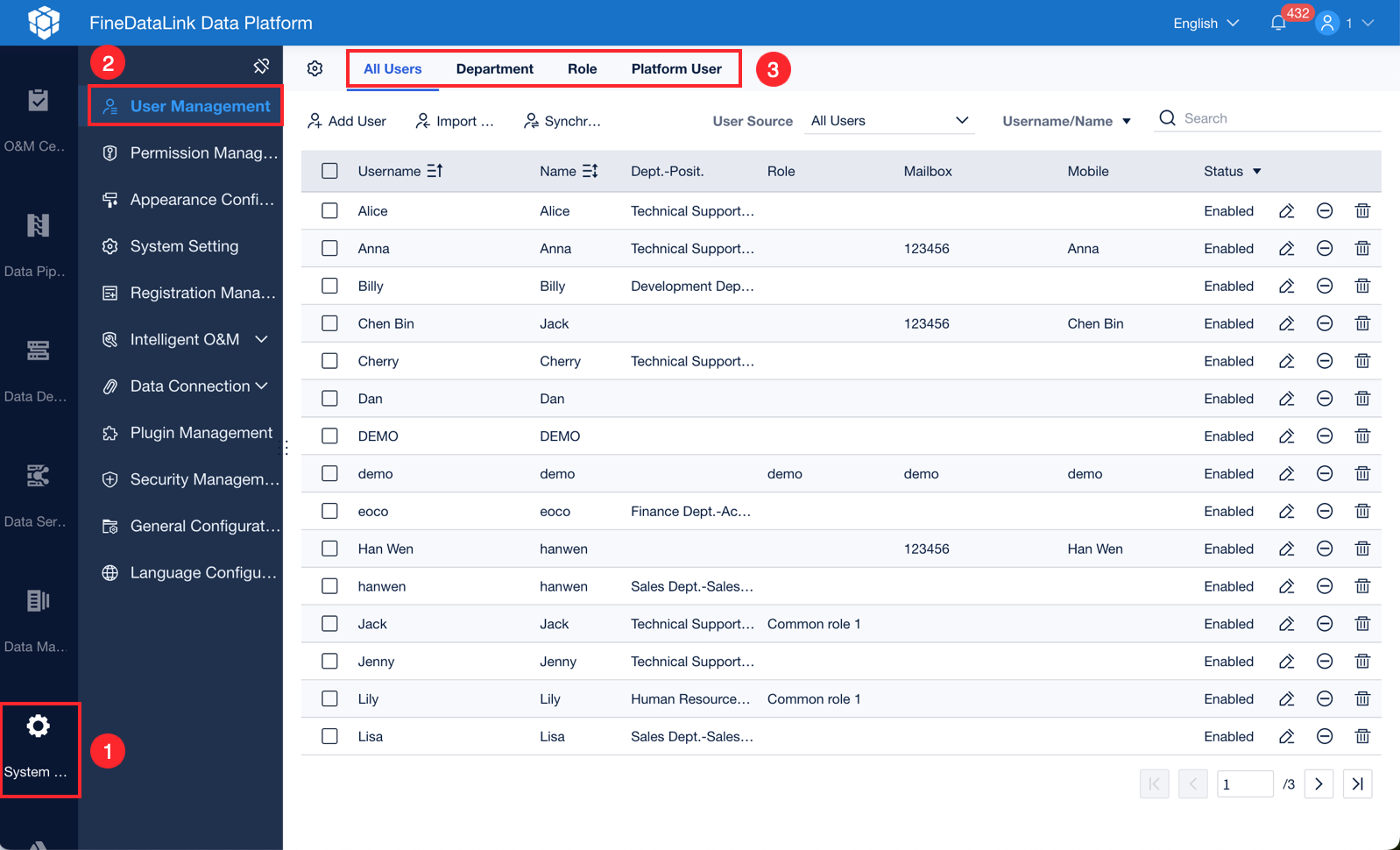

FineDataLink adalah platform integrasi data modern yang dirancang untuk menyederhanakan proses data pipeline. Platform ini menawarkan solusi yang efisien untuk mengelola data dari berbagai sumber hingga mencapai tujuan akhir. Berikut adalah beberapa peran utama FineDataLink dalam data pipeline:

| Aspek | Penjelasan |

|---|---|

| Meningkatkan Analisis | FineDataLink membantu perusahaan mengumpulkan data dari berbagai sumber untuk analisis yang lebih akurat. |

| Meningkatkan Kualitas | Melakukan pembersihan data otomatis, menghilangkan duplikasi, dan memvalidasi data untuk keputusan yang akurat. |

| Meningkatkan Efisiensi | Mengotomatiskan proses pengambilan, pemrosesan, dan penyimpanan data, mengurangi waktu dan upaya manual. |

| Keandalan Data | Memastikan data yang digunakan untuk pengambilan keputusan adalah akurat dan andal, mendukung kinerja bisnis yang lebih baik. |

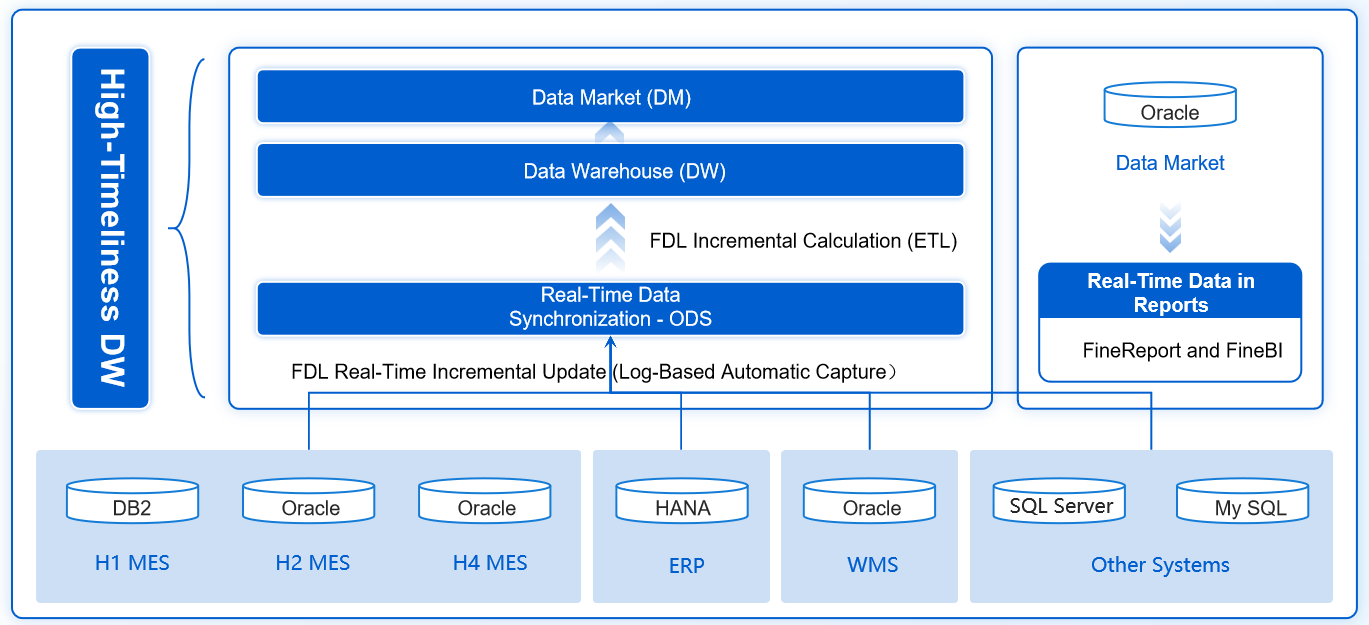

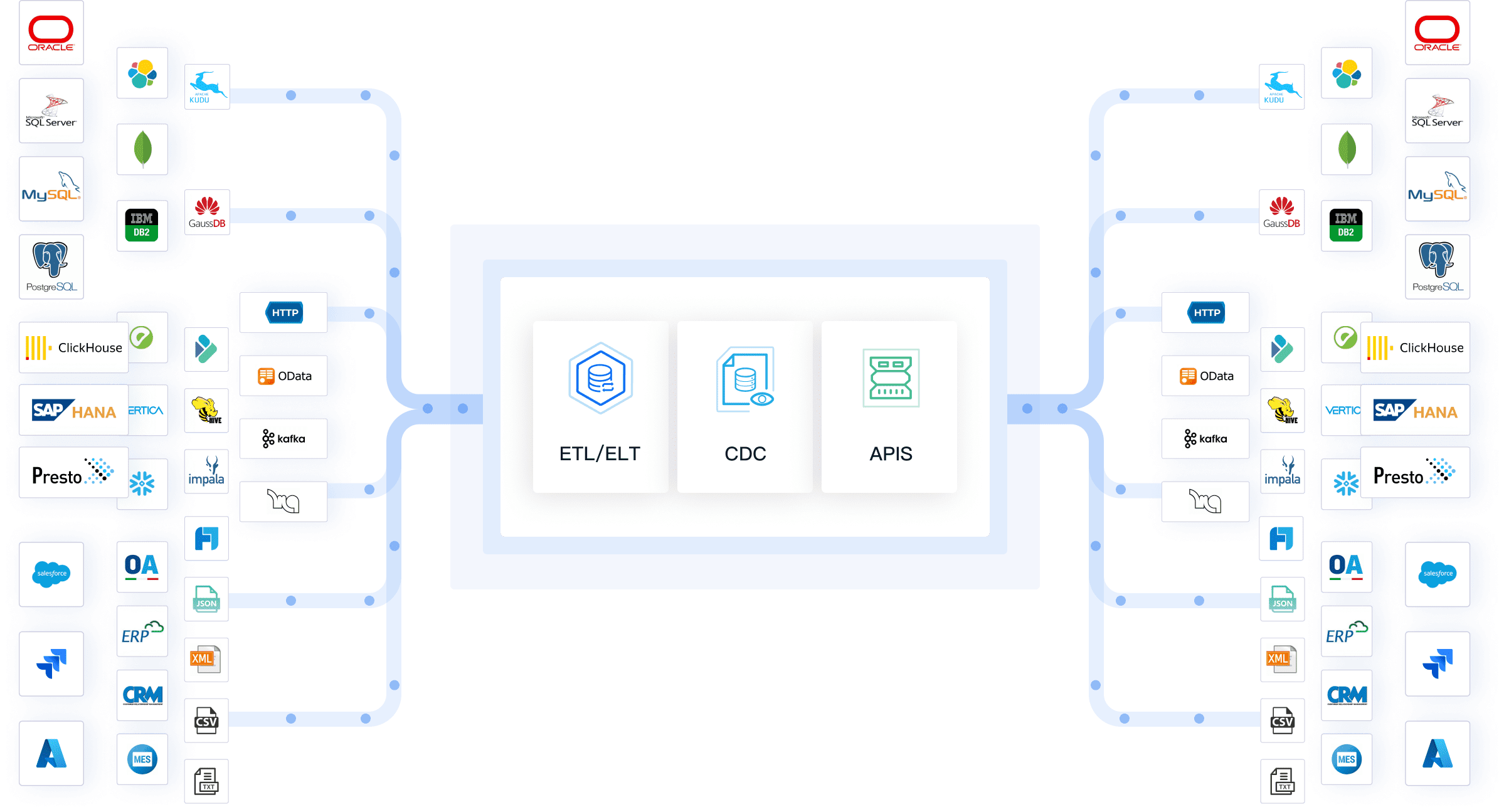

FineDataLink juga mendukung sinkronisasi data real-time, memungkinkan Anda untuk memproses data dengan latensi minimal. Dengan antarmuka drag-and-drop yang intuitif, Anda dapat merancang data pipeline tanpa memerlukan banyak kode. Selain itu, FineDataLink mendukung lebih dari 100 sumber data umum, menjadikannya solusi yang fleksibel untuk berbagai kebutuhan bisnis.

Sebagai contoh, FineDataLink dapat digunakan untuk membangun gudang data real-time yang mendukung analisis data secara langsung. Dengan fitur ETL/ELT yang canggih, platform ini memungkinkan Anda untuk mengintegrasikan data dari berbagai format dan sistem dengan mudah. FineDataLink tidak hanya meningkatkan efisiensi operasional tetapi juga memastikan data yang dihasilkan berkualitas tinggi dan siap digunakan.

Data pipeline menjadi elemen penting dalam pengelolaan data modern karena memastikan aliran data yang terstruktur dan andal. Ketika data mengalir tanpa gangguan, Anda dapat menggunakannya untuk analisis yang lebih bermakna. Infrastruktur pipeline yang dikelola dengan baik memungkinkan data sampai ke tujuan tanpa korupsi dan tepat waktu. Hal ini sangat penting untuk mendukung pengambilan keputusan berbasis data.

Pipeline yang dioptimalkan juga membantu ilmuwan data mengakses data yang terpusat dan terstruktur. Dengan begitu, mereka dapat fokus pada analisis mendalam tanpa harus khawatir tentang kualitas atau integritas data. Dalam dunia yang semakin bergantung pada data, pipeline yang efisien menjadi fondasi untuk analitik yang sukses.

Data pipeline menawarkan berbagai manfaat yang dapat meningkatkan efisiensi dan kualitas pengelolaan data Anda. Berikut adalah beberapa manfaat utamanya:

| Manfaat Data Pipeline | Penjelasan |

|---|---|

| Peningkatan Kualitas Data | Data pipeline meningkatkan kualitas raw data dengan membersihkan, menyempurnakan, dan menstandarkannya. |

| Pemrosesan Data yang Sederhana | Mengotomatiskan tugas transformasi data yang berulang, memungkinkan fokus pada tugas yang lebih penting. |

| Integrasi Data Komprehensif | Memfasilitasi integrasi data dari berbagai sumber dan memperbaiki ketidakkonsistenan sebelum analisis. |

Dengan manfaat-manfaat ini, Anda dapat memastikan bahwa data yang digunakan untuk analisis lebih akurat dan relevan. Hal ini membantu organisasi Anda tetap kompetitif di era digital.

FineDataLink memberikan solusi yang unggul untuk meningkatkan efisiensi dan kualitas data melalui integrasi data pipeline. Platform ini memungkinkan Anda mengumpulkan data dari berbagai sumber dan mengintegrasikannya ke dalam sistem yang mudah dianalisis. Proses ini tidak hanya mempercepat pengolahan data tetapi juga memastikan data yang dihasilkan berkualitas tinggi.

FineDataLink secara otomatis membersihkan data, menghilangkan duplikasi, dan memvalidasi informasi. Dengan begitu, Anda dapat yakin bahwa data yang digunakan untuk pengambilan keputusan bebas dari kesalahan. Selain itu, fitur sinkronisasi data real-time dari FineDataLink memungkinkan Anda memproses data dengan latensi minimal. Hal ini sangat berguna untuk analisis yang membutuhkan data terkini.

Dengan FineDataLink, Anda tidak hanya mendapatkan efisiensi operasional tetapi juga wawasan yang lebih dalam dari data Anda. Platform ini membantu Anda membangun fondasi data yang kuat untuk mendukung kebutuhan bisnis yang terus berkembang.

Proses data ingestion adalah langkah pertama dalam data pipeline. Pada tahap ini, data dari berbagai sumber dikumpulkan dan dimasukkan ke dalam sistem untuk diproses lebih lanjut. Sumber data dapat berupa basis data, file log, API, atau aplikasi SaaS. Proses ini memastikan bahwa data mentah tersedia untuk langkah-langkah berikutnya.

Efektivitas proses data ingestion sangat memengaruhi kinerja keseluruhan data pipeline. Data yang dikumpulkan harus melalui tahapan seperti pengumpulan, penyimpanan, dan analisis sebelum memberikan nilai yang bermanfaat. Jika proses ini tidak berjalan dengan baik, data yang dihasilkan mungkin tidak relevan atau tidak akurat untuk analisis.

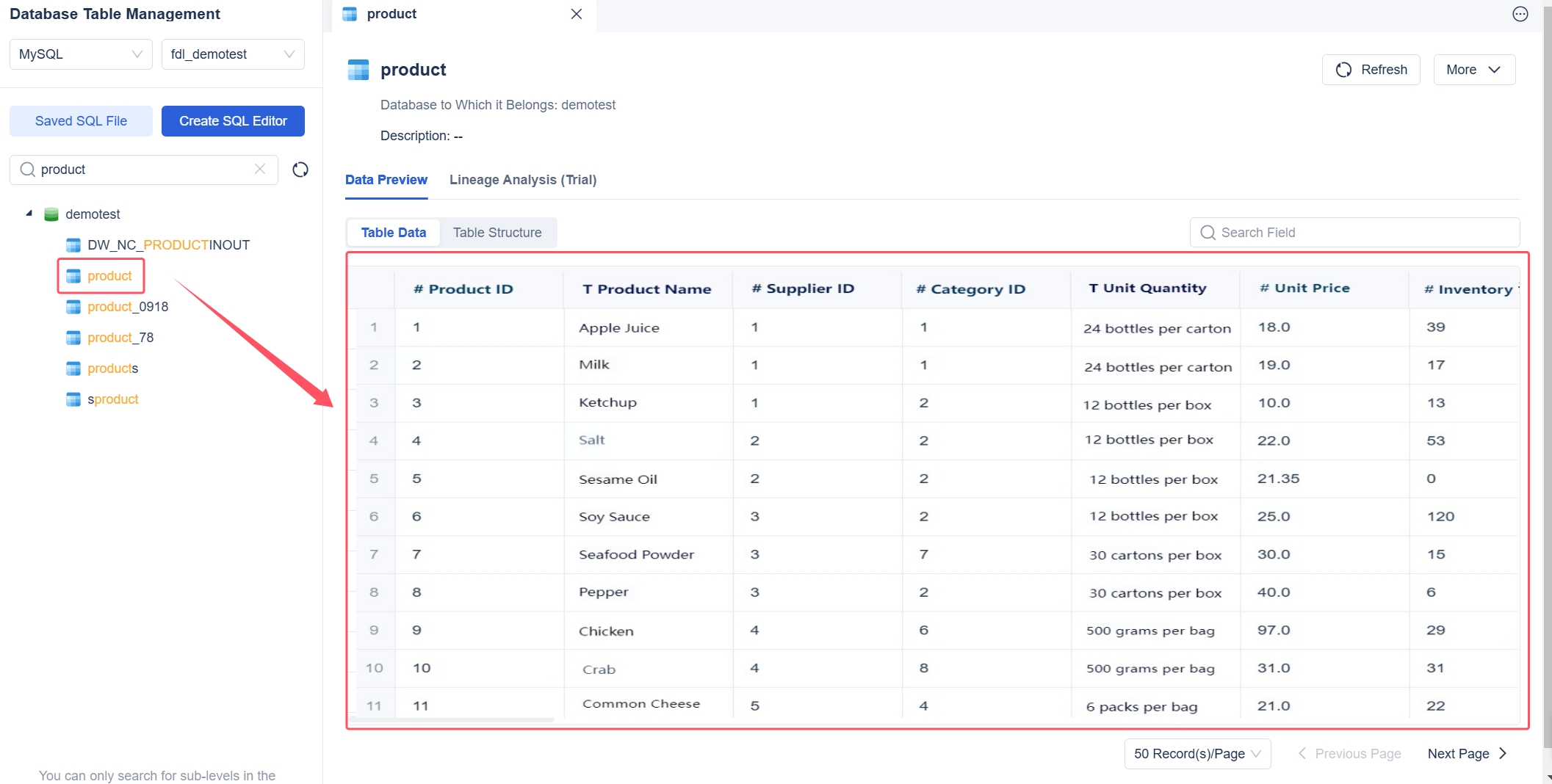

FineDataLink memainkan peran penting dalam proses ini. Dengan fitur sinkronisasi data real-time, FineDataLink memungkinkan Anda mengumpulkan data dari berbagai sumber dengan latensi minimal. Antarmuka drag-and-drop yang intuitif mempermudah pengaturan alur kerja data ingestion tanpa memerlukan banyak kode. Hal ini membantu Anda menghemat waktu dan memastikan data yang dikumpulkan siap untuk diproses lebih lanjut.

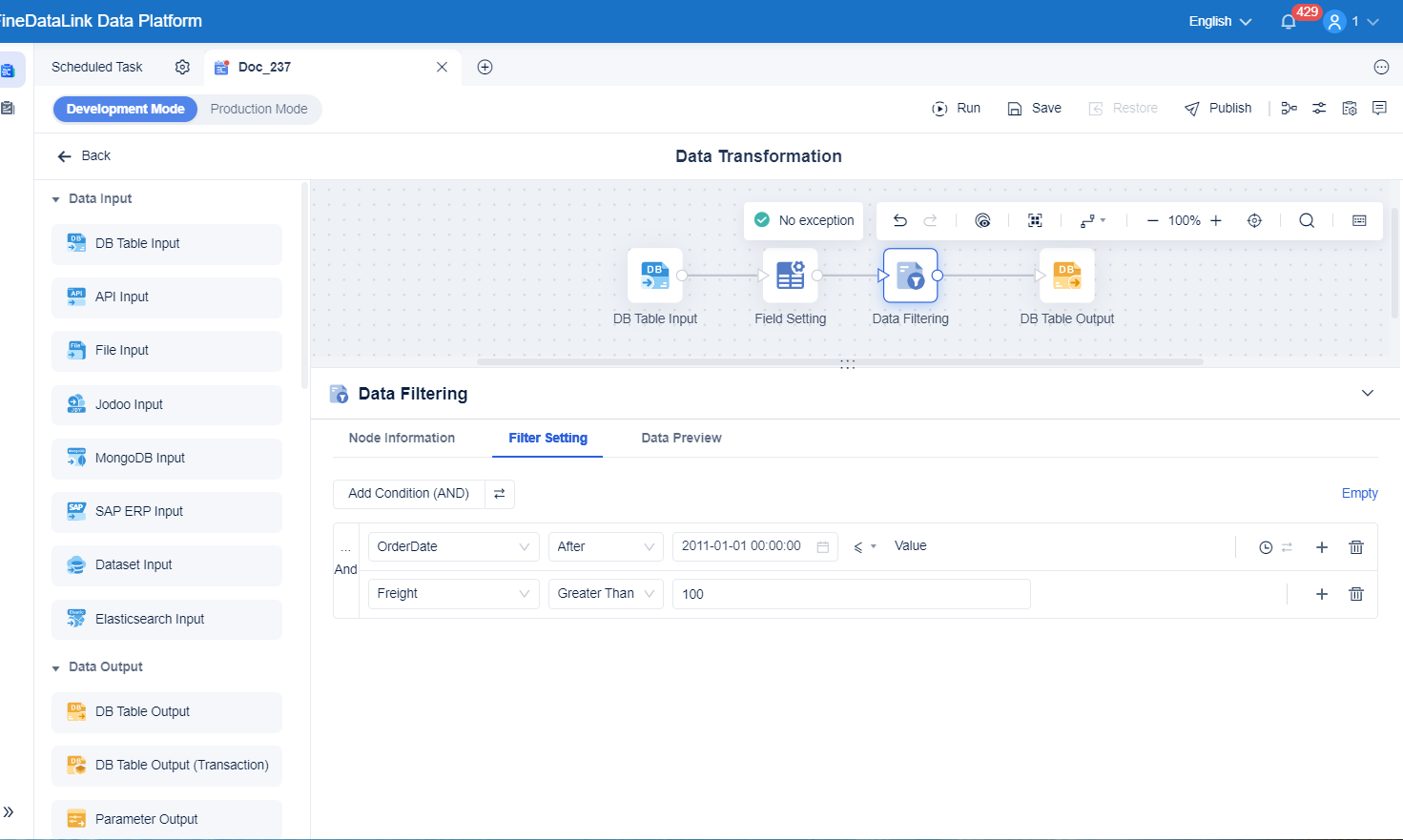

Setelah data dikumpulkan, langkah berikutnya adalah transformasi data. Pada tahap ini, data mentah diubah menjadi format yang sesuai untuk analisis. Transformasi data melibatkan berbagai proses, seperti pembersihan data, penghapusan duplikasi, dan pengubahan struktur data.

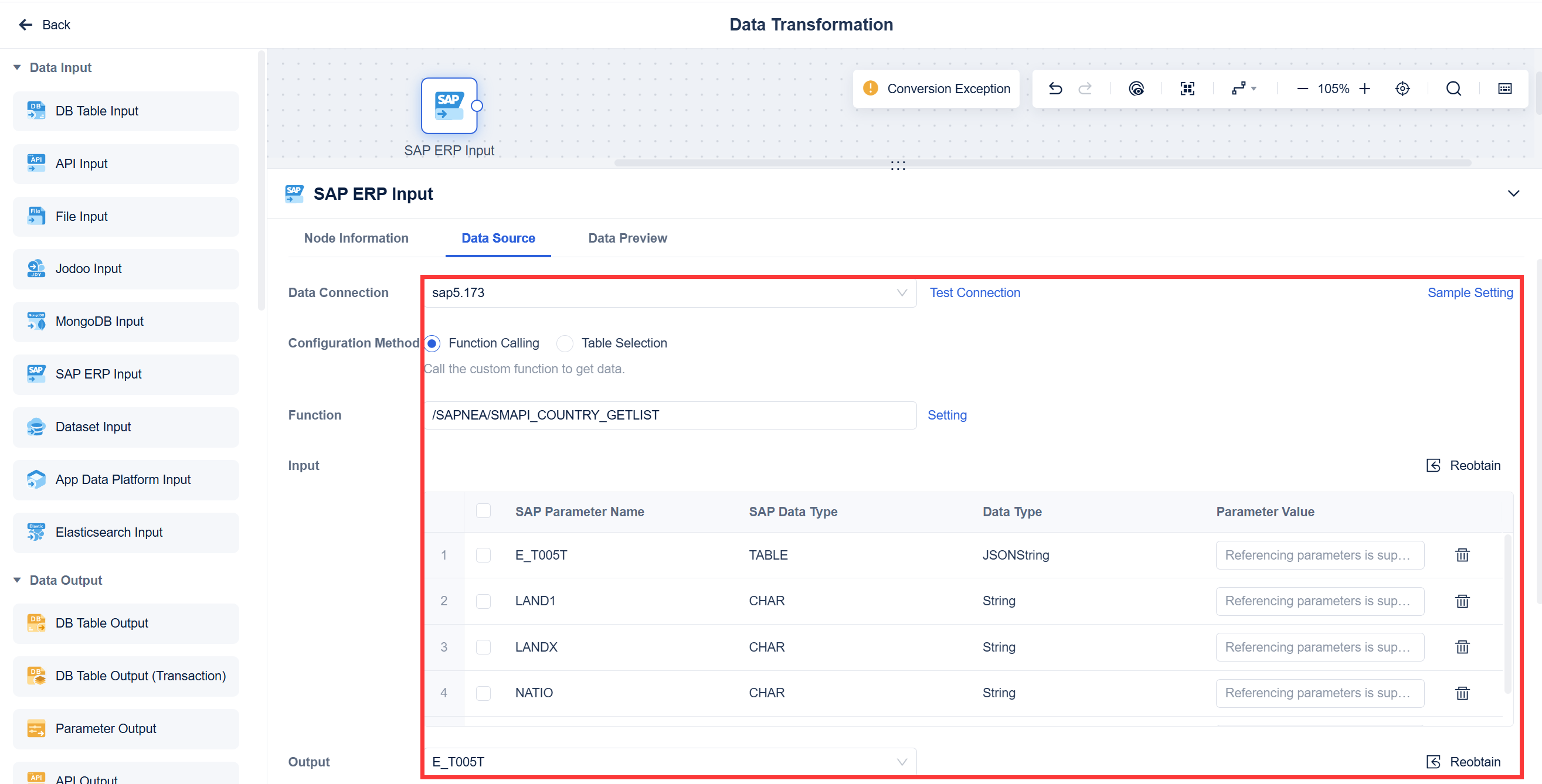

Transformasi data sangat penting untuk meningkatkan kualitas data. Data yang bersih dan terstruktur memungkinkan Anda mendapatkan wawasan yang lebih akurat. FineDataLink menyediakan fitur ETL/ELT canggih yang mempermudah proses transformasi data. Anda dapat menggunakan alat ini untuk membersihkan data secara otomatis, memvalidasi informasi, dan mengonversi data ke format yang sesuai dengan kebutuhan bisnis Anda.

Sebagai contoh, FineDataLink dapat digunakan untuk mengintegrasikan data dari berbagai format, seperti CSV, JSON, atau XML, ke dalam satu sistem yang terpusat. Dengan begitu, Anda dapat memastikan bahwa data yang digunakan untuk analisis bebas dari kesalahan dan siap untuk mendukung pengambilan keputusan.

Tahap terakhir dalam data pipeline adalah data loading. Pada tahap ini, data yang telah diproses dimasukkan ke dalam sistem tujuan, seperti gudang data, aplikasi analitik, atau dashboard interaktif. Proses ini memastikan bahwa data tersedia untuk digunakan oleh tim atau sistem yang membutuhkannya.

Keandalan proses data loading sangat penting untuk mendukung operasional yang efisien. Validasi data yang sistematis dapat meningkatkan kualitas dan keandalan data. Dengan data yang andal, Anda dapat membuat keputusan yang lebih baik dan meningkatkan efisiensi operasional. Untuk mencapai hal ini, Anda perlu memahami karakteristik dan kebutuhan spesifik dari data yang dikelola.

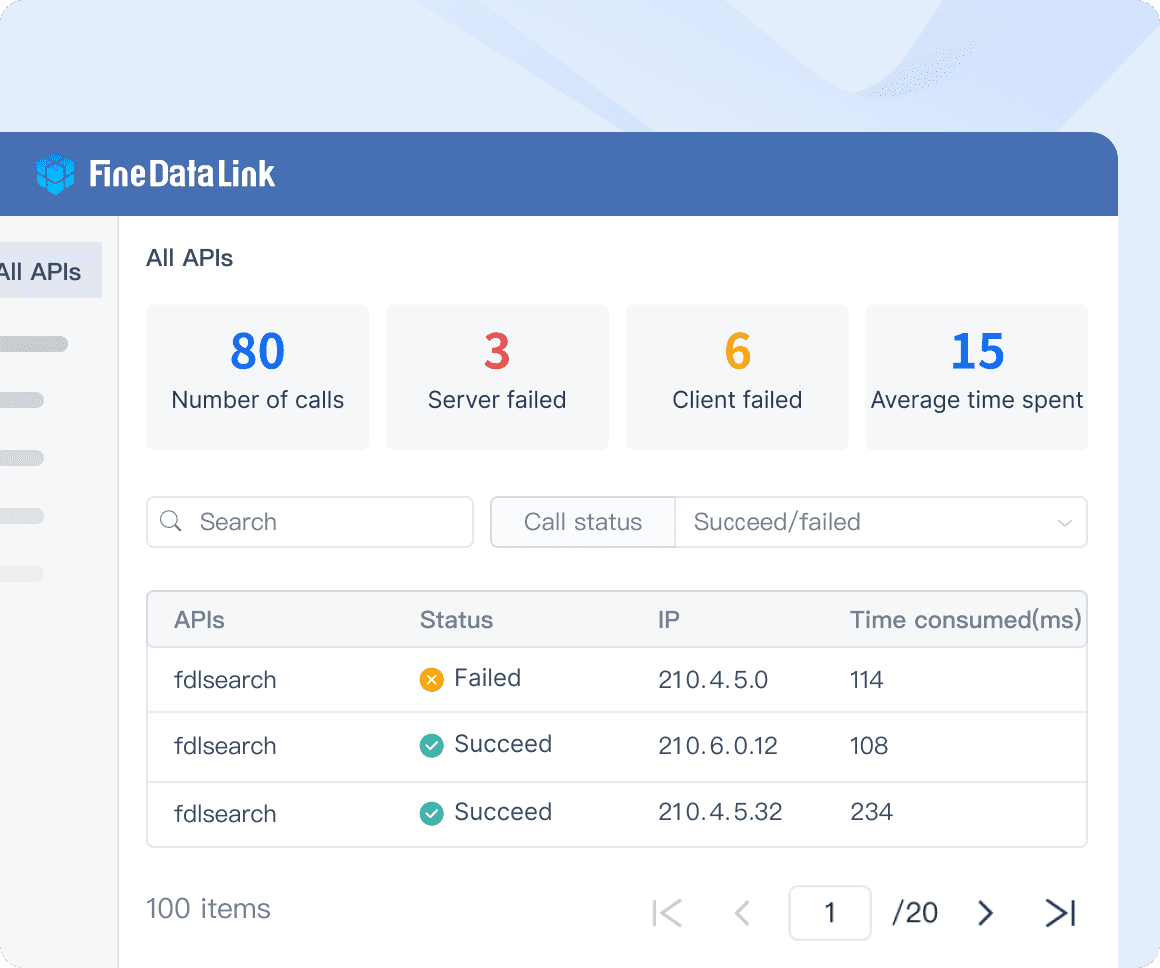

FineDataLink mendukung proses data loading dengan fitur-fitur seperti penjadwalan otomatis dan integrasi API. Anda dapat mengatur alur kerja untuk memuat data ke dalam sistem tujuan secara real-time atau sesuai jadwal yang telah ditentukan. Dengan kemampuan ini, FineDataLink membantu Anda memastikan bahwa data yang dimuat selalu relevan dan terkini.

FineDataLink memberikan solusi yang komprehensif untuk mendukung setiap tahap dalam proses data pipeline. Dengan fitur-fitur canggih, platform ini membantu Anda mengelola data secara efisien, mulai dari pengumpulan hingga penyimpanan. Berikut adalah cara FineDataLink meningkatkan kinerja di setiap tahap:

FineDataLink mengotomatiskan proses pengumpulan, transformasi, dan pengiriman data. Anda tidak perlu lagi melakukan tugas manual yang memakan waktu. Dengan otomatisasi ini, risiko kesalahan manusia berkurang, dan waktu yang dihabiskan untuk mengelola data menjadi lebih singkat. Proses ini memastikan data yang dikumpulkan siap untuk dianalisis tanpa hambatan.

Kecepatan adalah kunci dalam pengelolaan data modern. FineDataLink mempercepat alur kerja data pipeline, memungkinkan hasil analisis diakses lebih cepat. Anda dapat menggunakan data yang telah diproses untuk mendukung pengambilan keputusan yang lebih baik. Dengan pipeline yang efisien, Anda dapat merespons perubahan bisnis dengan lebih cepat.

FineDataLink dirancang untuk menangani volume data yang besar. Anda dapat menyesuaikan sistem sesuai kebutuhan tanpa mengurangi performa. Skalabilitas ini sangat penting bagi organisasi yang terus berkembang dan membutuhkan solusi yang fleksibel untuk mengelola data mereka.

Berikut adalah ringkasan bagaimana FineDataLink mendukung setiap tahap proses data pipeline:

| Aspek | Penjelasan |

|---|---|

| Otomatisasi Proses | FineDataLink mengotomatiskan pengumpulan, transformasi, dan pengiriman data, menghemat waktu dan mengurangi kesalahan manual. |

| Kecepatan Analisis | Pipeline ini meningkatkan kecepatan analisis data, memungkinkan hasil analisis diakses lebih cepat untuk pengambilan keputusan. |

| Skalabilitas | Dirancang untuk menangani volume data yang besar, memungkinkan sistem disesuaikan tanpa mengurangi performa. |

Dengan FineDataLink, Anda dapat membangun data pipeline yang lebih efisien dan andal. Platform ini tidak hanya meningkatkan kualitas data tetapi juga memberikan fleksibilitas untuk memenuhi kebutuhan bisnis yang terus berubah.

Batch processing adalah metode pemrosesan data dalam kelompok atau batch pada interval tertentu. Kamu dapat menggunakan pendekatan ini untuk mengolah data dalam jumlah besar yang tidak memerlukan respons langsung. Contohnya, laporan penjualan harian atau mingguan sering kali menggunakan batch processing untuk mengumpulkan data dari berbagai sumber sebelum diproses.

Metode ini cocok untuk analisis data yang bersifat periodik. Kamu dapat mengandalkan batch processing untuk tugas seperti penghitungan inventaris atau pembuatan laporan keuangan. Namun, karena data diproses dalam kelompok, hasilnya tidak tersedia secara real-time.

| Tipe Pemrosesan | Deskripsi | Contoh Penggunaan |

|---|---|---|

| Batch Processing | Mengumpulkan data dalam kelompok pada interval tertentu. | Laporan penjualan harian atau mingguan. |

Stream processing memungkinkan kamu memproses data secara real-time seiring dengan kedatangannya. Metode ini sangat ideal untuk situasi yang memerlukan respons cepat, seperti memantau data dari media sosial atau transaksi online. Dengan stream processing, kamu dapat langsung menganalisis data tanpa harus menunggu pengumpulan batch selesai.

Pendekatan ini memberikan keunggulan dalam kecepatan dan relevansi data. Kamu dapat menggunakannya untuk mendeteksi anomali, memantau aktivitas pengguna, atau memberikan rekomendasi produk secara langsung. Namun, stream processing memerlukan infrastruktur yang lebih kompleks dibandingkan batch processing.

Lambda Architecture menggabungkan keunggulan batch processing dan stream processing dalam satu sistem. Kamu dapat memanfaatkan arsitektur ini untuk mendapatkan analisis data yang mendalam sekaligus respons real-time. Dalam Lambda Architecture, data diproses melalui dua jalur: jalur batch untuk analisis historis dan jalur real-time untuk data terkini.

Pendekatan ini sangat berguna untuk aplikasi yang memerlukan data historis dan real-time secara bersamaan. Misalnya, kamu dapat menggunakannya untuk memantau performa bisnis sambil menganalisis tren jangka panjang. Lambda Architecture memberikan fleksibilitas tinggi, meskipun implementasinya memerlukan perencanaan yang matang.

Tip: Jika kamu ingin mengelola data dalam jumlah besar dengan kebutuhan analisis real-time, Lambda Architecture bisa menjadi solusi yang tepat.

FineDataLink menawarkan teknologi yang fleksibel untuk mendukung berbagai jenis data pipeline, termasuk batch processing, stream processing, dan Lambda Architecture. Kamu dapat memanfaatkan fitur-fitur canggihnya untuk mengelola data dengan lebih efisien dan memastikan kualitas data tetap terjaga.

FineDataLink dirancang untuk menangani berbagai jenis data, mulai dari data mentah hingga data yang telah diproses. Kamu dapat menggunakan platform ini untuk mengintegrasikan data dari berbagai format dan sumber. Berikut adalah jenis data yang dapat dikelola oleh FineDataLink:

| Jenis Data | Deskripsi |

|---|---|

| Raw Data | Data mentah yang belum diproses, biasanya dalam format encoding seperti JSON. |

| Processed Data | Data mentah yang telah diproses menjadi format event tertentu dengan skema yang jelas. |

| Cooked Data | Data yang sudah diringkas dari processed data, mencakup informasi seperti total waktu sesi. |

FineDataLink memungkinkan kamu untuk mengubah raw data menjadi cooked data dengan proses yang cepat dan otomatis. Kamu dapat menghemat waktu dan memastikan data yang dihasilkan siap untuk analisis.

FineDataLink mendukung sinkronisasi data real-time, yang sangat berguna untuk stream processing. Kamu dapat memproses data secara langsung tanpa harus menunggu pengumpulan batch selesai. Selain itu, fitur ETL/ELT canggihnya memungkinkan kamu untuk membersihkan dan mengubah data sesuai kebutuhan bisnis. Dengan antarmuka drag-and-drop, kamu dapat merancang pipeline data tanpa memerlukan banyak kode.

Untuk Lambda Architecture, FineDataLink menyediakan fleksibilitas tinggi. Kamu dapat mengintegrasikan data historis dan real-time dalam satu sistem. Hal ini membantu kamu mendapatkan wawasan mendalam sekaligus respons cepat terhadap perubahan.

FineDataLink memberikan solusi yang komprehensif untuk berbagai jenis pipeline. Kamu dapat mengandalkan teknologi ini untuk meningkatkan efisiensi operasional dan mendukung pengambilan keputusan berbasis data.

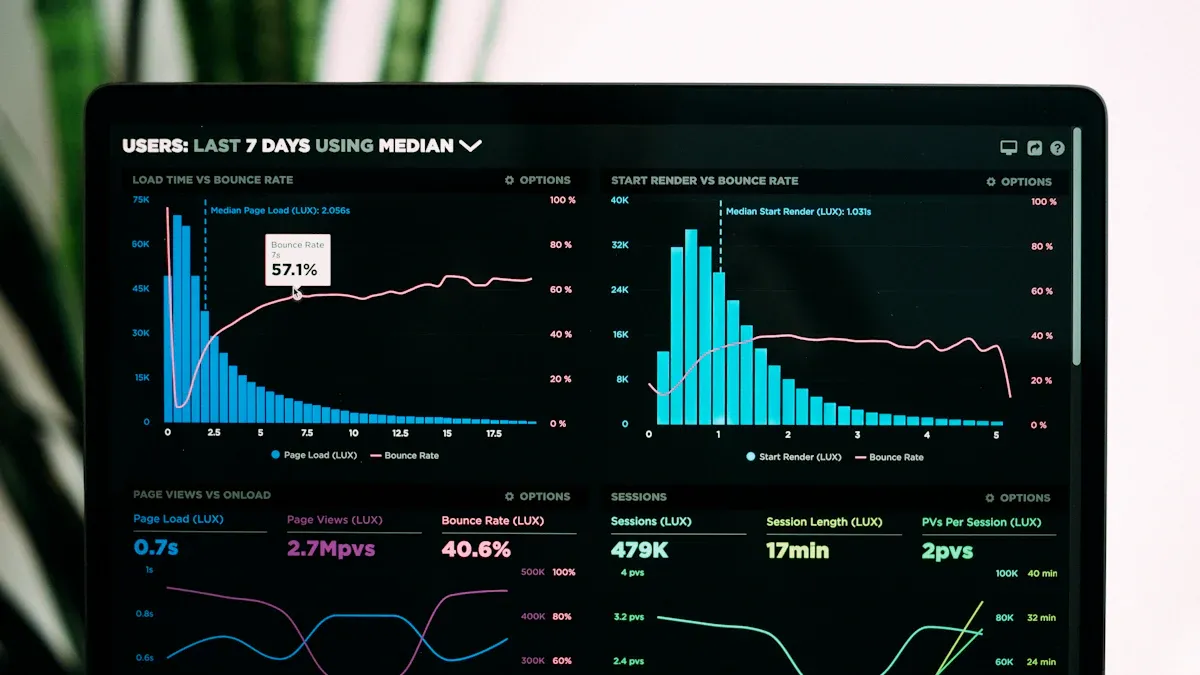

Big data membutuhkan pengelolaan yang efisien karena volume, kecepatan, dan variasinya yang tinggi. Data pipeline menjadi solusi utama untuk mengelola aliran data besar ini. Dengan pipeline yang dirancang baik, Anda dapat memproses data dalam jumlah besar secara otomatis dan terstruktur. Hal ini memungkinkan analisis data yang lebih cepat dan akurat.

Industri seperti e-commerce dan layanan keuangan sering menggunakan data pipeline untuk memproses data transaksi, perilaku pelanggan, dan tren pasar. Indikator kinerja utama (KPI) membantu mengukur keberhasilan penerapan pipeline ini. Berikut adalah beberapa KPI yang relevan:

| Indikator Kinerja Utama (KPI) | Deskripsi |

|---|---|

| Jumlah Lead yang Diproses | Mengukur seberapa banyak prospek yang berhasil diproses dalam pipeline. |

| Conversion Rate | Persentase prospek yang berhasil dikonversi menjadi pelanggan. |

| Waktu Rata-rata Closing Deal | Rata-rata waktu yang dibutuhkan untuk menutup transaksi. |

Dengan memantau KPI ini, Anda dapat mengevaluasi efektivitas pipeline dan mengoptimalkan proses pengelolaan data.

AI dan machine learning sangat bergantung pada data berkualitas tinggi. Data pipeline membantu memastikan data yang digunakan untuk pelatihan model AI bersih, terstruktur, dan relevan. Proses ini mencakup pengumpulan data dari berbagai sumber, transformasi data untuk memenuhi kebutuhan algoritma, dan pemuatan data ke dalam sistem pelatihan.

Misalnya, dalam pengembangan model prediksi, pipeline dapat mengintegrasikan data historis dan real-time untuk menciptakan dataset yang komprehensif. Dengan pipeline yang efisien, Anda dapat mempercepat siklus pelatihan model dan meningkatkan akurasi prediksi. FineDataLink , dengan fitur ETL/ELT canggihnya, mempermudah proses ini dengan otomatisasi dan sinkronisasi data real-time.

Media sosial menghasilkan data dalam jumlah besar setiap detik. Data pipeline memungkinkan Anda memanfaatkan data ini untuk kampanye pemasaran digital yang lebih efektif. Dengan pipeline, Anda dapat mengumpulkan data dari berbagai platform, menganalisis perilaku pengguna, dan mengukur efektivitas kampanye.

Beberapa manfaat utama dari penerapan pipeline dalam pengelolaan media sosial meliputi:

Pipeline yang dirancang dengan baik membantu Anda memahami audiens dengan lebih baik dan meningkatkan ROI dari kampanye pemasaran. Dengan FineDataLink, Anda dapat mengintegrasikan data dari berbagai platform media sosial secara real-time, memastikan data yang digunakan selalu relevan dan terkini.

FineDataLink telah membantu berbagai organisasi mengatasi tantangan dalam pengelolaan data pipeline. Berikut adalah beberapa studi kasus nyata yang menunjukkan bagaimana platform ini memberikan solusi yang efektif dan efisien.

Sebuah perusahaan e-commerce besar menghadapi tantangan dalam mengintegrasikan data dari berbagai sumber, seperti transaksi pelanggan, inventaris, dan analisis perilaku pengguna. Data yang tersebar di berbagai sistem menyebabkan proses analisis menjadi lambat dan tidak akurat. Dengan FineDataLink, perusahaan ini berhasil:

Hasilnya, perusahaan ini meningkatkan konversi penjualan hingga 25% dan mempercepat pengambilan keputusan berbasis data.

Sebuah bank terkemuka menghadapi tantangan dalam mematuhi regulasi data yang ketat sambil tetap menyediakan layanan yang cepat dan andal. Dengan FineDataLink, bank ini mampu:

Dengan pipeline yang lebih efisien, bank ini berhasil meningkatkan kepuasan pelanggan dan memenuhi standar regulasi tanpa hambatan.

Sebuah agensi pemasaran digital menggunakan FineDataLink untuk mengelola data dari berbagai platform media sosial. Mereka memanfaatkan fitur ETL untuk:

Hasilnya, agensi ini meningkatkan efektivitas kampanye hingga 30% dan memberikan laporan yang lebih mendalam kepada klien.

FineDataLink membuktikan kemampuannya dalam berbagai skenario industri. Dengan fitur-fitur canggihnya, platform ini membantu organisasi membangun data pipeline yang andal, efisien, dan siap mendukung kebutuhan bisnis modern.

Data pipeline menjadi fondasi penting dalam pengelolaan data modern. Dengan pipeline yang terstruktur, kamu dapat memastikan data mengalir dengan lancar, terorganisir, dan siap digunakan untuk analisis. Hal ini mendukung pengambilan keputusan yang lebih cepat dan akurat.

Manfaat utama: FineDataLink menawarkan fleksibilitas tinggi untuk mengelola data dari berbagai sumber. Kamu bisa memanfaatkan fitur seperti sinkronisasi real-time dan ETL/ELT canggih untuk meningkatkan efisiensi operasional.

Teknologi seperti FineDataLink membantu kamu membangun sistem data yang andal dan siap menghadapi tantangan bisnis di era digital.

Panduan Pemula: Apa Itu Integrasi Data

Menguasai Validasi Data: Kunci Integritas Database

Panduan Lengkap: Menguasai Manajemen Data

ETL (Extract, Transform, Load): Apa dan Cara Kerjanya

Pengertian dan Fungsi Data Mining dalam Bisnis

Penulis

Howard

Engineer Data Management & Ahli Data Research Di FanRuan

Artikel Terkait

Data Penelitian Adalah Fondasi Utama Riset, Penjelasannya

Data penelitian adalah kumpulan fakta dan informasi sistematis yang menjadi dasar utama riset agar hasil penelitian valid, akurat, dan dapat dipercaya.

Howard

2025 Juli 17

Pengertian Sumber Data Primer Dalam Penelitian

Sumber data primer adalah data asli yang dikumpulkan langsung peneliti dari objek penelitian, memiliki keaslian, relevansi, dan validitas tinggi.

Howard

2025 Juli 17

Sumber Data Sekunder Adalah? Pengertian dan Contoh Lengkap

Sumber data sekunder adalah data yang telah tersedia, seperti buku, jurnal, laporan BPS, dan publikasi pemerintah. Simak pengertian dan contohnya di sini.

Howard

2025 Juli 17