数据集成ETL工具有哪些?用心推荐,最好用的都在这里了!

数据集成是将不同来源、属性和形式的数据整合在同一个数据仓库中,为企业提供统一且具有分析价值的数据的过程。而ETL(Extract, Transform, Load)是一种重要的数据集成和处理方法。以下是市面上普及率高且非常好用的数据集成ETL工具,大家快转发收藏起来!

一、数据集成ETL工具推荐

1. Kettle

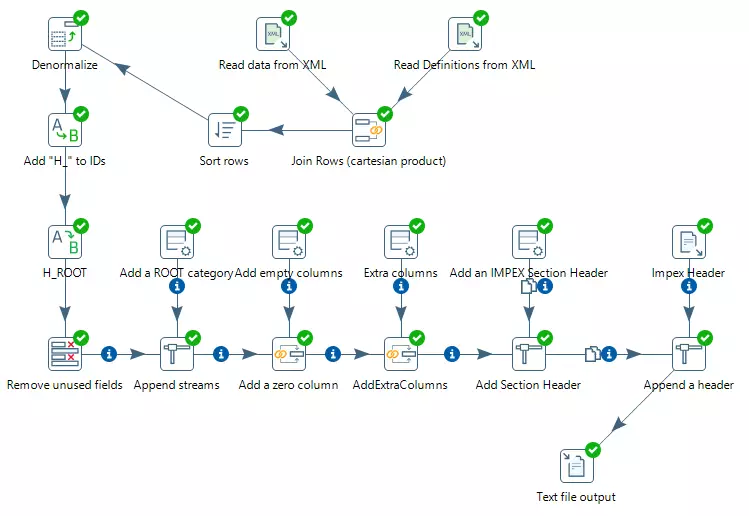

Kettle中文名称叫水壶,是一款国外开源的ETL工具。该项目的主程序员MATT希望把各种数据集中起来,然后以指定的格式输出并运用,宛如将数据集中在一个壶里,如水般丝滑流出。Kettle是纯java编写,可以在Windows、Linux、Unix上运行,如其名一般,具有高效且稳定的数据抽取功能。

Kettle中有两种脚本文件,Transformation(.ktr)和Job(.kjb),Transformation完成针对数据的基础转换,专注于数据的ETL;而Job则完成整个工作流的控制,范围比较广,可以是Transformation,也可以是Mail、SQL、Shell、FTP等,甚至可以是另外一个Job。

Kettle的核心概念:

- 可视化编程:Kettle可以被归类为可视化编程语言(Visula Programming Languages),因为Kettle可以使用图形化的方式定义复杂的ETL程序和工作流,可以快速构建复杂的ETL作业和减低维护工作量。

- 转换:转换(Transformation)是ETL解决方案的中的最重要组成部分,它处理抽取,转换,加载各种对数据行的操作。Kettle的转换包含一个或者多个步骤,如读取文件,过滤数据行,数据清洗,或者是将数据加载到数据库。转换里的步骤通过跳(hop)来连接,定义了一个单项通道允许数据从一个步骤到向另一个步骤流动。

但Kettle的缺陷就是,定时调度任务过多时,只能通过系统自带的定时任务调度去进行管理,写日志,无法做到统一的管理。假如要做统一的管理也行,安装一套Jenkins,但配置和后续的运维成本可能较高。以及,Kettle的内存占用较高,无法最大效率地利用服务器资源。

官方网站:https://www.hitachivantara.com/en-us/products/pentaho-platform/data-integration-analytics.html

2. FineDataLink

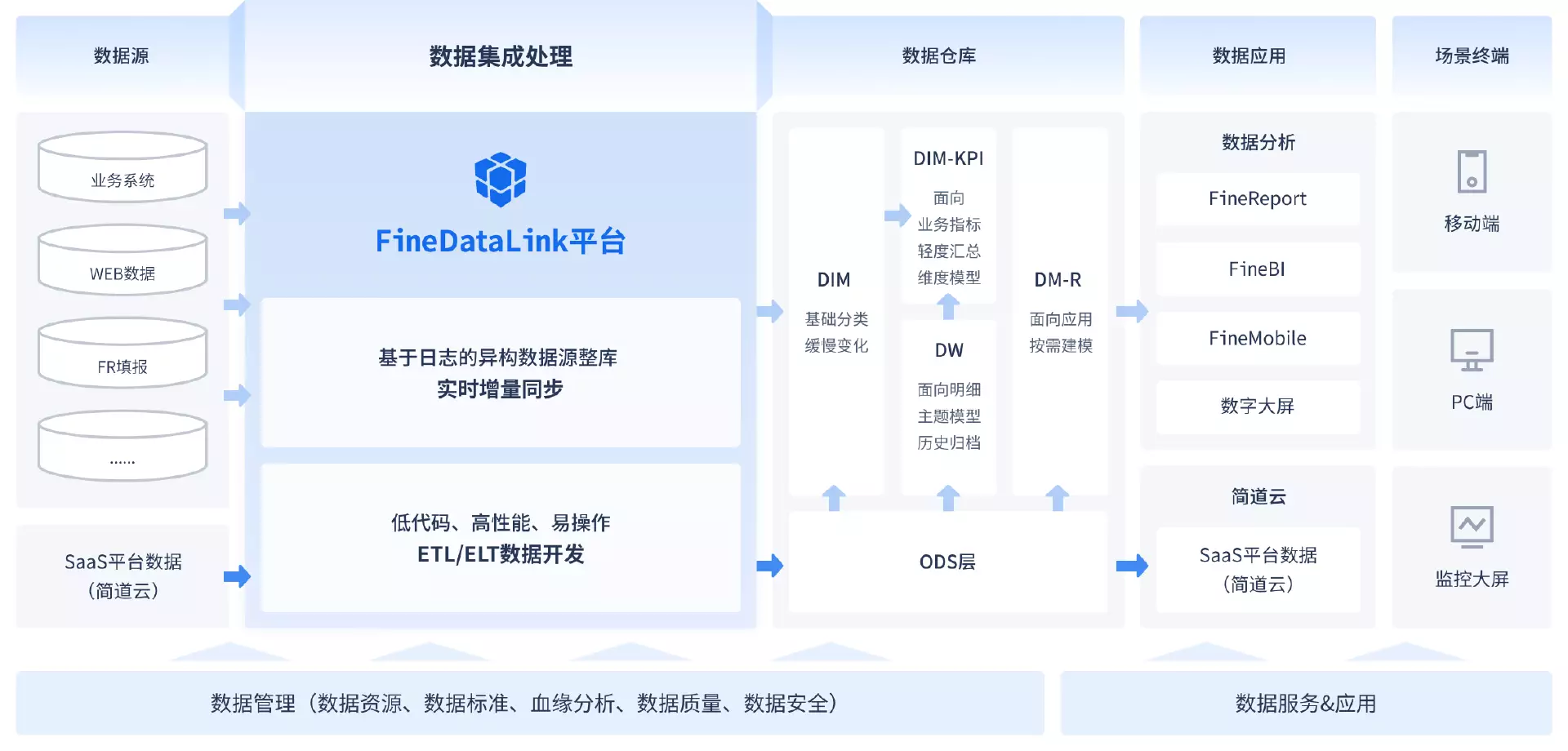

FineDataLink数据集成平台(简写:FDL)是国内知名商业智能厂商帆软面向IT人员推出的企业级一站式数据集成平台产品,拥有实时同步和离线计算两大引擎,具备实时数据同步、ETL和ELT定时数据计算等核心能力。

相比起其他数据集成工具,FDL具有更简易的上手操作、更强大的数据开发、更高效的系统运维、更灵活的团队协作等优势,能满足企业多种场景下的数据预处理需求。

FineDataLink的优势:

1)可视化界面,易懂、易上手

大多数人在最初接触到一个新工具时,会因为复杂的操作界面、繁琐的操作文档而止步。

而FineDataLink提供全程可视化、拖拉拽的全新操作界面,从任务管理页面、到每一个ETL任务的节点,都致力于做到简单易懂、直接上手可用,提供一个高效数据处理的平台给到数据分析处理人员使用。

2)数据开发:更多源、更灵活、更直接

FDL让所有的数据清洗、处理工作都在这个平台中统一完成,减少大量繁琐的数据连接、数据输出、错误重试等数据层面的开发时间。通过统一的数据源对接、数据转换清洗、数据输出、定时任务调度配置一系列数据开发处理工作,提高至少50%数据开发效率。

3)系统运维,高效无忧

在完成数据开发后,“任务按预定时间准时运行”、“任务准时运行成功”,将会是运维人员最为关心的问题。FDL通过“消息通知”,在任务执行成功或者失败时,可以自定义完成邮件、短信、企业微信、钉钉等的实时通知,在第一时间告知您任务的运行情况。

另外,FineDataLink提供整体化任务可视化运维界面,可以从主页看到任务的运行状态:运行成功、运行中断、运行报错,同时通过统计页面跳转到任务的详情界面,查看具体任务的错误原因。

4) 协同开发,提高企业数据开发效率

FineDataLink支持人员和权限管理,来对数据连接、数据开发任务进行权限分配,在进行数据处理协同开发的同时,做到数据隔离。

在完成数据的开发处理后,“结果数据”同样可以通过权限管理,赋予其他人数据资产复用的权限。

另外在数据开发过程中,管理员可以通过任务开发目录,实时看到数据开发人员的开发进度;同时支持查看任务的最近编辑人员,便于遇到问题时候,及时找人,解决问题。

官方网站:https://www.finedatalink.com

3. Talend

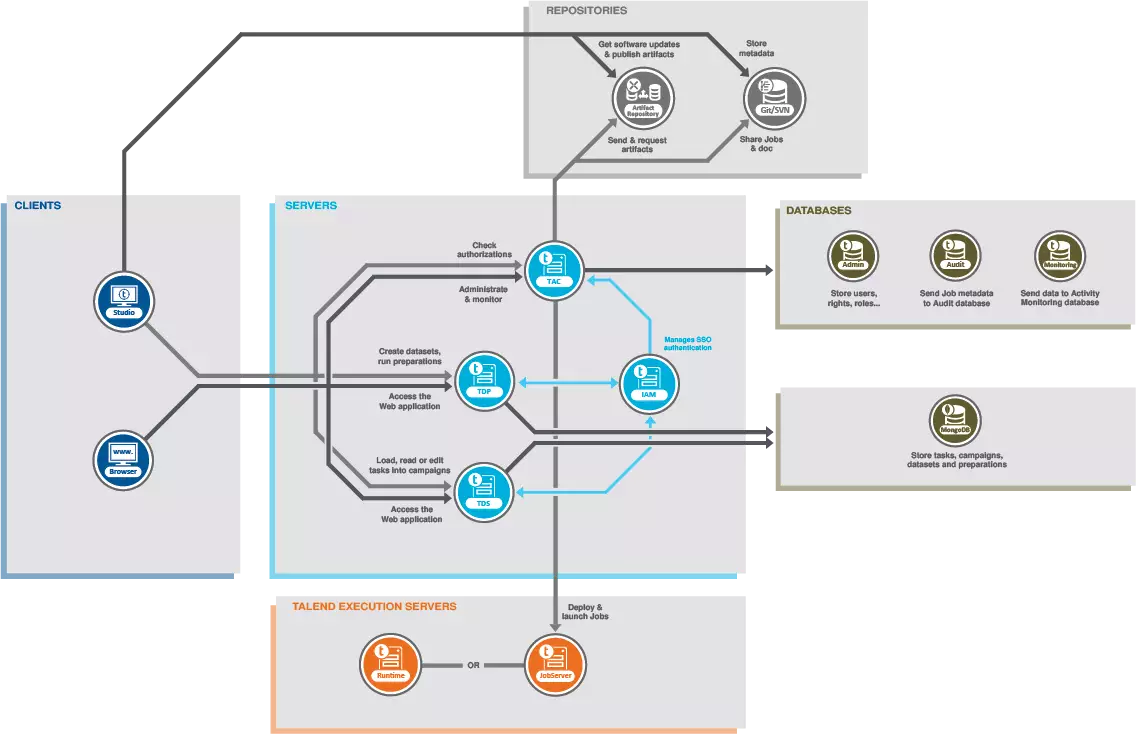

Talend中文名拓蓝,是一个开源的ETL数据集成解决方案,与企业内部和云端的数据源都兼容。该平台包括数百个预建的集成,简化了数据处理流程,降低入门门槛,使用者不需要掌握专业的ETL知识,仅仅通过web界面和简单的组件拖拽就可实现数据处理。除了开源版本,Talend还提供了一个付费的数据管理平台,包括用于生产力、设计、管理、监控和数据治理的额外工具和功能。

概况来说,Talend的优点主要有以下几点:

- 提供全面的 ETL 功能以及数据质量、数据治理等相关功能。

- 提供基于Eclipse的集成开发环境,便于用户使用和开发。

- 有着广泛的社区支持和更新维护,同时也提供了支持服务。

Talend在Gartner的数据整合工具魔力象限报告中被指定为 “领导者”。但它需要设备高配置的硬件设施,部署相对复杂,而且商业版的价格较高,可能不适合个人用户或初创企业。

官方网站:https://www.talend.com/products/application-integration/cloud-api-services/

4. DataStorage

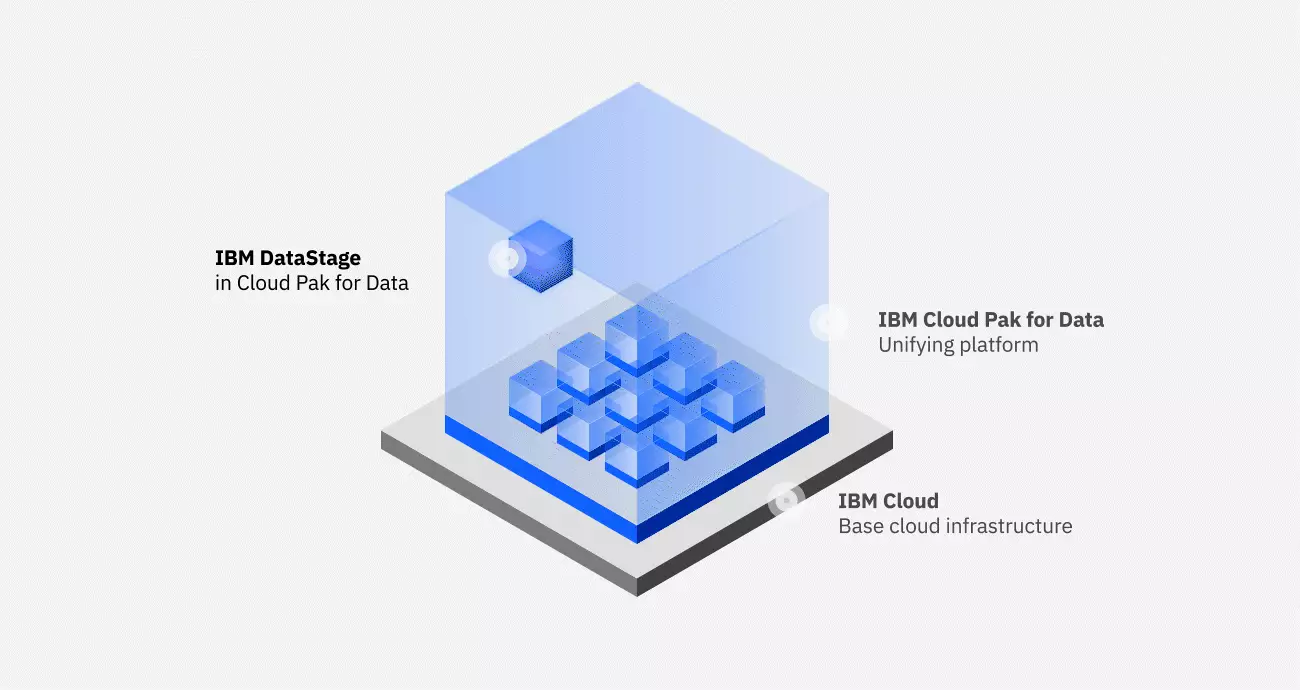

DataStage是IBM公司的商业软件,它为整个 ETL 过程提供了一个图形化的开发环境,是一套专门对多种操作数据源的数据抽取、转换和维护过程进行简化和自动化,并将其输入数据集或数据仓库的集成工具,适合大规模的ETL应用。

DataStage Designer的主要功能可以概括为以下几个方面:

1.ETL Job的开发

DataStage Designer里面包含了DataStage为ETL开发已经构建好的组件, 主要分为两种,一种是用来连接数据源的组件,另一种是用来做数据转换的组件。此外DataStage还提供自定义函数(Basic),利用这些组件,开发人员可以通过图形化的方式进行ETL Job的开发。

2.ETL Job的编译

开发好ETL Job后,可以直接在DataStage Designer里面进行编译。如果编译不通过,编译器会帮助开发人员定位到出错的地方。

3.ETL Job的执行

编译成功后,ETL Job就可以执行了,在DataStage Designer里面可以运行ETL Job,Job的运行情况可以在DataStage Director中看到。

4.ETL Job的Debug

ETL Job可以在Designer中设置断点,跟踪监视Job执行时的中间变量。

5.ETL Job Report的生成

可以为ETL Job生成文档报告,该报告非常详细,只通过该报告,就可以完全了解该Job的结构与处理过程,非常便于分析。

DataStage优点是能帮助企业从散布在各个系统中的复杂异构信息获得更多价值,且有很好的商业化的技术支持。缺点就是贵,且因为使用人数较少,所以如果遇到问题时,去网上找到解决方法的概率比较低。

官方网站:https://www.ibm.com/cn-zh/products/datastage

二、ETL工具使用总结

总而言之,在数字化时代下,大数据治理对企业数据建设的重要性不言而喻,然而实现的困难有时也让人望而却步,因此选择合适的技术和工具会达到事半功倍的效果。帆软FineDataLink——中国领先的低代码/高时效数据集成产品,能过为企业提供一站式的数据服务,通过快速连接、高时效融合多种数据,提供低代码Data API敏捷发布平台,帮助企业解决数据孤岛难题,有效提升企业数据价值。

立即沟通

立即沟通