当提到企业数据同步,很多人可能会想到数据量的庞大和同步过程中的复杂性。特别是在实时数据传输中,如何保证高性能和数据一致性成为企业数字化转型的一大挑战。面对这些问题,Kafka作为数据同步中间件的角色日益重要。在这篇文章中,我们将揭晓以下问题:

- Kafka具体适配哪些组件?

- 在数据同步过程中,保障数据一致性为何更加关键?

通过深入探讨这些问题,我们将帮助您理解Kafka在企业数据同步中的角色及其对数据一致性的影响。

🚀 Kafka具体适配哪些组件?

1. 数据同步与Kafka的角色

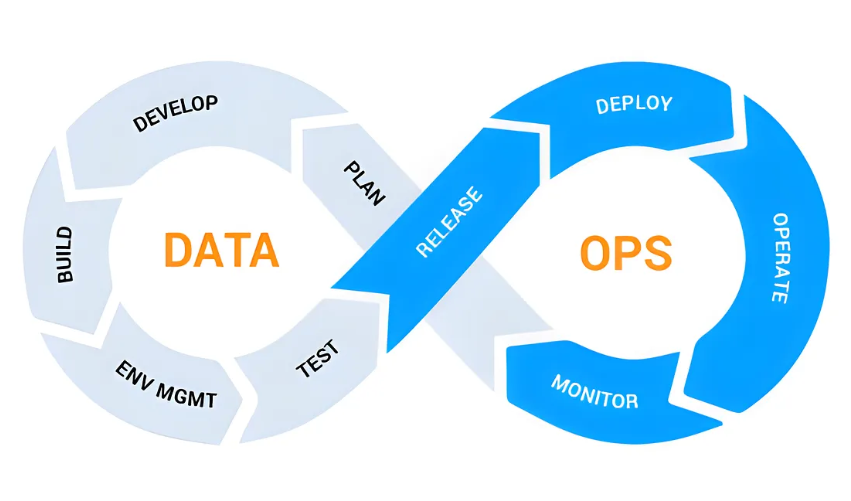

在现代企业中,数据同步是一个复杂且关键的过程,尤其当你面对大量数据需要实时处理时。Kafka在数据同步中起到暂存数据的作用,可以有效地管理企业数据流。这就像是一个交通枢纽,能够处理来自不同来源的“车辆”,确保它们能顺利到达目的地。

- 数据流的管理:Kafka适配了众多数据流组件,可以处理数据的传入和传出。例如,它可以集成数据库日志变化,实时监控并抓取增量数据。

- 组件适配性:Kafka能够适配不同的数据库和数据管道工具,如MySQL、PostgreSQL等,这种适配性使得它在不同数据源之间的切换变得更加顺畅。

Kafka的适配性不仅体现在它与数据库的集成上,还涉及到其他技术组件。比如,在数据管道任务和实时任务配置时,Kafka能够与数据集成平台FineDataLink(FDL)无缝协作。FDL是一款国产的、高效实用的低代码ETL工具,它使用Kafka作为中间件,帮助实现数据的读写分离和故障恢复。 FineDataLink体验Demo

2. Kafka与实时数据处理

实时数据处理是企业数据流管理的关键需求之一。Kafka的设计使其能够高效地处理实时数据传输,保障数据的一致性和完整性。

- 高吞吐量:Kafka的架构使得它能够承载大量数据流入和流出,保证数据在传输过程中不被阻塞。

- 低延迟:实时数据传输要求数据在最短时间内到达目的地,Kafka通过其高效的消息处理机制,降低数据传输的延迟。

Kafka不仅适用于实时数据传输,还可以用于历史数据的处理,这使得企业能够全面管理其数据资产。通过与其他组件的集成,Kafka能够在不同的业务场景中发挥作用,助力企业数据治理。

🔒 保障数据一致性更关键

1. 数据一致性的挑战

在数据同步过程中,数据一致性始终是一个关键问题。企业需要确保数据在传输和处理过程中保持一致,而不被修改或丢失。数据不一致可能导致业务决策的错误,甚至影响企业的运营。

- 数据丢失风险:在高频数据传输中,数据丢失或重复可能导致数据库中的信息不完整或错误。

- 数据修改风险:实时数据传输中的错误修改可能导致数据失去其原始状态,影响后续分析。

为了应对这些挑战,Kafka作为中间件能够有效地保证数据的一致性。它通过日志捕获和消息机制,确保每条数据在传输过程中可追溯和可恢复。

2. Kafka的解决方案

Kafka提供了一系列机制来保障数据的一致性:

- 消息确认机制:Kafka通过ACK机制,确认每条消息被成功处理,避免数据丢失。

- 日志存储机制:Kafka会记录所有的数据操作日志,支持数据的回溯和恢复。

通过这些机制,Kafka能够保障数据在传输过程中的一致性,确保企业能够获得准确的数据分析结果。

🏁 总结

Kafka作为数据同步中间件,其适配性和实时处理能力使其在企业数据管理中扮演了重要角色。企业在选择数据同步解决方案时,必须关注Kafka与其他组件的适配性,以及它在保障数据一致性方面的优势。通过合理利用Kafka,企业能够有效地解决数据同步中的高性能和一致性问题,推动数字化转型的进程。在探索Kafka的适配性和数据一致性保障时,FineDataLink可以作为一个值得关注的选择,它提供了低代码解决方案,提升数据管理的效率和可靠性。

以上就是我们对Kafka具体适配哪些组件以及保障数据一致性更关键的深入探讨。希望这篇文章能为您的企业数据管理提供有益的见解。

本文相关FAQs

🤔 Kafka具体适配哪些组件?有哪些使用场景?

最近在公司推进数据中台建设,领导提到要用Kafka来做数据同步。我对Kafka的理解还停留在它是个消息队列工具,具体适配哪些组件、有哪些使用场景还不太清楚。有没有大佬能科普一下?希望能从基础原理到实际应用都讲解一下。

Kafka,是一个分布式的流处理平台,常被用作消息队列,但它的功能远不止于此。在大数据和企业数字化建设中,Kafka可以适配多种组件和应用场景:

- 消息队列:Kafka最常见的应用场景是作为消息队列,用于解耦生产者和消费者之间的通信。它支持高吞吐量的消息处理,能够处理大量实时数据。

- 流处理:Kafka Streams是Kafka的一个组件,提供了流处理的功能。它可以对实时数据流进行复杂的操作,如过滤、聚合、连接等。

- 数据存储和缓存:虽然Kafka不是一个传统意义上的数据库,但它可以存储消息,保留一段时间供消费者使用。这使得它可以用于数据缓存和短期存储。

- 数据集成:Kafka Connect是一个用于数据集成的工具,可以轻松地将数据从外部系统导入到Kafka中,或者从Kafka导出到外部系统。

在具体实施过程中,选择适配哪些组件,取决于业务需求和技术栈。例如,若公司需要实时处理大数据流,Kafka Streams和Kafka Connect可以很好地满足需求。

阅读到这,可能会觉得Kafka适配的组件和场景很多,但如何根据具体业务需求选择合适的组件呢?可以从以下几个方面考虑:

- 业务需求:根据业务需求选择相应的Kafka组件。例如,需要实时数据处理的业务场景可以选择Kafka Streams。

- 技术栈:结合现有的技术栈,选择与之最兼容的Kafka组件。

- 性能要求:不同的组件在性能上有所不同,需要根据具体性能要求进行选择。

总的来说,Kafka是一个灵活且强大的工具,它的适配组件和应用场景都很丰富。了解清楚这些,可以为企业的数字化转型提供更好的支持。

🔍 如何保障Kafka数据同步中的数据一致性?

在用Kafka进行数据同步时,老板强调必须保证数据一致性。我们现在使用的是传统的批量同步方案,总觉得不太靠谱。有没有什么好的办法能确保数据在传输过程中不出问题?

在数据同步中,数据一致性是一个非常关键的问题,尤其是在使用Kafka这样的大规模分布式系统时。以下是一些确保数据一致性的方法和实践:

- 使用Kafka事务:Kafka提供了事务支持,可以确保一组生产和消费的操作要么全部成功,要么全部失败。这对于需要严格数据一致性的场景非常有用。

- 幂等性生产者:Kafka提供幂等性生产者功能,确保在网络故障或重试情况下不会重复写入相同的消息。通过配置

enable.idempotence=true,可以实现幂等性生产。

- 强制消费顺序:在某些情况下,数据的消费顺序对于一致性至关重要。可以通过合理设置Kafka的分区和消费者组,确保消息按顺序消费。

- 使用FineDataLink:这是一款低代码、高时效的企业级数据集成平台,特别适用于大数据场景下的实时和离线数据采集。它利用Kafka作为数据同步的中间件,确保数据在传输过程中保持一致性。FineDataLink不仅支持实时全量和增量同步,还提供了强大的数据调度和数据治理能力,是企业数字化转型的有力助手。 FineDataLink体验Demo

此外,数据一致性还需要配合以下措施:

- 监控和报警:建立完善的监控和报警机制,一旦出现数据不一致,能够及时发现和处理。

- 数据校验:在数据传输后进行数据校验,确保数据的完整性和准确性。

- 重试机制:在出现数据传输失败时,能够自动重试,保证数据最终一致。

经过这些措施的实施,可以有效提升Kafka数据同步的可靠性和一致性,为企业的数据平台建设提供更稳固的基础。

📈 在Kafka数据同步中,如何优化性能?

随着业务量的增加,Kafka的数据同步任务越来越多,导致系统性能下降。我们希望优化Kafka的性能,不知道有没有什么好的实践?特别是在实时数据同步的场景下,优化性能显得尤为重要。

Kafka的性能优化是一个复杂的话题,尤其是在处理大规模实时数据同步时。以下是一些实用的优化实践,可以帮助提高Kafka的性能:

- 增加分区数:Kafka的吞吐量与分区数密切相关。通过增加分区数,可以提高Kafka的并行处理能力,从而提升整体性能。

- 调整批量大小:在生产者配置中,适当增大批量大小(

batch.size),可以提高消息的写入效率。较大的批量可以减少IO操作次数,从而提升性能。

- 压缩消息:启用消息压缩(如Snappy或LZ4),可以减少网络传输的数据量,提高消息传输效率。

- 优化消费者配置:调整消费者的

fetch.min.bytes和fetch.max.wait.ms参数,可以增加批量消费的消息数,减少网络请求次数。 - 合理配置Broker:根据硬件资源情况,合理配置Kafka Broker的线程数、内存和磁盘,使其在高负载下仍能保持高效运转。

- 使用FineDataLink进行数据优化:FineDataLink提供了一站式的数据集成平台,能够合理配置Kafka的数据同步任务,提高数据传输效率。它支持对数据源的单表、多表、整库等多种数据同步方式,并提供强大的数据调度功能,使得Kafka的性能得到大幅优化。

此外,还有以下几点需要注意:

- 监控和调优:通过Kafka的监控工具(如Kafka Manager或Prometheus)实时监控集群性能,并根据监控数据进行针对性的调优。

- 网络优化:确保Kafka集群的网络环境良好,减少网络延迟和丢包率。

- 硬件升级:在可能的情况下,升级Kafka集群的硬件配置,如增加内存和磁盘IOPS。

通过以上优化措施,Kafka的数据同步性能可以得到显著提升,为企业的数据处理提供更高效的支持。