在处理大规模数据时,如何确保数据的一致性和高效性,是许多企业面临的核心挑战。Kafka,作为一个流行的数据流平台,常被应用于实时数据传输环境中。然而,对于 Kafka 能否真正保障数据一致性,尤其是在复杂的数据同步场景中,仍然存在不少疑问。在这篇文章中,我们将深入探讨以下几个关键问题:

- Kafka 在保障数据一致性方面的机制是什么?

- 写入复制机制如何在实际应用中提供保障?

- 使用 Kafka 的过程中可能遇到哪些数据一致性问题及解决方案?

接下来,我们将逐一解答这些问题,帮助你更好地理解 Kafka 在数据一致性方面的角色。

🚀 一、Kafka 在保障数据一致性方面的机制是什么?

1. Kafka 的架构概述

在谈论 Kafka 如何保障数据一致性之前,我们需要先了解其基本架构。Kafka 采用分布式架构,数据以主题(topic)为单位进行组织,每个主题由多个分区(partition)组成。分区的存在使得 Kafka 能够并行处理大量数据,这也是其高吞吐量的基础。

Kafka 的数据一致性机制主要依赖于其复制模型。在 Kafka 中,每个分区都有多个副本(replica),这些副本分布在不同的 Broker 上以实现容错能力。这种多副本机制是 Kafka 能够保障数据一致性的基础,因为即使某个 Broker 出现故障,其他 Broker 上的副本仍然可以提供数据。

2. 副本同步与领导者选举

在 Kafka 中,一个分区的副本分为领导者(leader)和跟随者(follower)。所有的数据写入和读取操作都通过领导者进行。当领导者接收到新的消息时,它会负责将这些消息分发给所有的跟随者副本。

这种设计使得 Kafka 能够在某个 Broker 出现故障时迅速选出新的领导者,从而继续提供服务。这一过程被称为领导者选举,其核心目的是保障数据的一致性和可用性。

3. ISR 副本集合的作用

Kafka 引入了 ISR(In-Sync Replicas,同步副本)集合的概念,来帮助保障数据一致性。ISR 集合包含所有与领导者同步的副本。当一个跟随者副本落后于领导者副本的进度时,它将被移出 ISR 集合。

这种机制确保了只有那些最新的、与领导者同步的副本才能被认为是可靠的。当领导者失效时,新的领导者会从 ISR 集合中选出,确保数据的一致性。

🔍 二、写入复制机制如何在实际应用中提供保障?

1. 数据写入过程详解

Kafka 中的数据写入过程是保障数据一致性的核心。每条消息在写入到 Kafka 的过程中,会被记录到日志中,并同步到 ISR 集合中的所有副本。这种日志记录和同步机制确保了即使发生故障,也能恢复到最新的状态。

在实际应用中,企业通常会根据数据的重要性来设置副本的数量。副本数量越多,数据的一致性和容错能力越强。然而,这也意味着更高的资源消耗和更长的写入延迟。

2. 复制因子与ACK机制

Kafka 的复制因子(replication factor)指的是每个分区要维护的副本数量。一个合理的复制因子可以有效提高数据的可靠性。然而,更多的副本也意味着更高的资源消耗和更长的延迟,因此企业需要根据自身需求进行权衡。

ACK(acknowledgment)机制是 Kafka 写入过程中另一个重要部分。生产者在发送消息后,会等待来自领导者的确认,以确认消息已被成功写入。Kafka 提供三种不同级别的 ACK 机制(0、1、-1),企业可以根据一致性与延迟的平衡来选择合适的级别。

3. 实际应用中的挑战与解决方案

尽管 Kafka 的复制机制在理论上能够保障数据一致性,但在实际应用中,企业可能仍然会遇到一些挑战。例如,网络延迟可能会导致副本与领导者之间的同步失败。此外,硬件故障也可能导致副本数据的丢失。

为了解决这些问题,企业可以采取以下措施:

- 定期监控 Kafka 集群的健康状态,确保所有副本都处于同步状态。

- 使用自动化工具进行故障检测和恢复,减少人为干预的延迟。

- 优化网络配置,减少网络延迟对副本同步的影响。

🔍 三、使用 Kafka 的过程中可能遇到哪些数据一致性问题及解决方案?

1. 数据丢失与重复

在使用 Kafka 的过程中,数据丢失和重复是两个常见的问题。数据丢失通常发生在网络故障或硬件故障导致的副本不同步时,而数据重复则可能出现在生产者重试机制中。

为了解决数据丢失问题,企业可以增加副本数量,并使用更严格的 ACK 机制。对于数据重复问题,可以使用去重逻辑或幂等性机制来确保数据的一致性。

2. 网络分区与数据一致性

网络分区是另一个可能影响 Kafka 数据一致性的问题。当网络分区发生时,Kafka 集群中的某些 Broker 可能无法与其他 Broker 通信,从而导致数据不同步。

解决网络分区问题的一个有效方法是使用 ZooKeeper 进行集群管理。ZooKeeper 可以帮助管理集群中的领导者选举和副本同步,从而在网络分区发生时确保数据的一致性。

3. 系统性能与一致性的权衡

在实际应用中,企业常常需要在系统性能和数据一致性之间进行权衡。为此,企业可以通过调整 Kafka 的配置参数(如副本数量、ACK 级别等)来实现最佳平衡。

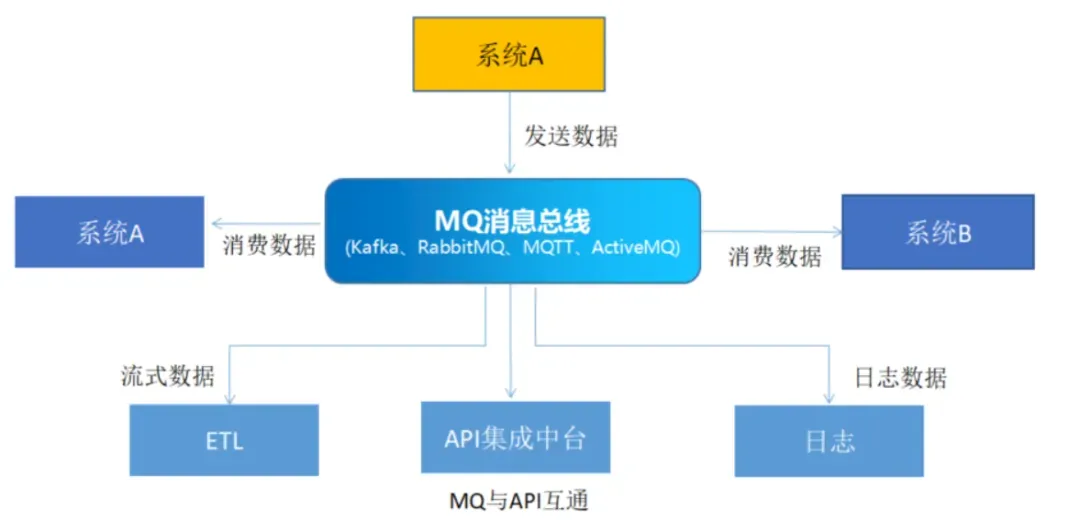

此外,企业还可以考虑使用如 FineDataLink体验Demo 这样的国产高效低代码ETL工具,来简化数据集成和同步过程,从而在保障数据一致性的同时提高系统性能。

📝 总结

Kafka 的复制机制为数据一致性提供了重要保障,但在实际应用中,企业仍需面临网络延迟、硬件故障等挑战。通过合理配置 Kafka 的参数、监控集群状态,以及使用合适的数据集成工具,企业可以在提升系统性能的同时,确保数据的一致性。希望本文能帮助你更清晰地理解 Kafka 在数据一致性保障中的角色,并为你的数据架构设计提供有价值的参考。

本文相关FAQs

🤔 Kafka的写入复制机制能否有效保障数据一致性?

在使用Kafka的过程中,老板一直在强调数据一致性的重要性,但我们团队对Kafka的写入复制机制是否能真正保障数据一致性存在疑虑。有没有大佬能详细讲一下这个机制的工作原理?在实际应用中,它能否真正保证数据不丢失、不重复?

Kafka的写入复制机制是其架构中的一大亮点,也是保障数据一致性的关键因素之一。在谈论数据一致性时,我们通常会考虑数据的持久性和数据的顺序性。Kafka通过将数据分区并存储在多个副本节点上,实现了高可用性和容错性。

- 副本机制:每个Kafka分区都有一个leader和多个follower。数据的写入首先发生在leader上,然后异步复制到follower。为了实现数据一致性,Kafka提供了ISR(In-Sync Replicas)机制,确保至少有一个follower与leader保持同步。

- 确认机制:Kafka的生产者可以通过设置acks参数来定义数据写入的确认级别。比如,acks=all意味着只有当所有ISR副本确认接收到数据后,生产者才会收到写入成功的确认。这种机制大大增强了数据一致性的保障能力。

- 数据顺序:Kafka天然支持数据的有序性,尤其在单分区内,数据按照写入的顺序进行存储和读取。这对于需要严格顺序处理的数据流应用至关重要。

然而,Kafka的复制机制也有其局限性。由于副本间的数据复制是异步的,因此在极少数情况下,可能会出现短暂的数据不一致,尤其是在leader节点故障切换时。为了提升一致性,用户可以适当调整复制因子、ISR配置和acks参数。

在实际应用中,理解和配置Kafka的复制机制是保障数据一致性的关键。通过合理的配置,可以在性能和一致性之间找到一个平衡点。对于需要实现高性能实时数据同步的企业,诸如FineDataLink这样的工具可以通过Kafka来实现数据的高效传输和一致性保障。更多详情可以通过 FineDataLink体验Demo 了解。

🔄 数据同步时,Kafka如何处理数据丢失和重复的问题?

我们在使用Kafka进行数据同步时,经常会担心数据丢失或重复的问题。尤其是在系统高负载或节点故障时,这种情况更为突出。有没有什么好的实践可以帮助我们在使用Kafka时减少这些问题的发生?

在数据同步的场景中,数据丢失和重复是两个常见的挑战。Kafka的设计初衷就是为了高吞吐量和高可用性,但在极端情况下,数据丢失和重复仍可能发生。以下是一些实践经验,可以帮助减少这些问题:

- 生产者配置:通过设置acks=all,可以确保数据在写入时至少有一个follower确认接收到数据,从而减少数据丢失的风险。此外,幂等生产者(idempotent producer)选项可以帮助防止数据重复。

- 消费者配置:消费者可以通过设置enable.auto.commit=false来手动管理偏移量的提交,确保只有在处理成功后才提交偏移量,从而防止重复消费。

- 数据副本配置:增加分区的副本数(replication.factor)可以提高数据的持久性和可用性,即使多个节点同时故障,也能确保数据不丢失。

- 错误处理机制:在高可用系统中,设计健壮的错误处理机制至关重要。通过设置合理的重试策略和错误日志,可以及时发现和处理异常情况。

此外,企业在使用Kafka进行实时数据同步时,可以结合使用数据集成平台,如FineDataLink,实现更加可靠的数据同步和管理。FineDataLink通过Kafka实现数据的实时传输和故障恢复能力,提供了便利的工具和界面来配置和监控数据同步任务。

🤯 Kafka在大规模数据环境中如何优化性能与一致性?

在大规模数据环境下,Kafka的性能表现和一致性保障面临不少挑战。我们公司目前的数据量增长迅猛,对Kafka的性能和一致性提出了更高要求。有没有针对大规模环境的优化建议?

在大规模数据环境中,Kafka需要在性能和一致性之间找到一个平衡点。以下是一些优化建议,可以帮助提升Kafka在大规模数据环境下的表现:

- 分区设计:合理的分区设计是优化Kafka性能的基础。在大规模环境下,增加分区数可以提高并发处理能力,但需要注意分区过多可能导致管理复杂度增加。

- 硬件配置:提升Kafka集群的硬件配置,包括磁盘IO、网络带宽和内存大小,是提高性能的直接手段。使用SSD替代HDD能显著提升读写速度。

- 批量处理:配置生产者和消费者的批量处理参数(如batch.size和fetch.min.bytes),可以减少网络请求次数,提高数据吞吐量。

- 压缩机制:启用消息压缩(如gzip或snappy)可以有效降低网络带宽的使用,提高传输效率。

- 监控与调优:使用Kafka的监控工具(如Kafka Manager或Prometheus)实时监控集群状态,及时发现和解决性能瓶颈。

企业在大规模数据环境中使用Kafka时,FineDataLink这样的工具可以提供更高效的管理和优化支持。通过FineDataLink的可视化界面和自动化配置功能,企业可以更轻松地实现数据的高效传输和一致性保障。更多详情请参考 FineDataLink体验Demo 。