在数据驱动的时代,企业的竞争力往往取决于其处理和利用数据的能力。然而,随着数据量的急剧增长和数据源的多样化,企业面临着如何高效、可靠地进行数据同步和集成的挑战。许多企业在ETL(Extract, Transform, Load)过程中遇到的瓶颈,可能正在阻碍其数字化转型的步伐。这就引出了一个重要的探讨:Kafka是否能够作为统一ETL数据路径的核心工具,从而提升平台的一致性与复用率?本文将深入探讨以下几个关键问题:

- Kafka在统一ETL数据路径中的角色与优势;

- 如何利用Kafka提升数据平台的一致性与复用率;

- 实际案例解析:Kafka如何解决ETL中的常见问题;

- FineDataLink如何作为低代码ETL工具,增强Kafka的效能。

通过对这些问题的深入分析,我们希望为您提供实用且可操作的见解,帮助您在数据处理的道路上走得更稳、更快。

🚀 一、Kafka在统一ETL数据路径中的角色与优势

1. 数据流的实时处理能力

在大数据环境下,实时数据处理是企业保持竞争力的关键。传统的批处理方式往往无法满足快速变化的业务需求,而Kafka作为一种分布式流处理平台,能够支持大规模的实时数据流处理。其高吞吐量和低延迟的特性,使其成为企业进行实时数据集成的理想选择。

- 高吞吐量:Kafka能够处理数百万条消息,使其在大规模数据环境下依然保持高效。

- 低延迟:数据从生产者到消费者的传输延迟可低至毫秒级,这对于需要实时响应的业务场景至关重要。

例如,在金融行业,实时处理交易数据能够为风险控制提供即时的决策支持。而在电子商务领域,实时分析用户行为数据,可以帮助企业更好地理解客户需求,优化推荐系统。

2. 可扩展的架构设计

Kafka的架构设计天然支持水平扩展,这意味着企业可以根据自身业务需求的变化,灵活地调整系统容量。这种可扩展性,使得Kafka能够适应从小型到超大规模的数据处理任务。

- 分布式系统:Kafka的分布式特性允许其在多个服务器上运行,确保数据的可靠性和持久性。

- 分区与复制机制:通过分区,Kafka能够实现消息的并行处理,而复制机制则保证了数据的高可用性。

这种架构设计不仅增强了系统的弹性,还降低了因单点故障导致的数据丢失风险。对于需要处理海量数据的企业来说,Kafka的扩展能力显然是一个巨大的优势。

3. 数据的一致性与持久性

在数据集成过程中,数据的一致性与持久性是保证数据质量的基础。Kafka通过其独特的日志存储机制,确保了数据从生产到消费整个过程中的一致性。

- 日志存储机制:所有的数据被写入持久化日志,确保任何时刻的数据都可以被重放和恢复。

- 事务支持:Kafka提供了端到端的事务支持,确保在复杂数据流中不会发生数据丢失和重复。

这种机制对于需要追踪和审计数据流的行业(如金融、医疗)尤为重要,Kafka能够帮助企业有效地保证数据的一致性和完整性。

4. 灵活的生态系统

Kafka拥有一个丰富的生态系统,包括Kafka Streams、Kafka Connect等组件,能够支持多种数据源和目标之间的连接与处理。

- Kafka Streams:用于构建实时流数据处理应用程序,提供了高层次的流处理API。

- Kafka Connect:提供连接器框架,可以轻松地与各种数据源和目标系统集成。

这种灵活性使得企业能够根据自身需求,构建定制化的数据处理解决方案,进一步提高数据集成的效率和效果。

通过上述分析,我们可以看到,Kafka在统一ETL数据路径中扮演着至关重要的角色。它不仅能够满足企业对实时数据处理的需求,还能通过其强大的扩展能力和灵活的生态系统,提升数据平台的一致性与复用率。

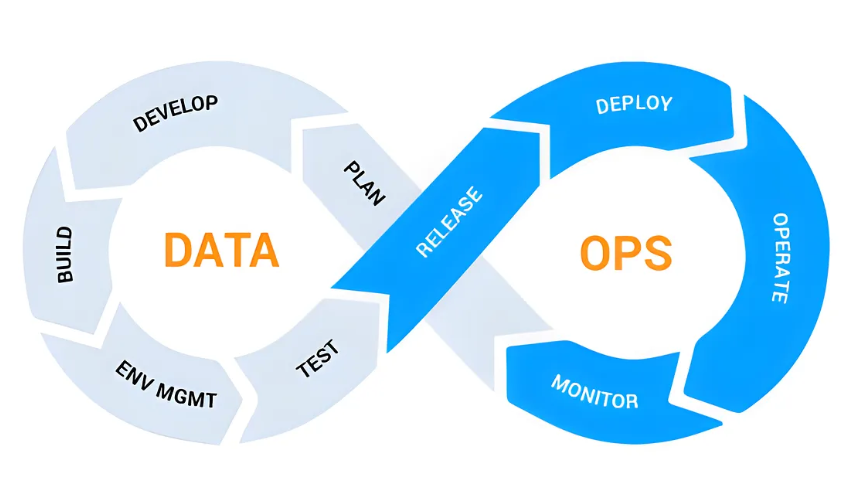

🔄 二、如何利用Kafka提升数据平台的一致性与复用率

1. 数据平台架构的优化

在数据平台的构建中,架构的优化是确保系统一致性与复用率的核心。Kafka的引入可以有效简化数据流动路径,使得数据平台的架构更加清晰和高效。

- 统一数据流:通过Kafka,企业可以集中管理不同来源的数据流,实现数据流的统一化和标准化。

- 模块化设计:利用Kafka Connect和Kafka Streams,企业可以将数据处理流程模块化,方便后续的扩展和维护。

这种架构优化不仅提高了系统的灵活性,还减少了由于复杂数据流导致的潜在错误和数据不一致问题。通过统一数据路径,企业可以更好地控制和监控数据流动,提升数据处理的准确性和可靠性。

2. 提高数据处理的效率

Kafka的高性能特性能够显著提升数据处理的效率,特别是在需要处理大量实时数据的场景中。通过优化数据传输和处理流程,Kafka为企业提供了一个高效的数据处理平台。

- 并行处理:通过分区机制,Kafka支持大规模的并行处理,能够有效降低数据处理的时间。

- 缓存机制:Kafka的缓存机制能够减少数据重复传输的次数,提高数据处理的效率和速度。

这些优化措施使得企业在处理复杂数据任务时,能够更快地响应业务需求,提升整体的运营效率。

3. 增强数据复用的能力

数据复用是提高企业数据价值的关键。通过Kafka,企业可以实现数据的高效复用,最大化数据的使用价值。

- 数据共享:通过Kafka的主题机制,企业可以实现不同部门和系统之间的数据共享,避免数据孤岛的问题。

- 数据再加工:利用Kafka Streams,企业可以对数据进行实时的再加工和分析,生成新的数据产品。

这种数据复用能力,不仅提高了数据的使用效率,还为企业创造了更多的数据价值。通过共享和再加工,企业能够更好地挖掘数据中的潜在价值。

4. 保障数据的安全与合规

随着数据安全与合规要求的提升,企业在数据处理过程中必须确保数据的安全性和合规性。Kafka通过其安全机制和日志记录能力,为企业提供了可靠的数据安全保障。

- 安全机制:Kafka支持多种安全机制,包括SSL/TLS加密、SASL认证等,保护数据传输的安全性。

- 日志记录:Kafka的日志记录功能,能够为企业提供详细的数据传输和处理记录,支持合规审计。

通过保证数据的安全性和合规性,企业可以更好地满足法律法规的要求,降低数据泄露和违规的风险。

总的来说,Kafka通过其架构优化、高效处理、数据复用和安全保障,显著提升了数据平台的一致性与复用率。利用Kafka,企业能够更好地管理和利用数据资源,推动数字化转型的进程。

🔍 三、实际案例解析:Kafka如何解决ETL中的常见问题

1. 数据延迟与丢失问题的解决

在ETL过程中,数据延迟和数据丢失是常见的问题,尤其是在数据量大和数据源复杂的情况下。Kafka通过其独特的设计和机制,有效解决了这些问题。

- 持久化日志:Kafka的持久化日志机制确保了数据不会因系统故障而丢失。在数据流中,任何一条消息都可以被持久化下来,确保在故障恢复后依然可以被处理。

- 事务支持:Kafka支持端到端的事务处理,确保数据流中的每一条消息的处理都是完整的,不会因中途失败而导致数据丢失或重复处理。

通过这些机制,Kafka在ETL过程中能够有效减少数据延迟和丢失,确保数据处理的完整性和准确性。

2. 数据整合与转换的优化

在ETL流程中,数据整合和转换是关键步骤,通常涉及多个数据源和复杂的数据转换逻辑。Kafka通过其强大的流处理功能,显著优化了数据整合与转换的过程。

- Kafka Streams:作为一个轻量级的流处理库,Kafka Streams能够在数据流中实时进行数据转换和整合,减少了传统ETL工具中因批量处理引起的延迟。

- 实时数据处理:通过实时处理,Kafka可以在数据到达的瞬间进行转换和整合,消除了批处理带来的延迟问题。

这些优化措施,使得企业在处理跨系统和多源数据时,能够更加高效和灵活,提升了数据整合与转换的效率。

3. 数据质量与一致性保障

数据质量和一致性是ETL过程中必须解决的问题。Kafka通过其一致性机制和监控工具,为企业提供了强有力的数据质量和一致性保障。

- 一致性机制:通过Kafka的复制和分区机制,企业能够确保数据在整个处理流程中的一致性,避免数据不一致的问题。

- 监控工具:Kafka提供了丰富的监控工具,帮助企业实时监控数据流动,及时发现和解决数据质量问题。

这些保障措施,不仅提高了数据处理的质量,也增强了企业对数据的信任度,确保了数据在ETL过程中的一致性。

4. 提升ETL效率与可扩展性

在大数据环境下,高效和可扩展的ETL流程是企业成功的关键。Kafka通过其高性能和可扩展的架构,为企业提供了高效、可扩展的ETL解决方案。

- 高性能架构:Kafka的高性能架构,能够支持海量数据的实时处理,显著提升了ETL的效率。

- 可扩展性:Kafka的分布式设计,使得企业可以根据业务需求灵活扩展ETL系统的容量,满足不断增长的数据处理需求。

通过提升ETL效率和可扩展性,Kafka帮助企业在大数据环境下,快速响应业务变化,保持竞争优势。

在实际案例中,Kafka通过其高效的数据处理能力和灵活的架构设计,解决了ETL过程中常见的问题,为企业的数据集成和处理提供了强有力的支持。

🔧 四、FineDataLink如何作为低代码ETL工具,增强Kafka的效能

1. 简化ETL流程的配置与管理

在复杂的ETL流程中,配置和管理往往是耗时且易出错的环节。FineDataLink通过其低代码平台,简化了ETL流程的配置与管理,使得企业能够更专注于业务逻辑而不是技术细节。

- 低代码开发:FineDataLink提供了直观的图形化界面,用户可以通过拖拽组件,快速配置和管理ETL流程,无需深入编写代码。

- 自动化任务调度:通过自动化的任务调度功能,FineDataLink能够帮助企业按需执行数据集成任务,提高管理效率。

这种简化和自动化,使得企业能够更高效地管理ETL流程,减少人为错误,提高数据处理的准确性。

2. 提供灵活的集成与扩展能力

FineDataLink不仅提供了丰富的内置功能,还支持灵活的集成与扩展,使得企业能够根据自身需求,定制化ETL解决方案。

- 多源数据支持:FineDataLink支持多种数据源的集成,包括关系数据库、NoSQL数据库、云存储等,满足企业多样化的数据集成需求。

- 插件扩展机制:通过插件扩展机制,企业可以根据自身需要,扩展FineDataLink的功能,实现更多的业务场景。

这种灵活的集成与扩展能力,使得FineDataLink能够更好地适应企业的个性化需求,提供更具针对性的ETL解决方案。

3. 增强数据处理的实时性与可靠性

在数据处理的实时性和可靠性方面,FineDataLink通过与Kafka的结合,显著增强了数据处理的能力。

- 实时数据同步:FineDataLink利用Kafka的流处理能力,实现数据的实时同步,确保数据处理的时效性。

- 高可靠数据传输:通过Kafka的高可靠传输机制,FineDataLink能够提供稳定的数据处理流程,降低数据丢失和错误的风险。

这种增强的实时性和可靠性,使得企业能够更快速地响应业务需求,提高数据处理的效率和质量。

4. 提供全面的监控与分析工具

为了帮助企业更好地管理和优化ETL流程,FineDataLink提供了全面的监控与分析工具,支持企业对数据处理全过程进行监控和优化。

- 实时监控:FineDataLink提供实时的监控界面,帮助企业及时发现和解决数据处理中的问题。

- 数据分析:通过内置的数据分析工具,企业可以对数据处理过程进行深入分析和优化,提高ETL流程的效率。

这些监控与分析工具,帮助企业更好地掌控数据处理流程,提高整体的数据管理能力。

通过FineDataLink与Kafka的结合,企业能够构建更高效、灵活和可靠的ETL解决方案,提升数据处理的效能,为业务发展提供强有力的支持。

📈 结论

通过对Kafka在ETL数据路径中的应用分析,我们可以看到,Kafka不仅在实时数据处理、高效的数据管理中发挥了关键作用,还通过其灵活的架构设计和强大的生态系统,显著提升了数据平台的一致性与复用率。结合FineDataLink等低代码工具,企业能够更加高效地构建和管理ETL流程,推动数字化转型的步伐。在未来的数据驱动世界中,如何更好地利用这些工具,将成为企业保持竞争力的关键所在。

本文相关FAQs

🤔 什么是Kafka在ETL中的角色?为什么这么多企业选择它?

很多人对ETL流程中的中间件选择感到困惑。老板要求我们研究Kafka作为ETL工具的一部分,但我不太清楚它在整个流程中具体的角色和优势是什么。有没有大佬能分享一下,为什么这么多企业选择Kafka?

Kafka在ETL过程中扮演着关键角色,尤其是在处理大规模流数据时。它不仅是一个消息队列,更是一个分布式流处理框架,这使得它对数据的实时处理和传输非常高效。企业选择Kafka主要有以下几个原因:

- 高吞吐量和低延迟:Kafka可以处理每秒数百万条消息,且延迟通常在毫秒级别,非常适合需要实时数据处理的场景。

- 持久性和可靠性:Kafka的设计使其数据可以持久化并拥有很高的可靠性,即使在系统故障时也能保证数据不丢失。

- 灵活的扩展性:Kafka能够方便地扩展,适应企业数据增长的需求。

- 支持多种数据源和目标:它能与众多数据源和目标无缝集成,帮助企业构建统一的数据管道。

在实际应用中,Kafka被用来暂存和传输ETL过程中的数据,尤其是增量数据的同步非常便捷。例如,当一个企业的数据量级较大时,使用Kafka可以有效解决数据实时同步的难题。Kafka的分布式架构确保了数据在多个节点之间的均衡分布和处理,提升了平台的一致性与复用率。

企业在数字化转型的过程中,需要处理越来越复杂的数据集成任务。Kafka作为ETL流程的中间件,能够帮助企业优化数据路径,简化数据处理流程。它的强大能力使得企业能够更快地响应市场变化,提供更及时的业务决策支持。

📈 如何利用Kafka提升平台的一致性与复用率?

老板希望我们能提升平台的一致性与复用率,而Kafka被认为是一个潜在的解决方案。有没有人能分享一下具体操作经验,如何利用Kafka来实现这些目标?

使用Kafka可以有效提升平台的一致性与复用率,但这需要对其进行合理的配置和使用。以下是一些具体的操作经验:

- 集中式数据流管控:通过Kafka,企业可以实现对所有数据流的集中管理。这意味着数据从多个源进入Kafka,并通过它统一分发到多个目标,确保数据的一致性。

- 实时数据处理:Kafka的设计使得它能够处理实时数据流,帮助企业在数据更新时即时同步到各个需要的模块或服务。这种实时性确保了所有模块使用的数据都是最新的,提高了一致性。

- 数据复用率提升:Kafka允许数据被多个消费者使用而不需要额外的复制工作。换句话说,同一份数据可以被多个应用、分析工具或存储系统使用,这显著提升了数据的复用率。

在具体实施过程中,企业可以结合使用Kafka并配合其他技术工具来创建更加智能化的数据管道。一个典型的案例是使用FineDataLink(FDL),这是一款企业级数据集成平台,能够与Kafka无缝集成。通过 FineDataLink体验Demo ,企业可以轻松实现数据源的实时同步,进一步提升平台的效率和一致性。

此外,Kafka的扩展性和持久性确保了数据在处理过程中不会丢失或损坏,这对提升平台的一致性至关重要。企业可以通过配置Kafka的主题和消费者组,优化数据流的处理路径,实现更高效的数据复用。

🔧 实际操作中如何配置Kafka以优化ETL数据路径?

我们已经了解了Kafka的优势,但在实际操作中,配置Kafka以优化ETL数据路径似乎有些复杂。有没有高手能分享一下具体的配置方法和注意事项?

配置Kafka以优化ETL数据路径需要一定的技术功底和实践经验。以下是一些具体的步骤和注意事项:

- Kafka集群规划:首先要根据企业的数据量和处理需求规划Kafka集群的规模。通常,集群的节点数应能支持高负载的数据处理需求,同时也要考虑容错能力。

- 主题设计:合理设计Kafka主题是优化数据路径的关键。主题应该根据数据类型和处理需求进行划分,以确保数据在传输过程中能被正确识别和处理。

- 分区和副本配置:设置合理的分区和副本数可以提高Kafka的并行处理能力和容错能力。一般建议根据数据量和处理速度需求进行调整,确保分区数不至于过高或过低。

- 消费者组管理:消费者组的配置可以帮助优化数据消费的效率。通过设置多个消费者组,可以实现数据的负载均衡和处理速度提升。

- 故障恢复机制:Kafka提供了多种故障恢复机制,企业可以利用这些机制来确保数据在传输过程中不受故障影响。配置日志保留策略和自动重试机制是常见的做法。

在实际操作中,企业往往需要结合其他技术工具来进一步优化Kafka的配置。例如,使用FineDataLink这样的数据集成平台可以简化Kafka的配置过程,将复杂的技术细节隐藏在平台的自动化流程中,企业用户只需专注于数据路径的设计和优化。

通过这些配置方法,企业可以有效优化ETL数据路径,提升数据处理效率和平台的一致性。这不仅能帮助企业在数据处理中获得更好的性能表现,也能确保数据在传输过程中始终保持完整和一致。