大数据时代,企业数据量爆炸性增长,如何高效地进行数据同步和处理成了一个亟待解决的问题。Kafka作为一种分布式流处理平台,在企业数据集成中扮演着至关重要的角色。特别是在数据按业务拆分和标签分类推送的场景中,Kafka提供了强大的支持。本文将深入探讨Kafka如何在这些场景下进行ETL(Extract, Transform, Load)操作,通过以下几个关键问题揭示其实现路径:

- Kafka如何支持业务数据拆分与实时同步?

- 如何通过标签分类实现精准的数据推送?

- 在复杂的数据管道中,Kafka的优势是什么?

- FineDataLink如何结合Kafka实现高效的ETL流程?

通过这些问题,我们将全面理解Kafka在企业数据管理中的应用价值及其操作细节。

🏷️ Kafka支持业务数据拆分与实时同步

1. 业务数据拆分的重要性

企业在进行数据管理时,通常会面对庞大的数据集,这些数据需要根据业务需求进行拆分和处理。业务数据拆分不仅提高了处理效率,还能促进数据的精准应用。例如,一个电商平台需要将订单数据、客户数据和产品数据分别处理,以便在不同的业务模块中应用。

- 提高处理效率:通过将数据拆分为多个小块,可以实现并行处理,减少单一数据源的负担。

- 促进精准应用:不同业务部门对数据的需求不同,拆分后的数据可以更好地满足各部门的精准需求。

2. Kafka在实时同步中的角色

Kafka作为一种高吞吐量的消息队列系统,非常适合用于实时数据同步。它的设计使其能够处理海量数据流,并确保数据的快速传输。

- 高吞吐量和低延迟:Kafka能处理大量数据并保持低延迟,适合实时数据同步的场景。

- 可靠的数据传输:通过日志机制,Kafka能确保数据在传输过程中的完整性和准确性。

3. 实现业务数据拆分的技术细节

在Kafka中,数据可以通过主题(Topic)进行组织,不同的业务数据可以分配到不同的主题。通过这种方式,Kafka实现了业务数据的有效拆分。

- 主题(Topic)的使用:为每个业务模块创建独立的主题,确保数据的隔离和专用。

- 分区(Partition)的配置:一个主题可以有多个分区,提高数据处理的并行度。

🔖 标签分类实现精准数据推送

1. 标签分类在数据推送中的应用

标签分类用于细化数据的属性,使得数据推送更加精准。通过标签分类,企业能够实现个性化的业务逻辑,如根据用户行为标签推送定制化的广告。

- 用户行为分析:通过分析用户的行为数据,给用户打上特定的标签,实现有针对性的推送。

- 个性化营销:根据用户的标签,企业可以设计个性化的营销策略,提高转化率。

2. Kafka如何实现标签分类推送

Kafka支持复杂的消费者组机制,结合标签分类,可以实现精准的数据推送。消费者组能够监听特定的主题和分区,获取对应标签的数据。

- 消费者组机制:通过为不同标签设置独立的消费者组,确保数据的精准推送。

- 动态标签配置:可以通过Kafka Streams动态调整标签配置,适应业务需求变化。

3. 技术实现细节

为了实现标签分类推送,企业需要在数据流中引入标签分类逻辑。Kafka Streams作为一个强大的流处理库,能够实现复杂的标签分类和数据过滤操作。

- 数据过滤:使用Kafka Streams对数据进行过滤和分类,确保每个标签的数据可以被准确识别。

- 实时处理:Kafka Streams支持实时处理,使得标签分类推送能够迅速响应业务变化。

🚀 Kafka在复杂数据管道中的优势

1. 复杂数据管道的挑战

企业数据管道通常涉及多个数据源和目标,需要处理不同格式的数据并进行整合。在复杂的数据管道中,数据的流动和处理效率至关重要。

- 数据源多样化:数据管道需要处理来自不同系统的数据,格式和协议可能各不相同。

- 数据整合需求:需要将不同来源的数据进行整合,形成统一的数据视图。

2. Kafka的优势

Kafka在复杂数据管道中显示出独特的优势。它能处理多样化的数据源,并通过其强大的流处理能力实现数据的快速整合。

- 支持多协议:Kafka Connect能够与多种数据源进行连接,支持丰富的协议。

- 流处理能力:Kafka Streams提供了强大的流处理能力,能够实时整合和转换数据。

3. 整合与管理

企业可以利用Kafka的能力构建强大的数据管道,确保数据的整合与管理实现高效。

- 连接器的使用:利用Kafka Connect,可以轻松连接不同的数据源,进行数据采集。

- 实时转换:通过Kafka Streams,实时转换和处理数据,提高数据管道的响应速度。

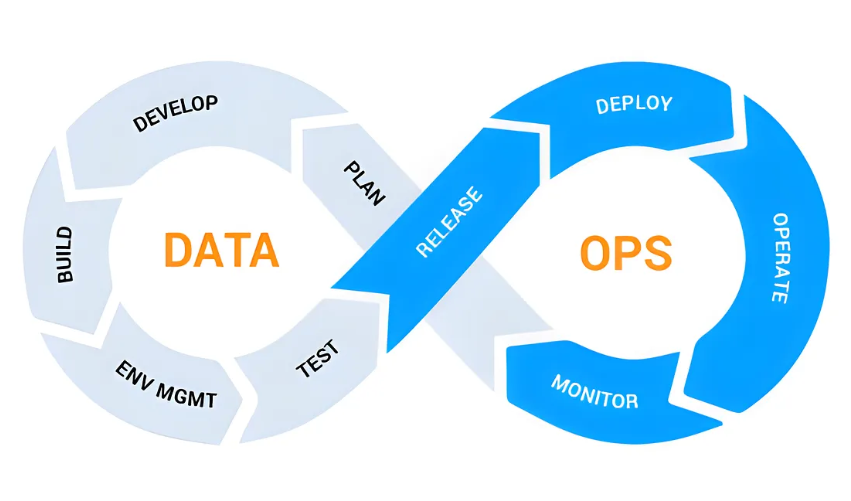

🌐 FineDataLink结合Kafka实现高效ETL流程

1. FineDataLink的简介

FineDataLink是一款国产的、高效实用的低代码ETL工具,专为大数据环境下的数据集成而打造。它能帮助企业实现实时和离线数据采集、管理与治理。 FineDataLink体验Demo 。

2. Kafka在FineDataLink中的应用

FineDataLink使用Kafka作为数据同步中间件,特别是在实时任务和数据管道中发挥作用。它能帮助企业实现高效的数据同步和故障恢复。

- 数据同步中间件:Kafka能暂存来源数据库的增量部分,确保数据的实时写入。

- 读写分离与故障恢复:通过Kafka的日志机制,FineDataLink实现了数据读写分离和故障快速恢复。

3. 实现高效ETL的技术细节

FineDataLink结合Kafka,提供了一整套高效ETL解决方案,帮助企业实现复杂的数据集成和实时处理。

- 低代码配置:FineDataLink的低代码设计使得ETL配置更加简单快捷,降低了使用门槛。

- 实时数据传输:通过Kafka的中间件功能,实现了数据的实时传输,提高了ETL流程的效率。

📈 总结与价值强化

通过本文的探讨,我们发现Kafka在按业务拆分ETL和支持标签分类推送业务队列中具备强大的优势。它不仅提供了高效的数据同步能力,还支持多样化的标签分类推送和复杂数据管道处理。同时,结合国产工具FineDataLink,企业能够更加轻松地实现数据集成与管理,推动数字化转型。希望这些技术洞见能够帮助读者在大数据处理领域取得更大的成功。

本文相关FAQs

🤔 Kafka如何实现按业务拆分的ETL?

老板要求我们优化数据处理流程,听说Kafka能做按业务拆分的ETL,但具体怎么操作有点迷糊。有没有大佬能分享一下这种ETL的实现方法?我想知道Kafka在数据拆分上到底有多强大,怎么才能高效地进行业务拆分?

Kafka在数据处理领域确实具有强大的能力,尤其是当数据量巨大且需要实时处理时,它的优势更加显著。要实现按业务拆分的ETL,首先需要理解Kafka的消息传递机制。Kafka通过主题(Topic)来组织消息,每个主题可以视为一个业务的独立消息通道。在实现按业务拆分的ETL时,通常需要做到以下几点:

- 定义业务主题:根据业务需求,设计多个主题,每个主题负责一个特定的业务线的数据处理。

- 数据生产者与消费者:设置不同的生产者和消费者应用,将对应业务的数据写入和读取特定的主题。

- 消息过滤与处理:使用Kafka Streams或类似工具对消息进行实时过滤、转换,实现ETL的复杂逻辑。

Kafka的弹性扩展能力支持处理海量数据,并且通过分区(Partition)机制可以做到数据的并行处理,提升速度和效率。对于企业来说,使用Kafka进行业务拆分的ETL可以显著优化数据处理流程,实现数据的实时传输和分析。

📊 如何用Kafka支持标签分类推送业务队列?

有没有小伙伴知道怎么用Kafka支持标签分类推送业务队列?我们的业务需求要根据标签来分类处理数据,感觉有点复杂,用Kafka怎么实现比较好?求解答,最好能有点案例分享。

在数据处理过程中,标签分类推送是一个常见的需求,尤其是在用户行为分析和精准营销领域。Kafka作为一个高效的消息系统,可以很好的支持这种需求。实现方式通常包括以下步骤:

- 标签识别与分类:首先,需要对数据进行标签识别,可以通过预设的规则或机器学习模型来识别数据中的标签。

- 主题设计与推送:根据标签设计多个Kafka主题,每个主题代表一个标签类别。数据生产者将识别后的数据推送到对应的主题。

- 消费与分发:消费者根据业务需求订阅相关标签的主题,实时处理或分发数据到后续系统。

Kafka的高吞吐量和低延迟使得标签分类推送的业务队列能够高效运行。通过这种方式,企业可以实现针对不同用户群体的精准数据处理和推送,提升业务响应速度和准确性。

🚀 如何用FineDataLink结合Kafka优化数据管道?

我在研究如何用FineDataLink结合Kafka优化数据管道,有没有大神能分享一下经验?感觉这种组合可以大幅提升我们公司的数据处理效率,但具体怎么操作还不是很清楚。

FineDataLink作为一款企业级数据集成平台,与Kafka的结合能够显著提升数据管道的效率和灵活性。以下是一些优化方法:

- 实时与离线任务结合:FineDataLink支持配置实时和离线数据处理任务。通过Kafka的实时消息传递能力,可以在FineDataLink中定义实时数据管道,确保数据的快速传输和处理。

- 故障恢复与读写分离:Kafka的持久化机制和FineDataLink的读写分离能力,帮助企业实现数据处理的高可用性和可靠性。即使在系统故障时,数据也能够通过Kafka日志进行恢复,确保业务连续性。

- 多对一数据同步:FineDataLink利用Kafka的灵活性,实现复杂的多对一数据同步场景。企业可以根据业务需求灵活配置数据源和目标,保证数据的一致性和完整性。

通过这种组合,企业不仅能够优化数据处理流程,还能够提升整体的数据管道效率和稳定性。如果你有兴趣,可以体验一下 FineDataLink体验Demo ,了解更多功能和应用场景。