在大数据时代,数据采集成为企业决策的关键环节。但如何有效地实现数据采集,尤其是使用Python这样灵活的编程语言,往往是技术人员面临的挑战。本文将深入探讨Python在数据采集中的应用,并通过学习大数据系统编程,为您提供实用的解决方案。

Python以其简洁和易用著称,使其成为数据科学家的首选工具。无论是网页数据抓取、API调用还是处理大型数据库,Python都能提供强大的支持。然而,在实施过程中,企业常常面临性能瓶颈、数据格式多样化以及实时性要求等难题。了解如何用Python高效实现数据采集,不仅能帮助企业优化数据处理流程,还能为业务增长提供有力支持。

为了帮助您更好地理解这一主题,我们将通过分步解析方式,详细展示Python在数据采集中的应用场景和技术实现。我们还将探讨FineDataLink(FDL)这款国产低代码ETL工具如何在大数据环境中提供高效、实时的数据集成解决方案。

🧩 一、Python在数据采集中的应用

Python在数据采集领域的应用广泛,涵盖了从网页抓取到数据库连接的多个方面。了解这些应用场景,能帮助企业在数据采集过程中做出更明智的选择。

1. 网页数据抓取

网页数据抓取是数据采集的常见需求。通过Python的强大库,如BeautifulSoup和Scrapy,用户可以轻松从网页中提取数据。这些工具提供了简洁的API接口,帮助用户快速解析HTML文档。

- BeautifulSoup:适合快速开发和简单的网页数据抓取任务。它以其易用性和灵活性受到开发者的青睐。

- Scrapy:这是一个功能强大的爬虫框架,适合大规模数据抓取任务。Scrapy支持异步请求处理,极大地提高了数据抓取的效率。

以下是网页抓取工具的对比:

| 工具名称 | 优势 | 劣势 |

|---|---|---|

| BeautifulSoup | 易于上手,适合简单任务 | 对大规模抓取支持较弱 |

| Scrapy | 支持异步,高效 | 学习曲线稍陡 |

在使用这些工具时,开发者需要注意网页抓取过程中的法律和道德问题,尤其是在处理敏感或隐私数据时。

2. 数据库连接与查询

数据库是数据采集的另一个重要来源。Python提供了多种库,如PyMySQL和Pandas,帮助用户连接和查询数据库。

- PyMySQL:这是一个纯Python实现的MySQL客户端库,支持MySQL数据库的连接和操作。

- Pandas:虽然Pandas主要用于数据分析,但它的

read_sql功能可以直接从数据库中读取数据,并将其转换为DataFrame格式,方便数据处理。

在数据库连接中,性能和安全是两个关键问题。通过优化查询语句和使用连接池技术,开发者可以显著提高数据采集的效率。同时,确保数据库连接的安全性也至关重要。

3. API数据获取

API是现代应用程序之间数据共享的重要方式。Python的Requests库提供了便捷的HTTP请求功能,使得API数据获取变得简单。

- Requests库:它支持GET、POST等多种HTTP请求方法,并提供了简洁的API接口。

- JSON解析:在获取API数据后,通常需要对JSON格式的数据进行解析和处理。这可以通过Python内置的json模块轻松实现。

API数据获取的挑战在于处理频繁的网络请求和大数据量的响应。通过实现请求缓存和响应数据流式处理,可以有效提升API数据获取的性能。

🛠️ 二、学习大数据系统编程

大数据系统编程是实现高效数据采集的基础。掌握这些技术,能帮助企业构建更具竞争力的数据处理平台。

1. 分布式计算框架

大数据处理往往需要分布式计算框架的支持。Apache Hadoop和Apache Spark是目前使用最广泛的两个框架。

- Apache Hadoop:Hadoop以其HDFS分布式文件系统和MapReduce计算模型著称,适合批量数据处理。

- Apache Spark:Spark以其内存计算能力和多语言支持(包括Python)而闻名,适合实时数据处理。

以下是分布式计算框架的对比:

| 框架名称 | 优势 | 劣势 |

|---|---|---|

| Hadoop | 适合批处理,成熟稳定 | 实时处理能力较弱 |

| Spark | 实时处理强,内存计算 | 对资源要求较高 |

在选择框架时,企业应根据自身的数据处理需求和硬件环境进行权衡。

2. 数据存储与管理

大数据系统的核心之一是数据存储与管理。通过优化数据存储结构和管理策略,企业可以显著提高数据处理的效率。

- NoSQL数据库:如MongoDB和Cassandra,适合处理非结构化和半结构化数据。

- 数据仓库:如Amazon Redshift和Google BigQuery,适合大规模数据分析和查询。

数据存储的选择直接影响数据采集和处理的性能。NoSQL数据库通常提供更高的写入和查询速度,但可能在事务一致性方面有所不足。数据仓库则以其强大的分析能力和横向扩展性著称。

3. 数据处理与分析

数据处理与分析是大数据系统的最终目标。通过Python的强大数据分析库,企业可以轻松实现数据的深度挖掘。

- Pandas:用于数据清洗和处理,是数据分析的基础工具。

- NumPy:提供高性能的多维数组对象,是科学计算的基础库。

- SciPy:扩展了NumPy的功能,适用于更多高级科学计算。

这些工具在数据处理和分析过程中发挥着不可或缺的作用。通过结合使用这些库,开发者可以实现从数据采集到分析的完整流程。

🔄 三、实时数据集成与FineDataLink的应用

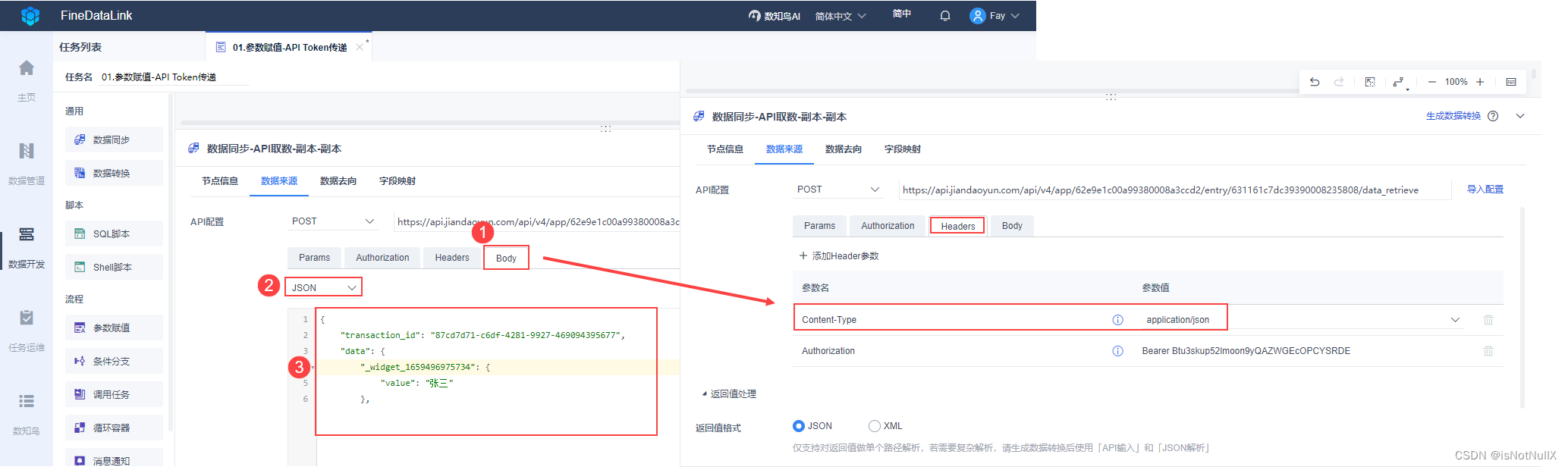

在大数据环境中,实时数据集成是企业获取竞争优势的重要手段。FineDataLink(FDL)作为一款国产低代码ETL工具,为企业提供了高效、实用的实时数据集成解决方案。

1. 高效数据同步

在实现数据集成时,高效的数据同步是关键。FineDataLink通过其先进的同步机制,实现了对数据源的实时全量和增量同步。

- 单表同步:适用于简单的数据同步场景,支持对单个数据表的实时更新。

- 多表同步:支持对多个相关数据表的同步,适合复杂的数据集成任务。

- 整库同步:支持对整个数据库的同步,适合大规模数据迁移和备份。

以下是数据同步方式的对比:

| 同步方式 | 优势 | 劣势 |

|---|---|---|

| 单表同步 | 简单高效,易于实施 | 适用场景有限 |

| 多表同步 | 灵活,支持复杂场景 | 实施复杂度较高 |

| 整库同步 | 全面,适合大规模场景 | 对系统资源要求高 |

FineDataLink通过其直观的界面和强大的功能,帮助企业轻松实现数据同步任务,极大地缩短了实施时间和降低了技术门槛。

2. 数据调度与治理

数据调度与治理是实现高效数据集成的重要环节。在这方面,FineDataLink通过其强大的调度引擎和数据治理工具,帮助企业实现数据的自动化处理和质量管理。

- 调度引擎:支持复杂的数据处理任务的调度和执行,确保数据在正确的时间被处理。

- 数据质量管理:提供数据清洗、格式转换和异常检测等功能,确保数据的准确性和完整性。

在数据调度与治理过程中,企业需要根据自身的数据处理需求和业务目标,制定合理的策略和流程。

3. 实时数据分析

实时数据分析是数据集成的最终目标。通过FineDataLink,企业可以实现数据的实时分析和可视化,为业务决策提供支持。

- 实时数据流处理:支持对数据流的实时分析,帮助企业快速响应市场变化。

- 数据可视化:通过丰富的图表和报表功能,帮助用户直观地了解数据趋势和洞察。

总之,FineDataLink通过其全面的数据集成功能,为企业的数据处理提供了一站式解决方案。它不仅提高了数据处理的效率,还降低了技术实施的复杂度,为企业的数字化转型提供了有力支持。

📝 总结

本文深入探讨了Python在数据采集中的应用,并通过学习大数据系统编程,为企业提供了实用的解决方案。通过FineDataLink这款国产低代码ETL工具,企业可以轻松实现高效的数据集成和实时分析。无论是网页数据抓取、数据库连接还是实时数据集成,Python和FDL都为企业提供了强大的支持,帮助企业在大数据时代取得竞争优势。

参考文献:

- "Python for Data Analysis" by Wes McKinney

- "Learning Spark" by Jules S. Damji et al.

- "Designing Data-Intensive Applications" by Martin Kleppmann

本文相关FAQs

🐍 如何用Python实现网页数据采集?

最近接到老板的任务,需要用Python来实现网页数据采集。虽然我对编程有一定的了解,但Python的爬虫技术还不太熟悉。有大佬能分享一下从入门到进阶的完整思路吗?比如用什么库,怎样处理反爬虫机制?

Python的强大之处在于其丰富的库和工具,尤其在数据采集领域,Python语言凭借其简洁和强大的库,已经成为首选。实现网页数据采集,通常需要用到requests库和BeautifulSoup等工具。requests库可以帮助你发送HTTP请求,获取网页的HTML内容,而BeautifulSoup则能让你解析HTML文档,提取所需的数据。

1. 确定目标和需求

在开始之前,明确需要采集的数据类型和结构很重要。不同网站的结构可能千差万别,针对特定网站进行分析,确定需要采集的页面和数据字段。

2. 使用requests获取网页内容

```python

import requests

url = 'http://example.com'

response = requests.get(url)

if response.status_code == 200:

html_content = response.text

else:

print("Error fetching the webpage")

```requests.get()方法用于向服务器发送请求,如果返回状态码是200,表示成功获取网页内容。

3. 解析HTML文档

使用BeautifulSoup解析HTML内容:

```python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

data = soup.find_all('div', class_='target-class')

```

通过find_all()方法,可以筛选出所有带有特定属性的HTML元素。

4. 处理反爬虫机制

许多网站都有反爬虫机制,如IP封禁、请求频率限制等。可以通过设置请求头、使用代理IP、模拟人类行为(如延迟请求)来绕过这些限制。

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

```

5. 数据存储和处理

采集到的数据可以存储在数据库中,如MySQL、SQLite,或者保存为CSV文件,便于后续的分析和处理。

这种方式适用于初学者快速上手网页数据采集,但在面对复杂网站时,可能需要更深入的技术,如处理JavaScript渲染的内容,可以借助Selenium等工具。

📊 学习大数据系统编程需要掌握哪些基础知识?

在公司推进大数据项目,老板要求我负责技术实现。大数据系统编程感觉好复杂,尤其是涉及到Hadoop、Spark等技术栈。我该从哪些基础知识入手,才能更好地完成这项任务呢?

大数据系统编程涉及多个技术栈,初学者容易被其复杂性吓倒。为了更好地掌握大数据编程,你需要从以下几个基础知识开始:

1. 理解大数据概念

首先,了解大数据的基本概念和特性(Volume、Velocity、Variety、Veracity)。这有助于你理解为什么需要特定的工具和技术来处理大数据。

2. 掌握分布式系统基础

大数据处理通常在分布式系统上进行。理解分布式计算的基本原理,了解节点、集群、分片等概念,这些知识是学习大数据技术的基石。

3. 熟悉Hadoop生态系统

Hadoop是大数据的基础架构,掌握HDFS(Hadoop分布式文件系统)和MapReduce编程模型。了解如何在HDFS上存储和处理数据,以及如何编写MapReduce作业。

4. 学习Spark编程

Spark以速度和易用性著称,是处理大数据的热门选择。学习如何使用Spark进行数据处理、流计算和机器学习。掌握RDD(Resilient Distributed Dataset)和DataFrame操作。

5. SQL和NoSQL数据库

了解传统SQL数据库(如MySQL)和NoSQL数据库(如MongoDB、Cassandra)之间的区别。掌握如何在不同类型的数据库中存储和查询大数据。

6. 掌握数据流处理技术

对于实时数据处理,学习Kafka、Flink等实时流处理工具。了解如何设置数据流管道,实现数据的实时采集和分析。

7. 了解云计算平台

大数据处理通常需要强大的计算资源,了解AWS、Azure、GCP等云平台提供的大数据处理服务,可以帮助你更高效地实施大数据项目。

8. 编程语言

Python、Java和Scala是大数据编程中常用的语言。熟练掌握其中一种编程语言,尤其是Python,因为它简单易学,并且有丰富的库支持大数据处理。

在学习过程中,理论和实践结合非常重要。可以通过在线课程、实验室项目和开源项目等方式,实战演练,逐步提高自己的技能。

🚀 如何实现高效的大数据实时同步?

公司在进行实时大数据同步时,遇到了性能瓶颈,尤其是在数据量大时。传统的批处理方式已经不太适用了,有没有更高效的方法来实现实时数据同步?需要考虑系统稳定性和数据准确性。

在大数据环境中,实现高效的实时数据同步是一个复杂的挑战。传统的批处理方法在数据量增大时往往力不从心。为了解决这个问题,我们可以采用以下策略:

1. 使用数据流处理技术

实时数据同步需要快速响应,可以采用流处理技术。Apache Kafka和Apache Flink是流处理方面的领先技术。Kafka负责数据的高吞吐量传输,而Flink则可以进行复杂的实时数据处理。

2. 增量数据同步

为了避免全量数据同步带来的高负载,可以实现增量数据同步。通过捕获数据库的变更数据,只同步更新的数据,提高同步效率。可以使用Debezium等工具实现这一点。

3. 使用低代码数据集成平台

如FineDataLink(FDL),它提供了低代码的解决方案,支持实时和离线数据采集、集成和管理。FDL可以根据数据源适配情况,配置实时同步任务,确保数据的高效传输和处理。其一站式平台还可以简化复杂的数据处理场景,为企业数字化转型提供支持。可以通过 FineDataLink体验Demo 了解更多。

4. 优化网络和系统架构

实时数据同步需要稳定的网络环境,建议优化网络架构,减少网络延迟。同时,确保系统架构的高可用性,避免单点故障。

5. 数据一致性和容错处理

实时同步过程中,数据的一致性至关重要。实现事务性数据传输和容错处理机制,确保数据的准确性和完整性。

6. 监控与预警系统

构建实时监控系统,及时发现和解决问题。通过预警机制,提前识别潜在的性能瓶颈和故障点。

通过以上策略,可以有效提升大数据实时同步的性能和稳定性。在实际应用中,具体方案的选择需要根据企业的业务需求和技术环境进行调整,以达到最佳效果。