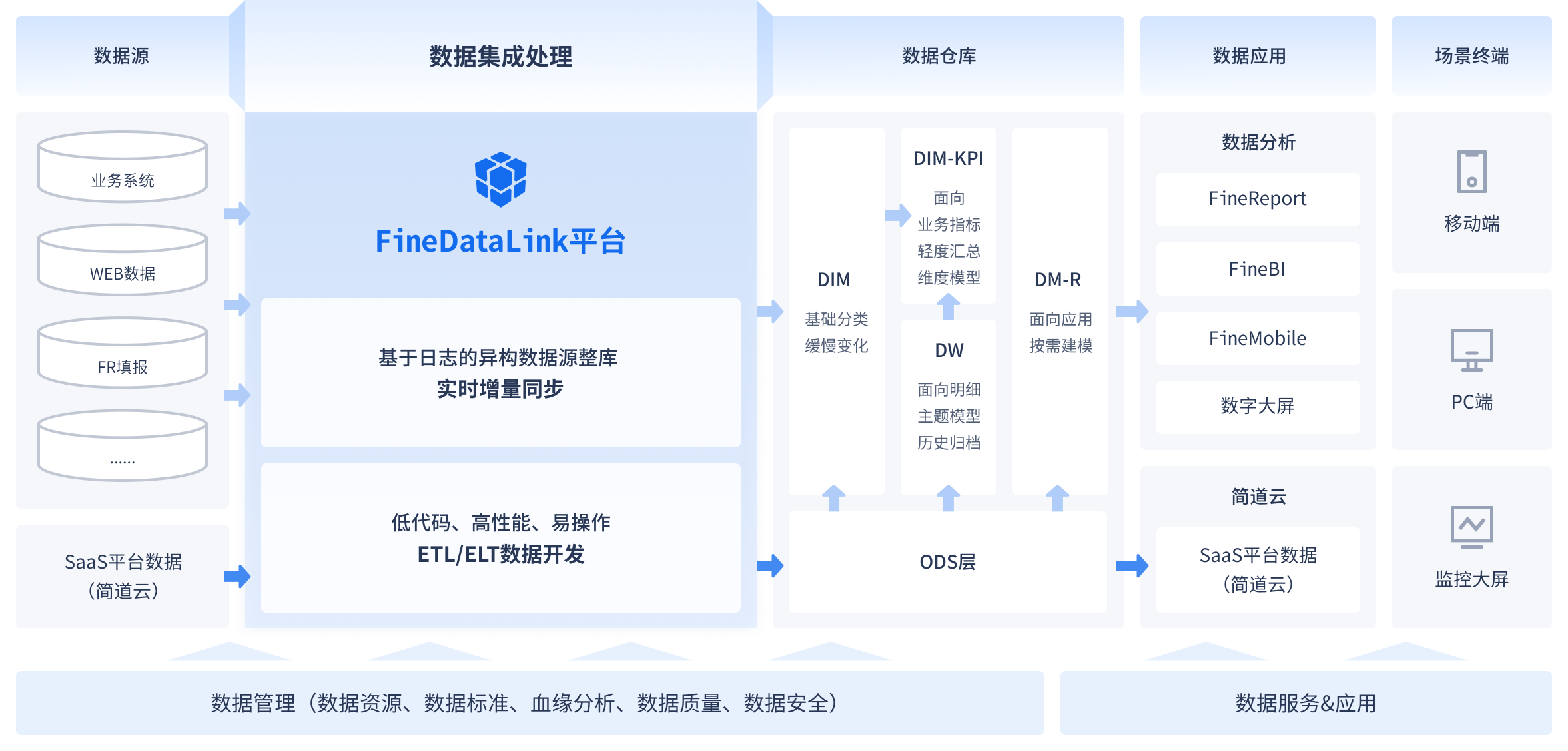

在现代数据驱动的商业环境中,实时数据处理已经成为企业成功的关键因素之一。对于数据中心来说,如何实现实时ETL(Extract, Transform, Load)是一个至关重要的任务,特别是在处理庞大的数据量时,这一任务显得更加艰巨。FineDataLink作为一个低代码、高时效的企业级一站式数据集成平台,为数据中心带来了革命性的改变。通过FDL,用户可以轻松地实现实时数据传输、数据调度和数据治理,支持企业的数字化转型。这不仅提高了数据处理效率,还降低了数据处理的复杂性。然而,具体如何实现这些功能?在这篇文章中,我们将深入探讨其工具应用技巧。

🚀 数据中心实时ETL的基本原理

实时ETL是指在数据生成的同时进行抽取、转换和加载的过程。这种处理方式能够确保数据的时效性,使企业可以立即获得最新的数据分析结果。传统的ETL流程往往是批量处理的,数据通常在特定的时间段内被抽取、转换并加载,这样的方式在数据量大的情况下可能导致延迟和性能问题。为了克服这些挑战,实时ETL技术应运而生。它的基本原理包括数据流处理、事件驱动架构和增量数据更新。

1. 数据流处理

实时ETL依赖于数据流处理技术,这与批量处理有很大的不同。在数据流处理中,数据被视为连续流动的,而不是固定的数据块。数据流处理技术能够实时地处理数据输入,支持实时分析和决策。

- 数据流处理的优势在于高效性和低延迟。

- 它能够处理来自不同来源的数据,包括传感器数据、日志数据和用户行为数据。

- 数据流处理工具通常支持动态扩展,能够根据数据量的变化自动调整资源配置。

2. 事件驱动架构

事件驱动架构是实时ETL的核心,它能够响应实时数据输入并触发相应的处理任务。这种架构允许系统根据事件的发生情况进行实时处理,而不是等待批处理周期。

- 事件驱动架构能够减少数据处理的复杂性。

- 它支持异步处理,能够显著提高系统的响应速度。

- 事件驱动架构通常采用微服务架构,支持灵活的系统扩展。

3. 增量数据更新

在实时ETL中,增量数据更新是一个关键技术。通过只处理变化的数据,增量数据更新技术能够显著提高数据处理效率,同时减少系统负载。

- 增量更新技术支持实时数据同步。

- 它能够降低数据传输的带宽需求。

- 增量更新技术适用于大规模数据集。

| 特性 | 数据流处理 | 事件驱动架构 | 增量数据更新 |

|---|---|---|---|

| 优势 | 高效性、低延迟 | 减少复杂性、异步处理 | 提高效率、减少负载 |

| 应用场景 | 实时分析、决策支持 | 实时响应、灵活扩展 | 大规模数据同步 |

| 技术支持 | 动态扩展 | 微服务架构 | 低带宽需求 |

🔧 如何选择合适的实时ETL工具

选择合适的实时ETL工具是实现高效数据处理的关键。在选择过程中,企业需要考虑多个因素,包括工具的功能、易用性、扩展性和成本。FineDataLink作为一个国产的、高效实用的低代码ETL工具,提供了全面的解决方案。以下是选择实时ETL工具时需要考虑的关键因素。

1. 功能全面性

一个优秀的实时ETL工具应具备全面的功能,包括数据抽取、转换和加载的能力。此外,它还应支持数据的实时监控和管理。

- 工具应支持多种数据源和目标。

- 它应能够处理结构化和非结构化数据。

- 工具应提供丰富的数据转换功能,以适应不同的业务需求。

2. 易用性

工具的易用性是企业实施实时ETL的基础。低代码工具能够显著降低技术门槛,使企业能够快速上手并开始数据处理工作。

- 用户界面应简单直观,支持拖拽式操作。

- 工具应提供详细的文档和教程。

- 易用性能够显著降低实施成本。

3. 扩展性

随着企业的数据需求不断增长,工具的扩展性显得尤为重要。一个扩展性强的工具能够支持企业的长远发展。

- 工具应支持动态资源分配,能够根据数据量调整性能。

- 它应支持与其他系统的集成,能够实现数据的无缝传输。

- 扩展性能够提高工具的长期使用价值。

4. 成本效益

企业在选择工具时需要考虑成本效益比。一个具备高性价比的工具能够帮助企业在预算内实现数据处理目标。

- 工具应提供灵活的定价方案。

- 它应支持免费试用,以便企业进行全面评估。

- 成本效益是企业实现实时ETL的基础。

| 关键因素 | 功能全面性 | 易用性 | 扩展性 | 成本效益 |

|---|---|---|---|---|

| 重要性 | 高 | 高 | 高 | 中 |

| 影响 | 数据处理能力 | 实施效率 | 长期价值 | 财务决策 |

| 推荐工具 | FineDataLink | FineDataLink | FineDataLink | FineDataLink |

推荐使用FineDataLink来替代传统ETL工具,它是一款国产的、高效实用的低代码ETL工具,提供强大的实时数据同步能力: FineDataLink体验Demo 。

📈 数据中心优化ETL流程的技巧

优化ETL流程能够显著提高数据中心的效率和性能。在实时ETL环境中,优化流程不仅能够降低系统负载,还能够提高数据处理的准确性。以下是一些优化ETL流程的实用技巧。

过程.webp)

1. 数据预处理

数据预处理是优化ETL流程的第一步。通过在数据进入系统之前进行预处理,企业能够显著减少后续数据处理的复杂性。

- 数据预处理包括数据清洗、格式转换和去重。

- 预处理能够提高数据质量,减少错误率。

- 通过预处理,企业能够减少数据存储和传输的负载。

2. 并行处理

并行处理技术能够显著提高ETL的效率。在实时ETL环境中,并行处理允许系统同时处理多个数据流,减少处理时间。

- 并行处理支持多线程和多节点操作。

- 它能够提高系统的吞吐量。

- 并行处理能够有效利用系统资源,降低成本。

3. 负载均衡

负载均衡是优化ETL流程的重要技术。通过动态调整系统负载,企业能够确保数据处理的稳定性和效率。

- 负载均衡技术能够防止系统过载。

- 它支持自动化资源分配。

- 负载均衡能够提高系统的可用性。

4. 数据缓存

数据缓存技术能够显著提高数据处理的效率。在实时ETL环境中,数据缓存允许系统临时存储频繁访问的数据,减少数据库访问次数。

- 数据缓存技术能够提高数据访问速度。

- 它支持快速数据检索。

- 数据缓存能够降低数据库负载。

| 优化技巧 | 数据预处理 | 并行处理 | 负载均衡 | 数据缓存 |

|---|---|---|---|---|

| 优势 | 提高数据质量 | 提高系统吞吐量 | 提高系统稳定性 | 提高访问速度 |

| 技术支持 | 数据清洗、格式转换 | 多线程、多节点 | 自动化资源分配 | 快速数据检索 |

| 应用场景 | 数据质量管理 | 大规模数据处理 | 系统稳定性保障 | 数据访问优化 |

📚 总结与展望

在数字化转型的浪潮中,实时ETL成为数据中心不可或缺的一部分。通过FineDataLink等工具,企业能够轻松实现实时数据处理,提高数据分析的时效性和准确性。本文探讨了实时ETL的基本原理、工具选择及优化技巧,为企业提供了全面的解决方案。未来,随着技术的不断进步,实时ETL将继续推动数据中心的创新发展。

权威来源:

- 《实时数据处理技术与应用》,作者:李明,出版社:电子工业出版社。

- 《数据流处理与事件驱动架构》,作者:张伟,出版社:清华大学出版社。

- 《大数据时代的ETL优化》,作者:王强,出版社:人民邮电出版社。

本文相关FAQs

🤔 如何理解实时ETL的重要性?

老板要求我们提升数据的利用效率,特别是在业务高峰期能够实时监控和分析数据。我知道ETL是数据处理的核心流程,但实时ETL究竟有什么特别之处?实现实时ETL对企业有什么具体好处吗?

实时ETL的重要性在于它能够将数据从源头快速传输到目标存储中,同时保持数据的更新和一致性。这对于现代企业来说尤为关键,因为业务决策需要基于最新的数据。如果仅依靠传统的批处理ETL,可能会导致数据延迟,无法满足实时分析的需求。在金融、电子商务等对数据时效性要求极高的领域,实时ETL是不可或缺的。例如,一家电商平台可能需要在购物节期间实时监控库存和销售数据,以便及时调整促销策略。

实时ETL的主要优势包括:

- 数据时效性:实时更新的数据可以支持即时决策。

- 业务连续性:减少因数据不同步带来的业务中断。

- 用户体验提升:消费者能够获得更加个性化和及时的服务。

在实际应用中,实施实时ETL需要克服许多技术挑战,如数据量大、数据结构复杂等。因此,选择合适的工具和平台至关重要。FineDataLink(FDL)就是这样一款专为实时ETL设计的工具,能够简化复杂的数据流程,提升数据集成效率。通过FDL,企业可以实现对多种数据源的实时同步,确保数据流畅传输,支持业务的快速响应。

🔄 如何在数据中心实现高效的实时ETL流程?

有没有大佬能分享一下,在数据中心进行实时ETL时,如何设计高效的流程呢?我试过用传统的ETL工具,但总感觉在大数据场景下性能不够理想,怎么办?

在数据中心实施高效的实时ETL流程,首先需要了解数据流动的全过程,找到瓶颈所在。传统ETL工具通常采用批处理方式,这在大数据量场景下会出现性能问题,无法满足实时需求。解决这个问题的关键在于使用流处理架构和现代化的数据集成工具。

流处理架构:在实时ETL中,流处理架构是必不可少的。与批处理不同,流处理允许数据实时流动和处理,减少了数据延迟。像Apache Kafka这样的流处理框架可以帮助实现高效的数据流转。

现代化ETL工具:选择支持流处理的现代化ETL工具也很重要。FineDataLink(FDL)就是一个很好的选择。FDL能够支持单表、多表、整库等多种数据同步模式,灵活适应不同的数据源和目标需求。它的低代码特性降低了开发和维护成本,使得非技术人员也能快速上手。

以下是一个高效实时ETL流程的基本步骤:

- 数据采集:使用FDL实时采集数据,支持多种数据源。

- 数据传输:通过流处理框架(如Kafka)实时传输数据。

- 数据转换:在FDL中配置数据转换规则,确保数据在传输过程中得到清洗和格式化。

- 数据加载:将转换后的数据加载到目标存储中,支持数据的实时查询和分析。

| 步骤 | 工具 | 说明 |

|---|---|---|

| 采集 | FDL | 支持多源数据实时采集 |

| 传输 | Kafka | 实时传输,减少延迟 |

| 转换 | FDL | 配置转换规则,清洗数据 |

| 加载 | 数据仓库 | 支持实时查询和分析 |

通过这样的流程设计,你可以显著提升数据处理的效率,实现真正意义上的实时ETL。

🚀 实时ETL在不同工具下的表现如何?选择哪个更合适?

我看到市场上有很多实时ETL工具,比如Kafka、Spark Streaming以及FineDataLink。各个工具在实际应用中的表现怎么样?选哪个更合适呢?

在选择实时ETL工具时,了解各个工具的特性和适用场景是非常重要的。不同的工具在性能、易用性和功能上各有千秋。以下是对主流实时ETL工具的分析和对比:

1. Apache Kafka

- 优势:Kafka是一个高吞吐量的分布式消息系统,擅长处理实时数据流。它的优势在于可以处理大规模的数据流,适合需要高可用性和数据一致性的场景。

- 劣势:Kafka需要较高的技术门槛来配置和管理,特别是对于复杂的流处理任务,可能需要结合其他工具,如Kafka Streams或Flink。

2. Spark Streaming

- 优势:Spark Streaming可以处理实时和批处理任务,适合需要同时处理历史数据和实时数据的场景。

- 劣势:需要熟练掌握Spark的API,对于小型团队可能不太友好。

3. FineDataLink(FDL)

- 优势:FDL是一款低代码、高时效的数据集成平台,专为企业级实时ETL设计。它支持多种数据源的实时同步,简化了数据处理流程。对于不具备强大技术团队的中小企业,FDL的低代码特性使其非常易于使用。

- 劣势:虽然FDL在易用性上有优势,但在某些特定的自定义需求上可能需要额外开发。

| 工具 | 适用场景 | 优势 | 劣势 |

|---|---|---|---|

| Kafka | 高吞吐量实时数据流处理 | 高可用性,数据一致性 | 技术门槛高,需要结合其他工具 |

| Spark Streaming | 实时和批处理任务结合 | 同时处理历史和实时数据 | 需要掌握复杂API |

| FineDataLink | 企业级数据集成,低代码需求 | 易用性高,支持多源实时同步 | 特定自定义需求可能需额外开发 |

结合企业实际需求和团队技术水平,选择合适的工具才能事半功倍。如果你希望降低技术门槛,同时快速实现实时数据同步,建议体验一下 FineDataLink体验Demo 。通过实际操作,你可以更直观地感受到FDL在实时ETL中的强大能力。