在当今数据驱动的商业环境中,企业面临着如何高效处理和管理其庞大的数据集的问题。数据量的增长使得传统的数据同步和处理方法显得尤为吃力,而这显然已经成为影响企业数字化转型的关键痛点。一个显著的事实是,超过70%的企业因数据处理不当而面临效率低下的问题,这不仅影响了决策速度,还阻碍了市场竞争力。在这样的背景下,ETL(Extract, Transform, Load)脚本的高效编写显得尤为重要。本文将深入探讨如何编写高效的ETL脚本,并提供实用的编程技巧和示例,帮助企业优化其数据处理能力。

🚀 一、理解ETL流程与需求

在开始编写ETL脚本之前,理解ETL流程的需求是至关重要的。ETL流程通常包括数据提取、转换和加载三个步骤,每一步都需要精心设计,以确保最终的数据质量和处理效率。

1、数据提取的关键要素

数据提取是ETL流程的第一步,它涉及从各种数据源中获取数据。这一步的效率直接影响后续步骤的表现,因此在数据提取时,应考虑以下几个关键要素:

- 数据来源的多样性:企业通常会从多个数据源提取信息,包括关系型数据库、CSV文件、API接口等。确保脚本能够适应不同的数据源格式是提高提取效率的基础。

- 数据量的大小:对于海量数据,应采用分页提取或增量提取的方法,以减少一次性数据提取对系统的压力。

- 网络带宽和延迟:在分布式环境中,网络条件会影响数据提取的速度。采用数据压缩和批量传输技术有助于提高提取效率。

| 数据源类型 | 提取方法 | 优势 | 劣势 |

|---|---|---|---|

| 关系型数据库 | SQL查询 | 灵活性高 | 可能影响数据库性能 |

| API接口 | RESTful请求 | 实时性强 | 网络依赖性高 |

| CSV文件 | 文件读取 | 简单易用 | 不适合大规模数据 |

2、数据转换的技巧

数据转换是ETL流程中的核心步骤,它涉及对提取的数据进行清洗、格式化和整合。这一步骤的复杂性决定了脚本的编写技巧。

- 数据清洗:过滤掉不必要的数据,处理缺失值和异常值,以确保数据质量。

- 数据格式化:将数据转换为目标系统所需的格式,考虑数据类型转换、编码转换等。

- 数据整合:根据业务需求合并不同数据源的数据,确保数据的可用性和一致性。

3、数据加载的优化策略

数据加载是ETL流程的最后一步,它涉及将转换后的数据写入目标数据库或数据仓库。

- 批量加载:采用批量加载方法可以显著提高数据加载速度,减少数据库连接次数。

- 事务管理:在数据加载过程中,确保数据的完整性和一致性,使用事务管理机制。

- 日志记录和监控:记录加载过程中的重要信息,及时监控和处理异常情况。

在理解了ETL流程的需求后,企业可以根据自身数据特点和业务需求,灵活调整ETL脚本的编写策略,确保数据处理的高效和稳定。

🧑💻 二、编写高效ETL脚本的技巧

编写高效的ETL脚本需要考虑多方面的因素,包括编程语言选择、代码结构设计和性能优化等。以下将详细介绍这些方面的技巧。

1、选择合适的编程语言

不同编程语言在处理ETL任务时各有优劣势,选择合适的编程语言是编写高效ETL脚本的第一步。

- Python:凭借其丰富的库和社区支持,Python是处理数据的热门选择。Pandas、NumPy等库为数据处理提供了强大支持。

- Java:适合大规模数据处理,具有良好的性能和稳定性。Apache Hadoop和Spark都基于Java开发。

- SQL:对于数据提取和部分转换任务,SQL是不可或缺的工具,其简洁和高效使其成为数据库操作的首选。

| 编程语言 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|

| Python | 灵活性高,库丰富 | 性能较低 | 数据分析与统计 |

| Java | 性能好,稳定性高 | 开发复杂度高 | 大规模数据处理 |

| SQL | 简洁高效 | 不适合复杂逻辑 | 数据库操作 |

2、设计高效的代码结构

良好的代码结构能够提高ETL脚本的可维护性和执行效率。以下是设计高效代码结构的几个原则:

- 模块化设计:将ETL流程的各个步骤(提取、转换、加载)分解成独立的模块,使得代码更易于理解和维护。

- 避免重复计算:在数据处理中,尽量避免重复的计算和数据复制,使用缓存技术提高效率。

- 使用高效算法:选择合适的算法进行数据处理,避免使用复杂度高的算法,从根本上提高性能。

3、性能优化策略

性能优化是编写高效ETL脚本的关键环节,通过以下策略可以显著提高脚本的执行效率:

- 并行处理:利用多线程或多进程技术,充分利用计算资源,提高数据处理速度。

- 内存管理:在处理大规模数据时,合理管理内存使用,避免内存泄漏和溢出。

- I/O优化:减少磁盘和网络I/O操作的次数,使用批量操作和数据压缩技术。

通过以上技巧,开发者可以编写出高效的ETL脚本,满足企业在数据处理中的各种需求。

📚 三、实用编程示例

为了更好地理解上述技巧,我们将提供一些实用的编程示例,帮助开发者将理论应用于实践。

1、Python示例:数据提取与转换

以下是一个使用Python进行数据提取和转换的简单示例:

```python

import pandas as pd

import requests

数据提取

response = requests.get('https://api.example.com/data')

data = response.json()

数据转换

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

df['value'] = df['value'].astype(float)

数据清洗

df = df.dropna()

df = df[df['value'] > 0]

print(df.head())

```

在这个示例中,我们使用requests库从API接口提取数据,然后使用pandas库将数据转换为DataFrame格式,并进行日期和数值类型转换。通过这种方式,我们可以快速提取和转换数据,为后续分析做好准备。

2、Java示例:数据加载与优化

以下是一个使用Java进行数据加载和优化的示例:

```java

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.util.List;

public class DataLoader {

private static final String URL = "jdbc:mysql://localhost:3306/mydb";

private static final String USER = "user";

private static final String PASSWORD = "password";

public static void batchInsert(List dataList) {

try (Connection conn = DriverManager.getConnection(URL, USER, PASSWORD)) {

conn.setAutoCommit(false);

String sql = "INSERT INTO my_table (id, name, value) VALUES (?, ?, ?)";

try (PreparedStatement pstmt = conn.prepareStatement(sql)) {

for (Data data : dataList) {

pstmt.setInt(1, data.getId());

pstmt.setString(2, data.getName());

pstmt.setDouble(3, data.getValue());

pstmt.addBatch();

}

pstmt.executeBatch();

conn.commit();

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

```

在这个示例中,我们使用Java的JDBC接口进行数据加载,并采用批量插入的方法以提高效率。通过设置自动提交为false,我们可以在一个事务中执行多个插入操作,减少数据库连接的开销。

这些编程示例不仅展示了如何应用编程技巧,还强调了代码的可读性和可维护性,为开发者在实际项目中使用提供了参考。

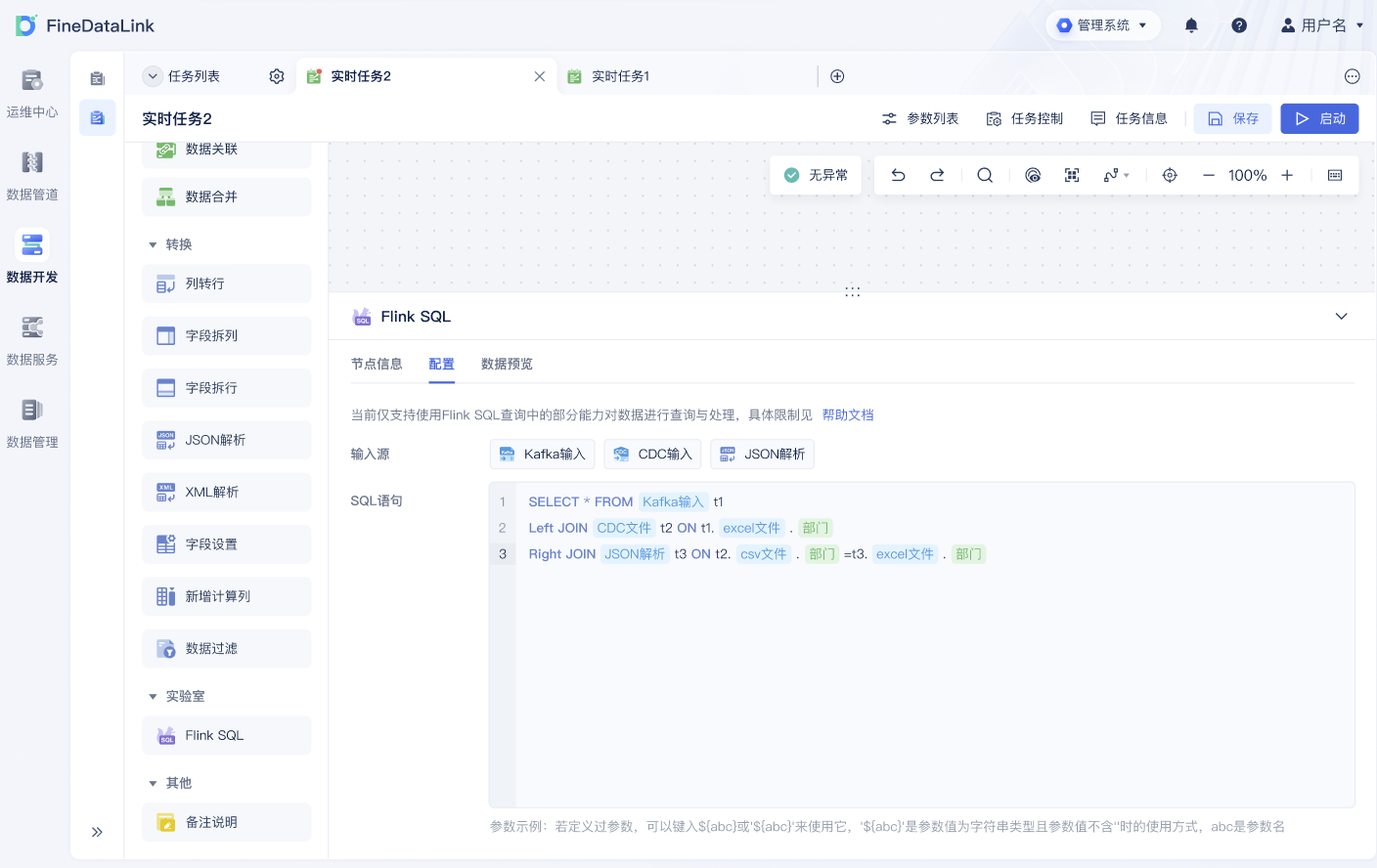

🔗 四、推荐工具:FineDataLink

在选择ETL工具时,FineDataLink(FDL)是一个值得推荐的选择。作为一款低代码、高时效的企业级数据集成平台,FDL由帆软背书,国产且高效实用。它支持对数据源进行实时全量和增量同步,并提供简便的配置界面,使企业能够快速实现数据传输和调度。 FineDataLink体验Demo

✨ 结论与总结

通过本文,我们深入探讨了如何编写高效的ETL脚本,并提供了实用的编程技巧和示例。理解ETL流程的需求、选择合适的编程语言、设计高效的代码结构、应用性能优化策略是编写成功ETL脚本的关键。借助这些方法,企业能够显著提高数据处理效率,支持业务的数字化转型。此外,FineDataLink作为一个优秀的ETL工具,提供了便捷的解决方案,值得企业在实际应用中选择。阅读相关书籍如《数据驱动营销》与《大数据时代》,可以进一步加深对数据处理的理解。

参考文献:

- 《数据驱动营销》,李晓东著,电子工业出版社,2015年。

- 《大数据时代》,维克托•迈尔-舍恩伯格著,浙江人民出版社,2018年。

本文相关FAQs

💻 为什么我的ETL脚本总是执行得那么慢?

唉,真是让人头疼。我一开始也是,老板要求数据处理要高效,但每次跑脚本都卡得半死。有没有大佬能分享一下?我用了几种优化方法,效果都不明显。是不是我写的代码有啥问题?还是配置没对呢?求解惑!

ETL脚本的执行效率常常受到数据量、代码结构以及硬件资源的影响。很多人遇到这种问题,首先得从代码结构入手。比如,处理大量数据时,数据库的I/O操作可能会成为瓶颈。要解决这个问题,建议从以下几点入手:

- 优化SQL查询:使用索引和联合查询可以减少数据库的访问时间。确保你的查询只提取必要的数据,避免过多的冗余字段。

- 批量处理:当处理大量数据时,使用批量操作可以显著提高性能。比方说,批量插入和更新操作可以减少数据库连接的开销。

- 多线程处理:利用多线程可以更好地利用系统资源,尤其是在CPU密集型任务中。Python的

concurrent.futures库可以帮助你简单地实现多线程。

- 缓存机制:合理使用缓存可以减少重复的计算开销。可以考虑使用内存缓存(如Redis)来存储中间结果。

- 数据并行化:随着数据量的增加,数据并行化处理可以有效提高效率。考虑使用分布式处理框架,如Apache Spark。

- 调整资源配置:确保你的ETL设备在硬件和网络上足够支持数据处理需求。适当增加内存和CPU资源可以显著改善脚本性能。

这些方法在不同的场景下可能会有不同的效果。关键是要根据自己的实际情况进行调整。再有,别忘了定期监控和分析ETL的执行情况,以便及时发现新的瓶颈。

🛠 如何处理ETL脚本中的错误?

说实话,有时候真想砸电脑!每次跑ETL脚本都死在某个奇怪的错误上。找半天都不知道怎么解决。有没有大神能分享一些处理错误的套路?让我们少踩坑,少浪费时间。

ETL过程中的错误是个常见的烦恼。要处理这些错误,得有个系统的方法。下面是一些常用技巧:

- 日志记录:在脚本中加入详细的日志记录,可以帮助你快速定位错误。Python的

logging模块是个不错的选择。 - 错误处理机制:使用try-except语句来捕获和处理异常。确保你能捕获到常见的异常类型,并为每种异常类型制定合适的处理方案。

- 事务处理:对于数据库操作,使用事务可以确保数据的一致性。事务可以帮助你在出错时回滚到安全状态。

- 数据验证:在ETL之前,进行数据验证可以避免因数据错误引起的异常。可以使用数据校验库,如Pandas中的

validate功能。 - 自动重试机制:对于临时性的错误(如网络中断),可以设置自动重试机制。Python的

tenacity库提供了方便的重试装饰器。 - 定期测试:对脚本进行定期测试,尤其是在数据结构或库版本更新时。这可以帮助你提前发现潜在的问题。

通过这些方法,可以有效减少ETL过程中的错误发生率。记住,错误处理不是一劳永逸的,得根据实际情况不断调整和优化。

🚀 如何提升ETL脚本的实时性能?

得了吧,老板总说数据需要实时更新。可是每次脚本跑起来都要好久,真心累啊!有没有啥好方法能提升ETL的实时性能?真希望能少点加班,多点自由。

提升ETL脚本的实时性能是许多企业的需求。尤其是在数据量巨大的情况下,传统的批量处理已经无法满足实时需求。下面是一些行之有效的方法:

- 流处理框架:使用流处理框架可以支持实时数据处理。Apache Kafka和Apache Flink是目前主流的选择,能够处理高吞吐量的数据。

- 增量数据处理:避免全量数据加载,使用增量数据处理策略。通过时间戳或标识字段提取新增数据,可以显著减少处理时间。

- 数据分片:将数据分片处理可以有效利用多节点资源。通过数据分片,可以实现数据的并行处理,提高整体效率。

- 使用FineDataLink:在复杂的实时数据同步场景下,考虑使用企业级数据集成平台,如 FineDataLink体验Demo 。FDL支持单表、多表、整库等多对一实时全量和增量同步,非常适合大数据场景。

- 内存计算:利用内存计算可以减少I/O操作的延迟。使用内存数据库或内存计算框架,如Apache Ignite,可以提高处理速度。

- 动态资源调度:根据任务负载,动态调整资源配置。使用云服务的自动扩展功能可以实现资源的灵活调度。

这些方法可以帮助你从不同角度提升ETL脚本的实时性能。关键是结合自己的业务需求和现有技术架构进行合理选择。希望这些建议对你有所帮助,提升效率,让你工作轻松一点。