在当今数据驱动的世界里,企业对实时数据处理的需求日益增长。随着数据体量的不断扩大,如何高效地进行数据提取、转换和加载(ETL)成为了现代企业面临的一大挑战。特别是在使用Java进行ETL实现时,开发者需要面临框架选择、性能优化、以及实时性保障等多重难题。在本文中,我们将深入探讨如何使用Java实现ETL过程,并提供一些编程技巧和框架选择的实用指南。

🚀 一、Java中的ETL实现概述

在ETL过程中,Java作为一种成熟的编程语言,以其跨平台特性和强大的生态系统,成为许多数据工程师的首选。实现ETL不仅仅是一个技术挑战,更是一个涉及多重考量的过程,包括性能、可扩展性和维护性等。

1. ETL的基本步骤

ETL的基本步骤通常包括:

- 数据提取(Extract): 从各种数据源提取数据。

- 数据转换(Transform): 清洗、格式化、聚合等数据处理操作。

- 数据加载(Load): 将处理后的数据加载到目标系统中。

在Java中实现这些步骤需要对多种数据源的支持,以及对数据处理过程中性能的优化。为了更好地理解这些步骤,我们可以通过以下表格总结Java在ETL实现中的主要步骤:

| 步骤 | 描述 | 相关技术 |

|---|---|---|

| 数据提取 | 从数据库、API等获取原始数据 | JDBC、JPA、RESTful API |

| 数据转换 | 格式转换、数据清洗、聚合等操作 | Java Stream、Lambda、MapReduce |

| 数据加载 | 将数据写入数据库或数据仓库 | JDBC、JDBC Batch、Spring Data |

2. Java在ETL中的优势

- 跨平台支持: Java的"编写一次,到处运行"特性,使得其在不同的操作系统上都可以无缝运行。

- 丰富的库和框架: Java生态系统提供了大量的库和框架,支持各种数据源和格式的处理。

- 性能优化: 通过JVM的优化和Java的多线程特性,可以实现高性能的数据处理。

这些优势使得Java在ETL的实现过程中具有很高的灵活性和可扩展性。

🌐 二、框架选择:Java ETL工具大比拼

在Java中实现ETL,选择合适的框架是至关重要的。不同的框架在功能、性能、易用性等方面各有千秋。以下是一些常用的Java ETL框架及其特点。

1. Apache Camel

Apache Camel是一个基于规则的路由和处理引擎,广泛用于集成不同类型的数据源和目标。其主要特点包括:

- 多协议支持: 支持HTTP、FTP、JMS等多种协议。

- 企业集成模式: 提供丰富的企业集成模式,简化复杂的数据流处理。

- 灵活的DSL: 提供多种DSL(如Java、XML)来定义路由。

2. Spring Batch

Spring Batch是一个轻量级的批处理框架,专注于大规模数据处理。其特点包括:

- 任务管理: 提供任务分片、并行处理等功能,提升处理效率。

- 事务管理: 支持事务一致性,确保数据处理的可靠性。

- 易于集成: 与Spring生态系统无缝集成,易于使用。

3. Talend Open Studio

Talend Open Studio是一款开源的ETL工具,提供了图形化的开发环境。其特点包括:

- 拖拽式开发: 提供直观的图形化界面,降低开发门槛。

- 丰富的组件库: 提供丰富的预置组件,支持多种数据源和目标。

- 开源免费: 开源社区支持,降低使用成本。

以下是这些框架的对比表:

| 框架 | 主要特点 | 适用场景 |

|---|---|---|

| Apache Camel | 多协议支持,企业集成模式 | 数据集成和路由 |

| Spring Batch | 任务管理,事务支持 | 大规模批处理 |

| Talend Open Studio | 拖拽式开发,丰富组件库 | 快速开发和原型设计 |

选择合适的框架不仅仅是技术考虑,更需要结合企业的实际需求和开发团队的技术背景。

🛠 三、Java ETL编程技巧

在使用Java进行ETL开发时,掌握一些编程技巧可以大大提升开发效率和程序的性能。

1. 使用Java Stream API

Java Stream API提供了一种高效的数据处理方式,特别适用于数据转换阶段。通过Stream API,我们可以实现数据的并行处理,提高程序的执行效率。

- 链式操作: 使用链式操作可以简化代码结构,使代码更加清晰。

- 并行流: 使用parallelStream()方法可以实现数据的并行处理,充分利用多核CPU。

2. 异步处理与线程池

在数据提取和加载阶段,异步处理可以有效地提升程序的响应速度。通过Java的CompletableFuture和ExecutorService,我们可以实现异步数据处理。

- CompletableFuture: 提供异步执行和结果组合的能力。

- ExecutorService: 通过线程池管理线程资源,避免线程创建的开销。

3. 使用批量操作

在数据加载阶段,使用批量操作可以显著提升写入性能。JDBC的batch操作允许我们将多条SQL语句合并成一个批次执行,减少数据库交互次数。

- JDBC Batch: 使用addBatch()和executeBatch()方法进行批量操作。

- 事务管理: 在批量操作中使用事务,确保数据的完整性。

通过合理运用这些技巧,我们可以在Java中实现高效、可靠的ETL流程。

🔍 四、FineDataLink:现代ETL的最佳选择

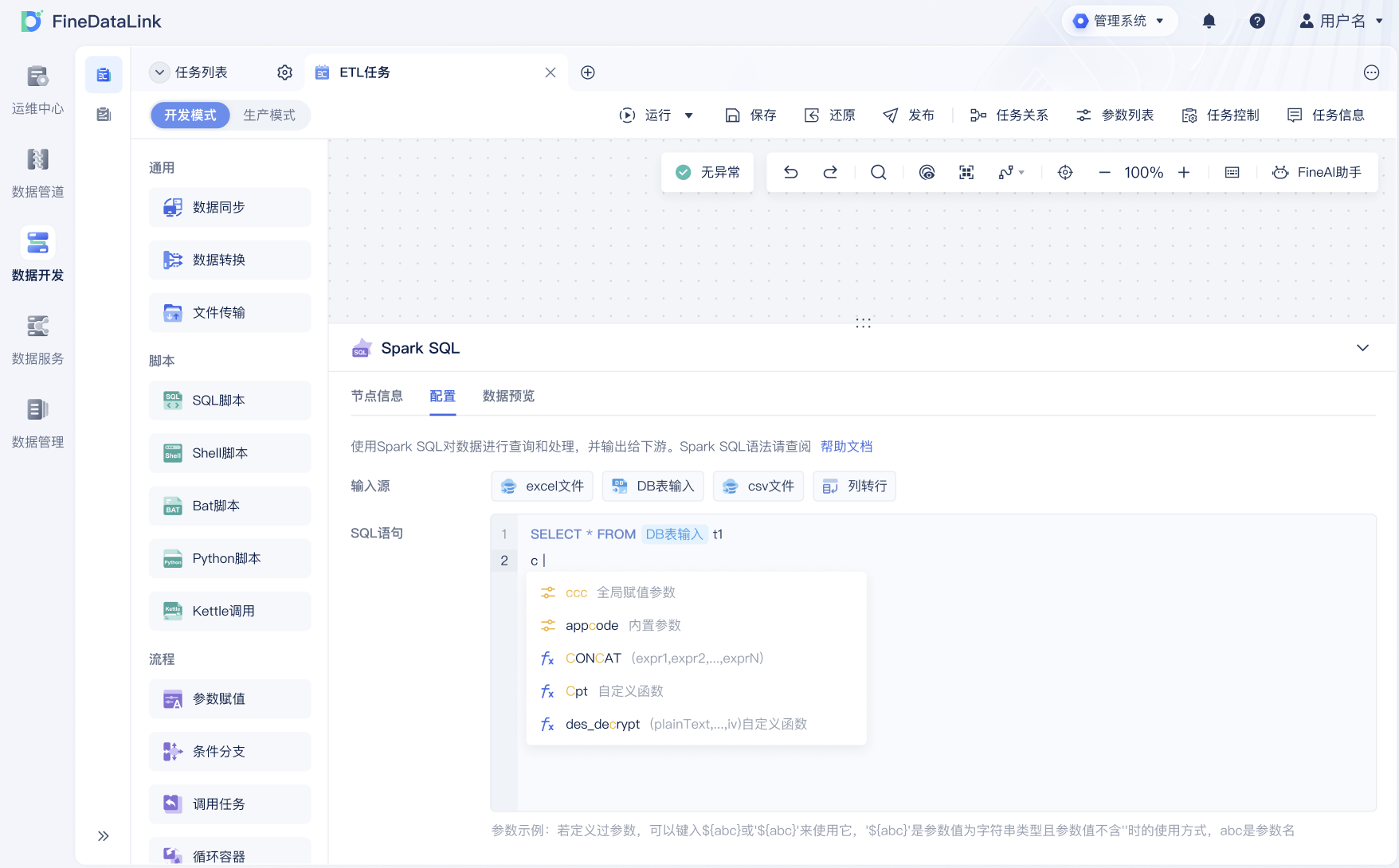

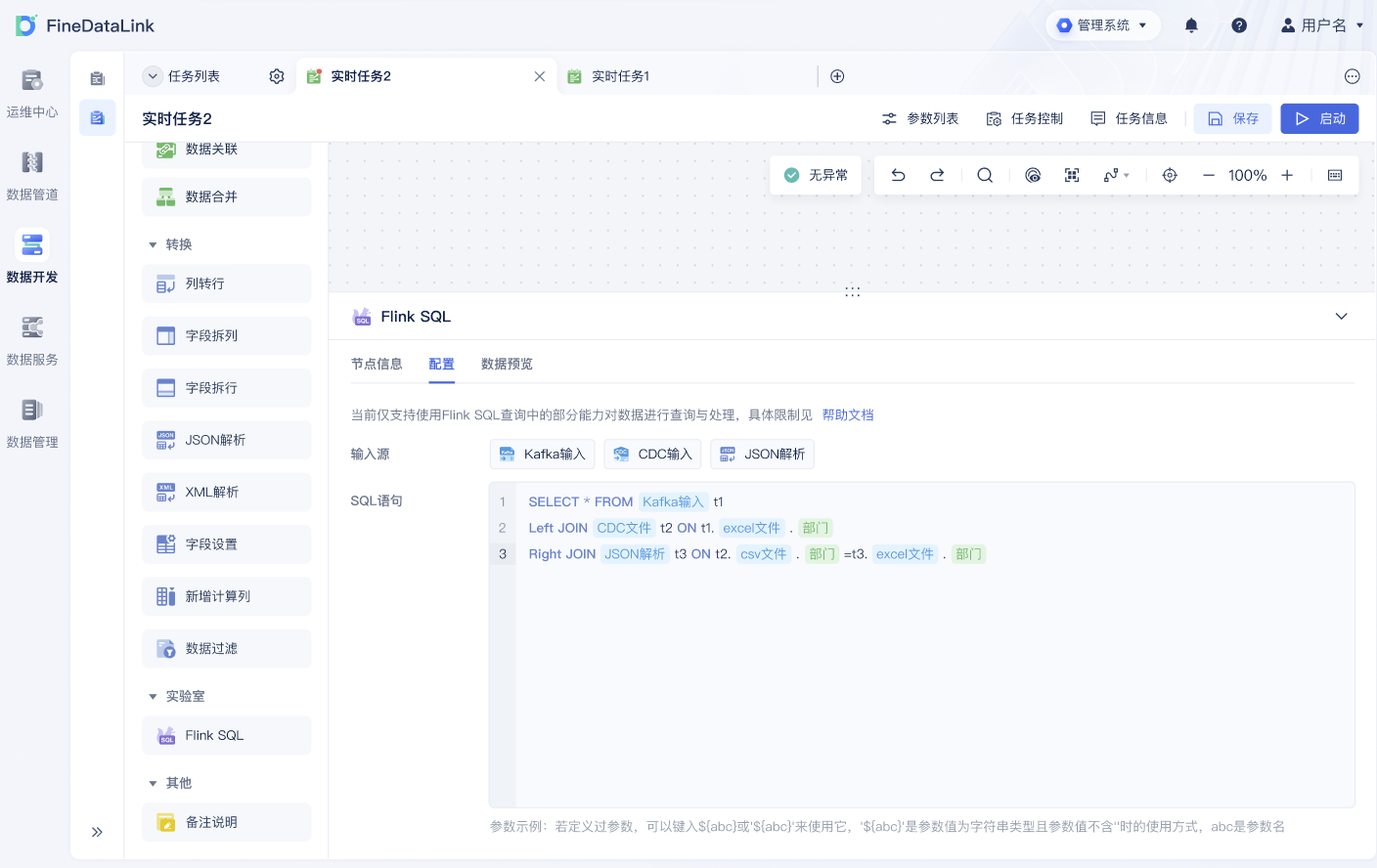

在讨论Java的ETL实现时,我们不得不提到FineDataLink(FDL)。作为一款低代码、高效能的企业级数据集成平台,FDL提供了无与伦比的便捷性和性能。

1. 低代码开发

FDL的低代码特性使得非技术人员也可以轻松上手,大大缩短了开发周期。同时,FDL提供了丰富的预置功能,用户可以通过简单的配置实现复杂的ETL流程。

- 图形化界面: 提供直观的可视化操作界面,简化开发过程。

- 预置模板: 提供多种预置模板,支持快速启动项目。

2. 高性能实时同步

FDL支持对数据源进行实时全量和增量同步,适用于大数据场景下的实时数据处理需求。其高效的同步机制保证了数据的一致性和及时性。

- 实时数据传输: 提供高效的实时数据传输能力,满足实时性要求。

- 增量同步: 支持增量数据同步,减少不必要的数据传输。

3. 灵活的扩展性

FDL具备极高的扩展性,用户可以根据企业的实际需求调整和扩展功能。同时,FDL的国产背景和帆软的技术背书,使其在技术和服务上更加贴近国内市场。

- 国产支持: 提供本地化支持和服务,解决国内用户的特殊需求。

- 扩展能力: 支持自定义功能扩展,满足个性化需求。

对于企业的数字化转型,FineDataLink无疑是一个值得考虑的ETL解决方案。想要体验FDL的强大功能,可以访问 FineDataLink体验Demo 进行试用。

📚 结论

Java在ETL实现中具有无与伦比的优势,通过选择合适的框架和掌握必要的编程技巧,我们可以实现高效的ETL流程。在众多ETL解决方案中,FineDataLink以其低代码、高性能、灵活扩展等特点,成为现代企业数据集成的理想选择。无论是希望简化开发过程,还是提升实时数据处理能力,FDL都能为企业提供强有力的支持。

参考书籍:

- 《Java并发编程实战》,作者:Brian Goetz

- 《数据密集型应用系统设计》,作者:Martin Kleppmann

本文相关FAQs

🚀初学者如何用Java实现ETL流程?

很多人对ETL一开始可能有点懵,特别是用Java来实现。没错,ETL听起来像是个大工程,某些老板可能就要求你“用Java搞定它”。如果你对ETL和Java都不太熟悉,可能会觉得无从下手。有没有大佬能分享一下从零开始的经验?

实现ETL流程,特别是在Java环境中,看起来可能有点恐怖,但其实可以分解成几个简单步骤。首先要了解ETL是什么。ETL代表提取(Extract)、转换(Transform)、加载(Load),是数据处理的核心流程。用Java实现ETL,你需要掌握几个关键组件和技巧。

1. 数据提取 在Java中,数据提取通常通过JDBC连接来实现。你需要熟悉如何配置数据库连接,并执行SQL查询来获取数据。常见的数据库如MySQL、PostgreSQL,都有丰富的JDBC支持。

```java

Connection conn = DriverManager.getConnection(url, username, password);

Statement stmt = conn.createStatement();

ResultSet rs = stmt.executeQuery("SELECT * FROM table_name");

```

2. 数据转换 转换是ETL中最关键的部分。在Java中,可以使用Apache Commons库中的工具进行数据类型的转换和格式化。或者,你可以编写自定义的转换逻辑来处理复杂的业务需求。

3. 数据加载 加载阶段将处理后的数据写入目标数据库或数据仓库。通常也通过JDBC实现。这部分和数据提取类似,关键是要确保数据的完整性和准确性。

工具和框架选择 Apache Camel和Spring Batch都是不错的选择。Camel提供了丰富的集成组件,适合复杂的ETL流程,而Spring Batch则擅长批处理任务。

实践案例 一个简单的ETL任务可能是将CSV文件中的数据转换并导入到数据库。首先用Java读取CSV,使用OpenCSV库进行解析,然后通过JDBC将数据写入数据库。

学习资源

通过这些步骤,你可以逐步掌握Java实现ETL的技巧。当然,熟悉API和库的用法需要时间,不过慢慢来,实践出真知。

🔧如何解决Java ETL中的性能瓶颈?

说实话,很多人用Java做ETL的时候,都会遇到性能瓶颈。尤其是数据量大的时候,卡得让人想砸电脑。有没有什么神技能优化这个过程?老板总是希望我们能提高效率,怎么办?

性能瓶颈是Java ETL开发中常见的问题,尤其是在面对大量数据时。解决这个问题需要从多个角度来分析和优化。

1. 并行处理 Java天然支持多线程。通过多线程或并行流来处理数据,可以显著提高ETL操作的速度。Java 8引入的Stream API提供了简洁的并行处理方式。

```java

List

data.parallelStream().forEach(this::transformAndLoad);

```

2. 批量操作 批量处理通常比逐行处理要快得多。使用JDBC的批量操作功能,可以减少数据库连接开销,并提高数据插入的效率。

```java

PreparedStatement pstmt = conn.prepareStatement("INSERT INTO table_name VALUES (?, ?)");

for (Data d : data) {

pstmt.setString(1, d.getField1());

pstmt.setString(2, d.getField2());

pstmt.addBatch();

}

pstmt.executeBatch();

```

3. 缓存机制 缓存是提升性能的有效手段。使用Redis或Ehcache这样的工具,可以减少数据库的读写压力。Java有丰富的缓存库可供选择。

4. 优化SQL 复杂的SQL查询可能是性能瓶颈的原因之一。优化SQL语句,使用索引,避免全表扫描,可以显著改善ETL的效率。

5. 使用集成平台 如果以上方法还不够,可以考虑使用企业级集成平台,例如 FineDataLink (FDL)。FDL提供高效的数据同步和调度功能,可以简化ETL流程,提升整体性能。

实践案例 在实际项目中,我们曾通过调整JVM参数、优化SQL、使用批处理和并行流,将ETL任务的执行时间缩短了一半。结合缓存机制,进一步减少了数据库压力。

学习资源

通过这些优化策略,你可以有效地提升Java ETL的性能,避免卡顿和瓶颈。

🔍如何选择合适的Java ETL框架?

选择框架就像选手机一样,品牌多功能多,可能让人眼花缭乱。有没有什么经验能分享一下?特别是在企业项目中,哪个框架更有优势?

选择合适的Java ETL框架是成功实施ETL流程的关键一步。不同的框架有各自的特点和适合的场景。

1. Apache Camel Camel是一个强大的集成框架,支持多种协议和数据格式。它适合复杂的ETL流程,特别是在需要与各种系统集成时。Camel的路由和转换功能非常灵活。

2. Spring Batch Spring Batch擅长处理大规模数据的批处理任务。它提供了一套完整的基础设施,能够轻松处理事务、并发和错误处理。对于标准化的ETL任务,Spring Batch是一个好选择。

3. Talend Talend是一个开源的ETL工具,支持图形化设计和丰富的组件库。对于不熟悉编程的用户,Talend提供了友好的界面和拖拽操作,非常适合快速原型开发。

4. FineDataLink (FDL) 对于企业级的高性能实时数据同步,FDL提供了一个低代码解决方案。它支持多种数据源的实时全量和增量同步,适合大数据场景下的ETL需求。 FineDataLink体验Demo 提供了完整的功能演示。

| 框架 | 优势 | 适用场景 |

|---|---|---|

| Apache Camel | 强大的集成能力 | 复杂系统集成 |

| Spring Batch | 批处理优化 | 大规模数据处理 |

| Talend | 图形化设计 | 快速原型开发 |

| FineDataLink (FDL) | 实时同步 | 企业级项目 |

实践案例 在一个企业项目中,我们曾使用Spring Batch来处理每日数百万条记录的数据仓库更新任务。通过Spring Batch的分区和并行处理功能,任务执行效率得到了显著提升。

学习资源

选择框架时,应考虑项目的具体需求、团队的技术背景和框架的支持社区。通过以上信息,你可以找到最适合的Java ETL框架。