在现代企业中,数据已经成为推动业务决策和创新的关键资产。然而,处理和管理这些数据的复杂性常常让企业望而却步。特别是当涉及到大型数据集的实时同步和集成时,传统方法可能会出现性能瓶颈、数据丢失和系统停机等问题。此时,采用高效的ETL(Extract, Transform, Load)脚本及其开发技巧显得尤为重要。本文将深入探讨如何编写高效的ETL脚本,并通过实用的Java技巧提升开发效率。

🚀 一、ETL脚本的核心概念与挑战

ETL是数据处理中的重要环节,主要涉及数据的提取、转换和加载。了解ETL的核心概念有助于更好地编写和优化ETL脚本。

1、ETL流程的基本步骤

ETL流程通常涉及以下三个主要步骤:

- 提取(Extract):从各种数据源中获取数据,比如关系数据库、NoSQL数据库、API接口等。

- 转换(Transform):将提取的数据进行清洗、规范化、聚合等处理,以满足业务需要。

- 加载(Load):将转换后的数据存储到目标数据仓库或数据库中。

以下是一个简单的ETL流程表格:

| 步骤 | 描述 | 常用工具 |

|---|---|---|

| 提取 | 从源数据系统中提取原始数据 | Apache Sqoop, Kettle |

| 转换 | 数据清洗和格式化 | Apache Spark, Talend |

| 加载 | 将数据加载到目标系统 | Amazon Redshift, Hadoop |

这些步骤看似简单,但在实际操作中常常面临以下挑战:

- 数据源多样性:不同的数据源格式各异,导致提取难度增加。

- 数据质量问题:源数据可能存在质量问题,如重复、缺失或不一致的数据。

- 实时处理要求:一些业务场景需要对数据进行实时处理和分析,这对ETL系统的性能提出了更高要求。

2、ETL脚本优化的必要性

在传统ETL流程中,许多企业使用批处理方式处理数据。这种方法在处理大规模数据时效率低下,且无法满足实时数据处理的需求。因此,编写高效的ETL脚本,优化数据处理流程就显得尤为重要。

为了解决上述问题,企业可以考虑以下几种策略:

- 使用高效的数据提取工具:减少数据提取的时间和资源消耗。

- 提高数据转换的并行度:利用多线程或分布式计算框架提高转换效率。

- 优化数据加载策略:选择合适的加载策略,避免对目标系统造成性能瓶颈。

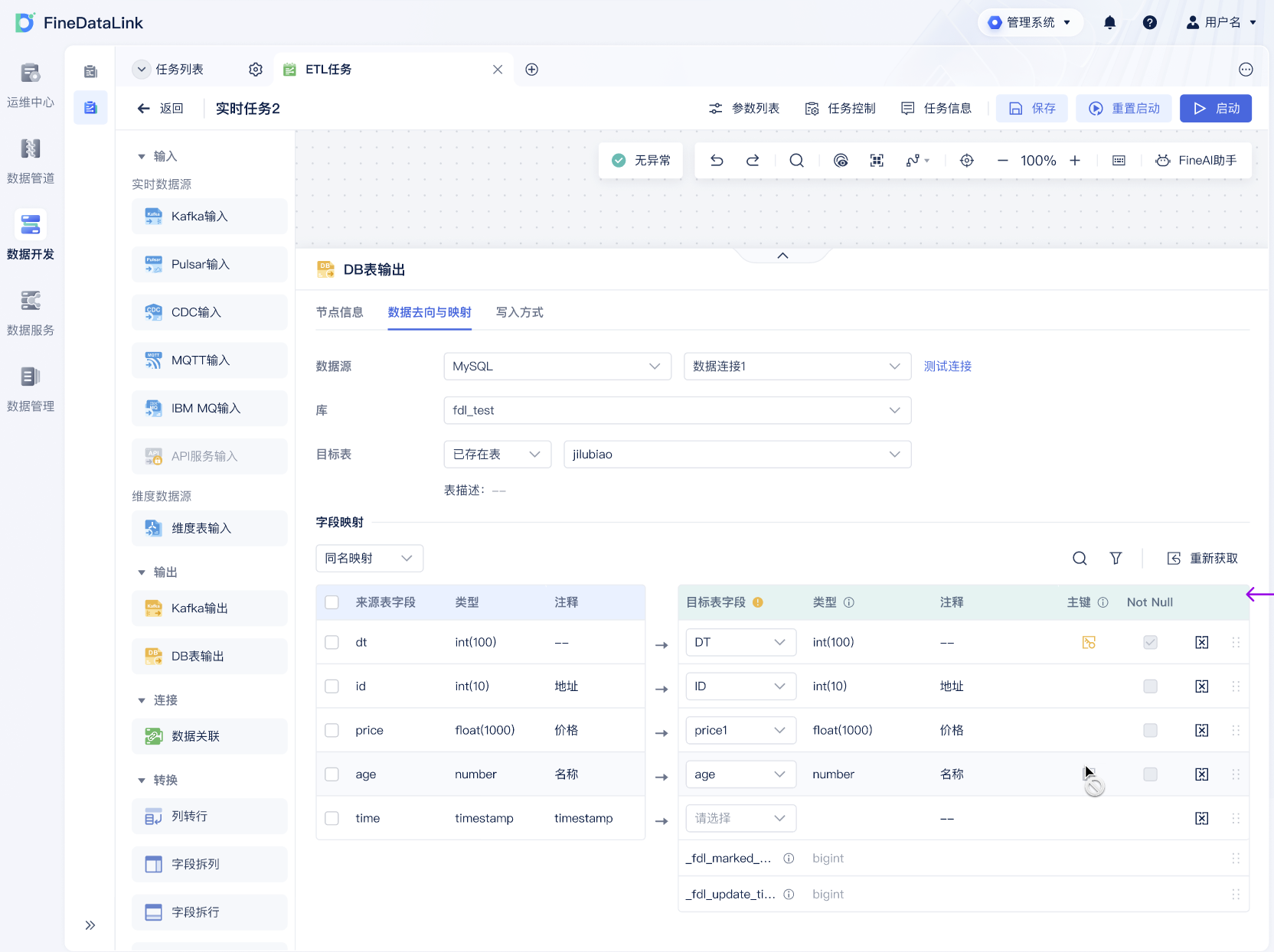

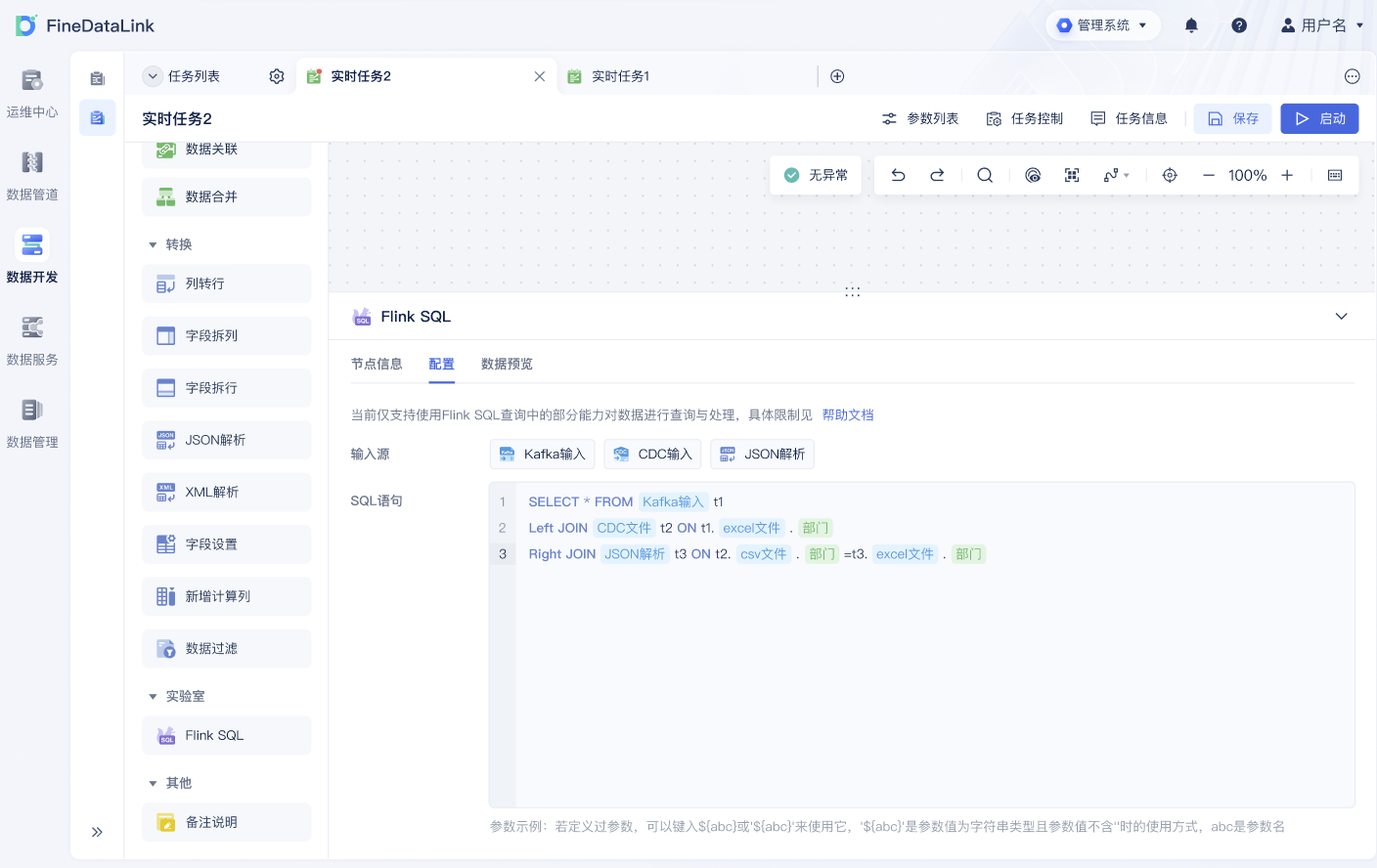

在优化ETL脚本时,选择一个合适的工具尤为重要。FineDataLink(FDL)作为一款低代码、高效实用的ETL工具,提供了丰富的功能,能够帮助企业快速实现数据集成、管理和同步。它不仅能够支持多种数据源的实时同步,还具备强大的数据治理和调度能力,非常适合现代企业的数据处理需求。 FineDataLink体验Demo 。

💡 二、Java在ETL脚本中的应用

Java语言凭借其可移植性、高效性和丰富的开源库,成为编写ETL脚本的理想选择。通过掌握Java中的一些实用技巧,开发者可以更有效地编写和优化ETL脚本。

1、Java在数据提取中的应用

在ETL流程的提取阶段,Java可以通过多种方式与各种数据源进行交互:

- JDBC连接:Java Database Connectivity(JDBC)是Java标准的数据库访问API,支持与大多数关系型数据库的连接。

- RESTful API调用:通过Java的HTTP库,可以轻松与支持REST API的数据源进行交互。

- 文件读取:Java的IO库支持读取多种格式的文件,如CSV、JSON、XML等。

以下是一个使用Java JDBC连接MySQL数据库提取数据的示例代码:

```java

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.Statement;

public class ETLExtraction {

public static void main(String[] args) {

String jdbcUrl = "jdbc:mysql://localhost:3306/mydatabase";

String username = "user";

String password = "password";

try (Connection connection = DriverManager.getConnection(jdbcUrl, username, password);

Statement statement = connection.createStatement()) {

String query = "SELECT * FROM source_table";

ResultSet resultSet = statement.executeQuery(query);

while (resultSet.next()) {

// 处理数据

System.out.println(resultSet.getString("column_name"));

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

```

2、Java在数据转换与加载中的技巧

Java在数据转换阶段可以利用其强大的面向对象编程特性和多线程编程模型,实现复杂的数据转换逻辑和并行处理:

- 使用Java Stream API:Java 8引入的Stream API提供了高效的数据流操作方法,可以用于数据过滤、映射和聚合。

- 多线程并行转换:通过使用Java的

ExecutorService,可以实现数据转换的并行化处理,提高处理效率。 - 数据加载优化:在数据加载阶段,可以通过批量插入和事务管理来提高性能。

以下是一个使用Java Stream API进行数据转换的示例代码:

```java

import java.util.Arrays;

import java.util.List;

import java.util.stream.Collectors;

public class ETLTransformation {

public static void main(String[] args) {

List

List

.filter(s -> s.startsWith("data"))

.map(String::toUpperCase)

.collect(Collectors.toList());

transformedData.forEach(System.out::println);

}

}

```

通过合理运用Java的这些功能,可以大幅提升ETL脚本的执行效率和可维护性。

📊 三、ETL脚本中的性能优化策略

在编写ETL脚本时,性能优化是不可忽视的一个环节。合理的性能优化策略能够显著提升数据处理速度,降低资源消耗。

1、优化数据提取策略

在数据提取阶段,选择合适的提取策略能有效减少处理时间和资源消耗:

- 增量提取:对实时性要求高的数据,可以采用增量提取策略,只提取变化的数据。

- 并行提取:对于大规模数据,可以通过多线程或分布式系统实现并行提取。

- 数据压缩:在传输数据之前进行压缩,减少网络带宽消耗。

以下是一个优化数据提取的示例表格:

| 策略 | 描述 | 优点 |

|---|---|---|

| 增量提取 | 只提取变化的数据,减少数据量 | 减少数据传输量 |

| 并行提取 | 利用多线程或分布式系统提取数据 | 提高提取速度 |

| 数据压缩 | 在传输前压缩数据,减少带宽消耗 | 降低网络负载 |

2、转换和加载的性能优化

在数据转换和加载阶段,同样可以通过多种策略进行性能优化:

- 批量处理:将数据批量进行转换和加载,减少数据库的交互次数。

- 使用缓存:在转换过程中使用缓存,减少重复计算。

- 优化SQL语句:在加载阶段,优化SQL语句,避免不必要的复杂查询。

以下是一个批量处理的Java示例代码:

```java

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.util.List;

public class ETLLoading {

public void batchInsert(List

String jdbcUrl = "jdbc:mysql://localhost:3306/mydatabase";

String username = "user";

String password = "password";

String insertSQL = "INSERT INTO target_table (column_name) VALUES (?)";

try (Connection connection = DriverManager.getConnection(jdbcUrl, username, password);

PreparedStatement preparedStatement = connection.prepareStatement(insertSQL)) {

for (String item : data) {

preparedStatement.setString(1, item);

preparedStatement.addBatch();

}

preparedStatement.executeBatch();

} catch (Exception e) {

e.printStackTrace();

}

}

}

```

通过合理优化ETL脚本,可以有效提高数据处理的效率和稳定性。

🔍 四、ETL脚本开发中的常见问题及解决方法

在ETL脚本开发过程中,开发者常常会遇到各种问题。了解这些问题的成因及其解决方法,能够帮助开发者更好地编写和维护ETL脚本。

1、数据质量问题

数据质量问题是ETL流程中最常见的问题之一,常见的数据质量问题包括数据重复、缺失和不一致。处理数据质量问题可以采取以下措施:

- 数据校验:在数据提取阶段进行数据校验,确保数据的完整性和一致性。

- 数据清洗:在数据转换阶段进行数据清洗,去除重复和错误的数据。

- 数据标准化:统一数据格式,确保数据的一致性。

2、性能瓶颈

性能瓶颈是影响ETL脚本效率的主要因素,常见的性能瓶颈包括网络带宽、磁盘IO和CPU使用率。解决性能瓶颈可以通过以下策略:

- 网络优化:使用数据压缩和增量提取策略,减少网络带宽消耗。

- 并行处理:利用多线程和分布式系统进行并行处理,减少处理时间。

- 硬件升级:通过升级硬件资源,如增加内存和CPU,提高处理能力。

3、错误处理和日志记录

在ETL流程中,错误处理和日志记录是至关重要的。通过有效的错误处理和日志记录,可以快速定位和解决问题。常见的错误处理和日志记录策略包括:

- 异常处理:在Java代码中使用try-catch块捕获异常,并记录错误信息。

- 日志记录:使用日志记录框架,如Log4j或SLF4J,记录ETL流程中的重要信息。

- 报警机制:在出现严重错误时,触发报警机制,及时通知相关人员。

📚 结论

ETL脚本的编写和优化是数据处理中的关键环节。通过掌握ETL流程的核心概念,合理选择和运用Java中的实用技巧,并针对常见问题采取有效的解决方法,开发者可以编写出高效、稳定的ETL脚本,支持企业的数据驱动决策和业务创新。

FineDataLink作为一款国产的低代码ETL工具,凭借其高效性和易用性,能够帮助企业快速实现数据集成和管理,是现代企业数字化转型的不二选择。为了更深入地了解如何利用Java来优化ETL脚本,建议阅读《Java性能优化权威指南》(作者:Ben Evans, Chris Newland)和《大数据技术原理与应用》(作者:王轩)。这些书籍提供了丰富的实践经验和理论知识,能够帮助开发者更好地理解和应用Java技术。

本文相关FAQs

🚀 如何用Java快速入门ETL脚本编写?

最近老板让我用Java编写ETL脚本,说实话,我有点懵。虽然Java写过不少,但用它做ETL还真是头一遭。有没有大佬能分享一些入门经验?比如要注意哪些关键点?毕竟,我不想在项目上掉链子。

编写ETL脚本是个复杂的过程,尤其对Java开发者来说,因为Java虽强大,但在ETL领域算不上“快捷”。先别慌,咱一步步来。从基础开始,Java有很多库可以帮助你实现ETL功能,比如Apache Camel、Spring Batch,还有Kettle(也叫Pentaho Data Integration)。这些工具能简化很多工作。

1. 理解ETL流程:ETL(Extract, Transform, Load)顾名思义,就是数据抽取、转换和加载。你要搞清楚数据从哪里来、怎么变、往哪里去。一般来说,抽取数据可以用JDBC连接数据库,转换部分可能涉及一系列数据清洗和格式转换,最后加载到目标数据库。

2. 选择合适的工具或库:如果你的项目不算特别复杂,可以考虑用Spring Batch。它提供了一个简单的编程模型,支持大规模数据处理,尤其适合批处理任务。Apache Camel则更适合需要集成多个数据源的项目。

3. 数据源连接与数据格式转换:Java连接数据库通常用JDBC,这是基础。要注意的是,处理数据转换时,Java虽然强大,但有时候可能显得笨重。比如对复杂的数据格式转换,通常会用到Java Streams API、Java 8的新特性来简化代码。

4. 错误处理与日志记录:ETL过程中,错误难免。Java提供了丰富的异常处理机制,你可以用try-catch-finally来保证程序的鲁棒性。此外,日志记录是ETL不可或缺的一部分,Log4j或SLF4J是常见的选择。

5. 性能优化:如果数据量很大,性能就是个大问题。Java的多线程和并行流(Parallel Streams)可以用来提升性能。但要注意,过度使用多线程可能导致资源竞争问题。

6. 持续学习和优化:ETL不是一劳永逸的,需求变了,脚本也得变。保持学习的心态,多看社区和开源项目的实现,吸取经验和教训。

总之,Java是个很好的选择,但它要求你有扎实的编程基础和耐心。希望这些建议能帮到你!

🛠️ Java编写ETL时,数据同步的最佳实践是什么?

在用Java写ETL脚本时,数据同步老是让我头疼。特别是面对实时数据更新时,真心求教,如何高效处理?有没有一些实用的最佳实践可以分享?不想搞砸这个项目。

说到数据同步,确实是ETL中的一个大坑。Java虽然能处理很多事情,但面对实时数据更新时,可能显得不那么得心应手。不过,别怕,咱们有办法应对。

1. 使用合适的工具:如果你已经尝试了自己写同步逻辑,但觉得力不从心,可以考虑使用一些专业的工具,比如 FineDataLink体验Demo 。这种工具专为大数据环境设计,支持实时数据同步和增量更新,减轻了开发者的负担。

2. 增量同步 vs 全量同步:在处理数据同步时,增量同步是关键。全量同步会导致资源浪费,尤其是数据量大的时候。增量同步可以通过数据库的变更日志(Change Data Capture)实现,Java可以使用Debezium这样的库来获取数据库的变更事件。

3. 并发处理与批量操作:为了提高数据同步效率,可以利用Java的多线程和批量操作。比如说,使用ExecutorService来管理线程池,可以避免手动创建和销毁线程的开销。对于批量操作,JDBC提供了批处理功能,可以减少数据库的交互次数。

4. 数据一致性问题:在处理数据同步时,数据一致性是个大问题。事务处理是Java中的重要特性,确保数据的一致性和完整性。你可以通过使用Spring的事务管理器来简化事务处理过程。

5. 监控和报警:数据同步过程中,难免会出现各种问题。搭建一个监控和报警系统,可以帮助你及时发现和解决问题。Java中有很多监控框架,比如Micrometer和Prometheus,可以帮助你实现这一目标。

6. 性能调优:Java中有很多性能调优的技巧,比如JVM参数的调整、垃圾回收机制的优化等。这些都需要结合具体的业务场景进行调整。

数据同步是个系统工程,需要不断学习和实践。希望这些最佳实践能帮你在项目中游刃有余!

🤔 如何解决ETL过程中Java性能瓶颈?

用Java写ETL脚本时,感觉性能总是差强人意。特别是数据量大的时候,速度慢到让人抓狂。有没有什么办法可以突破这个瓶颈?实在不想被老板喷了。

Java在处理大数据量时,性能瓶颈确实让人头疼。不过,掌握一些技巧和策略,可以有效地提升性能。

1. 内存管理:Java的垃圾回收机制虽然强大,但有时会影响性能。通过调整JVM参数(如-Xms, -Xmx, -XX:+UseG1GC),可以优化内存使用和垃圾回收行为。

2. 数据分片与并行处理:如果你的数据量巨大,考虑将数据分片。Java 8的并行流可以帮助你将任务分片并行处理。使用Fork/Join框架也是个好方法,它能有效地利用多核CPU的优势。

3. 使用高效的数据结构与算法:Java提供了很多数据结构,选择合适的数据结构可以提高效率。比如,使用HashMap而不是ArrayList来进行频繁的查找操作。

4. JDBC性能优化:在数据库操作中,使用批处理(Batch Processing)可以减少交互次数,提高性能。此外,使用PreparedStatement而不是Statement,可以提高查询速度和安全性。

5. 缓存策略:如果数据的实时性要求不高,可以通过缓存策略提高性能。Java中有很多缓存框架,比如Ehcache和Caffeine,能帮助你减少数据读取的时间。

6. 专业工具的辅助:当自己实现的方案难以提升性能时,不妨使用专业工具。比如,FineDataLink提供了高效的数据集成和实时同步能力,可以大大减轻Java开发者的负担。

7. 持续监控与调优:性能优化是个持续的过程,定期进行性能监控和调优,能帮助你发现潜在的问题。Java有很多监控和分析工具,如VisualVM、JProfiler等,可以帮助你了解程序的运行情况。

性能瓶颈并不可怕,关键在于找到合适的方法来突破它。希望这些建议能帮到你,不再被性能问题困扰!