数据质量是企业成功的基石,但在大数据时代,如何确保数据质量成为了一个复杂的问题。企业在进行ETL(Extract, Transform, Load)设计时,往往面临着数据量大、数据结构复杂等挑战。错误的设计可能导致数据丢失、数据不一致、数据重复等问题,影响决策的准确性和及时性。那么,如何在ETL设计中优化流程和架构以提高数据质量呢?

🛠️ ETL设计对数据质量的影响

1. 数据抽取过程中的挑战

在ETL设计中,数据抽取是首要环节。它直接影响后续数据转化和加载的质量。抽取过程通常面临以下挑战:

- 数据源的多样性和复杂性:企业的数据源可能包括数据库、文件系统、API等。这些数据源的结构和格式各异,导致抽取过程复杂。

- 数据量大:大数据环境下,数据的规模巨大,传统的批量处理方式难以高效处理。

- 实时性需求:商业决策需要实时数据支持,抽取过程的延迟可能导致数据过时。

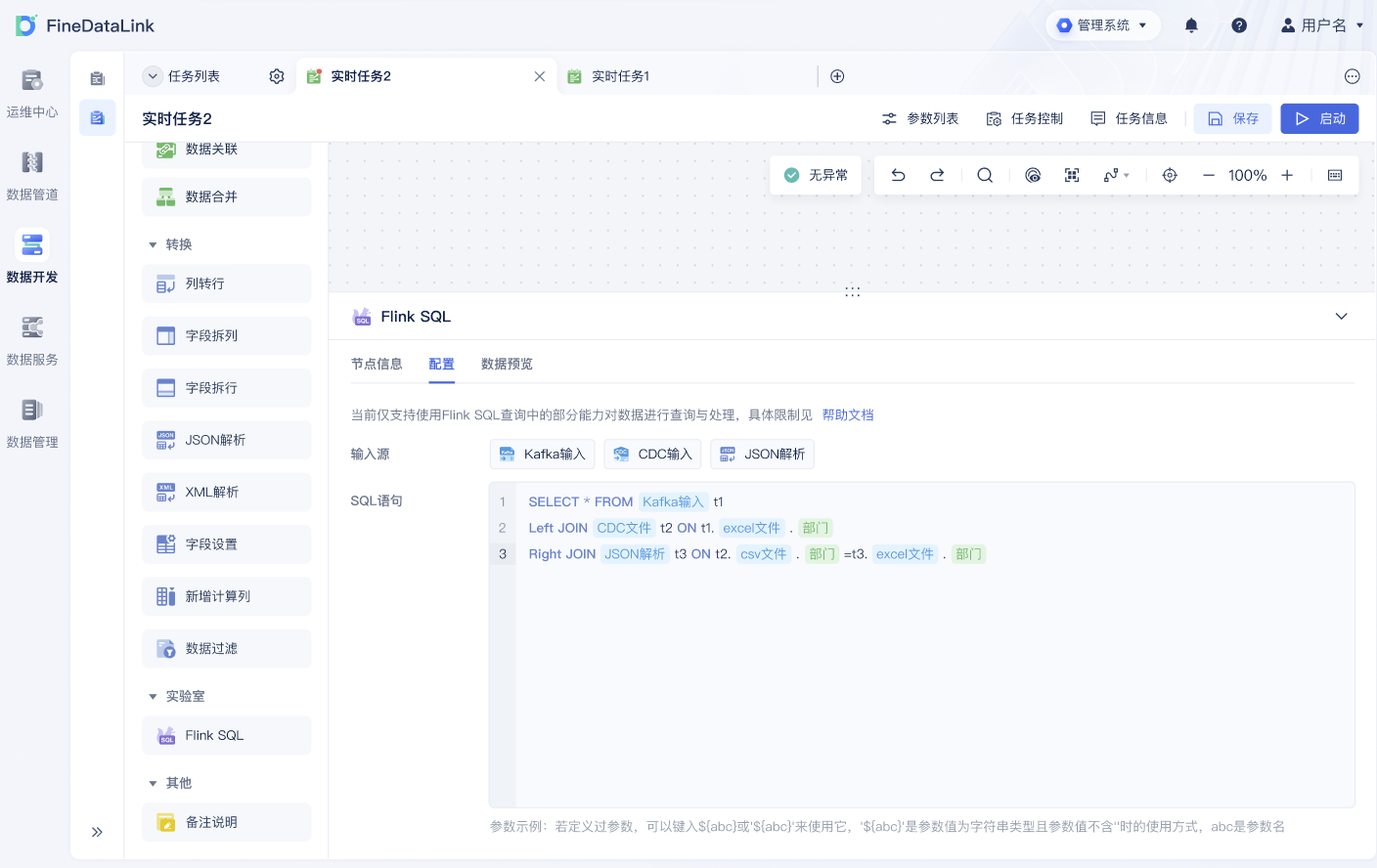

为了应对这些挑战,企业需要选择合适的工具和技术。例如,FineDataLink提供了一站式解决方案,通过低代码平台实现对多种数据源的实时同步和管理,减少抽取过程中的复杂性和延迟。 FineDataLink体验Demo

2. 数据转换中的问题

数据转换是ETL过程中最复杂的环节。主要问题包括:

- 数据清洗:原始数据中包含错误、缺失值和重复数据,需要进行清洗以提高数据质量。

- 数据整合:不同数据源的格式和标准不一致,需要进行整合和标准化。

- 业务规则应用:转换过程中需要应用业务规则,但复杂的规则可能导致错误和数据丢失。

在数据转换阶段,企业可以通过定义明确的转换规则和使用自动化工具来减少人为错误。例如,通过使用FineDataLink,可以轻松配置数据转换规则,确保数据转换过程中的高质量输出。

| 转换步骤 | 挑战 | 解决方案 |

|---|---|---|

| 数据清洗 | 错误、缺失值 | 自动化清洗工具 |

| 数据整合 | 格式不一致 | 标准化转换 |

| 业务规则 | 复杂性 | 规则自动化 |

3. 数据加载的注意事项

数据加载是ETL过程的最后一步,但却不容忽视。加载过程的质量直接影响数据的可用性和性能。

- 性能问题:大规模数据加载可能导致系统性能下降,影响其他业务系统的运行。

- 数据一致性:加载过程中的错误可能导致数据不一致,影响业务决策。

- 数据安全:加载过程中需要确保数据的安全性,防止泄露或篡改。

企业可以通过优化加载策略来提高数据质量。例如,采用增量加载方式而非全量加载方式,减少数据加载时间和系统负担。同时,使用FineDataLink可以实现对数据加载的实时监控和管理,确保数据加载过程的安全性和一致性。

🔄 流程优化与架构建议

1. 采用现代化ETL工具

传统的ETL工具在面对大数据环境时往往力不从心。现代化的ETL工具如FineDataLink提供了更高的灵活性和扩展性,能够更好地处理复杂的数据同步和转换需求。

- 低代码开发:降低开发门槛,减少人为错误。

- 实时数据同步:支持对多种数据源的实时同步,提高数据的时效性。

- 自动化流程管理:通过自动化工具减少人工干预,提高流程效率。

2. 构建敏捷的ETL架构

敏捷的ETL架构能够快速响应业务变化,提高数据处理的灵活性和效率。

- 模块化设计:将ETL流程拆分为独立模块,便于管理和优化。

- 微服务架构:通过微服务架构实现ETL流程的解耦,提高系统的可扩展性。

- 云端部署:利用云计算资源提高ETL流程的性能和可用性。

3. 加强数据治理

数据治理是提高数据质量的关键。通过制定严格的数据治理政策和流程,企业能够更好地管理数据质量。

- 数据标准化:制定统一的数据标准,确保数据的一致性。

- 数据监控:通过实时监控工具跟踪数据质量,及时发现和解决问题。

- 数据安全:加强数据安全措施,保护数据免受泄露和篡改。

📚 结论

本文探讨了ETL设计对数据质量的影响,以及如何通过流程优化和架构建议来提高数据质量。选择合适的ETL工具和优化ETL流程架构,对于提高数据质量至关重要。FineDataLink作为帆软背书的国产低代码ETL工具,提供了一站式解决方案,帮助企业实现高效的数据同步和管理。通过现代化工具和敏捷的架构设计,企业能够有效提高数据质量,支持业务的数字化转型。

参考文献

- 王海艳,《数据治理与数据质量管理》,电子工业出版社,2020。

- 刘宏伟,《数据仓库与数据挖掘》,清华大学出版社,2018。

本文相关FAQs

🤔 ETL设计真的能影响数据质量吗?

最近被老板问到:“咱们的数据质量怎么老出问题?是不是ETL设计不合理?”我一开始也没太在意,以为就是个小瑕疵,但仔细一想,发现可能真是这么回事。ETL流程里有不少环节都会影响数据质量,比如数据清洗、转换规则等等。这些环节如果出错,结果可想而知。所以有经验的大佬能不能分享下,ETL设计到底怎么影响数据质量?

ETL(Extract, Transform, Load)是数据处理的核心流程之一,设计得当与否,对数据质量的影响巨大。首先,数据提取阶段就可能产生问题,比如数据源不可靠、数据不完整,这些都会直接影响到最终的数据质量。其次,在数据转换过程中,错误的转换规则、缺乏数据校验机制等问题也会导致数据质量下降。数据加载阶段如果没有做好数据的校验和监控,也会导致数据错误地进入数据仓库。

让我们看看具体的影响:

- 数据完整性:在ETL过程中,如果提取的数据不完整,或者某些字段丢失,结果就是我们得到的分析数据不准确。这可能是因为在提取过程中使用了不正确的SQL查询,或者数据源的连接不稳定。

- 数据一致性:在数据转换阶段,如果不同的数据源有不同的格式或单位,需要通过转换将其标准化。若转换规则不一致,最终数据的一致性就会出问题。

- 数据准确性:ETL设计中,如果没有对数据进行足够的校验和清洗,那么错误的数据也会被加载到目标系统中,直接影响数据分析的准确性。

为了避免这些问题,我们需要在ETL设计时,做到以下几点:

- 明确数据源的可靠性:在提取数据前,要确保数据源是稳定的,数据结构是清晰的。

- 制定清晰的转换规则:在转换数据时,要有严格的转换规则和标准,确保数据的一致性。

- 建立数据校验机制:在加载数据前,进行数据校验,确保数据的准确性和完整性。

通过优化ETL设计流程,我们可以大大提高数据质量,从而提升数据分析的准确性和可靠性。

🛠️ 数据同步时遇到性能问题,该怎么办?

最近在做数据同步,发现同步速度特别慢,老板天天催进度。我们用的是批量定时同步数据,但总感觉有点跟不上需求。有没有大佬分享一下提高数据同步性能的经验?尤其是在数据量特别大的情况下,怎么才能高效地同步?

数据同步是数据处理中的重要环节,尤其是在大数据环境下,如何高效地进行数据同步成为了一个挑战。传统的批量定时同步方式,在数据量巨大的情况下确实容易出现性能瓶颈。这是因为批量同步需要读取大量数据,可能导致网络带宽、目标系统负载等问题。以下是一些提高数据同步性能的方法:

- 增量同步:与传统的全量同步相比,增量同步只处理数据的变化部分,大大减少了数据量,提高了同步速度。可以通过设置时间戳或版本号来实现增量同步。

- 实时流式处理:利用实时流处理框架(如Apache Kafka、Apache Flink)可以实现数据的实时同步。这些框架能够处理大规模数据流,提供高吞吐量和低延迟的数据处理能力。

- 优化网络传输:在数据同步过程中,网络传输是一个关键因素。可以通过压缩数据、使用更高效的网络协议(如gRPC)来提高传输效率。

- 使用合适的工具:选择一个合适的数据集成工具也很重要。比如, FineDataLink体验Demo 作为一款低代码、高时效的数据集成平台,可以帮助企业实现高性能的实时数据同步。它支持多种数据源的实时全量和增量同步,能够根据数据源适配情况,自动优化同步任务。

通过这些方法,我们可以大幅提高数据同步的性能,从而满足业务需求。

🎯 如何优化ETL流程以支持企业的数字化转型?

我们的企业正在进行数字化转型,老板要求我们优化现有的ETL流程,但我有点不知从何下手。有没有比较系统的流程优化建议?尤其是如何在不影响现有业务的情况下,逐步优化ETL架构?

在企业数字化转型中,ETL流程的优化是关键一环。因为ETL直接影响到数据的获取、处理和利用能力。优化ETL流程不仅要提高效率,还要兼顾业务的稳定性和数据的可靠性。以下是一些系统的流程优化建议:

- 评估现有流程:首先对现有ETL流程进行全面评估,找出影响性能的瓶颈和容易出错的环节。可以通过日志分析、性能测试等方式来获取数据。

- 采用现代化架构:传统的ETL架构通常是批处理模式,而现代化的ETL架构更多地采用流式处理,这样不仅提高了数据的时效性,也降低了对系统资源的占用。

- 自动化和监控:引入自动化工具和监控机制,可以大大提高ETL流程的效率和稳定性。自动化工具可以减少人工干预,降低出错率,而监控机制可以实时检测和报警,防止数据问题的发生。

- 数据治理和质量控制:加强数据治理和质量控制,通过数据校验、数据清洗、数据标准化等手段,确保数据质量。

- 逐步迁移和测试:在优化过程中,不要急于求成,可以选择逐步迁移和测试的方法。先在小范围内进行优化和测试,确保没有问题后,再逐步推广到整个系统。

通过这些优化措施,我们可以构建一个高效、稳定、灵活的ETL流程,以支持企业的数字化转型和业务发展。