在当今数据驱动的世界里,企业面临着如何高效地处理和管理大量数据的挑战。传统的数据同步方法往往难以应对大规模数据的实时处理需求,而现代企业需要能够快速、准确地提取和同步数据,以支持业务决策。这便是 Python 与 ETL(Extract, Transform, Load)结合使用的重要性所在。通过自动化数据抽取,企业可以显著提高数据处理效率,同时减少人为错误。

Python 作为一种强大的编程语言,以其灵活性和丰富的库支持,成为实现 ETL 过程的理想选择。本文将深入探讨如何利用 Python 的特性来优化 ETL 流程,实现数据抽取自动化。我们将提供具体的解决方案和工具推荐,帮助企业在数字化转型中获得成功。

🚀一、Python与ETL的结合优势

在数据处理领域,Python因其广泛的应用和强大的功能而备受推崇。结合ETL过程,Python不仅能处理复杂的数据转换,还能简化自动化流程。以下是Python与ETL结合的几个显著优势:

1. 灵活的数据处理能力

Python的灵活性使得它能够处理各种数据类型和格式,这在ETL过程中尤其重要。无论是结构化数据还是非结构化数据,Python都有相应的库和工具来应对。

- 数据转换: 借助Pandas库,Python可以轻松地对数据进行清洗、过滤和转换。这种强大的数据处理能力使得ETL过程中的“Transform”部分变得简单高效。

- 数据连接: Python支持与各类数据库和数据源的连接,如MySQL、PostgreSQL、MongoDB等。这使得数据的抽取和加载过程更加顺畅。

表格展示Python在数据处理中的典型库:

| 数据类型 | 处理库 | 功能 |

|---|---|---|

| CSV | Pandas | 清洗、转换 |

| JSON | json | 解析、转换 |

| SQL | SQLAlchemy | 数据库交互 |

2. 自动化流程的实现

Python的强大之处还在于其自动化能力。通过编写脚本和使用任务调度工具,企业可以实现数据抽取的完全自动化。

- 脚本编写: Python脚本可以实现复杂的ETL流程,包括数据抽取、转换和加载。结合条件判断和循环结构,脚本能够动态适应不同的数据处理需求。

- 任务调度: 使用如Airflow等调度工具,可以轻松实现ETL任务的自动化运行。这不仅提高了数据处理效率,还确保了数据的及时更新。

3. 高效的错误处理机制

ETL过程中的错误处理是保证数据质量的重要环节。Python提供了异常处理机制,使得开发者能够应对各种潜在错误。

- 异常处理: 通过try-except结构,Python可以捕获并处理运行时错误,确保ETL流程的顺利执行。

- 日志记录: 对于错误和异常,Python可以记录详细日志,以便后续分析和处理。这对于维护数据质量和系统稳定性至关重要。

综上所述,Python与ETL结合的灵活性和自动化能力,使得企业能够高效地进行数据处理和管理。在选择ETL工具时,推荐企业考虑 FineDataLink体验Demo ,它是帆软背书的国产高效实用的低代码ETL工具,专为应对实时和离线数据采集等复杂场景而设计。

🔍二、Python实现ETL自动化流程

Python在ETL自动化流程的实现上,提供了全面的解决方案。通过结合不同的库和框架,企业可以构建一个高效稳定的数据处理系统。

1. 数据抽取

数据抽取是ETL过程的第一步,决定了后续数据处理的质量和效率。Python通过多种方式连接和抽取数据源,提供了灵活的解决方案。

- 数据库连接: 使用库如PyMySQL、psycopg2,Python可以方便地连接数据库并提取数据。通过SQL查询语句,用户能够精确地选择需要的记录。

- API数据获取: 对于需要从外部API获取数据的场景,Python的requests库提供了简单的接口。开发者可以设置请求参数,根据需要提取数据。

2. 数据转换

数据转换是ETL过程的核心,涉及数据的清洗、格式变换和整合。Python的强大处理库使得这一过程高效而简洁。

- 数据清洗: 使用Pandas库,Python能够快速清洗和筛选数据。例如,去除重复项、处理缺失值等。

- 数据集成: 通过结合多个数据源,Python可以实现数据的整合。利用Merge和Join操作,开发者能将不同来源的数据组合成有用的格式。

3. 数据加载

数据加载是ETL的最后一步,将处理后的数据存入目标系统。Python支持多种数据加载方式,以满足不同的业务需求。

- 本地存储: 对于需要存储到本地文件的场景,Python支持CSV、Excel等格式的写入。

- 数据库加载: 使用SQLAlchemy等库,Python可以将数据加载到目标数据库中,支持批量插入和更新操作。

表格展示Python在ETL过程中的应用:

| ETL步骤 | 使用库 | 功能 |

|---|---|---|

| 抽取 | PyMySQL | 数据库连接 |

| 转换 | Pandas | 数据清洗和转换 |

| 加载 | SQLAlchemy | 数据库写入 |

Python的强大处理能力和灵活性,使得ETL过程的自动化实现成为可能。通过结合不同的库和工具,企业可以构建一个高效的数据处理系统,支持业务的数字化转型。

🛠️三、Python与ETL结合的实践案例

在实际应用中,Python与ETL结合的案例非常丰富。企业通过实施这些解决方案,能够显著提升数据处理效率和质量。

1. 企业数据仓库建设

企业在构建数据仓库时,需要高效的ETL流程来支持数据的抽取、转换和加载。Python通过其灵活的库支持,能够为数据仓库建设提供强大的技术支持。

- 数据抽取: 企业通过Python连接多个数据源,包括关系型数据库和NoSQL数据库,实现数据的高效抽取。

- 数据转换: 使用Python处理库,企业能够对数据进行复杂的转换操作,确保数据的一致性和完整性。

- 数据加载: Python支持将处理后的数据加载到数据仓库中,维持数据的更新和同步。

2. 实时数据分析

实时数据分析需要快速的数据抽取和处理能力,Python为此提供了高效的解决方案。

- 流数据处理: 使用Python进行流数据处理,企业可以实时分析数据流,支持业务决策。

- 实时报告生成: 通过Python自动化生成报告,企业能够及时获取数据分析结果,做出相应调整。

3. 自动化数据治理

数据治理是企业数据管理的重要环节,Python在自动化数据治理中也有广泛应用。

- 数据质量监控: Python可以实现数据质量的自动化监控,及时识别数据异常和错误。

- 数据合规性检查: 企业通过Python进行数据合规性检查,确保符合相关法规要求。

表格展示Python与ETL结合的实践应用:

| 应用场景 | 解决方案 | 优势 |

|---|---|---|

| 数据仓库建设 | 数据抽取与整合 | 高效数据处理 |

| 实时数据分析 | 流处理与报告 | 及时数据分析 |

| 数据治理 | 质量监控与合规 | 自动化流程与检查 |

Python与ETL结合的实践案例展示了其在数据处理领域的广泛应用。通过实施这些解决方案,企业能够显著提升数据管理效率,为业务决策提供支持。

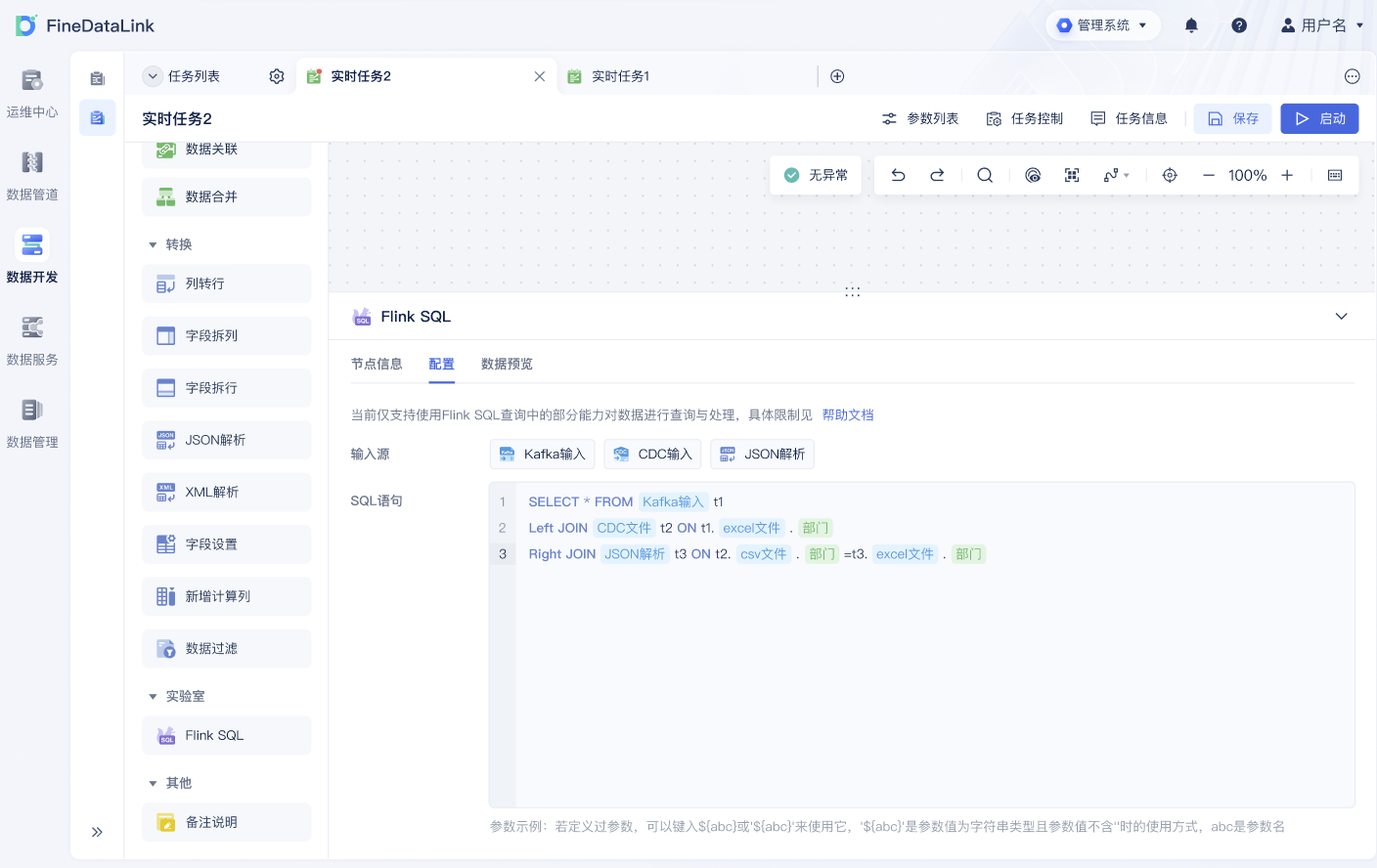

📚四、FineDataLink的优势与应用

在众多ETL工具中,FineDataLink凭借其高效实用的功能,成为企业数据处理的理想选择。作为帆软背书的国产低代码ETL工具,FineDataLink具有多项优势。

1. 简化复杂数据处理

FineDataLink通过低代码平台,简化了复杂的数据处理过程。用户无需编写复杂的代码,即可实现数据的抽取、转换和加载。

- 直观界面: FineDataLink提供简单易用的界面,使得数据处理流程的设计和实施更加直观。

- 自动化配置: 用户可以通过配置任务参数,实现数据处理的自动化。

2. 实时数据同步

对于需要实时数据处理的场景,FineDataLink提供了高效的解决方案。通过实时数据同步功能,企业能够快速更新数据,支持业务实时决策。

- 实时监控: FineDataLink支持数据处理过程的实时监控,确保数据的及时更新。

- 增量同步: FineDataLink支持增量数据同步,减少数据处理时间和资源消耗。

3. 数据治理支持

FineDataLink不仅提供数据处理功能,还支持数据治理的实施,确保数据质量和合规性。

- 数据质量检查: FineDataLink提供数据质量检查工具,帮助企业维护数据的一致性和完整性。

- 合规性支持: FineDataLink支持数据合规性检查,帮助企业满足相关法规要求。

表格展示FineDataLink的功能优势:

| 功能模块 | 特点 | 优势 |

|---|---|---|

| 数据处理 | 低代码配置 | 简化复杂操作 |

| 实时同步 | 增量同步 | 高效数据更新 |

| 数据治理 | 质量与合规检查 | 确保数据合规 |

FineDataLink作为一款高效实用的ETL工具,帮助企业简化数据处理流程,提高数据处理效率。推荐企业在选择ETL工具时,考虑使用 FineDataLink体验Demo 进行实践。

📝总结:Python与ETL结合的非凡价值

本文深入探索了Python与ETL结合的优势、实现方法、实践案例及工具推荐。通过灵活的数据处理能力和自动化流程实现,Python为ETL过程提供了强大的技术支持。企业可以通过Python结合ETL工具,如FineDataLink,实现数据处理的自动化和高效化。无论是构建数据仓库、进行实时数据分析还是实施自动化数据治理,Python与ETL的结合为企业提供了不可或缺的支持。在选择ETL工具时,FineDataLink以其低代码、高效实用的特性,成为企业数字化转型的理想选择。

参考文献:

- 王晓强,《数据科学与Python实践》,电子工业出版社, 2020.

- 李伟,《企业数据治理》,机械工业出版社, 2021.

本文相关FAQs

🐍 什么是Python和ETL?它们如何结合在一起?

哎,最近老板让我研究Python和ETL的结合。说实话,我一开始还真懵了。Python我懂,ETL我也知道是数据抽取、转换和加载,但这俩怎么一起用呢?有没有大佬能简单讲讲?感觉这东西挺有魔力的,但具体怎么操作还真不知道。

结合Python和ETL是一个非常热门的话题,主要因为Python的灵活性和易用性使其成为处理ETL过程的理想工具。ETL,即Extract(提取)、Transform(转换)、Load(加载),是数据集成的核心步骤。Python作为一种强大的编程语言,提供了丰富的库和工具,可以简化这些步骤。

首先,Python强大的数据处理库如Pandas,可以轻松实现数据的提取和转换。Pandas中的DataFrame结构使得数据操作像在Excel中操作表格一样简单,你可以用几行代码实现复杂的数据清洗和转换。比如,你可以用Pandas读取CSV文件,进行缺失值处理,数据聚合等操作。

```python

import pandas as pd

读取CSV文件

data = pd.read_csv('data.csv')

删除缺失值

data.dropna(inplace=True)

数据聚合

grouped_data = data.groupby('category').sum()

```

其次,Python的连接能力非常强。通过SQLAlchemy或pyodbc等库,可以方便地连接到各种数据库,包括MySQL、PostgreSQL、SQL Server等,进行数据提取和加载。例如,使用SQLAlchemy,你可以轻松地从数据库中提取数据并将其加载到另一个数据库中。

```python

from sqlalchemy import create_engine

创建数据库连接

engine = create_engine('mysql+mysqlconnector://user:password@host/dbname')

从数据库中读取数据

data = pd.read_sql('SELECT * FROM table_name', engine)

将数据加载到另一个数据库

data.to_sql('new_table_name', engine, index=False)

```

最后,Python的调度和自动化能力也很强。借助Airflow或Luigi等调度工具,你可以轻松创建复杂的ETL工作流,实现数据的定时抽取、转换和加载。这些工具提供了图形化的工作流管理界面,使得ETL流程的管理和监控变得非常直观。

Python和ETL的结合,给数据工程师和分析师带来了巨大的便利。它不仅提高了数据处理的效率,还大大简化了ETL流程的实现。

🔄 如何自动化ETL流程?Python能帮上忙吗?

我现在倒是明白Python和ETL是怎么回事了。但问题是,我的手动操作太慢了,老板盯着要效率。有没有办法用Python来自动化这些ETL流程啊?最好能让我每天少加点班。

自动化ETL流程是数据工程师的梦想。Python作为一种灵活多变的编程语言,提供了丰富的工具来实现这一目标。

首先,你可以使用Python的调度工具,比如Apache Airflow。Airflow是一个强大的调度和工作流管理平台,专为自动化ETL流程设计。通过Airflow,你可以定义DAG(有向无环图),每个节点代表ETL流程中的一个任务。Airflow不仅支持任务的依赖关系,还提供了丰富的监控和日志功能。

```python

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime

def extract():

# 数据提取逻辑

pass

def transform():

# 数据转换逻辑

pass

def load():

# 数据加载逻辑

pass

定义DAG

dag = DAG('etl_dag', description='My ETL DAG', schedule_interval='@daily', start_date=datetime(2023, 1, 1), catchup=False)

定义任务

extract_task = PythonOperator(task_id='extract_task', python_callable=extract, dag=dag)

transform_task = PythonOperator(task_id='transform_task', python_callable=transform, dag=dag)

load_task = PythonOperator(task_id='load_task', python_callable=load, dag=dag)

设置任务依赖

extract_task >> transform_task >> load_task

```

其次,你可以考虑使用Luigi,这是另一款Python开源调度工具,特别适合于数据管道的构建和管理。Luigi的优势在于其简单的任务定义和依赖管理。

此外,如果你厌倦了自己写调度代码,还可以使用FineDataLink(FDL)这样的低代码工具。FDL支持自动化的ETL流程配置和管理,特别适合业务数据量大的场景。它提供了实时和离线数据采集、集成、管理的功能,只需简单配置,就能实现复杂的ETL流程。相比手动编写代码,FDL的低代码特性能极大提高开发效率。

总的来说,Python为ETL自动化提供了多种选择,从开源工具到商业解决方案,你可以根据具体需求选择适合的工具来实现流程的自动化。

🤔 当数据量巨大时,如何确保ETL过程的高效性?

哎,数据越来越多,手头的ETL流程开始卡壳,慢得像蜗牛。有没有什么方法能优化一下?毕竟老板不想看到报表出得比预期慢。

当数据量巨大时,ETL过程的高效性是一个重要的挑战。要想提高效率,可以从以下几个方面入手:

- 增量数据抽取:不要每次都全量抽取数据,尝试使用增量抽取的方法。可以通过时间戳、变更数据捕获(CDC)等技术来实现,只抽取自上次ETL以来发生变化的数据。

- 并行处理:利用Python的多线程或多进程库,比如concurrent.futures或multiprocessing,来并行处理数据。这样可以充分利用CPU资源,加快数据处理速度。

- 分布式计算:当单机计算能力不足时,可以考虑使用分布式计算框架,比如Apache Spark。Spark的Python接口PySpark,可以在分布式环境中处理大规模数据集,极大提高了数据处理效率。

- 高效存储格式:使用高效的存储格式,比如Parquet或ORC。这些格式支持列式存储和压缩,可以大大减少存储空间和I/O操作,提高数据加载速度。

- 缓存和索引:在频繁访问的数据上建立索引,或者使用缓存技术来减少重复的I/O操作。Python中可以使用Redis作为缓存,或者利用数据库的索引功能。

- 工具选择:当Python无法胜任时,可以借助于专业的ETL工具,比如FineDataLink。这种工具专为大数据场景设计,支持实时和离线数据集成,能够灵活应对数据量大的挑战。

以上这些方法都可以帮助你在数据量巨大的情况下,保持ETL过程的高效性。重要的是,根据具体业务需求和技术栈,选择合适的方案来优化ETL流程。通过不断的调整和优化,你可以确保ETL过程的高效性,从而及时为业务提供所需的数据支持。