在现代企业的数字化转型过程中,数据同步的实时性已成为关键要素之一。想象一下,每次业务决策都依赖于几个小时前的数据,这将如何拖慢企业的反应速度。在数据量庞大、更新频繁的情况下,如何实现高性能的增量同步已成为众多企业的痛点。传统的批量定时同步已不能满足需求,而清空目标表再写入数据的方法则让许多企业担心数据的暂时不可用性。为了攻克这些挑战,FineDataLink(FDL)等高效的企业级数据集成平台应运而生,它为企业在大数据环境下实现实时数据同步提供了强大的支持。

🚀一、理解数据同步的实时性

在数据管理中,实时性是指数据在生成后,尽快被传输到需要的位置并可供使用。实时数据同步的重要性不言而喻,尤其在需要快速决策的商业环境中。实现数据同步的实时性,主要涉及几个关键因素。

1. 数据同步的核心挑战

实现实时数据同步,首先需要了解其面临的几个核心挑战:

- 数据量大:随着企业业务的扩展,数据量呈指数级增长,传统方法难以有效处理。

- 数据变化频繁:业务的动态变化要求同步机制能快速响应。

- 系统资源限制:同步过程需要消耗大量计算和存储资源,可能影响系统性能。

- 数据一致性:在不同数据源之间保持数据的一致性是实时同步的基础。

这些挑战对传统的ETL(Extract, Transform, Load)技术提出了新的要求。传统ETL通常采用批处理模式,难以实现实时性。为了迎接这些挑战,企业需要创新的解决方案。

2. 传统ETL技术的局限性

传统ETL工具虽然在数据整合和清洗方面表现优异,但在实时性上存在明显不足:

- 批处理延迟:数据的批量处理会导致延迟,这与实时同步的需求相悖。

- 复杂的配置:传统ETL工具配置复杂,难以灵活适应多变的业务需求。

- 资源消耗大:批处理需要在短时间内处理大量数据,可能对系统资源造成压力。

为了解决这些局限性,企业需要对ETL技术进行革新,采用低代码、易于配置、支持实时同步的工具,如FineDataLink FineDataLink体验Demo 。

⚙️二、ETL技术如何支持动态更新

在解决数据实时同步的问题上,ETL技术的革新是至关重要的。现代ETL技术通过多种手段支持动态更新,提升数据处理的实时性。

1. 实时ETL的实现机制

现代ETL工具通过以下机制支持实时更新:

- 流式处理:通过流式处理技术,数据在生成后能立即被捕获并处理,减少延迟。

- 事件驱动架构:利用事件驱动架构,数据变化会触发同步操作,实现数据的实时更新。

- 增量同步:只同步变化的数据,而不是全量数据,降低数据传输的负担。

这些机制的结合,使得ETL工具能更好地适应实时同步的需求。

2. FineDataLink的优势

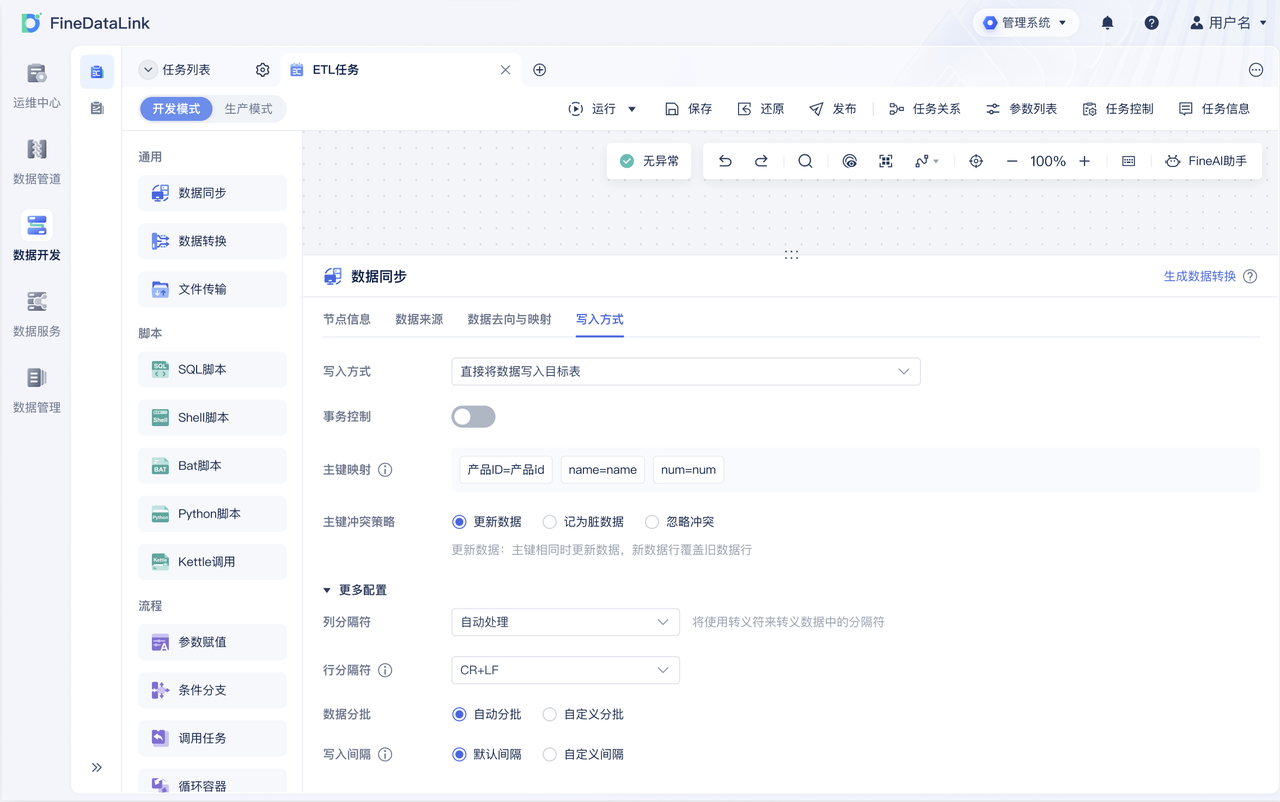

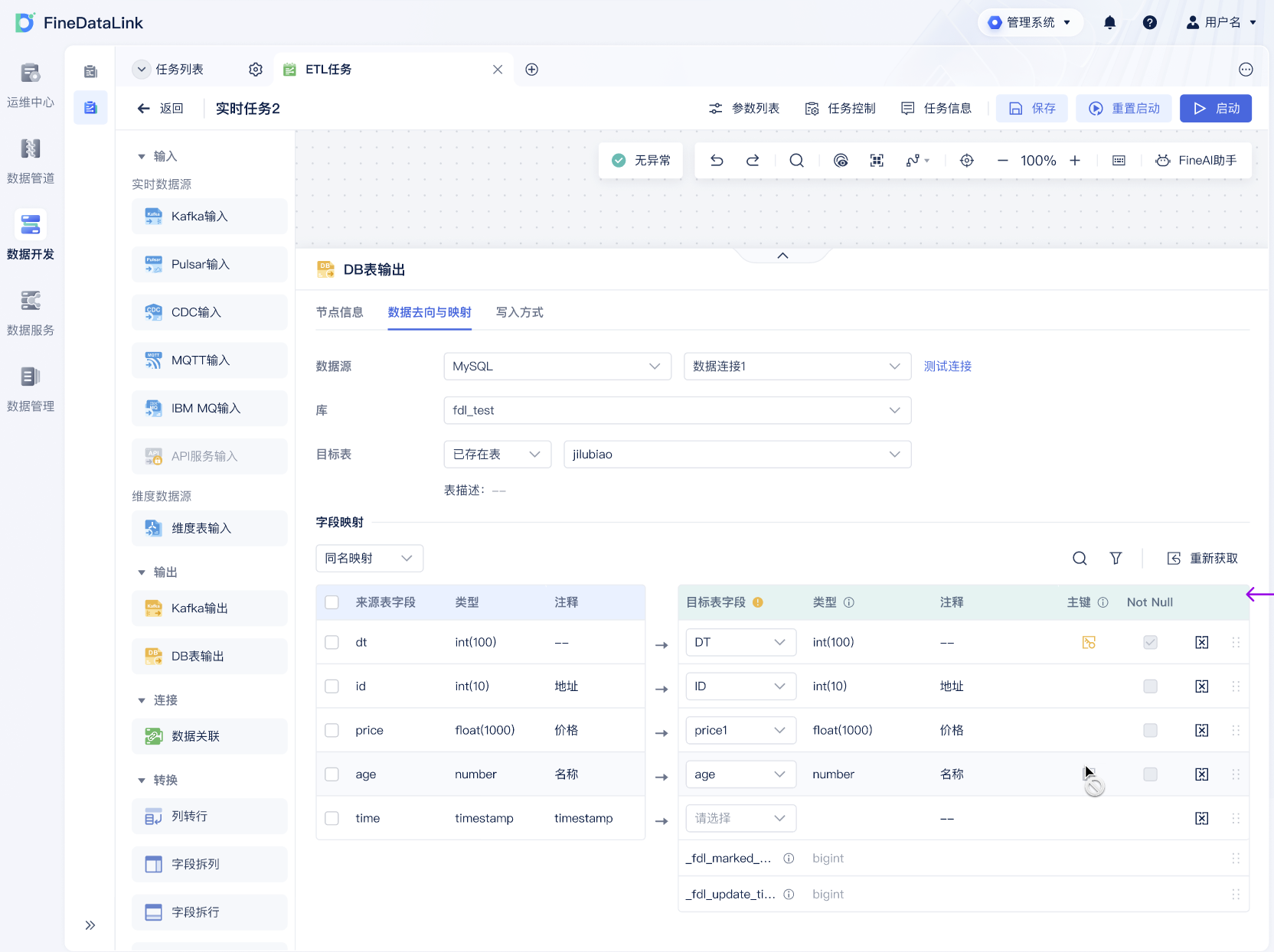

作为国产的低代码ETL工具,FineDataLink在支持动态更新方面表现出色:

- 高效的流处理能力:FDL支持Kafka等流处理框架,能够高效处理实时数据流。

- 灵活的配置能力:用户可以通过简单的配置实现复杂的同步任务,减少开发工作量。

- 丰富的数据源支持:FDL支持多种数据源和目标,能够轻松集成企业现有的数据环境。

| 特性 | 优势 | 说明 |

|---|---|---|

| 高效流处理 | 实时捕获和处理数据 | 支持Kafka等流处理框架 |

| 灵活配置 | 简化配置过程 | 低代码实现复杂同步任务 |

| 多数据源支持 | 广泛的数据集成能力 | 支持多种数据源和目标 |

这些优势使得FineDataLink成为实现实时数据同步的理想选择,并极大地提升了ETL技术对动态更新的支持能力。

⚡三、实时数据同步的实现策略

为了更好地实现数据同步的实时性,企业需要制定一套有效的策略。这些策略不仅涉及技术的选择,还包括流程的优化和资源的合理配置。

1. 数据同步的技术选择

在技术选择上,企业可以通过以下策略实现实时数据同步:

- 选择合适的ETL工具:如FineDataLink,能够提供低延迟的实时同步能力。

- 采用流式数据架构:利用Kafka、Flink等流处理平台,实现数据的实时处理。

- 开发定制化的同步解决方案:针对特定业务场景,开发定制化的同步模块,优化性能。

这些技术选择可以帮助企业在多变的商业环境中保持数据的实时性。

2. 流程优化与资源配置

除了技术选择,优化同步流程和资源配置也是实现实时同步的重要环节:

- 优化数据管道:减少数据传输路径中的瓶颈,提高整体传输速度。

- 合理配置系统资源:根据同步任务的需求,合理分配计算和存储资源。

- 持续监控与调整:通过持续的监控和性能分析,动态调整同步策略。

通过优化流程和合理配置资源,企业可以进一步提升数据同步的实时性和可靠性。

🏁总结

在企业数字化转型的过程中,实现数据同步的实时性是提升业务反应速度和决策效率的关键。通过选择合适的ETL工具、采用流式数据架构,以及优化同步流程和资源配置,企业可以有效地应对数据同步的挑战。FineDataLink作为国产高效的低代码ETL工具,以其强大的实时同步能力,帮助企业在大数据环境下实现数据的动态更新,为业务的数字化转型提供了有力支持。通过本文的讨论,企业可以更好地理解和应用这些策略,推动数据管理的创新和发展。

参考文献

- 王华. 《大数据技术原理与应用》. 电子工业出版社, 2021.

- 李明. 《实时数据处理技术》. 清华大学出版社, 2020.

本文相关FAQs

🔄 数据同步怎么做到实时性?

最近在公司负责数据库的管理,老板总是要求数据同步要更快、更实时。可是面对庞大的数据量,定时批量同步效率太低了,有时候还影响业务运行。有没有大佬能分享一下实现实时同步的绝招?

实现数据同步的实时性可以说是数据工程师的头号难题,尤其是当数据量庞大的时候。要解决这个问题,先得了解几种常见的同步方式:批量处理和流处理。批量处理是传统的方式,适合定期数据更新,但对于实时性要求高的场景,流处理才是王道。

在流处理方面,我们可以借助工具比如Apache Kafka和AWS Kinesis。这些工具允许数据在微秒级内传输,从而实现实时同步。Kafka的分布式架构特别适合处理海量数据,支持数据流的多节点消费和生产。这意味着即使数据量巨大,也能在短时间内完成同步。

流处理的核心在于数据的持续输入和输出,这样可以降低延迟,保证实时性。但这也要求我们设计精良的架构,确保数据流的顺畅,比如合理设置分区和副本数量,以防止数据堵塞。

当然,在选择工具的时候,还要考虑数据源的类型和结构。比如,对于结构化的数据,使用SQL Stream可能是个好选择,而对于非结构化数据则可以考虑NoSQL数据库的实时更新功能。

最后,想要确保实时同步的有效性,监控和调优是少不了的。定期检查传输速度、延迟、错误率等指标,及时发现问题并作出调整。

🚀 ETL技术如何支持动态更新?

我们公司最近在做数据仓库建设,发现使用传统ETL工具很难支持动态更新。每次数据变化都需要重新跑一遍整个流程,效率低到老板都看不下去了。有没有什么办法可以优化ETL流程,让它支持动态更新呢?

传统ETL工具之所以难以支持动态更新,主要还是因为它们的设计思路。一般来说,ETL流程是批处理的,先抽取数据,再进行转换和加载,适合周期性任务。可是,当数据源不断变化时,传统的ETL就显得有些笨拙了。

为了解决这个问题,我们可以借助增量ETL技术。所谓增量ETL,就是只处理变化的数据,而不是每次都跑全量。这样可以极大地提高效率。实现增量ETL有几个关键点:

- 识别变化:我们需要一种机制来识别哪些数据发生了变化,比如使用数据源的Change Data Capture(CDC)功能。CDC可以实时监控数据更新、插入、删除等操作。

- 实时触发:增量ETL需要能够实时触发数据处理任务。可以结合流处理工具,如Apache Kafka,来实现数据实时传输和处理。

- 智能调度:通过调度工具,比如Apache Airflow,可以根据数据变动情况动态调整任务运行频率和顺序。

- FineDataLink的优势:在复杂的企业环境中,使用像FineDataLink这样的平台可以大大简化增量ETL的实现。它支持实时全量和增量同步,能根据数据源适配情况自动配置任务,减少人工干预。

通过这些措施,ETL流程可以更智能地适应数据的动态变化,不再需要频繁的全量处理,从而提高效率和实时性。

🤔 如何选择适合的实时数据同步方案?

公司决定全面升级数据同步方案,面对众多工具和方法,我有点晕头转向。不同的工具都有各自的优缺点,怎么才能选择最适合公司的呢?

选择一个适合的实时数据同步方案,需要从多个方面进行考量。首先要明确公司的业务需求,比如数据量、数据类型、实时性要求等。下面是一些选择方案时需要考虑的因素:

| 因素 | 说明 |

|---|---|

| **数据量** | 数据量大的公司,建议选择支持分布式架构的工具,比如Apache Kafka。 |

| **数据类型** | 如果数据源主要是结构化数据,可以考虑SQL Stream;如果是非结构化数据,NoSQL数据库可能更合适。 |

| **实时性要求** | 对于实时性要求特别高的场景,流处理工具是最佳选择。 |

| **易用性** | 工具的易用性也是一个重要因素。选择一个上手快、操作简便的工具可以减少学习成本。 |

| **支持** | 考虑工具的社区支持和文档质量,确保在遇到问题时有足够的资源帮助解决。 |

在进行选择时,可以先做小规模试点,测试不同工具的性能和适用性,看看是否符合预期。比如,可以先在有限的数据集上验证工具的实时性和稳定性,观察其处理速度和错误率。

最后,别忘了考虑未来扩展性。选择一个具有良好扩展性的工具,确保未来数据量增长或业务需求变化时不会影响系统性能。

通过综合考虑这些因素,可以更好地选择适合公司的实时数据同步方案,为企业的数字化转型打下坚实的基础。