在现代数字化转型的浪潮中,企业越来越依赖API数据接口来实现系统之间的无缝数据交换。然而,这一过程中存在的挑战往往令人措手不及。许多企业在面对数据接口时,常常感受到来自于性能、安全性以及数据同步等方面的阻碍。就像一台高速运转的机器,任何一个小故障都有可能导致整个系统的瘫痪。本文将深入探讨API数据接口面临的挑战,并揭示解决这些问题的有效方案,助力企业在数字化转型中轻松应对这一关键环节。

🔍 一、API数据接口的性能挑战

1. 数据传输的速度与可靠性

API接口的性能往往直接影响系统的响应速度。尤其是在大数据环境下,高效的数据传输和处理成为企业关注的焦点。

- 数据量大:随着业务的增长,数据量呈指数级增长,传统API接口在处理大数据量时常常力不从心。

- 传输速度慢:网络带宽限制、数据包大小等因素都可能导致数据传输速度缓慢。

- 可靠性差:在数据传输过程中,丢包、数据损坏等问题频频出现,影响数据的完整性。

解决方案

要解决这些问题,企业可以通过以下策略优化API接口性能:

- 批处理与并行处理:采用批量处理和并行处理的方式,提升数据传输效率。

- 数据压缩:在传输过程中对数据进行压缩,减少数据体积。

- 使用CDN:借助内容分发网络(CDN)加速数据传输,提升系统响应速度。

以下是解决方案的对比表:

| 解决方案 | 优点 | 缺点 |

|---|---|---|

| 批处理与并行处理 | 提升速度,降低延迟 | 复杂度增加 |

| 数据压缩 | 减少传输数据量 | 需额外的解压缩时间 |

| 使用CDN | 提升传输速度与可靠性 | 可能增加成本 |

2. API接口的可扩展性

随着业务的扩展,API接口需要具备良好的可扩展性,以应对不断增加的用户请求和数据量。

- 请求高峰:在流量高峰期,API接口可能无法处理大量请求。

- 资源限制:计算资源、存储资源的限制影响接口的扩展能力。

- 架构僵化:传统的单体架构不利于API接口的灵活扩展。

解决方案

提升API接口的可扩展性,可以通过以下方式实现:

- 微服务架构:采用微服务架构,将API接口拆分成多个独立的服务,以便灵活扩展。

- 云计算:利用云计算的弹性扩展能力,动态调整资源配置。

- 负载均衡:使用负载均衡技术,均匀分配请求,提升系统稳定性。

🔐 二、API数据接口的安全挑战

1. 数据泄露和隐私保护

在数据传输过程中,API接口极易成为网络攻击的目标,导致数据泄露。

- 未授权访问:黑客可以通过未授权访问接口,窃取敏感数据。

- 数据泄露风险:接口的错误配置或漏洞可能导致数据泄露。

- 隐私保护不足:缺乏有效的隐私保护措施,用户数据面临风险。

解决方案

为了保护数据安全,企业可以采取以下措施:

- 身份验证:采用OAuth、JWT等技术进行接口身份验证。

- 加密传输:使用HTTPS协议,对数据传输进行加密。

- 访问控制:设置严格的访问控制策略,限制数据访问权限。

2. API接口的攻击防护

API接口常常成为攻击者的目标,需要有效的防护措施来抵御各种网络攻击。

- DDoS攻击:分布式拒绝服务攻击会导致接口无法正常提供服务。

- SQL注入:攻击者通过恶意SQL语句窃取或破坏数据库数据。

- XSS攻击:跨站脚本攻击可能导致用户数据被窃取。

解决方案

为防止API接口受到攻击,企业应采取以下防护策略:

- 防火墙:部署Web应用防火墙(WAF),过滤恶意请求。

- 输入验证:对用户输入进行严格验证,防止SQL注入和XSS攻击。

- 流量监控:实时监控接口流量,及时发现并阻止异常行为。

🔄 三、API数据接口的数据同步挑战

1. 实时数据同步

在大数据环境下,实现高效的实时数据同步是企业面临的一大挑战。

- 同步延迟:数据同步过程中的延迟影响实时性。

- 数据一致性:多源数据同步时,容易出现数据不一致问题。

- 网络抖动:网络环境的不稳定性可能导致数据同步中断。

解决方案

为实现高效的实时数据同步,企业可以采用如下策略:

- 流式处理:采用Kafka、RabbitMQ等流处理技术,提升数据同步实时性。

- 增量同步:只同步发生变化的数据,减少数据同步量。

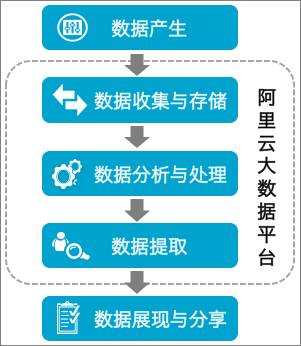

- FineDataLink:使用国产高效的低代码ETL工具FineDataLink,简化数据集成和实时同步流程。 FineDataLink体验Demo

2. 数据同步的复杂性

在多源、多格式的数据环境中,实现数据的高效同步具有较大的复杂性。

- 数据源多样:不同数据源的数据格式各异,增加同步难度。

- 数据转换:数据在同步过程中需要进行格式转换,增加复杂性。

- 数据治理:需要对数据进行治理,确保数据质量和一致性。

解决方案

为应对数据同步的复杂性,企业可以采取以下措施:

- 数据标准化:建立统一的数据标准,简化数据转换过程。

- 自动化工具:使用自动化工具简化数据同步流程,减少人工干预。

- 数据治理平台:部署数据治理平台,提升数据质量和一致性。

📚 结语

API数据接口在企业的数字化转型中扮演着重要角色。针对性能、安全和数据同步三大挑战,企业需要采取一系列的技术和策略来优化接口性能、保护数据安全以及实现高效的数据同步。通过本文的深入探讨,相信读者能够更好地理解API数据接口的挑战,并找到适合自身企业的解决方案,以确保在数字化转型过程中顺利前行。

参考文献

- "RESTful Web APIs" by Leonard Richardson, Mike Amundsen, and Sam Ruby

- "Microservices Architecture: Aligning Principles, Practices, and Culture" by Irakli Nadareishvili, Ronnie Mitra, Matt McLarty, and Mike Amundsen

- "Data Governance: How to Design, Deploy, and Sustain an Effective Data Governance Program" by John Ladley

本文相关FAQs

🚀 如何解决API接口数据同步的性能问题?

在企业数字化转型过程中,老板总是希望数据能够实时更新,但当数据量巨大时,API接口的性能问题就凸显出来了。有没有大佬能分享一下如何解决大规模数据同步时的性能瓶颈?特别是增量同步的部分,大家都是怎么搞定的?有没有一些高效的实战经验?

解决API接口数据同步的性能问题,尤其是增量同步,是许多企业在大数据环境下遇到的常见挑战。首先,需要理解的是,增量同步指的是只同步发生变化的数据,而不是全量同步整个数据库,这样可以大幅提升效率。为了解决这个问题,以下几个策略可以考虑:

1. 使用高效的数据传输协议: 企业可以选择使用高效的传输协议,如gRPC或数据流协议,这些协议在处理大规模数据时表现出色。它们可以提供更低的延迟和更高的吞吐量。

2. 数据库变更捕获(CDC): CDC技术可以帮助识别数据库中的变化,并只同步这些变化。通过使用日志记录和变更追踪机制,企业可以实现实时的增量同步而不影响系统性能。

3. 缓存机制优化: 通过引入分布式缓存系统(如Redis),可以减少对数据库的直接访问频率,从而提高数据访问速度并降低数据库负载。

4. FineDataLink平台的应用: 对于希望简化复杂数据同步流程的企业,可以考虑使用像FineDataLink这样的低代码平台。FineDataLink不仅支持实时和离线数据采集,还能通过配置实现实时全量和增量同步,适合处理大数据场景。 FineDataLink体验Demo 。

5. 弹性扩展: 通过云服务上的弹性扩展能力,企业可以根据数据流量动态调整资源分配,确保在高峰期也能保持性能稳定。

这些解决方案各有优劣,具体选择需要根据企业的数据规模、基础架构以及预算来决定。实践中,结合使用多个策略,往往能达到更理想的效果。

📊 数据库实时同步时如何避免目标表不可用?

在数据库实时同步过程中,有时候我们会遇到目标表短时间不可用的问题,尤其是在清空目标表后重新写入数据。这个问题很影响业务连续性,有没有好的解决办法可以避免这种情况?大家都是怎么处理的?

目标表不可用的问题在实时数据同步中是一个关键痛点,对于业务连续性要求较高的企业来说,解决这一问题至关重要。以下是几种常见的解决方案:

1. 双写策略: 通过双写策略,可以在数据同步过程中同时将数据写入两个表——一个用于实时查询,另一个用于数据更新。这样,即使一个表在更新过程中不可用,另一个表仍然可以提供服务。

2. 表切换机制: 实施表切换机制,即在准备写入新的数据时,先将数据写入一个备用表,待写入完成后通过切换表名来实现无缝更新。这种方式可以保证在数据写入期间,目标表仍然可以正常访问。

3. 数据分片: 通过将数据划分为多个分片,可以在更新过程中逐片进行更新,减少单一表的不可用时间。这种方式适合大规模数据量的场景。

4. 使用事务处理: 采用事务处理可以确保在数据更新过程中出现问题时可以回滚,避免目标表长时间不可用。

5. FineDataLink的实时同步功能: FineDataLink平台提供多对一数据的实时同步功能,可以通过配置实现数据的动态更新,减少目标表的不可用时间。

具体选择哪种解决方案要根据企业的业务需求和基础设施来决定。通常情况下,结合使用多种方案可以更有效地解决目标表不可用的问题。

🔍 在大数据环境下如何优化API接口的架构设计?

随着业务数据量的增长,API接口的设计变得越来越复杂。有没有大佬能分享一下在大数据环境下如何优化API接口的架构设计?特别是要考虑数据传输效率和系统扩展性方面。

在大数据环境下,优化API接口的架构设计不仅仅是技术上的挑战,更是影响企业业务效能的关键因素。为了确保API接口能够高效处理海量数据并保持良好的扩展性,可以考虑以下几个方面:

1. 微服务架构: 采用微服务架构将API设计拆分为多个独立服务模块,每个模块负责特定功能。这种设计可以提高系统的灵活性和扩展性,便于维护和升级。

2. 异步处理: 通过使用消息队列(如Kafka、RabbitMQ)进行异步处理,可以有效提高API的响应速度和系统的吞吐量,避免因同步操作导致的性能瓶颈。

3. 数据压缩与流式处理: 在数据传输过程中使用压缩技术(如GZIP)和流式处理可以显著降低网络负载,提高数据传输效率。

4. API网关: 引入API网关(如Kong、Apigee)可以帮助管理和优化API流量,提供负载均衡、缓存和安全管理等功能。

5. 使用FineDataLink: 对于企业级数据集成需求,可以使用FineDataLink平台进行数据调度和治理,简化复杂的API架构设计。 FineDataLink体验Demo 。

通过以上这些优化策略,不仅能提高API接口的效率,还能增强系统的稳定性和扩展性。在实际应用中,根据业务需求调整和组合这些策略,可以更加有效地应对大数据环境下的挑战。