在当今数据驱动的世界中,如何高效地处理和分析大规模数据已经成为企业成功的关键之一。特别是在人工智能领域,海量数据的处理能力决定了模型的训练速度和准确性。Spark,作为一个强大的大数据处理框架,因其高速度、易扩展性和强大的内存处理能力,成为了数据分析和人工智能领域的热门选择。那么,如何用Spark处理大规模人工智能分析呢?本文将深入探讨这一问题,提供可行的技术方案,帮助你在数据分析的旅程中少走弯路。

🚀 一、Spark的基本概念与特点

在深入技术方案之前,首先了解Spark的基本概念和特点是非常必要的。Spark是一个开源的大数据处理框架,支持批处理、流处理、SQL查询、机器学习和图计算等多种计算模式。其核心优势在于内存计算速度快、易于使用和高度可扩展性。

1. Spark的架构与核心组件

Spark的架构设计使其在处理大规模数据时具有显著的优势。Spark的核心组件包括:

- Spark Core:提供基本的内存计算功能和任务调度。

- Spark SQL:用于处理结构化数据和关系型查询。

- Spark Streaming:支持实时数据流处理。

- MLlib:提供机器学习算法库。

- GraphX:用于图计算。

这些组件的协同工作使得Spark在处理大规模数据时具备了高效和灵活的能力。

| 组件名称 | 功能描述 | 优势 |

|---|---|---|

| Spark Core | 内存计算与调度 | 高速度 |

| Spark SQL | 结构化数据处理 | 易用性 |

| Spark Streaming | 实时流处理 | 实时性 |

| MLlib | 机器学习算法库 | 算法丰富 |

| GraphX | 图计算 | 强大图处理能力 |

2. Spark的内存计算优势

Spark的内存计算能力是其最大的亮点。与传统的MapReduce不同,Spark通过在内存中计算中间结果,大幅减少了磁盘I/O操作,从而提高了计算速度。这种内存计算模型特别适合需要迭代计算的机器学习任务。

- 快速的数据处理能力

- 减少磁盘I/O操作

- 支持复杂计算流程

3. Spark的易用性与扩展性

Spark提供了丰富的API,支持Scala、Java、Python和R等多种编程语言,使开发者能够以最熟悉的语言进行编程。此外,Spark的扩展性使其能够轻松处理从数百GB到数PB的数据。

- 多语言支持

- 高度可扩展

- 便捷的开发环境

通过理解Spark的基本概念和核心优势,我们可以更好地利用其能力进行大规模人工智能分析。接下来,我们将探讨如何将这些优势转化为实际的技术方案。

🧠 二、用Spark进行大规模人工智能分析的技术方案

在掌握了Spark的基本特点后,接下来我们将详细探讨如何用Spark进行大规模人工智能分析。具体来说,如何利用Spark的核心功能来处理和分析海量数据,为人工智能模型提供支持。

1. 数据准备与预处理

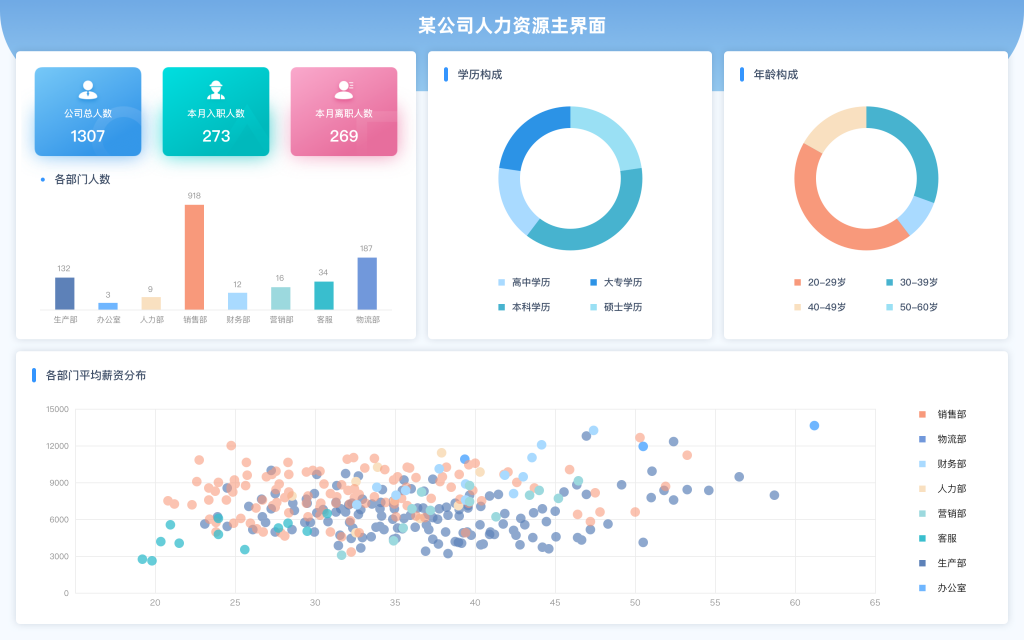

在人工智能分析中,数据的准备与预处理是至关重要的一步。FineBI提供了一种比Excel更强大的数据提取和分析能力,通过直观的界面和便捷的自助分析模式,使用户能够快速完成数据准备工作。

| 步骤 | 描述 | 工具 |

|---|---|---|

| 数据清洗 | 去除重复和错误数据 | FineBI |

| 数据转换 | 数据格式转换与标准化 | Spark SQL |

| 数据抽样 | 选择代表性数据集 | Spark Core |

- 使用FineBI进行数据清洗和初步分析

- 利用Spark SQL进行数据格式转换

- 在Spark Core中进行数据抽样,确保数据代表性

2. 模型训练与评估

利用Spark的MLlib库,可以高效地训练和评估机器学习模型。MLlib提供了多种常用的机器学习算法,并且可以利用Spark的分布式计算能力来加速模型训练。

- 选择合适的机器学习模型

- 利用Spark的并行计算能力加速训练过程

- 使用交叉验证等方法评估模型性能

在模型训练过程中,我们需要注意数据的平衡性和模型的泛化能力,以确保模型在实际应用中能保持稳定的表现。

3. 实时流数据处理

在某些人工智能应用场景中,实时数据处理是必不可少的。Spark Streaming可以帮助我们处理实时数据流,从而实现实时分析与决策。

| 功能 | 描述 | 适用场景 |

|---|---|---|

| 数据接入 | 实时接收数据流 | 物联网 |

| 数据处理 | 实时分析与处理 | 在线推荐 |

| 数据存储 | 结果存储与可视化 | 实时监控 |

- 接入实时数据源,确保数据流的连续性

- 利用Spark Streaming实现实时数据处理

- 将结果存储到数据库,并通过可视化工具进行展示

通过整合上述技术方案,我们可以有效地利用Spark进行大规模人工智能分析,为企业的智能化转型提供有力支持。

🔍 三、实例分析:Spark在实际人工智能项目中的应用

在理论方案之下,我们通过一个实际案例来分析Spark在人工智能项目中的应用,帮助读者更好地理解和掌握这些技术。

1. 案例背景

某大型零售公司希望通过大数据分析和人工智能技术,优化其库存管理和客户推荐系统。面临的挑战包括数据量巨大、数据类型多样、实时性要求高。

- 公司规模:全国性零售连锁

- 数据量:每日产生数TB的数据

- 应用场景:库存优化、客户推荐

2. 技术实施

在该项目中,公司使用了Spark作为核心的数据处理引擎,结合FineBI进行数据可视化和自助分析。

| 步骤 | 描述 | 工具 |

|---|---|---|

| 数据集成 | 整合多源数据 | Spark SQL |

| 模型开发 | 开发预测模型 | Spark MLlib |

| 实时处理 | 处理实时销售数据 | Spark Streaming |

- 使用Spark SQL整合来自POS系统、ERP系统的销售数据

- 利用Spark MLlib开发库存预测模型,优化库存管理

- 通过Spark Streaming处理实时销售数据,实现在线客户推荐

3. 项目效果

通过实施这一方案,公司实现了库存管理效率的提升和客户推荐的精准化,显著提高了运营效率和客户满意度。

- 库存周转率提升20%

- 客户推荐点击率提高15%

- 数据处理时间减少50%

通过这个案例,我们可以看到Spark在大规模数据分析中的强大能力,以及它在人工智能项目中的实际应用效果。

📚 四、未来展望与结论

在数据驱动的时代,如何有效处理和分析大规模数据是每个企业必须面对的挑战。而Spark,凭借其强大的内存计算能力和丰富的功能组件,为我们提供了强有力的技术支持。通过合理的技术方案和工具选择,我们可以充分发挥Spark的优势,推动企业的智能化转型。

总结与建议

- 理解Spark的核心优势:利用其内存计算和分布式处理能力。

- 选择合适的工具:如FineBI,用于数据准备和可视化。

- 结合实际需求:定制化技术方案,确保项目成功。

在未来,随着数据量的不断增长和人工智能技术的不断发展,Spark将继续在大规模数据分析中扮演重要角色。我们期待它能为更多企业带来变革性的影响。

参考文献

- 《深入理解Spark:核心思想与源码分析》,李鹏,电子工业出版社。

- 《大数据分析技术》,王晓东,清华大学出版社。

- 《机器学习实战:基于Spark的应用》,张伟,人民邮电出版社。

通过对这些资料的深入研究,我们可以进一步理解Spark的强大功能和应用场景,为数据分析和人工智能项目提供更有力的支持。

本文相关FAQs

🚀 如何开始用 Spark 处理大规模人工智能分析?小白求指教!

我最近在一个项目中需要处理大量数据,听说 Spark 很厉害,但我对它还不太了解。能不能帮我理一下思路,如何入门 Spark 进行大规模的人工智能分析?有没有什么好的教程或者资料推荐?

要开始用 Spark 处理大规模人工智能分析,首先需要了解 Spark 的基本架构和工作机制。Spark 是一个强大的分布式计算框架,适用于大规模数据处理和机器学习。它可以处理海量数据,并且速度非常快,因为它能够在内存中进行计算,从而减少磁盘 I/O 操作。

Spark 的基本组件包括:

- Spark Core:提供基本的任务调度和内存管理。

- Spark SQL:用于结构化数据处理。

- Spark Streaming:用于实时数据流处理。

- MLlib:提供机器学习算法库。

- GraphX:用于图处理。

在开始之前,你可以安装一个本地版的 Spark,进行一些小规模的数据处理实验。这有助于你理解 Spark 的基本操作,如 RDD(Resilient Distributed Datasets)的创建和转换。可以从 Apache Spark 的官方网站 下载并安装。

学习资源推荐:

- 官方文档:Spark 的官方文档非常详细,涵盖了从安装到高级使用的所有内容。

- 在线课程:Coursera 和 Udemy 上有很多高质量的 Spark 入门课程。

- 社区和论坛:如 Stack Overflow 和 Reddit,能找到许多有用的问答。

最后,建议你在学习过程中,尝试用 Spark 处理一些公开数据集,这样可以加深理解。

📊 使用 Spark 进行大规模数据分析时,如何提高效率?有何技巧?

在实际工作中,我发现用 Spark 处理大规模数据时,性能并不总是理想。想请教一下,如何优化 Spark 的性能?有哪些常见的技巧和方法?

在大规模数据分析中,Spark 的性能优化是一个关键问题,尤其是在处理复杂的人工智能算法时。以下是一些常见的优化技巧:

- 数据分区:合理的数据分区可以显著提高性能。Spark 默认会根据数据的大小和集群的资源进行分区,但这并不总是最优的。你可以通过

repartition和coalesce方法调整分区数量。 - 持久化(Caching):对于需要多次使用的数据,使用

cache()或persist()将数据缓存到内存中,可以减少重复计算的时间。 - 使用 DataFrame 和 Dataset:相较于 RDD,DataFrame 和 Dataset 提供了更高的抽象层次,能够自动优化查询执行计划,提升性能。

- 广播变量:对于需要在多个节点上共享的小数据集,可以使用广播变量减少数据的传输开销。

- 调优资源配置:根据作业的需求,调整 Spark 的资源配置,如 executor 的数量和内存大小,能够提高计算效率。

- 代码优化:在编写 Spark 应用时,尽量减少

groupByKey等需要在全局范围内进行数据洗牌的操作,使用reduceByKey等局部聚合操作代替。

具体实现:假设你正在处理一个大规模的用户行为日志数据集,你可以先用 Spark SQL 对数据进行预处理,筛选出需要的字段,然后使用 MLlib 进行机器学习模型的训练。在整个过程中,合理应用上述优化技巧,可以显著提升分析效率。

通过这些方法,你可以在实际项目中提高 Spark 的性能,确保大规模数据分析的效率和效果。

📈 Excel 已经不够用了,如何用 FineBI 和 Spark 助力数据可视化?

我们公司一直用 Excel 做数据分析,但随着数据量的增加,Excel 越来越吃力。听说 FineBI 和 Spark 能很好地解决这个问题,能不能详细介绍一下?

随着数据量的增长,Excel 逐渐显得力不从心。这时候,FineBI 和 Spark 是强大的组合,可以为企业的数据分析提供更高效的解决方案。

为什么选择 FineBI 和 Spark?

- FineBI 的优势:

- 强大的数据处理能力:FineBI 可以连接多种数据源,并且支持大数据量的快速处理。

- 自助分析模式:FineBI 提供了用户友好的界面,允许业务人员通过拖拽的方式进行数据分析,无需编程。

- 市场占有率第一:FineBI 已连续八年在中国市场占有率第一,获得了多家权威机构的认可。

- FineBI在线试用

- Spark 的贡献:

- 分布式计算:Spark 能够处理海量数据,适合大规模数据分析和机器学习。

- 实时性:通过 Spark Streaming,能够处理实时数据流,及时获取分析结果。

如何结合使用:

- 使用 Spark 对大规模数据进行预处理,比如数据清洗、特征提取等。

- 将处理后的数据集成到 FineBI 中,通过其强大的数据可视化功能,快速生成报表和仪表盘。

- FineBI 的可视化结果可以帮助企业决策者快速理解数据背后的趋势和问题。

实际例子:假设你正在分析一个电商平台的用户行为数据。通过 Spark,你可以快速处理用户的浏览和购买记录,找出热门商品和用户的购买习惯。接着,使用 FineBI 自动生成销售趋势图和用户画像,帮助市场部门优化营销策略。

这种结合使用的方式,不仅提高了数据处理的效率,还增强了数据分析的直观性和实用性,是应对大规模数据分析挑战的理想方案。