在数字化转型浪潮中,企业数据处理能力的提升已成为竞争的关键。然而,面对海量数据,如何实现高效的增量同步成为了许多企业的痛点。想象一下,您正在处理一个动辄数百万行的数据库,若每次更新都需要重新同步全部数据,效率低下不说,还可能导致系统资源的浪费和业务中断。那么,有没有更优的解决方案呢?今天我们将深入探讨数据增量同步的实用步骤与方法,让您的数据处理如虎添翼。

🌟 一、理解数据增量同步的基本原理

在谈及数据增量同步时,我们首先要明确其基本原理。增量同步是一种只同步变化数据的技术,而不是重新同步整个数据库。这种方式不仅节省了时间,还大幅减少了网络带宽的消耗。

1. 增量同步与全量同步的比较

首先,我们需了解增量同步和全量同步的区别。全量同步意味着每次数据同步时,都会传输整个数据集,而增量同步则只传输自上次同步以来发生变化的数据。这个差异对系统性能有着巨大的影响。

| 同步类型 | 数据传输量 | 性能影响 | 使用场景 |

|---|---|---|---|

| 全量同步 | 高 | 资源消耗大 | 小规模数据更新 |

| 增量同步 | 低 | 资源消耗低 | 大规模数据更新 |

增量同步的优势在于它可以显著降低资源消耗,因此在处理大规模数据更新时尤为适用。通过减少冗余数据传输,增量同步能够提高系统效率和响应速度。

2. 实现增量同步的基本步骤

要实现高效的增量同步,我们通常遵循以下步骤:

- 识别变化数据:使用数据库的触发器或日志来识别变化的数据。

- 数据过滤与提取:只选择需要同步的数据,通过查询优化来提取增量数据。

- 数据传输与应用:使用高效的传输协议将数据发送至目标系统,并在目标系统中正确应用这些数据。

这些步骤确保数据同步过程快速且准确。通过识别和处理增量数据,我们不仅节省了时间,还能降低系统负荷,进而提升整体性能。

3. 数据增量同步的挑战

尽管增量同步有诸多优势,但其实施过程中仍存在一些挑战:

- 数据一致性:确保源系统和目标系统数据的一致性是增量同步的核心问题。

- 系统兼容性:不同系统间的数据格式和传输协议可能不兼容。

- 实时性:在一些应用场景中,实时性是关键,增量同步需要确保足够的速度来满足业务需求。

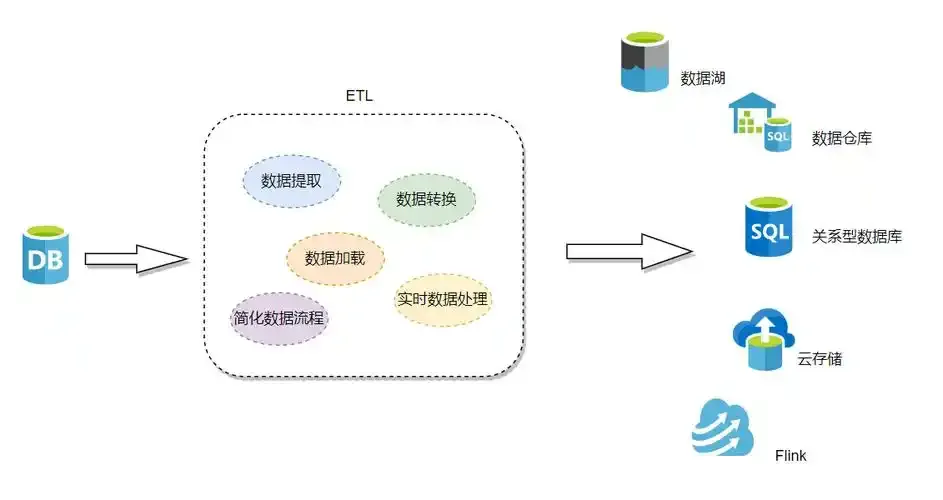

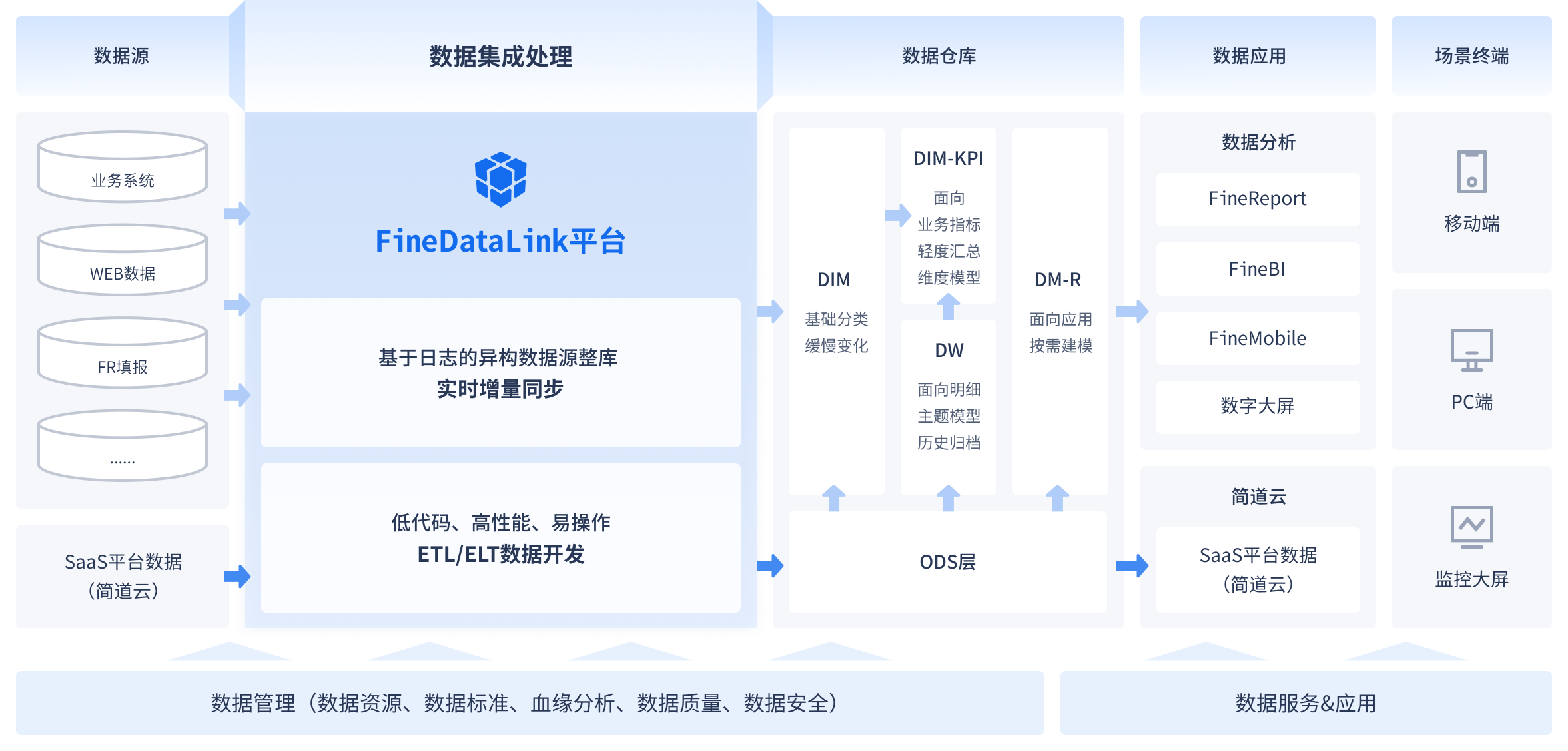

解决这些挑战需要综合考虑技术实现、系统架构和业务需求。FineDataLink作为国产高效的低代码ETL工具,提供了一站式解决方案来应对这些挑战。 FineDataLink体验Demo

🚀 二、实用步骤一:识别变化数据

识别变化数据是增量同步的第一步,也是最关键的一步。我们需要一种可靠的方法来追踪数据的变化,以确保传输的准确性。

1. 使用数据库触发器

触发器是数据库中一种强大的工具,能够在数据变化时自动执行特定操作。通过设置触发器,我们可以实时记录数据的变化。

- 设置触发器:在数据库中创建触发器,监听INSERT、UPDATE、DELETE操作。

- 记录变化:将变化记录到专用表中,以便后续处理。

- 优化触发器:确保触发器不会影响数据库性能,通过索引和查询优化来提升效率。

触发器的使用使得数据变化的识别变得自动化,但需注意对数据库性能的潜在影响。

2. 日志采集与分析

除了触发器,日志采集也是识别变化数据的有效方式。通过分析数据库日志,我们可以获取数据变化的详细信息。

- 配置日志:启用数据库的日志功能,记录所有数据操作。

- 日志分析:使用工具分析日志文件,提取变化数据。

- 高效存储:将分析结果存储在高效的数据库中,便于后续处理。

日志采集与分析为数据变化识别提供了另一种选择,尤其在触发器使用受限的情况下可以作为补充。

3. 数据标记技术

数据标记技术是一种通过给数据打上标记来识别变化的方法。每当数据发生变化时,标记会被更新。

- 标记字段:在数据库表中添加标记字段,记录数据变化的时间戳或版本号。

- 更新标记:在数据变化时更新标记字段。

- 查询增量数据:根据标记字段查询变化数据。

数据标记技术简单易行,适合用于需要快速识别增量数据的场景。

🚀 三、实用步骤二:数据过滤与提取

在识别变化数据后,接下来需要进行数据过滤与提取。高效的数据过滤和提取能够确保增量同步的准确性与速度。

1. 查询优化

查询优化是数据过滤与提取的核心。通过优化查询,我们能够快速获得需要的增量数据。

- 使用索引:为关键字段创建索引,加速查询。

- 优化查询语句:简化查询语句,减少复杂度。

- 缓存机制:在频繁查询的场景中使用缓存机制,减少数据库压力。

查询优化能够显著提升数据提取效率,使得增量同步更为高效。

2. 数据清洗

数据清洗是确保数据质量的重要步骤。在数据提取过程中,我们需要对提取的数据进行清洗以去除冗余和错误数据。

- 格式转换:转换数据格式,确保一致性。

- 去除重复:识别并去除重复数据。

- 异常处理:检测并处理异常数据。

数据清洗不仅提高了数据质量,还使得后续处理更加顺畅。

3. 数据压缩与传输

为了提高传输效率,数据压缩是一个值得考虑的步骤。通过压缩,我们可以减少数据量,加快传输速度。

- 选择压缩算法:选择高效的压缩算法,确保压缩与解压速度。

- 传输协议:选择合适的传输协议,确保数据安全与完整。

- 传输速度监控:监控传输速度,及时进行优化。

数据压缩与传输是实现高效增量同步的最后一步,通过这一环节,我们能够确保数据快速且安全地抵达目标系统。

📈 四、实用步骤三:数据传输与应用

在完成数据过滤与提取后,最后一步便是数据的传输与应用。如何高效地传输数据并在目标系统中正确应用,是实现增量同步的关键。

1. 选择合适的传输工具

选择合适的工具是数据传输的基础。不同的工具在性能、兼容性和安全性方面各有优势。

- 工具评估:根据数据量、传输频率和安全要求选择工具。

- 工具配置:进行工具配置,确保与源系统和目标系统的兼容。

- 传输协议选择:选择符合业务需求的传输协议,如HTTP、FTP等。

合适的传输工具能够确保数据安全快速地抵达目标系统。

2. 数据应用策略

在数据传输到目标系统后,如何应用这些数据是关键。我们需要制定策略来确保数据的正确更新。

- 应用顺序:确定数据应用顺序,避免数据冲突。

- 应用规则:制定数据应用规则,确保数据一致性。

- 应用监控:监控数据应用过程,及时发现并解决问题。

数据应用策略是确保数据在目标系统中正确使用的保障。

3. 实时监控与优化

为了确保数据同步过程的稳定性与效率,实时监控与优化是必要的步骤。

- 系统监控:实时监控系统性能,发现瓶颈。

- 数据验证:定期进行数据验证,确保数据一致性。

- 性能优化:根据监控结果进行性能优化。

实时监控与优化能够确保数据增量同步的持续高效,为业务提供稳定的数据支持。

📚 结论与建议

数据增量同步是提升企业数据处理能力的关键技术。通过识别变化数据、数据过滤与提取、数据传输与应用的步骤,我们可以实现高效的增量同步。FineDataLink作为国产高效的低代码ETL工具,提供了一站式解决方案来应对这些挑战,助力企业的数字化转型。

文献来源:

- 《数据库系统概念》 - 数据库的基础理论与实践。

- 《数据仓库与数据挖掘》 - 数据仓库构建与应用。

- 《大数据管理与分析》 - 大数据处理与管理技术。

实现高效的数据增量同步不仅仅是技术上的突破,更是企业在数据时代立于不败之地的战略选择。通过合理的实施步骤与工具选择,我们能够显著提升数据处理效率,推动企业业务的持续创新与发展。

本文相关FAQs

🚀 如何理解数据增量同步的基本概念?

在企业数字化转型的过程中,数据的实时性变得尤为重要。尤其是当老板提出需要实时获取最新的业务数据时,我们该如何理解数据增量同步呢?有没有大佬能帮忙解释一下这个概念背后的原理和意义呢?

数据增量同步,是指在数据传输过程中,仅传输新增或修改过的数据部分,而不是整个数据集。这在数据量级较大的企业环境中显得尤为重要,因为全量同步不仅耗时,更耗费资源。那么,为什么企业会选择增量同步呢?

背景知识 在传统的数据处理过程中,全量同步的方式不仅会引起网络带宽的消耗,还可能导致系统负载过高,影响其他业务系统的正常运行。尤其是在业务高峰期,频繁的全量数据同步可能会导致数据库锁表、系统响应迟缓等问题。

实际场景 假设一家大型电商平台,每天都会有大量的订单生成。若要实时分析这些订单数据以调整营销策略,使用全量同步将不可避免地拖慢整个分析系统的响应速度。而增量同步则可以在保证数据及时性的同时,极大地减少系统负担。

难点突破 增量同步的难点在于如何高效、准确地捕捉到数据的变化。对于关系型数据库,通常会使用数据库的日志文件(如MySQL的Binlog)来追踪数据变化。而对于非关系型数据库,可能需要借助于特定的API或工具进行增量数据的拉取。

方法建议

- 选择合适的工具:选择支持增量同步功能的数据集成工具,如FineDataLink。这些工具通常能提供较为完整的方案,帮助企业更好地实现数据的高效传输。

- 数据库配置优化:确保数据库配置支持日志捕获,并定期维护和优化数据库索引,以提升数据查询效率。

- 监控与报警:建立完善的监控系统,确保数据同步过程中出现异常时能及时响应。

选择适合的增量同步工具与方案,不仅能够提升数据传输的效率,还能为企业的数据分析与决策提供有力支撑。

📈 数据增量同步的实用步骤有哪些?

在初步了解了数据增量同步的概念后,我想更深入地了解一下具体的操作步骤。有没有哪位有经验的朋友可以分享一下具体的实用步骤和方法呢?

实现高效的数据增量同步,并不是单纯依赖某个工具或方法,而是需要一个系统化的流程与策略。以下是一些关键步骤与方法,供大家参考。

1. 确定数据源与目标 在进行增量同步之前,首先要明确需要同步的数据源和目标数据库。这涉及到数据源的类型(如关系型、NoSQL等)以及目标系统的架构(如数据仓库、数据湖等)。

2. 数据变化捕获 对于关系型数据库,可以使用CDC(Change Data Capture)技术来捕获数据变化。CDC能够实时监控数据库的变更,并将变更数据提取出来供后续处理。对于NoSQL数据库,则需要根据具体的数据库类型选择对应的变化捕获机制。

3. 数据传输优化 在数据传输过程中,需要考虑网络带宽、数据压缩等因素。使用FineDataLink等数据集成平台,可以实现对数据传输过程的优化,包括数据压缩、并行传输等功能。

4. 数据一致性校验 在数据传输过程中,确保数据的一致性是非常重要的。需要根据业务需求,定期进行数据比对与校验,确保源数据与目标数据的一致性。

5. 同步任务调度 使用自动化任务调度工具,定期执行同步任务。FineDataLink等平台通常提供完善的调度功能,可以根据需要设置不同的同步频率与时间。

6. 异常处理机制 在数据同步过程中,可能会出现网络中断、数据冲突等异常情况。需要建立完善的异常处理机制,确保在出现问题时能及时响应与解决。

表格如下:

| 步骤 | 说明 |

|---|---|

| 数据源与目标确定 | 明确需要同步的数据来源和目标系统 |

| 数据变化捕获 | 使用CDC技术或相关API捕获数据库变更 |

| 数据传输优化 | 利用数据集成平台优化数据传输过程,如压缩与并行传输 |

| 数据一致性校验 | 定期校验源与目标数据的一致性,确保数据准确性 |

| 同步任务调度 | 设置自动化调度任务,定期执行同步操作 |

| 异常处理机制 | 建立异常处理流程,及时响应与解决同步过程中出现的问题 |

通过上述步骤,企业可以有效实现数据增量同步,提高数据处理的效率与准确性。

🔍 数据增量同步过程中常见的挑战有哪些?

了解了数据增量同步的基本概念和步骤后,我想知道在实际操作中,增量同步可能会遇到哪些挑战和问题?有没有什么好的解决方案可以参考呢?

在数据增量同步的实际操作过程中,企业往往会遇到多种技术挑战和管理问题。以下是一些常见的挑战及其解决方案:

挑战一:数据变化捕获的复杂性 对于不同类型的数据库,捕获数据变化的方式各不相同。有些数据库可能不直接支持CDC功能,导致数据变化捕获变得复杂。

解决方案 可以借助于成熟的数据集成工具,如 FineDataLink体验Demo ,其支持多种数据库类型,并提供了灵活的配置选项来实现数据变化的捕获。通过这种方式,可以在不同数据库环境下实现高效的数据增量同步。

挑战二:网络传输的不稳定性 在数据传输过程中,网络状况的不稳定可能会导致数据丢失或传输失败,影响同步的准确性和时效性。

解决方案 使用具备断点续传功能的数据集成平台,可以在网络中断后自动恢复数据传输,避免数据丢失。此外,合理规划网络带宽,确保数据传输的稳定性。

挑战三:数据一致性校验的复杂性 在数据量较大时,确保数据一致性需要消耗大量的计算资源和时间。

解决方案 建立基于样本的数据校验机制,通过随机抽样和批量校验相结合的方式,确保数据的一致性。同时,利用分布式计算框架,如Hadoop或Spark,加速数据校验过程。

挑战四:系统资源的消耗 数据同步过程占用大量系统资源,可能影响其他业务系统的正常运行。

解决方案 定期优化数据库索引及配置,确保查询效率,减少资源占用。同时,可以在非业务高峰期安排数据同步任务,降低对系统资源的影响。

通过识别和应对这些挑战,企业可以更好地执行数据增量同步,提高数据管理的整体效率和可靠性。选择合适的数据集成平台和工具,是解决这些问题的关键一步。