在现代商业环境中,企业面临的一个共同挑战是如何有效整合异构数据源。随着数据量的不断增长和数据类型的多样化,许多公司发现传统的数据整合方法已经无法满足其需求。正如我们所见,异构数据源的整合不仅仅是技术上的难题,更是影响企业决策效率和业务推进的重要因素。今天,我们将深入探讨如何克服这些困难,并揭示成功整合异构数据源的秘诀。

为了理解这个问题的核心,我们必须认识到数据整合涉及多个复杂维度,包括数据格式、结构、传输速度和同步效率等。根据《Data Management for Analytics》一书中的统计数据,超过75%的企业在数据整合过程中发现数据格式不一致是最大的障碍之一。这不仅导致数据传输延迟,还影响数据质量和可靠性。那么,专家们是如何解决这一挑战的呢?

🚀 一、异构数据源整合的挑战与解决方案

1. 数据格式与结构不一致

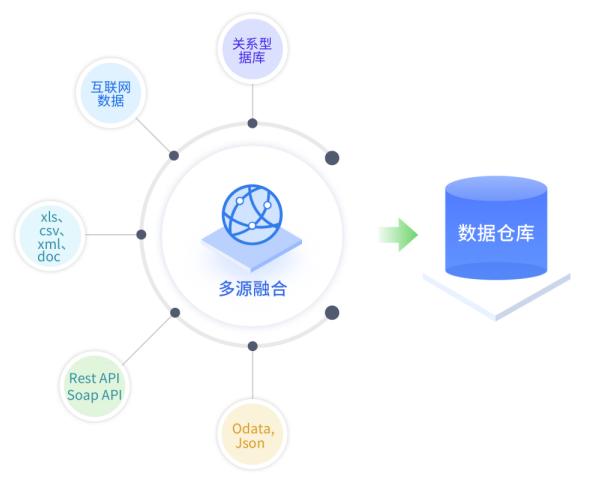

异构数据源整合的首要挑战来自数据格式与结构的不一致。在大多数企业中,数据可能来自多个系统,包括关系型数据库、NoSQL数据库、甚至是实时流数据。这些数据源的结构各异,如何在不影响数据质量的情况下整合它们,是企业必须解决的核心问题。

- 数据格式: 数据格式差异是整合过程中最常见的障碍。传统的ETL工具虽然可以处理一些简单的数据转换,但面对复杂的格式差异时,往往力不从心。

- 数据结构: 不同数据源的结构不一致意味着需要更多的时间和资源来进行数据映射和转换。根据《Big Data Integration》一书的研究,近60%的数据整合项目需要重新设计数据结构来适应新的整合需求。

为了解决这些问题,企业可以采用高效的数据整合工具,如FineDataLink (FDL)。FDL提供了一种简化的低代码解决方案,可以快速适应不同数据源的结构和格式需求,支持实时和离线的数据传输。

| 挑战 | 传统解决方案 | FDL解决方案 |

|---|---|---|

| 数据格式不一致 | 复杂的ETL过程 | 低代码配置,快速适配 |

| 数据结构不一致 | 重构数据结构 | 灵活映射,实时同步 |

| 数据质量问题 | 手动数据清洗 | 自动化数据治理 |

2. 数据传输速度与同步效率

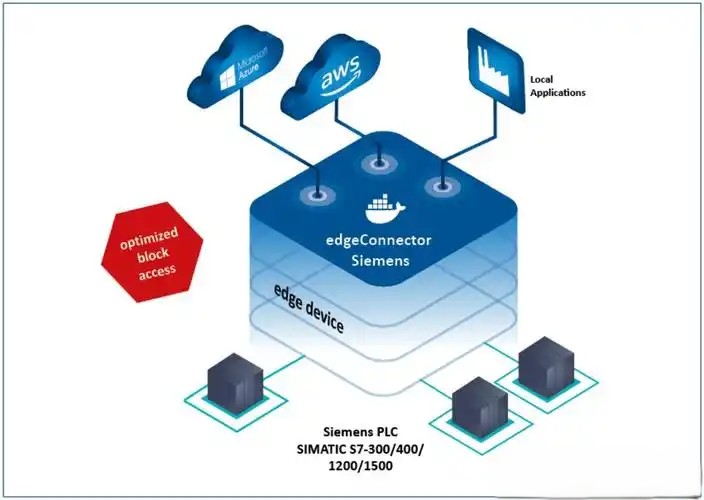

数据传输速度和同步效率对于实时业务决策至关重要。企业需要能够快速同步大量数据,以支持实时分析和响应。然而,传统的数据同步方法通常在速度和效率上存在不足。

- 实时性要求: 随着业务需求的变化,实时数据传输已成为企业的基本要求。根据《Real-time Data Warehousing》文献,超过80%的企业希望实现实时数据同步,以支持动态决策。

- 同步效率: 在数据量巨大时,传统的批量同步方式可能导致数据传输延迟和资源浪费。根据研究,使用批量同步的企业平均需要多达30%的额外资源来处理同步延迟。

FineDataLink在这方面提供了强大的支持。它通过高效的数据传输协议和智能同步机制,能够确保数据在最短时间内传输,并且无需额外资源投入。它不仅支持全量同步,还能智能地进行增量同步,进一步提高效率。

- 实时数据传输

- 高效增量同步

- 智能资源管理

3. 数据质量与可靠性

数据质量是影响整合效果的重要因素。低质量的数据不仅会误导决策,还可能导致企业资源的浪费。确保数据的高质量和可靠性是整合异构数据源的关键。

- 数据清洗: 数据整合前的清洗是必不可少的步骤。根据《Data Quality Management》研究,数据清洗可以提高整合效率和质量。

- 数据验证: 数据整合后的验证确保数据的准确性和一致性,是确保整合成功的最后一步。

通过FineDataLink,企业可以实现自动化的数据治理,确保数据的高质量和可靠性。FDL内置的数据验证机制可以在整合过程中自动检测和修复数据问题,保障数据的一致性和准确性。

📊 二、成功整合异构数据源的策略

1. 建立统一的数据标准

成功整合异构数据源的第一步是建立统一的数据标准。在数据整合过程中,不同数据源的标准化处理是保持数据一致性的重要手段。根据《Standardizing Data Integration》文献,统一的数据标准可以提高整合效率和数据质量。

- 标准化数据格式: 采用统一的数据格式可以减少数据转换过程中的复杂性。

- 标准化数据结构: 统一的数据结构有助于提高数据的可读性和一致性。

FineDataLink提供了灵活的配置选项,帮助企业快速建立统一的数据标准。通过简单的配置,企业可以轻松实现数据格式和结构的标准化,减少整合过程中的障碍。

| 策略 | 优势 | FDL支持 |

|---|---|---|

| 数据格式标准化 | 降低转换复杂性 | 灵活配置,快速适配 |

| 数据结构标准化 | 提高数据一致性 | 自动化映射,实时同步 |

| 数据质量控制 | 确保数据可靠性 | 内置治理机制,自动验证 |

2. 实施自动化的数据治理

自动化的数据治理是提高数据整合效率的重要策略。通过自动化工具,企业可以减少人为错误,提高数据的可靠性。

- 自动数据清洗: 自动化工具可以快速识别并修复数据中的问题,提高数据质量。

- 自动数据验证: 在数据整合后进行自动验证,确保数据的准确性和一致性。

FineDataLink通过内置的数据治理工具提供自动化的数据清洗和验证功能。企业可以通过FDL实现数据的自动化治理,确保数据的高质量和可靠性。

- 自动化数据清洗

- 自动化数据验证

- 智能数据治理

3. 优化数据传输与同步机制

优化数据传输和同步机制是提高整合效率的重要策略。在数据量巨大的情况下,优化传输和同步机制可以显著提高整合速度。

- 高效传输协议: 采用高效的数据传输协议可以减少传输时间和资源消耗。

- 智能同步机制: 通过智能同步机制,可以实现实时增量同步,提高整合效率。

FineDataLink通过先进的传输协议和智能同步机制提供高效的数据整合解决方案。企业可以通过FDL优化数据传输和同步,提高整合效率。

| 优化策略 | 传输效率 | FDL支持 |

|---|---|---|

| 高效传输协议 | 降低传输时间 | 先进协议,快速传输 |

| 智能同步机制 | 提高同步效率 | 自动增量同步,智能管理 |

| 资源优化 | 节省资源消耗 | 自动化资源调度,智能分配 |

📈 结论与未来展望

成功整合异构数据源对于企业的数字化转型至关重要。通过采用统一的数据标准、实施自动化数据治理和优化数据传输与同步机制,企业可以显著提高整合效率和数据质量。FineDataLink作为一款高效实用的低代码ETL工具,为企业提供了一站式的数据整合解决方案,帮助企业轻松应对复杂的整合挑战,支持业务的快速发展。

在未来,随着数据量的进一步增长和数据类型的不断丰富,企业需要不断优化数据整合策略,以适应新的业务需求。FineDataLink将继续发挥其优势,助力企业实现高效的数据整合和数字化转型。

参考文献:

- 《Data Management for Analytics》

- 《Real-time Data Warehousing》

- 《Standardizing Data Integration》

本文相关FAQs

🤔 异构数据源整合难?如何高效地进行实时数据同步?

我在企业数字化转型中遇到一个大难题:异构数据源整合。老板要求我们对接各种数据库,实现高效的实时数据同步,但数据量大、表结构复杂,传统的批量定时同步效率太低,增量同步更是难上加难。有没有大佬能分享一下高效整合异构数据源的方法?

整合异构数据源确实是企业数字化转型中的一大挑战。首先,可以先了解不同数据源的特性,比如它们的连接方式、数据格式、访问协议等。这些因素直接影响整合策略的选择。传统的批量定时同步方式在数据量小、更新频率低的情况下是可行的,但在数据量大、实时性要求高的场景下就显得力不从心。

为了高效进行实时数据同步,可以考虑以下几点:

- 选择合适的工具:像FineDataLink(FDL)这样的平台可以帮助企业实现对多种数据源的实时同步。FDL支持单表、多表、整库的实时同步,并能根据数据源适配情况进行配置。

- 实现增量同步:通过监控数据源的变更记录,实现对数据的增量采集。这样可以大幅减少数据传输量,提高同步效率。

- 优化数据传输:利用数据压缩、分片传输等技术,降低网络传输的压力。

- 合理设计数据模型:在目标数据库中设计合理的数据模型,避免不必要的数据冗余和复杂的表关联。

使用FDL这样的平台,企业可以通过一个平台完成数据采集、集成、调度和治理的工作,为业务提供稳定的数据支持和快速响应能力。点击这里体验一下: FineDataLink体验Demo 。

💡 如何在异构数据源整合中确保数据质量和一致性?

在整合异构数据源的过程中,我发现一个棘手的问题是数据质量和一致性。不同的数据源可能会有不同的格式、编码、标准,甚至同一数据在不同来源会有不同的表现形式。这种情况下,如何在整合过程中确保数据质量和一致性?

确保数据质量和一致性是异构数据源整合的核心挑战之一。不同的数据源可能使用不同的编码格式、存储标准,甚至在数据类型、时间格式上都存在差异。为了解决这些问题,可以考虑以下策略:

- 数据标准化:在数据进入目标系统前,对数据进行标准化处理。包括统一编码、格式转换、字段映射等。例如,将所有日期格式转为ISO标准。

- 数据清洗:对于不同来源的数据进行清洗,去除重复、不完整或不一致的数据。可以通过编写脚本或使用数据清洗工具来实现。

- 数据验证与校验:在数据整合过程中,设置数据校验规则,对数据进行实时验证。确保数据在传输过程中没有丢失或被篡改。

- 使用数据治理工具:像FDL这样的集成平台,通常会提供数据质量管理功能。可以自动化地进行数据清洗、标准化和验证。

- 实施数据治理策略:建立一套全面的数据治理策略,涵盖数据采集、存储、处理和分析的各个环节。确保数据在生命周期各个阶段的一致性和完整性。

通过这些方法,可以在异构数据源整合过程中有效提高数据质量和一致性,为后续的分析和决策提供可靠的数据支持。

🚀 在整合异构数据源的过程中,如何应对性能瓶颈?

整合异构数据源的过程中,我遇到了性能瓶颈的问题。随着数据量的增加,整合过程变得越来越慢,甚至影响到业务的正常运作。有没有什么方法可以优化整合过程中的性能?

在异构数据源整合时,性能瓶颈是一个常见的问题。数据量大、数据源多样化、实时性要求高等因素都会影响整合效率。为了应对性能瓶颈,可以从以下几个方面进行优化:

- 并行处理:利用并行处理技术,分批对不同的数据源进行同步,从而充分利用服务器资源,提高处理效率。

- 数据分区:对数据进行分区处理,尤其是在大数据场景下,可以根据数据的特性进行水平或垂直分区,减少单次数据处理的负担。

- 使用缓存技术:通过引入缓存技术,减少对源数据的频繁访问,提高访问速度。缓存可以在内存或本地磁盘中存储常用数据。

- 优化数据库查询:优化数据库查询语句,合理使用索引,减少不必要的全表扫描,缩短查询时间。

- 选择合适的集成工具:使用FineDataLink(FDL)这样的工具,可以实现高效的数据同步和调度。FDL支持多种数据源的实时同步,具备良好的性能优化能力。

通过这些策略,可以有效提升异构数据源整合过程中的性能,确保业务的顺利进行。企业在选择数据集成平台时,应考虑其性能优化能力和对异构数据源的支持情况。