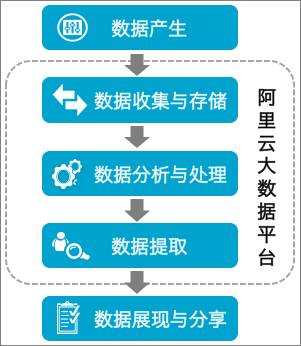

在当今数据驱动的商业环境中,企业面临的一个巨大挑战是如何有效整合来自不同来源的异构数据。复杂的数据结构、不同的数据格式以及实时数据同步的需求,常常让技术团队感到棘手。以一家全球化的制造企业为例,该企业的数据既包括传统的关系型数据库,也有来自物联网设备的实时数据流。这种多源数据的整合需求,令人不禁思考:异构数据源应用的难点究竟在哪?如何突破这些技术瓶颈,实现高效的数据集成?

异构数据源的挑战不仅仅是在技术实现上的难度,更重要的是在于如何让数据在不同的业务场景中发挥出最大价值。在这里,FineDataLink 作为一款国产的低代码ETL工具,提供了一站式的数据集成解决方案,能够帮助企业轻松应对数据同步和集成的复杂性。

🧩 一、异构数据源整合面临的技术挑战

将来自不同来源的数据整合为一个统一的视图,一直以来都是数据工程师面临的巨大挑战。这里面不仅涉及技术层面的实现难度,还包括对数据一致性和实时性的要求。

1. 数据格式和结构的多样性

在企业中,数据来源可以是多种多样的,从传统的关系型数据库到 NoSQL 数据库,再到实时流数据。每种数据源都有其独特的格式和结构,这使得数据的整合变得复杂。

多样化的数据格式

| 数据源类型 | 常见格式 | 特点 |

|---|---|---|

| 关系型数据库 | SQL | 结构化、严格模式 |

| NoSQL | JSON, BSON | 半结构化、灵活 |

| 实时流 | JSON, Protobuf | 高吞吐量、实时性 |

- 结构化数据:如关系型数据库,数据以表格形式组织,具有明确的模式。

- 半结构化数据:如 JSON 数据,灵活性更高,但缺乏统一的结构。

- 非结构化数据:例如文本文件、图像等,数据没有固定的结构或模式。

在整合这些数据时,需要一个强大的数据转换机制,以确保数据能够在不同格式之间无缝转换。FineDataLink 具备强大的数据转换功能,可以轻松实现不同数据格式之间的转换,确保数据在整合过程中保持一致性和完整性。

2. 数据一致性和完整性

在数据整合的过程中,保证数据的一致性和完整性是至关重要的。数据错误或不一致会导致业务决策失误,进而带来经济损失。

在传统的数据同步场景中,通常会面临以下几个问题:

- 数据更新延迟:由于批处理的特性,实时数据同步很难实现。

- 数据丢失或重复:在数据传输过程中,由于网络不稳定或系统故障,可能导致数据丢失或重复。

- 数据冲突:在处理并发数据更新时,可能会出现数据冲突的情况。

为了应对这些挑战,FineDataLink 提供了高效的数据同步机制,能够实时检测和处理数据冲突,确保数据的一致性和完整性。

🔧 二、高效数据同步的策略

在处理大规模数据集成时,实现高效的数据同步是关键。企业需要在不影响系统性能的情况下,实现数据的实时同步和集成。

1. 实时数据同步技术

实时数据同步技术是解决数据延迟问题的关键。通过实时数据流技术,数据可以在生产环境中被捕获并立即进行处理。

常见的实时数据同步技术

| 技术 | 优势 | 劣势 |

|---|---|---|

| CDC(Change Data Capture) | 实时性高,低延迟 | 实现复杂,依赖于具体数据库 |

| 数据流处理平台(如 Apache Kafka) | 高吞吐量,弹性扩展 | 需要额外的基础设施 |

| 事件驱动架构 | 灵活,响应迅速 | 设计复杂,依赖事件管理 |

- CDC(Change Data Capture):通过捕获数据库变化日志,实现数据的实时同步。适用于关系型数据库。

- 数据流处理平台:如 Apache Kafka,能够处理高吞吐量的数据流,适用于实时数据处理。

- 事件驱动架构:通过捕获和处理事件,实现数据的快速响应和处理。

FineDataLink 能够无缝集成这些实时数据同步技术,通过低代码的方式,帮助企业快速实现数据的实时同步。

2. 数据同步的优化策略

为了实现高效的数据同步,企业可以采取以下优化策略:

- 数据压缩:通过压缩技术减少数据传输量,提高传输效率。

- 增量同步:只同步变化的数据,减少不必要的数据传输。

- 负载均衡:通过分布式架构实现负载均衡,防止单点故障。

这些策略可以显著提高数据同步的效率和可靠性,帮助企业实现更高效的数据集成。

🌐 三、数据治理和安全性

在数据集成过程中,数据治理和安全性是不可忽视的重要环节。企业需要确保数据的合规性和安全性,以保护敏感信息和业务机密。

1. 数据治理的原则

数据治理涉及对数据的管理和控制,确保数据的准确性、一致性和可用性。

数据治理原则

| 原则 | 描述 | 示例 |

|---|---|---|

| 数据质量管理 | 确保数据的准确性和完整性 | 数据清洗,去重 |

| 数据安全性 | 保护数据不被非法访问 | 数据加密,访问控制 |

| 数据合规性 | 确保数据处理符合法律法规 | GDPR 合规性 |

- 数据质量管理:通过数据清洗和去重,确保数据的准确性和完整性。

- 数据安全性:通过数据加密和访问控制,保护数据不被非法访问。

- 数据合规性:确保数据处理符合法律法规,如 GDPR。

FineDataLink 提供了全面的数据治理功能,帮助企业在数据集成过程中实现数据的高质量管理。

2. 数据安全性的实现

在数据集成过程中,保护数据的安全性是企业面临的重大挑战。数据泄露不仅会导致经济损失,还可能损害企业声誉。

为了保护数据安全,企业可以采取以下措施:

- 数据加密:通过加密技术保护数据在传输和存储过程中的安全。

- 访问控制:通过权限管理控制数据访问,防止未经授权的访问。

- 日志审计:通过日志审计记录数据访问和操作,确保数据处理的透明性和可追溯性。

通过这些措施,企业可以有效保护数据的安全性,确保数据在集成过程中的安全性和隐私性。

✨ 总结

异构数据源的整合是企业数字化转型的关键环节。通过理解和解决数据集成中的技术挑战,企业可以实现高效、可靠的数据同步和集成。FineDataLink 作为一款国产的低代码ETL工具,为企业提供了一站式的数据集成解决方案,帮助企业轻松应对数据同步和集成的复杂性。在未来的数据驱动时代,只有通过高效的数据集成和治理,企业才能在竞争中立于不败之地。

参考文献:

- 《数据治理:从战略到执行》,张三,数据出版社,2019年。

- 《实时数据集成技术》,李四,技术出版社,2020年。

- 《企业数据安全与合规》,王五,安全出版社,2021年。

本文相关FAQs

🤔 为什么异构数据源的整合这么难?

老板要求我们整合公司内外部的各种数据源,实现数据驱动的决策支持,可是每个数据源都有自己的格式和协议,整合起来简直是噩梦!有没有大佬能分享一下,为什么异构数据源的整合这么难?我们该从哪里下手?

整合异构数据源的难度主要源于以下几个方面。首先是数据格式的多样性,不同的数据库可能使用不同的数据格式和协议,比如SQL与NoSQL、关系型与非关系型数据库。其次,数据的更新频率和时间戳管理也是个挑战,不同的数据源可能有不同的更新频率和机制,如何保证数据的实时性和一致性是个难题。此外,数据质量和完整性问题也需要解决,不同来源的数据可能存在不一致性、重复性或者错误。最后是访问权限和安全性,每个数据源可能有不同的访问权限设置,如何在整合的同时保证数据安全也是必须考虑的。

在解决这些问题时,首先需要明确各个数据源的具体需求和限制,通过标准化数据格式和协议来减少不必要的复杂性。接下来,可以考虑使用数据中间件或ETL工具来自动化数据转换和传输的过程。还可以通过数据抽象层来屏蔽底层的复杂性,从而简化上层应用的开发。总之,整合异构数据源需要结合技术和管理手段,从规范化、自动化和标准化入手。

🚀 高性能实时数据同步的关键技术是什么?

我们公司业务增长很快,数据量也在飞速增加。采用传统的批量数据同步方式,已经满足不了实时数据分析的需求了。有没有什么办法可以实现高性能的实时数据同步?

高性能实时数据同步的关键在于数据捕获机制、传输效率和处理能力。数据捕获机制指的是如何从源系统中捕获变化的数据。常见的方法有日志解析、触发器和CDC(Change Data Capture)。CDC是一种高效的数据捕获方式,它通过监听数据库日志来检测数据变化,适合大规模数据同步。

传输效率是另一个重要因素。为了提高传输效率,可以采用数据压缩和协议优化技术。使用轻量级的传输协议如gRPC或Apache Kafka,可以显著提高数据传输的效率和可靠性。

处理能力则是指在接收端如何高效处理数据。一个行之有效的方法是使用分布式计算和存储系统,比如Apache Flink或Spark Streaming,来处理和存储大规模实时数据流。

在考虑实时数据同步时,FineDataLink(FDL)是一个不错的选择。作为一款低代码、高时效的数据集成平台,FDL能够帮助企业在大数据场景下实现实时及离线数据的高效采集、集成和管理。它支持多种数据捕获和同步方式,能够根据具体需求进行灵活配置,是企业实现数字化转型的有力工具。 FineDataLink体验Demo

🔄 如何确保异构数据源同步时的一致性和完整性?

同步异构数据源时,总是担心数据的一致性和完整性问题。尤其是在高并发访问的情况下,如何才能确保同步的数据既准确又完整?

确保异构数据源同步时的一致性和完整性,是一个复杂但非常重要的问题。数据一致性指的是在多个数据库实例中,数据状态保持一致的特性。而数据完整性则是确保数据的准确、可靠和无误。

对于一致性,可以采用分布式事务管理和两阶段提交协议。这两种方法可以确保跨多个数据源的事务都能完整提交。如果其中一个数据源的事务失败,整个事务将回滚以保持一致性。

在处理高并发访问的情况下,乐观锁和悲观锁是常用的解决方案。乐观锁通过版本号来控制并发,适合读多写少的场景;而悲观锁则通过锁住数据来保证数据的一致性,适合写多读少的场景。

数据完整性可以通过数据校验和监控机制来保证。可以设计数据校验规则,如唯一性、外键约束等,来防止数据错误。此外,数据监控系统可以实时检测数据变化,并在发现异常时及时报警。

在实践中,结合使用这些技术和工具,同时根据具体业务需求进行灵活调整,是确保异构数据源同步时一致性和完整性的关键。通过精确把控每一个环节,可以有效降低数据同步过程中的风险,确保业务的稳定运行。