在每个企业的数据处理过程中,效率和准确性是两大关键因素。然而,许多企业仍然面临着复杂的数据处理挑战:数据量庞大、实时同步困难、以及繁琐的手动管理。这些挑战可能会导致低效的工作流程,并最终影响企业的整体表现。因此,了解数据处理的标准流程并优化工作效率显得尤为重要。

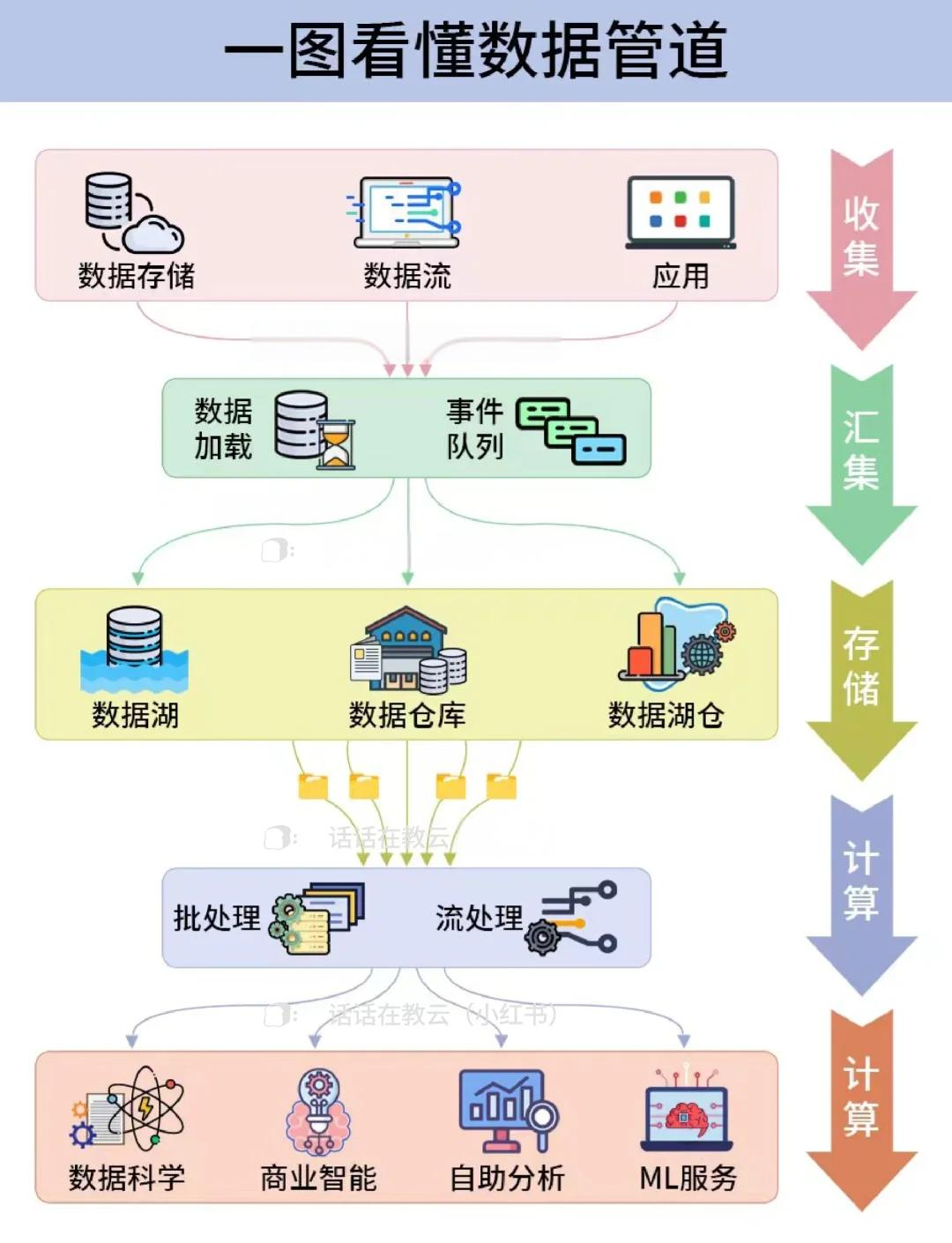

📊 数据处理的标准流程

数据处理是任何企业数据管理的核心环节。标准化的数据处理流程不仅可以帮助企业简化操作,还能确保数据的准确性和可靠性。

1️⃣ 数据收集和导入

数据收集是数据处理的第一步。企业需要从各种来源收集数据,包括客户信息、销售记录和市场分析等。这个过程要求高效的工具和方法,以确保数据的完整性和及时性。

- 数据源多样性:企业可能需要处理来自数据库、第三方应用程序、传感器数据等各类信息。

- 数据格式兼容性:处理来自不同格式的数据(如CSV、JSON、XML等)。

- 数据导入工具:使用自动化工具将数据导入到企业数据仓库。

表格:数据收集工具对比

| 工具名称 | 优势 | 劣势 |

|---|---|---|

| 手动导入 | 简单直接 | 时间耗费大,容易出错 |

| 自动化工具 | 高效,减少人为错误 | 初始设置复杂,需技术支持 |

| FineDataLink | 实时数据同步,支持多格式 | 初期学习曲线 |

2️⃣ 数据清理和预处理

在数据收集之后,清理和预处理是关键步骤。未经处理的数据可能包含错误、重复值或不完整的信息,这些都会影响最终分析结果。

- 错误检测与修正:识别并修正数据中的错误或异常值。

- 重复数据剔除:消除数据集中重复的记录。

- 数据标准化:将数据转换为一致的格式和单位,以便于分析。

3️⃣ 数据存储和管理

数据存储是数据处理的核心,它不仅涉及存储空间的选择,还包括数据的安全性和访问效率。

- 存储解决方案选择:根据数据量选择适合的数据库或数据仓库。

- 安全性与备份:确保数据保护措施到位,定期进行数据备份。

- 访问权限管理:控制数据访问权限,以保护敏感信息。

表格:存储解决方案对比

| 解决方案名称 | 优势 | 劣势 |

|---|---|---|

| 本地存储 | 直接控制,安全性高 | 扩展性差,成本高 |

| 云存储 | 高扩展性,成本灵活 | 安全性需额外保障 |

| FineDataLink | 低代码管理,实时同步 | 需初期配置和学习 |

🚀 优化工作效率的实用指南

为了进一步提高数据处理效率,企业需要采用一系列优化策略,从工具选择到流程管理。

1️⃣ 工具自动化和集成

选择合适的自动化工具可以极大地提升工作效率。这些工具能够简化复杂的操作,减少人为错误,并加速数据处理速度。

- 自动化工具选择:选择能够自动化重复任务的工具,如FineDataLink。

- 集成现有系统:确保新工具能够无缝集成现有系统和流程。

- 持续监控与调整:根据使用反馈不断调整和优化工具配置。

2️⃣ 流程标准化和简化

标准化流程能够帮助企业理清工作步骤,减少在复杂任务上耗费的时间和资源。

- 流程图绘制:绘制详细的流程图,明确每个步骤和相关责任。

- 任务分配与协调:明确任务分配,确保团队协作顺畅。

- 定期流程审核:定期审核和优化流程,以适应业务变化。

3️⃣ 团队协作与培训

提升团队整体效率需要有效的沟通和培训机制,以确保所有成员都能快速适应新的工具和流程。

- 培训计划制定:制定详细的培训计划,覆盖工具使用和流程理解。

- 跨部门协作:促进跨部门协作,提高信息共享和沟通效率。

- 反馈机制建立:建立反馈机制,及时解决团队遇到的问题和挑战。

表格:团队培训效果评估

| 评估指标 | 描述 | 重要性 |

|---|---|---|

| 团队理解度 | 团队对新工具和流程的理解程度 | 高 |

| 问题解决能力 | 团队解决数据处理问题的能力 | 高 |

| 协作效率 | 团队成员间的协作效率 | 中 |

📚 结论与推荐

通过本文,我们探讨了数据处理的标准流程以及优化工作效率的实用指南。企业需要在数据收集、清理、存储和管理上采用标准化流程,并通过自动化工具和团队协作来提高效率。FineDataLink作为一款国产高效低代码工具,为企业在大数据场景下的数据处理提供了强有力的支持。

阅读相关文献以获取更多信息:

- 《大数据处理与分析》——提供了关于数据处理的深入洞察。

- 《企业数据管理指南》——详细讲解了企业数据处理的最佳实践。

- 《数字化转型与效率提升》——探讨了数字化工具如何优化工作效率。

综上所述,掌握数据处理的标准流程并持续优化工作效率,对企业的成功至关重要。通过合理的工具选择和流程管理,企业能够更好地应对数据挑战,实现高效运营。

本文相关FAQs

🤔 数据处理的标准流程是什么?新人入门指南

作为一名刚入门的数据分析师,我被要求负责处理大量业务数据,但对标准流程不是很清楚。有没有大佬能分享一下,数据处理的一般步骤应该怎么走?从数据接收到可以用来做分析,这中间有什么需要特别注意的地方?

数据处理的标准流程就像烹饪一顿大餐,每个步骤都至关重要。首先,我们需要数据收集。这一步是关于连接数据源并获取原始数据。常见的数据源包括数据库、文件、API等。选择合适的工具和方法,比如Python的Pandas库或SQL查询,是关键。

接下来是数据清洗。这一步需要你将数据中的错误、重复、缺失值去除掉。就像厨房里的食材准备,清洗干净才能下锅。数据清洗的工具有很多,比如OpenRefine、Trifacta等。

然后是数据转换。这一步需要你将数据转换成分析所需的格式。可能需要对数据进行聚合、变换或衍生变量的创建。ETL工具(Extract, Transform, Load)在这一步非常有用。

数据存储则是将处理好的数据存入数据仓库或数据库中,以备后续分析和报告。有时候需要考虑云存储方案,如AWS Redshift、Google BigQuery等。

最后是数据分析。这是整个流程的高潮部分,通过使用统计软件(如R、Python)或BI工具(如Tableau、Power BI),你可以从数据中提炼出有价值的信息和见解。

注意事项:每一步都需要根据具体的业务需求进行定制化处理,确保处理后的数据准确无误,并能真实反映业务情况。整个过程的自动化是提升效率的关键。

🛠 如何优化数据处理流程?提高工作效率的实用技巧

老板要求我们提升数据处理效率,以便更快地做出数据驱动的决策。有没有哪些实用的技巧可以帮助优化数据处理流程?尤其是在面对海量数据时,如何避免掉坑?

优化数据处理流程的关键在于自动化和智能化。对于企业而言,手动操作不仅效率低下,还容易出错。以下是一些提升效率的实用技巧:

1. 自动化工具的使用:使用自动化脚本或工具来处理重复性任务。Python和R都有很强的脚本处理能力,而像Apache NiFi这样的工具可以进行更复杂的流程自动化。

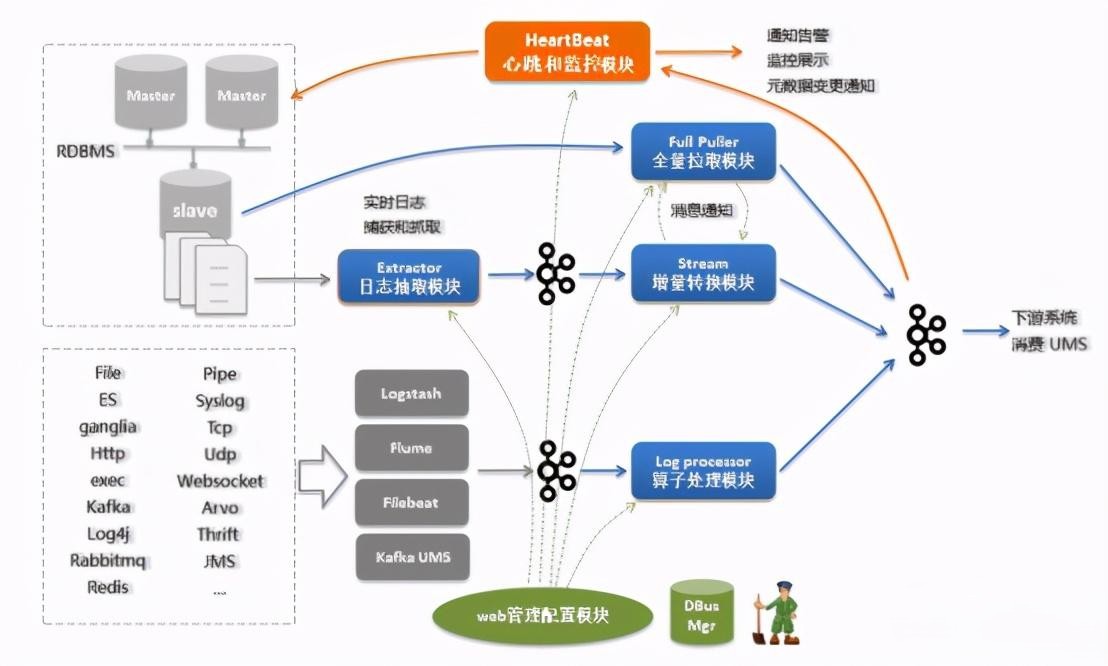

2. 实时数据处理:当面对大量数据时,实时处理比批量处理更高效。流处理平台如Apache Kafka、Apache Flink可以帮助实现这一点。对于企业级应用,可以考虑使用 FineDataLink体验Demo 这样的低代码平台来简化数据集成和处理。

3. 数据存储优化:选择合适的数据存储方案。NoSQL数据库(如MongoDB、Cassandra)在处理大规模数据时更具优势,而云解决方案提供弹性存储。确保数据库的索引和架构设计合理,以便加快查询速度。

4. 数据清洗与预处理:使用AI和机器学习技术进行智能数据清洗和预处理,可以大幅提高效率。工具如DataRobot、Google Cloud AutoML在这方面提供了很多便利。

5. 团队协作与流程文档化:确保团队成员之间的协作顺畅,流程清晰并文档化。这样即便是新成员也能快速上手,减少因人员变动带来的效率降低。

通过以上方法,你可以显著提升数据处理的效率,实现快速响应业务需求的目标。

🚀 如何应对数据处理中的实时同步挑战?深入解析

企业在进行数据处理时,经常遇到实时数据同步的瓶颈,尤其是数据量大且表结构复杂的情况下。有没有什么好的解决方案能有效应对这种挑战?

实时数据同步是现代企业数据处理中的一大难题,尤其是在数据量大且复杂的情况下。传统的批量同步方法往往无法满足实时性的要求,而简单的清空再写入策略又导致目标表的不可用时间过长。那么,如何应对这些挑战呢?

1. 数据流处理平台的应用:对于需要高频数据更新的场景,引入数据流处理平台是一个不错的选择。平台如Apache Kafka、Apache Flink提供了强大的实时数据处理能力,能够以流的方式处理数据更新。

2. 增量同步策略:相比全量同步,增量同步更为高效。通过记录数据变化日志(CDC - Change Data Capture)实现增量数据的捕获和同步,可以显著提升同步效率。工具如Debezium专注于这方面的解决方案。

3. 数据同步平台的使用:企业可以选择集成平台如 FineDataLink体验Demo ,其低代码特性使得配置实时同步任务变得简单。FDL支持多种同步模式,无论是单表还是多表、整库同步,都能灵活应对。

4. 数据库优化:确保数据库设计的合理性,创建合适的索引,优化查询性能,以减少同步的压力和时间。使用分布式数据库架构也有助于提升性能。

5. 网络和基础设施:实时同步对网络和服务器有较高的要求,确保网络带宽充足,服务器性能强劲,能够支持高并发的读写操作。

通过这些方法,你可以有效地应对实时数据同步中的挑战,确保数据的实时性和一致性,为业务决策提供及时准确的数据支持。