在当今数据驱动的世界中,企业面临着一个重要的挑战:如何高效地利用海量数据来获取洞察,推动业务增长。数据管道和数据仓库之间的有效协作成为解决这一挑战的关键。想象一下,一个全球电子商务平台每天产生海量数据,如何将这些数据无缝地从各个来源传输到最终的分析平台,这是一个企业能否快速响应市场变化的关键所在。本文将深入探讨数据管道与数据仓库如何协作的流程,通过细致分析和实例一同揭开这层神秘的面纱。

🌀 一、数据管道与数据仓库协作的核心流程

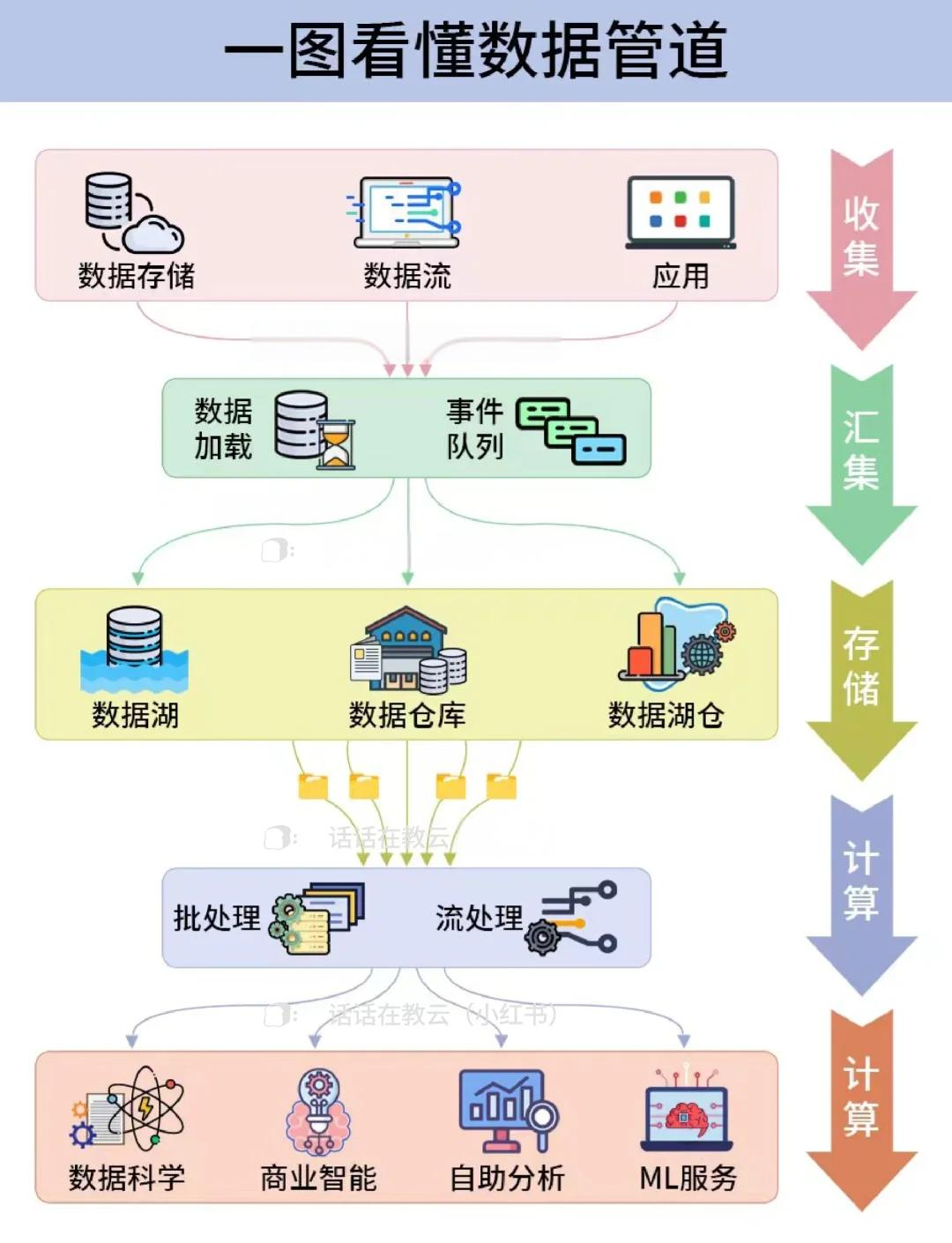

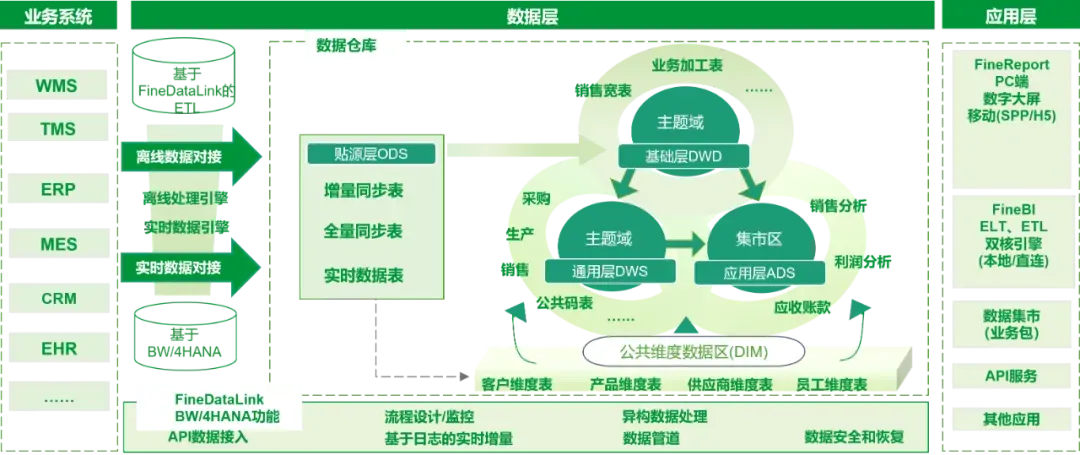

数据管道是一个将数据从源头传输到目标位置的自动化流程,而数据仓库则是用于存储和管理大量数据的系统。两者的协作流程可以通过以下几个关键步骤来实现。为了更好的理解,我们可以用一个简化的表格来初步概括:

| 步骤 | 数据管道功能 | 数据仓库功能 |

|---|---|---|

| 1 | 数据采集 | 数据接收 |

| 2 | 数据转换 | 数据存储 |

| 3 | 数据加载 | 数据分析 |

1. 数据采集与接收

数据采集是数据管道的第一步,旨在从不同的数据源(如数据库、API、文件系统等)收集原始数据。举个例子,一个在线零售商可能需要从其网站、移动应用和社交媒体平台获取用户行为数据。这些数据可能以结构化或非结构化的形式存在,数据管道需要具备足够的灵活性来处理不同类型的数据源。

在这个过程中,FineDataLink可以作为一个值得考虑的工具。它能够轻松地连接多种数据源,并支持实时数据同步,确保数据采集的准确性和时效性。

而数据接收则是数据仓库的第一项任务。数据仓库需要为数据的到来准备好存储空间,并根据业务需求对数据进行初步的分类和整理。现代数据仓库如Amazon Redshift、Google BigQuery等,能够处理大量的并发数据接入请求,确保数据在进入仓库时不会造成延迟。

2. 数据转换与存储

在数据成功采集和接收之后,数据转换成为下一个重要步骤。数据转换通常涉及清洗、标准化、聚合等多个子步骤,以确保数据的一致性和准确性。比如,将不同格式的时间戳统一成一种格式,或者将不同来源的货币转换成相同的汇率。

数据仓库在这一阶段的工作则是数据存储。在数据被转换为适合分析的格式后,数据仓库将其存储在特定的表格或分区中,以便于后续的检索和分析。此过程中,数据仓库会应用压缩算法来减少存储空间,并可能对数据进行索引以提升查询效率。

3. 数据加载与分析

最后一步是数据加载,即将转换后的数据传输到数据仓库中。这一过程需要确保数据的完整性和一致性。在传统的ETL(提取、转换、加载)流程中,数据加载往往是一个批处理过程,但随着实时数据分析需求的增加,许多企业开始采用ELT(提取、加载、转换)流程,以便在数据进入仓库后再进行转换。

一旦数据成功加载到数据仓库,便进入数据分析阶段。数据仓库提供了强大的查询功能,支持复杂的分析和报表生成。企业可以利用这些功能进行深入的数据挖掘,生成有价值的商业洞察。

🔄 二、数据管道与数据仓库协作的主要挑战

尽管数据管道与数据仓库的协作流程看似简单,但在实际操作中,企业往往会面临各种挑战。以下是一些常见的问题以及可能的解决方案。

| 挑战 | 原因 | 解决方案 |

|---|---|---|

| 数据质量 | 数据源不可靠 | 数据清洗与验证 |

| 数据延迟 | 网络带宽限制 | 实时数据同步 |

| 系统复杂性 | 技术栈多样 | 低代码平台 |

1. 数据质量问题

数据质量是所有数据驱动项目的基础。低质量的数据将直接影响分析结果的准确性和可靠性。在数据管道的采集阶段,数据质量问题常常由于数据源不一致、数据录入错误或数据丢失而产生。

为了解决数据质量问题,企业需要在数据管道中实施严格的数据清洗和验证流程。这可能包括格式验证、重复数据删除、异常数据检测等。值得一提的是,FineDataLink可以帮助企业在数据采集阶段就对数据进行初步清洗,确保进入数据仓库的数据质量。

2. 数据延迟问题

随着实时分析需求的增加,数据延迟问题变得愈发显著。传统的批处理方式可能导致数据分析滞后,从而影响业务决策的及时性。

为了解决数据延迟问题,企业可以采用实时数据同步技术,以便迅速处理数据更新。FineDataLink支持对数据源的实时同步,可以有效减少数据传输的延迟,确保数据仓库中的数据始终是最新的。

3. 系统复杂性问题

在实施数据管道和数据仓库协作时,企业常常会面临技术栈复杂性的问题。这可能是由于多种不同的工具和平台相互集成所致,导致维护和管理的成本增加。

低代码平台如FineDataLink,通过提供统一的接口和简化的操作流程,能够有效降低系统的复杂性,使企业可以专注于数据分析本身,而无需过多关注底层技术的集成问题。

🔍 三、数据管道与数据仓库协作的最佳实践

为了确保数据管道与数据仓库之间的高效协作,企业可以遵循一些最佳实践。这些实践不仅能够提升数据处理的效率,还能为企业的数据战略提供强有力的支持。

| 实践 | 优势 | 案例 |

|---|---|---|

| 数据治理 | 提高数据一致性 | 全球银行采用数据治理改善风险管理 |

| 自动化 | 降低人为错误 | 大型电商平台使用自动化工具提升运营效率 |

| 安全管理 | 保护数据隐私 | 医疗机构加强数据加密措施 |

1. 数据治理

数据治理是确保数据一致性和可靠性的关键。通过实施严格的数据治理政策,企业可以有效管理数据的整个生命周期,从创建、存储到使用和销毁。例如,一家全球银行通过数据治理项目改善了其风险管理流程,显著减少了不良贷款的发生。

数据治理的关键在于制定明确的数据标准和政策,以及建立有效的数据管理架构。企业可以利用FineDataLink的可视化数据管理功能,简化数据治理的实施过程。

2. 自动化

自动化是减少人为错误、提升数据处理效率的有力工具。在数据管道和数据仓库协作过程中,自动化可以帮助企业实现流程的标准化和高效化。例如,某大型电商平台通过引入自动化数据处理工具,成功提升了运营效率,显著减少了订单处理时间。

自动化可以应用于数据采集、转换、加载等多个环节,FineDataLink提供了一套完整的自动化工具集,帮助企业实现数据处理的自动化。

3. 安全管理

在数据驱动的时代,数据安全变得尤为重要。企业需要采取多层次的安全措施,确保数据在传输、存储和处理过程中的安全性。例如,一家医疗机构通过加强数据加密和访问控制措施,成功保护了患者的隐私数据。

企业可以利用FineDataLink的安全管理功能,实施全面的数据安全策略,确保数据的机密性、完整性和可用性。

📚 四、总结

通过深入了解数据管道与数据仓库的协作流程,企业可以更好地设计和管理其数据架构。高效的数据协作不仅能提升数据分析的准确性,还能为企业战略决策提供坚实的基础。在不断变化的市场环境中,保持数据的及时性、准确性和安全性是企业成功的关键。

在实施过程中,FineDataLink作为一款高效、实用的低代码ETL工具,为企业的数字化转型提供了强有力的支持。其功能全面、操作简便,能够帮助企业实现复杂的数据集成任务,是现代企业在大数据时代不可或缺的伙伴。

参考文献:

- Kimball, R., & Ross, M. (2013). The Data Warehouse Toolkit: The Definitive Guide to Dimensional Modeling. Wiley.

- Inmon, W. H. (2005). Building the Data Warehouse. Wiley.

- Linstedt, D., & Olschimke, M. (2015). Building a Scalable Data Warehouse with Data Vault 2.0. Morgan Kaufmann.

本文相关FAQs

🚀 数据管道和数据仓库的基本概念是什么?它们如何相互作用?

最近老板让我研究一下数据管道和数据仓库之间的协作关系,但我对这方面的概念还不太清楚。有没有大佬能用通俗易懂的话给我讲讲?特别是它们在企业数据流中的角色和相互关系,搞不太明白啊!

在开始深入探讨数据管道和数据仓库如何协作之前,我们首先需要了解它们各自的基本概念和在企业数据流中的角色。

数据管道是一种用于传输数据的系统,可以将数据从一个地方转移到另一个地方。这个过程包括提取、转换和加载(ETL)数据,通常是为了让数据在不同的应用程序和系统之间流动。有时,我们也会用“ELT”流程,即在数据仓库中完成转换步骤。

数据仓库则是一个专门用于存储和管理大量历史数据的系统,支持复杂的查询和分析。它通常被设计为高性能的查询引擎,适合于处理大规模数据集。数据仓库是企业做出决策的重要支持工具,因为它能提供整合后的数据视图。

数据管道和数据仓库的协作是数据流管理的核心。管道负责从各种数据源提取数据,进行必要的转换,然后将其加载到数据仓库中。数据仓库则存储这些数据,并通过支持用户查询和分析的方式为企业提供洞察力。

在实际应用中,数据管道和数据仓库的协作关系可以简化为以下步骤:

- 数据收集:数据管道从多个源(如数据库、日志、API等)收集数据。

- 数据处理:在数据管道中,数据经过清洗、转换和聚合,以确保其格式一致并具有分析价值。

- 数据存储:处理后的数据被加载到数据仓库中,进行长期存储和管理。

- 数据分析:用户可通过数据仓库执行复杂查询,生成报表,支持业务决策。

这种协作关系确保了企业的数据处理和分析过程高效且可靠,使决策者能够依赖准确和及时的数据进行决策。

🔍 实时数据同步和批量处理的利与弊,怎么选择?

作为企业的IT工程师,我们有时需要在实时数据同步和批量处理之间做出选择。但每种方法都有优缺点,具体场景该如何判断?有没有什么实际案例或经验分享?

在企业的数据管理中,实时数据同步和批量处理是两种常见的数据处理方法,各有其应用场景和优势。

实时数据同步指的是在数据变更时立即更新数据仓库。这种方式的优点是可以确保数据的时效性,适合需要实时决策的业务场景,如金融交易、在线广告投放等。然而,实时同步对系统性能要求较高,可能会增加系统负担,尤其是在数据量巨大的情况下。

批量处理则是在特定时间间隔内,将数据成批次地进行处理和更新。它的优点是可以减少系统的瞬时负荷,适合处理大量数据的业务场景,如日终结算、月度报表生成等。批量处理的缺点是数据的时效性不如实时同步,需要等待下一次批处理才能反映数据变更。

如何选择?这主要取决于业务需求和技术条件:

- 业务需求:如果业务需要实时获取最新数据并迅速做出反应,则实时数据同步是更好的选择。如果业务对数据的时效性要求不高,选择批量处理可能更为合适。

- 技术条件:实时数据同步需要更高的技术支持,包括高性能的网络、数据库和数据管道工具。如果现有技术条件不满足,批量处理可能是更可行的方案。

一个实际案例是电商平台的库存管理。当商品销售时,需要实时更新库存信息以防止超卖,此时实时数据同步是最佳选择。而在生成销售报告时,由于不需要立即出结果,批量处理更为合适。

为了实现高效的实时数据同步,企业可以考虑使用像 FineDataLink体验Demo 这样的低代码数据集成平台。FDL不仅支持实时全量和增量同步,还能根据数据源的适配情况,灵活配置同步任务,帮助企业在大数据场景下实现高效的数据流管理。

🤔 如何解决数据管道和数据仓库协作中的性能问题?

在项目实施中,我们发现数据量一大,实时同步性能就跟不上,影响了业务开展。大家有没有遇到过类似的问题?都用什么方法解决的呢?

在数据管道和数据仓库的协作过程中,性能问题是一个常见的挑战,尤其是在面对海量数据时。以下是一些常见的性能瓶颈及其解决方案:

- 数据传输速度慢:当数据量巨大时,数据传输的速度可能成为瓶颈。解决这个问题的方法包括:

- 压缩数据:通过数据压缩减少传输的数据量。

- 优化网络:使用更高带宽的网络或者优化现有网络配置。

- 分布式传输:将数据拆分为更小的片段,使用分布式系统并行传输。

- 数据加载效率低:数据加载到仓库的速度影响整体性能。可以通过以下方法优化:

- 批量加载:将数据分批加载,而非逐行加载,可以有效提高加载效率。

- 增量更新:仅更新有变化的数据,而不是每次全量更新。

- 使用合适的工具:选择支持高效数据加载的工具或平台,确保加载过程的性能。

- 数据处理性能差:在数据管道中,数据处理是另一个性能瓶颈。优化方法包括:

- 优化ETL流程:简化或并行化ETL过程中的复杂转换逻辑。

- 使用缓存:在处理过程中使用缓存技术,减少重复计算。

- 选择合适的计算框架:例如使用Apache Spark等分布式计算框架提高处理速度。

一个实际案例是某大型在线零售商在进行实时库存管理时遇到性能瓶颈。通过使用FineDataLink这样的集成平台,他们能够灵活配置数据同步任务,实现增量同步和批量加载的结合,显著提升数据处理速度与系统的整体性能。

面对性能问题,企业需要综合考虑业务需求、现有技术条件和解决方案的可行性。选择适合的工具和平台,优化数据流的各个环节,可以有效解决性能瓶颈,保障数据管道和数据仓库的高效协作。