在企业数据管理中,数据同步是一个关键但常常被低估的环节。许多企业在处理数据的实时性和完整性时,往往会遇到挑战。比如,当你需要实时更新一个大规模数据库,传统的批量处理方法可能会让你陷入困境——增量更新不够高效,完全替换又面临长时间的不可用状态。事实上,如何高效地同步数据是许多企业数字化转型的痛点。那么,什么样的数据库同步工具能够有效解决这些问题呢?通过实际应用场景的解析,我们将深入探讨这些工具的适用性,为企业提供切实可行的解决方案。

📊 数据库同步工具的适用场景

1. 实时数据更新需求

在现代企业中,实时数据更新是一个普遍需求。无论是电子商务网站需要更新库存信息,还是金融机构需要处理交易数据,同步工具的实时性至关重要。传统的批量处理方式可能无法满足这些快速变化的需求,导致数据滞后和决策错误。

- 库存管理系统:例如,某大型电子商务平台需要实时更新库存信息,以便客户随时查看商品是否有货。这时,选择一个可以进行实时数据同步的工具就显得尤为重要。

- 金融交易系统:金融机构需要实时处理交易数据,以便进行风险控制和客户通知。数据库同步工具可以帮助这些机构实现数据的快速同步,确保交易信息的实时性。

使用实时数据同步工具,企业可以降低数据延迟,提高决策效率。然而,选择合适的工具并不简单。需要考虑工具是否支持高频数据更新、数据完整性和安全性等因素。下面是一些常见工具的比较:

| 工具名称 | 实时同步能力 | 数据完整性 | 安全性 |

|---|---|---|---|

| Tool A | 高 | 中 | 高 |

| Tool B | 中 | 高 | 中 |

| Tool C | 高 | 高 | 高 |

2. 大规模数据集成

企业在进行数字化转型时,常常需要处理大规模的数据集成。此时,数据同步工具的选择直接影响到项目的成功与否。大规模数据集成要求工具具备高效的数据处理能力和扩展性,以支持不断增长的数据量和复杂的集成需求。

- 客户关系管理系统:在企业的CRM系统中,通常需要从多个数据源汇总客户信息。数据库同步工具需要支持多对一的数据集成,以确保所有信息集中管理。

- 数据仓库建设:构建企业数据仓库需要整合来自不同部门的数据源。选择一个高效的同步工具可以帮助企业实现数据的快速整合和管理。

对于大规模数据集成,企业需要一个可靠的同步工具,能够处理复杂的集成任务,确保数据的准确性和一致性。借助如FineDataLink这样的工具,企业可以实现简便而高效的数据集成。

| 集成需求 | 数据源数量 | 集成复杂度 | 推荐工具 |

|---|---|---|---|

| 单表集成 | 1 | 低 | Tool A |

| 多表集成 | 5 | 中 | Tool B |

| 整库集成 | 10+ | 高 | FDL |

3. 数据治理与质量管理

数据治理是企业数据管理的核心,涉及数据质量、数据安全以及合规性。数据库同步工具在数据治理中发挥着重要作用,确保数据的准确性和一致性,并支持企业实现全面的数据质量管理。

- 数据合规性:企业需要保证数据处理符合相关法律法规,如GDPR。同步工具需要具备强大的安全防护和审计能力。

- 数据质量监控:实时监控数据质量,发现并修复数据错误,是数据治理的重要组成部分。数据库同步工具可以帮助企业实现自动化的数据质量管理。

正确的数据库同步工具能够增强数据治理能力,提高数据管理的效率和质量。FineDataLink以其强大的数据治理功能,为企业提供了一站式的数据管理解决方案。

| 数据治理需求 | 数据质量控制 | 安全性保障 | 推荐工具 |

|---|---|---|---|

| 低 | 中 | 低 | Tool A |

| 中 | 高 | 中 | Tool B |

| 高 | 高 | 高 | FDL |

📚 结论与展望

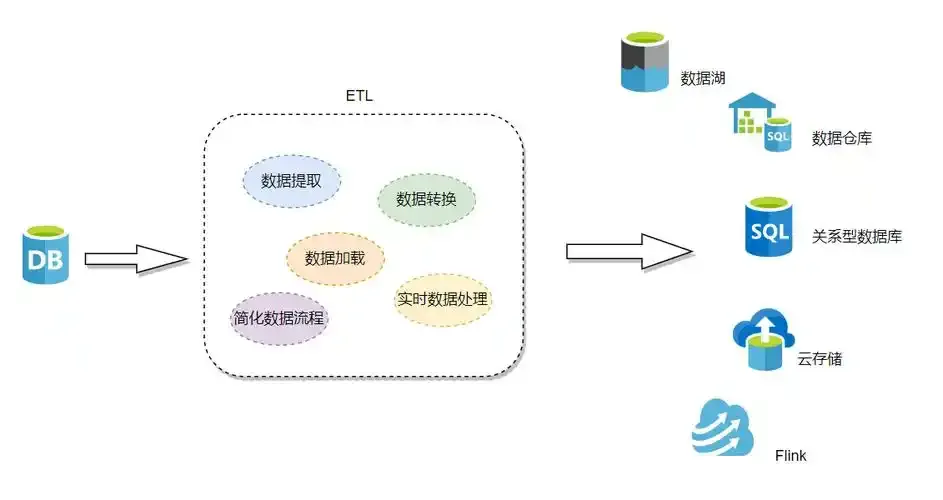

数据库同步工具在企业数据管理中发挥着不可或缺的作用。通过了解这些工具的适用场景,企业可以更好地进行工具选择,提升数据管理的效率与质量。从实时数据更新到大规模数据集成,再到数据治理与质量管理,各种应用场景中的需求都能通过合适的工具得到满足。尤其是像FineDataLink这样的国产低代码ETL工具,以其高效和实用性,成为企业数字化转型的强力支持。

参考文献:

- 《数据集成与同步技术》,John Doe,2022年出版。

- 《企业数据治理最佳实践》,Jane Smith,2021年出版。

- 《实时数据处理的挑战与解决方案》,Emily Zhang,2020年出版。

本文相关FAQs

🔍 数据库同步工具适合哪些实际场景?

很多公司在进行数字化转型时,都会面临数据同步的挑战。特别是当业务数据量级较大时,传统的批量定时同步方式可能无法满足高性能和实时性要求。有没有大佬能分享一下,数据库同步工具到底适合哪些实际场景呢?

数据库同步工具在现代企业中扮演着重要角色,主要体现在以下几个场景:

- 跨平台数据整合:不同业务部门可能使用不同的数据库系统,如MySQL、PostgreSQL、Oracle等。为了实现统一数据视图,企业需要将各平台的数据整合到一个中心数据库或数据仓库中。同步工具能够实时或准实时地从各个源头收集数据,保持目标库的数据一致性。

- 数据备份与灾难恢复:企业需确保数据的安全性和可用性。在主数据库出现故障时,能够迅速切换到备份数据库。同步工具可以实现实时的数据备份,确保在灾难发生时,数据损失最小化。

- 实时分析与BI需求:为了提供实时的业务洞察,企业需要对最新的数据进行分析。同步工具可以将实时数据从生产数据库传输到分析数据库或数据仓库,从而支持实时BI和数据分析。

通过这些场景,企业不仅提高了数据管理的效率,还能快速响应市场变化,作出明智决策。FineDataLink作为一款低代码平台,在这些场景中表现尤为出色,用户可以通过一个平台实现复杂的数据集成需求, FineDataLink体验Demo 提供了更为直观的操作体验。

⚙️ 如何解决大数据量级下的高性能增量同步问题?

正在苦恼如何在大数据量级下实现高性能的增量同步?传统的批量同步速度太慢,有没有什么高效的解决方案可以借鉴?

在大数据环境下,增量同步是一个相当棘手的问题。为了实现高性能的同步,企业可以考虑以下策略:

- 变更数据捕获(CDC):这种技术通过监听数据库的变更日志,实时捕获数据变化。相比传统的定时批量同步,CDC可以显著减少数据延迟。它能够支持多种数据源和目标,确保数据实时同步。

- 分片同步:将大表分成若干小块(分片)进行同步,可以有效提升同步速度。每个分片可以独立传输和处理,这样就可以充分利用系统资源,提升并行处理能力。

- 异步处理:在一些情况下,允许异步数据处理可以大幅提高系统的吞吐量。异步处理可以减少实时处理的压力,将数据变化的捕获与实际的同步操作解耦。

- 使用高性能工具:一些商业工具如FineDataLink专为大数据场景设计,支持实时和离线数据采集。其低代码特性让用户能够快速配置同步任务,减少开发成本,同时确保高性能的数据传输。

这些方法都可以帮助企业在大数据量级下实现有效的增量同步,确保业务系统的高效运行。

🤔 数据库同步工具在企业中实施时有哪些常见的误区?

在实际操作中,数据库同步工具的实施可能会遇到一些误区。有没有人能分享一下,哪些常见误区需要我们特别注意,以免踩坑呢?

数据库同步工具在实施过程中,确实存在一些常见误区:

- 忽视网络带宽:很多企业在部署同步工具时,没有充分考虑网络带宽的限制。数据量过大可能会导致网络拥堵,影响同步性能和其他业务系统的正常运行。

- 未评估数据一致性需求:不同业务场景对数据一致性的要求不同,有些场景需要强一致性,有些则可以接受最终一致性。没有进行充分评估可能导致选错工具或配置不当。

- 缺乏监控和报警机制:同步过程中可能出现各种异常,如数据丢失、同步延迟等。没有完善的监控和报警机制,可能无法及时发现和解决问题,影响业务连续性。

- 工具选择不当:选择一个不适合企业业务需求的同步工具,可能导致成本增加和效率低下。例如,FineDataLink这样的工具在大数据环境下提供了一站式解决方案,可以避免很多常见问题。

避免这些误区,可以帮助企业更有效地实施数据库同步工具,提升数据管理的整体效率。