在数据密集型企业中,如何有效地进行ETL需求分析和选型策略成为了一个关键问题。企业需要处理从不同数据源提取、转换到加载的一系列复杂操作,确保数据的准确性、时效性和可用性。而在这过程中,选择合适的ETL工具至关重要,它不仅能够提升数据处理效率,还能降低IT成本和复杂性。本文将深入探讨如何精准进行ETL需求分析,并提供选型策略与方法,帮助企业在数字化转型中取得优势。

🧐 一、ETL需求分析的基础

精准的ETL需求分析是成功实施ETL项目的第一步。它要求我们从企业的实际业务需求出发,明确数据处理的目标与挑战。

1. 识别业务需求

在开始ETL需求分析时,首先需要识别并理解企业的业务需求。这包括明确哪些数据需要被处理、数据的更新频率、以及数据的最终用途。只有充分理解这些需求,才能确保ETL流程的设计能够满足业务目标。

- 关键数据:识别哪些数据对业务决策至关重要。

- 数据频率:评估数据更新的频率需求,以决定是进行批量处理还是实时处理。

- 数据质量:确定数据的质量标准,确保数据的准确性和完整性。

2. 分析数据源和结构

分析数据源是ETL需求分析的另一重要环节。企业通常面临多种数据源,包括关系数据库、NoSQL数据库、文件系统等,这要求我们在设计ETL流程时考虑多样化的数据结构和格式。

| 数据源类型 | 特点 | 处理挑战 |

|---|---|---|

| 关系数据库 | 结构化数据,强一致性 | 复杂查询,事务处理 |

| NoSQL数据库 | 分布式,高可扩展性 | 数据模型多样,灵活性 |

| 文件系统 | 非结构化数据,易访问 | 格式多样,读取效率低 |

3. 评估数据处理能力

评估现有的数据处理能力对于精准分析ETL需求至关重要。企业需要了解现有系统的处理能力、瓶颈和限制,以便在ETL工具选型时做出明智的决策。此过程包括对计算资源、存储容量和网络带宽的评估。

- 计算资源:当前计算资源是否能够支持高负载的数据处理任务。

- 存储容量:现有存储容量是否足以容纳所有历史数据和增量数据。

- 网络带宽:网络带宽是否能够支持大规模的数据传输和同步。

🛠️ 二、ETL工具选型策略

选择合适的ETL工具是实现高效数据处理的关键。面对市场上众多的ETL工具,企业需要综合考虑功能、易用性和成本等多方面因素。

1. 功能需求匹配

在进行工具选型时,首先要确保工具的功能能够满足企业的实际需求。不同的ETL工具提供了不同的功能集,企业需要根据自身的需求进行匹配。

| 工具名称 | 实时处理 | 批量处理 | 数据清洗 | 数据转换 | 数据集成 |

|---|---|---|---|---|---|

| 工具A | 是 | 是 | 是 | 否 | 是 |

| 工具B | 否 | 是 | 是 | 是 | 否 |

| FineDataLink | 是 | 是 | 是 | 是 | 是 |

2. 易用性与灵活性

易用性和灵活性是选型时的重要考量因素。企业需要评估工具的用户界面是否友好、是否支持低代码开发以及是否可以灵活地扩展和定制。

- 用户界面:直观的用户界面能降低学习曲线,提高工作效率。

- 低代码支持:支持低代码开发的工具能够加速开发过程,降低技术门槛。

- 扩展性:工具是否能够根据企业的业务增长进行灵活扩展。

3. 成本与支持

成本是选型时必须考虑的重要因素,包括工具的初始购置成本、运营和维护成本。同时,厂商的技术支持和社区活跃度也影响工具的选择。

- 初始成本:工具的购置和部署成本是否在预算范围内。

- 运营成本:工具的长期运营和维护成本是否可控。

- 技术支持:厂商是否提供完善的技术支持和培训服务。

🔍 三、ETL工具选型方法

在明确了需求和选型策略后,企业需要采用系统化的方法进行ETL工具的选型。这包括对工具的功能测试、性能评估和用户反馈的收集。

1. 功能测试

功能测试是选型过程中不可或缺的一步。企业需要通过实际的使用来验证ETL工具是否能够满足所有的功能需求。这通常涉及到对工具的安装、配置和基本功能的使用。

- 安装配置:测试工具的安装和配置过程是否简单易行。

- 基本功能:验证工具的基本功能是否如厂商所述。

- 高级功能:测试工具的高级功能是否能够支持复杂的数据处理场景。

2. 性能评估

性能评估主要关注工具在实际数据处理任务中的表现,包括处理速度、资源消耗和稳定性。企业可以通过模拟实际工作负载来进行评估。

| 性能指标 | 工具A | 工具B | FineDataLink |

|---|---|---|---|

| 处理速度 | 中 | 高 | 高 |

| 资源消耗 | 高 | 中 | 低 |

| 稳定性 | 中 | 中 | 高 |

3. 用户反馈

用户反馈可以为选型提供重要的参考。企业可以通过调研已使用该工具的用户,了解其在实际应用中的优缺点,并结合自身需求进行判断。

- 用户满意度:调查用户对工具的整体满意度。

- 常见问题:了解用户在使用过程中遇到的常见问题和解决方案。

- 改进建议:收集用户对工具改进的建议,以评估其未来发展潜力。

✨ 四、FineDataLink的优势

在众多ETL工具中,FineDataLink(FDL)凭借其低代码、高效能的特点成为了企业的理想选择。FDL不仅能够支持实时和离线数据同步,还提供了一站式数据集成平台,为企业的数字化转型提供了强有力的支持。

1. 低代码实现高效

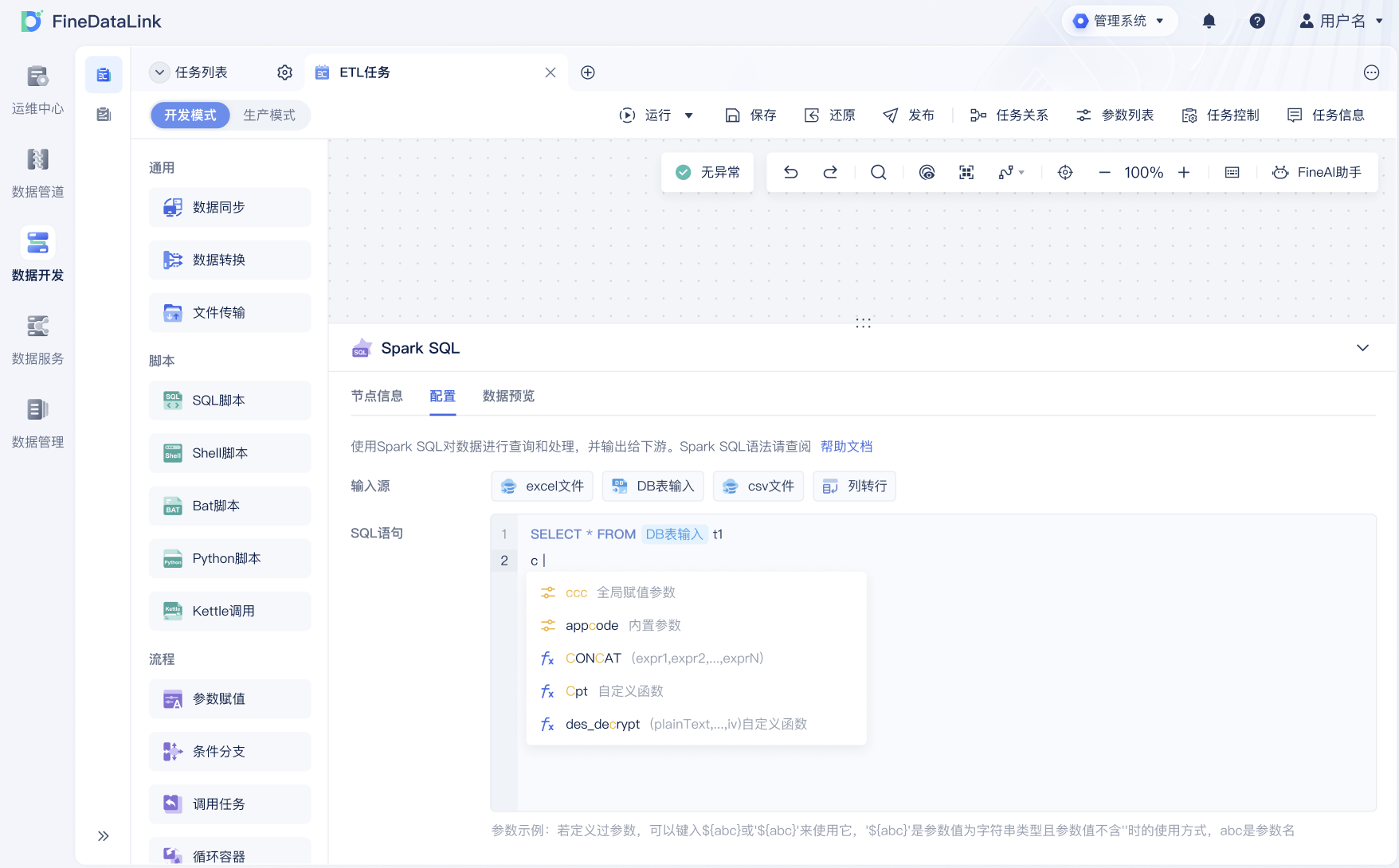

FineDataLink通过简化开发流程,实现了低代码的高效能。企业可以通过简单的配置和界面操作,快速构建复杂的数据处理流程,这大大降低了技术门槛和开发成本。

- 快速配置:用户无需编写复杂的代码即可完成数据同步任务。

- 可视化界面:直观的界面设计让用户能够轻松管理和监控数据流。

- 灵活扩展:支持多种数据源和数据格式,满足企业多样化的数据需求。

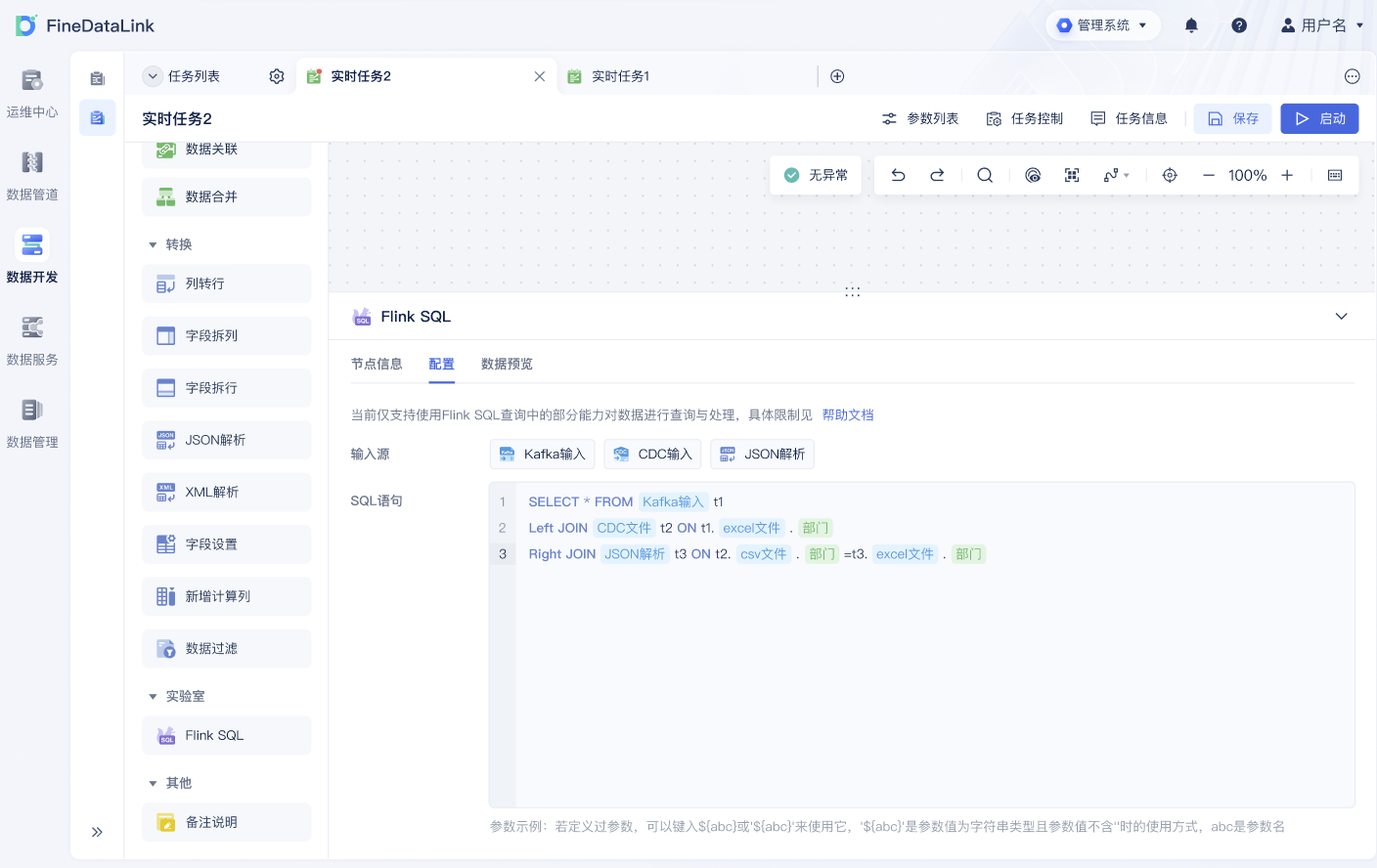

2. 实时数据处理

FDL支持高性能的实时数据处理,确保企业能够快速响应业务变化。这对于需要实时数据分析和决策支持的企业尤为重要。

| 功能 | FineDataLink |

|---|---|

| 实时处理 | 支持 |

| 批量处理 | 支持 |

| 数据清洗 | 支持 |

3. 帆软背书的信赖

作为帆软背书的国产ETL工具,FineDataLink不仅具有高效实用的特性,还享有国内用户的广泛信赖。帆软丰富的行业经验和技术积累为FDL的性能和稳定性提供了有力保障。

📚 五、总结与展望

精准的ETL需求分析和合理的工具选型策略是企业成功进行数据集成的基石。通过明确业务需求、分析数据源、评估数据处理能力,企业能够为选型提供明确的方向。而在工具选型过程中,企业需要综合考虑功能需求、易用性和成本等因素,采用系统化的方法进行测试和评估。FineDataLink凭借其低代码、高效能和帆软背书的优势,为企业的数字化转型提供了强有力的支持。在未来,随着技术的不断进步和企业需求的变化,ETL工具将继续发展,为企业提供更加灵活和高效的数据处理解决方案。

参考文献

- 王海波,《大数据技术与应用》,电子工业出版社,2021。

- 李志刚,《企业数字化转型》,人民邮电出版社,2022。

希望本文为您提供了关于ETL需求分析和工具选型的全面指导,为您的企业在数字化转型道路上提供有价值的参考。

本文相关FAQs

🤔 如何快速理解ETL流程中的关键步骤?

最近接触ETL,感觉信息量有点大。数据提取、转换、加载这三步听起来简单,实际上每一部分都有一堆细节要考虑。老板总是说要把ETL搞清楚,这样才能做出高效的数据管道。有没有谁能总结一下ETL的核心步骤和每一步需要注意的地方?

理解ETL的流程其实就像是解剖一个复杂的系统,关键在于抓住核心。ETL是Extract(提取)、Transform(转换)和Load(加载)的缩写。每个步骤都有其独特的挑战和机会。

提取(Extract) 提取是ETL的第一步,目标是从各种数据源中获取数据。无论是关系型数据库、NoSQL数据库,还是文件系统,提取方式和工具的选择都至关重要。对于数据量大的企业来说,选择一个高效的提取工具能够显著降低数据同步的时间。通常建议使用能够支持增量提取的工具,这样可以避免每次都进行全量提取,节省时间和资源。

转换(Transform) 转换阶段是ETL中的精华所在,它决定了数据清洗和格式化的质量。这里的挑战在于如何将数据标准化,以及如何处理数据中的异常值和缺失值。一个好的转换工具可以提供丰富的函数库来支持各种数据操作,也可以通过可视化界面让数据转换变得直观易懂。值得注意的是,转换过程中的性能优化是个大问题,尤其是在数据量巨大的情况下。

加载(Load) 最后一步是将处理过的数据加载到目标系统中。加载过程的效率直接影响到数据的实时性,尤其是在需要支持实时分析的场景下。选择一个支持并行加载的工具能够显著提高加载效率。同时,考虑到数据一致性和完整性,加载过程中需要设计好事务管理和错误处理机制。

在整个ETL过程中,工具的选择是影响效率的关键。在这里推荐一个不错的工具: FineDataLink体验Demo ,它能够简化ETL流程中的很多复杂操作,适合大多数企业的需求。

🛠️ ETL中的数据转换老是出错,有什么好的方法提高准确性?

每次数据转换的时候,总会遇到各种各样的问题。比如数据格式对不上、转换后数据不完整,还有一些奇怪的异常值。有没有大佬能分享一下提高ETL数据转换准确性的方法?或者有没有什么工具特别好用?

数据转换是ETL过程中最容易出问题的环节之一,因为它涉及到数据的清洗和格式化,而这两个操作往往对数据的完整性要求很高。为了提高转换过程的准确性,可以采取以下几种策略:

数据质量控制 首先,确保输入数据的质量。有时候输入数据本身的问题会导致转换出错,因此在进行转换之前,应对输入数据进行严格的检查。可以使用数据质量工具来识别和修复数据中的异常值和缺失值。

转换规则的定义 在转换过程中,明确的规则定义是至关重要的。使用可视化工具来定义转换规则可以减少人为错误。很多ETL工具都提供了拖拽式的转换规则配置界面,这样即便是非技术人员也能参与到数据转换的工作中。

测试和验证 在将转换后的数据加载到目标系统之前,一定要进行充分的测试。创建一个测试环境来模拟实际的转换场景,通过对比转换前后的数据来验证转换的准确性。自动化的测试工具可以帮助在代码层面上检测潜在的问题。

工具选择 选择一个能够支持实时监控和调试的ETL工具也是提高转换准确性的关键。FineDataLink就是一个不错的选择,它提供了丰富的数据转换功能和直观的界面。

通过这几种方法,可以有效提高数据转换的准确性,减少出错的概率。

📊 如何选择适合企业的数据同步方案?

我们公司正面临业务数据量激增的问题,平时用的批量同步方式越来越慢,数据时效性不够。有没有人能帮忙分析一下,在这种情况下,选择什么样的数据同步方案最合适?特别是在数据库数据量大或表结构规范的情况下。

在数据同步方案的选择上,企业常常面临时效性和性能的双重考验。特别是当数据量不断增长时,传统的批量同步已经难以满足需求。

实时同步 vs 批量同步 首先需要明确业务需求,是需要实时数据还是允许一定的延迟。实时同步能够确保数据的时效性,但同时对系统的压力也更大。而批量同步通常对系统压力较小,但可能导致数据延迟。

增量同步的重要性 对于大数据量的场景,增量同步是提高效率的关键。增量同步只传输变化的数据,节省了带宽和处理时间。很多现代化的ETL工具都支持增量同步,可以根据业务需求进行灵活配置。

工具的选择 选择一个高效的数据同步工具至关重要。FineDataLink就是一个很好的选择,它支持对数据源进行单表、多表、整库、多对一数据的实时全量和增量同步,能够根据数据源适配情况,配置实时同步任务。你可以先体验一下: FineDataLink体验Demo 。

性能优化 在同步方案的设计中,性能优化是需要重点考虑的因素。可以通过合理配置同步任务的并发数,以及使用分布式处理框架来提高同步效率。

通过以上几种方法,企业可以根据自身的业务需求和数据特点,选择最合适的数据同步方案,从而实现高效的数据管理和分析。