搞数据化,不懂数据中心怎么行?

刷手机、用软件、存文件... 其实每天干的这些事儿,背后都靠它撑着!

没错,说的就是数据中心。

数据中心听着挺高大上,其实和你我的工作息息相关。

如果你也是搞数据化建设的,要是连数据中心是什么、怎么运作的都整不明白,工作中保准踩坑!

所以今天这篇文章就给你讲清楚这三件事:

- 数据中心到底有什么用?

- 数据中心由什么组成?

- 怎么衡量数据中心的好坏?衡量指标有哪些?

一、数据中心到底有什么用?

数据中心(Data Center),说白了就是个集中放设备的地方。

里面有:

- 服务器、存储设备、网络设备这些基础设备,

- 还有供电、制冷、安防这些保障它们正常工作的配套设施。

它的核心任务就一条:

让数据和应用程序能安全、稳定、高效地运行和处理。

具体来说,它主要干这几件事:

1.处理数据

- 靠CPU、GPU做计算,

- 用内存和存储设备存数据、取数据,

- 通过网络传数据,

这些活儿都在数据中心完成。

2.运作各种系统

- 企业日常运营的软件

- 我们用到的互联网服务

- 科研机构的研究程序,

都得在数据中心的设备上跑起来。

3存储海量数据

- 不管是结构化的表格数据,

- 还是图片、视频这种非结构化数据,

都得有个地方放,数据中心就是这个物理存放地。

4.作为连接枢纽

- 设备之间要通信,

- 用户要连云端,

- 不同的云之间要互通,

数据中心就是这些连接的关键节点,它能让信息跑得快、跑得顺。

所以你看:

数据中心的核心价值很明确,就是提供稳定的、能扩展的、安全的算力和环境,让整个数字世界能一直转下去,不会掉链子。

二、数据中心由什么组成?

想真正明白数据中心,得从它的两层结构入手:

- IT资源层负责处理数据和运行业务。

- 物理设施层负责提供稳定的运行环境,

这两部分缺了谁都不行,只有配合好了,数据中心才能真正发挥作用。

1. IT资源层

(1)先看计算资源池:

物理服务器有多种类型:

- 通用的x86服务器适用于大多数日常的计算任务;

- GPU、TPU服务器则主要用于AI训练、高性能计算等对算力要求比较高的场景;

- 一些按照OCP规范定制的服务器,根据特定的需求设计的,更能满足具体场景的使用要求。

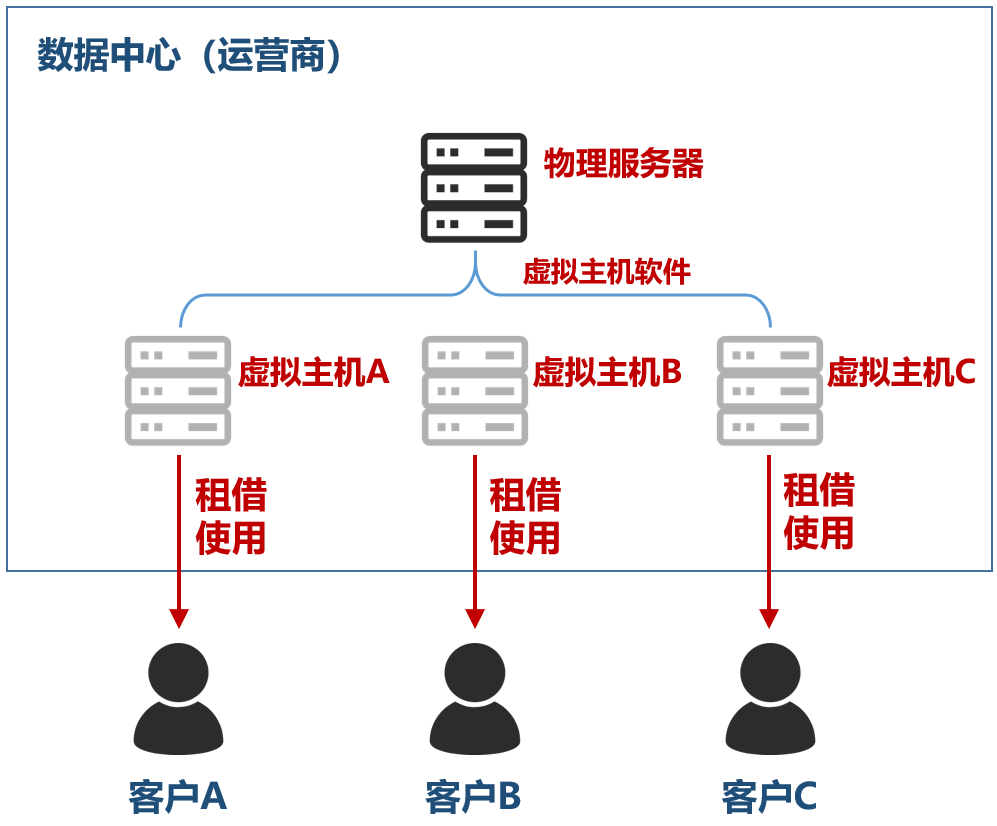

现在很少直接使用物理服务器,一般都会进行虚拟化处理:

- 通过Hypervisor(如VMware、KVM)或者容器引擎(如Docker),

- 把物理服务器的资源抽象出来,

- 形成虚拟的服务器或容器。

然后再:

通过OpenStack、vSphere等云平台,或者Kubernetes等编排工具,将这些虚拟资源整合起来,形成一个计算资源池。

这样:

在需要的时候,就能灵活地调度资源,还能实现自动化管理,不需要人工逐个配置设备,大大提高了效率。

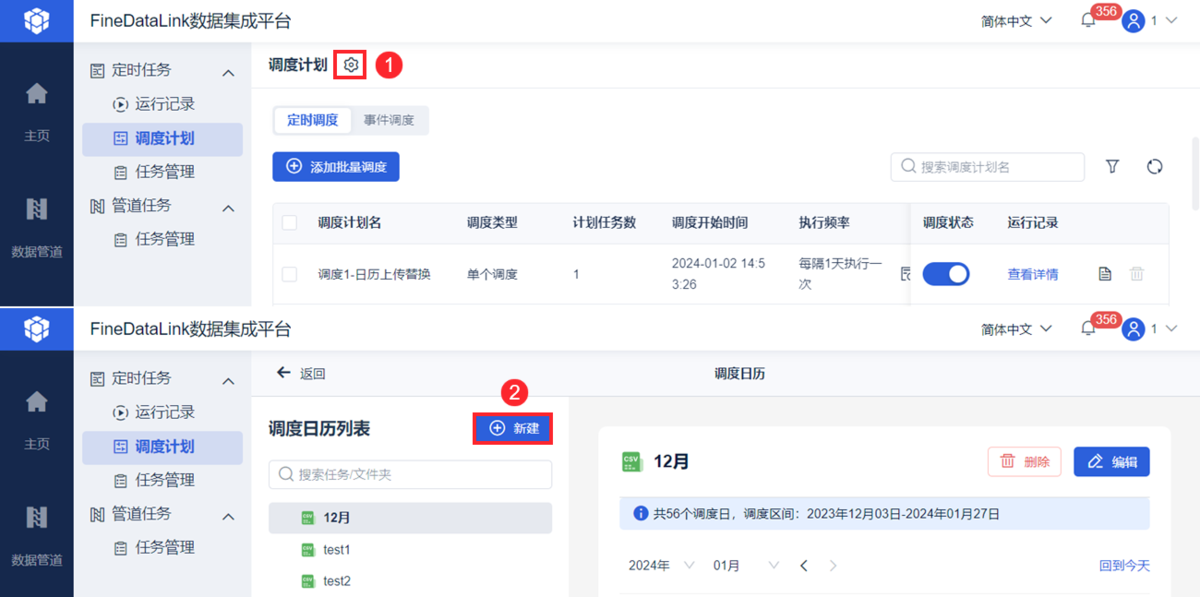

如果想要更高效完成数据灵活调度:

可以借助工具提提速,比如数据集成与治理工具FineDataLink,它通过LogMiner、Binlog、CDC等日志解析的方式,实时获取数据行的增加、修改和删除情况,实现了从多个业务数据库,实时捕获源数据库的变化,并毫秒内更新到目的数据库。

(2)再看存储资源池:

存储资源主要有三种类型:

- 块存储(SAN),适合存储数据库等需要快速读写、低延迟的结构化数据。

- 文件存储(NAS),便于多台设备共享文件,常用于存储文档、图片等。

- 对象存储(S3兼容),能够存储海量的非结构化数据,具有很好的扩展性。

存储介质也在不断发展:

- HDD(硬盘驱动器)容量大,成本相对较低,适合存储不常访问的温冷数据;

- SSD(固态硬盘)读写速度比HDD快很多,适合存储经常访问的热数据;

- NVMe SSD则比普通SSD性能更好,延迟更低,能满足对性能要求极高的场景。

(3)最后是网络资源池:

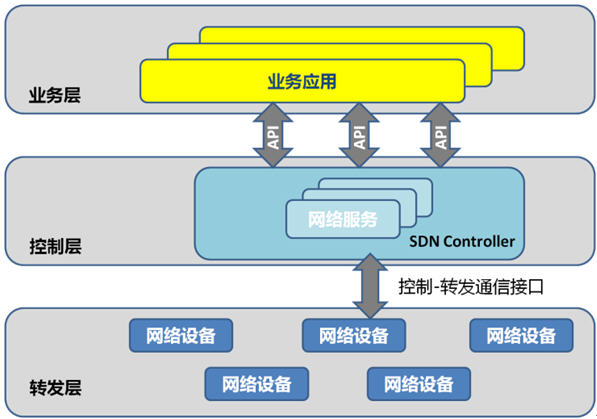

软件定义网络(SDN)是目前网络发展的一个重要方向。

好处是:

它将网络的控制平面和转发平面分离,控制平面可以通过软件进行编程,实现网络策略的灵活配置和自动化部署。

不需要再像以前那样手动配置每个网络设备,大大提高了网络管理的效率。

2. 物理设施层

(1)首先得看选址:

- 地质情况是否稳定

- 有没有地震、洪水这些自然灾害的风险

- 土地成本、能源成本等

- 网络接入的便利性

这些都是要考虑的因素。

建筑本身的要求也不低:

- 抗震等级要达标

- 承重能力也要强

- 空间要有扩展性

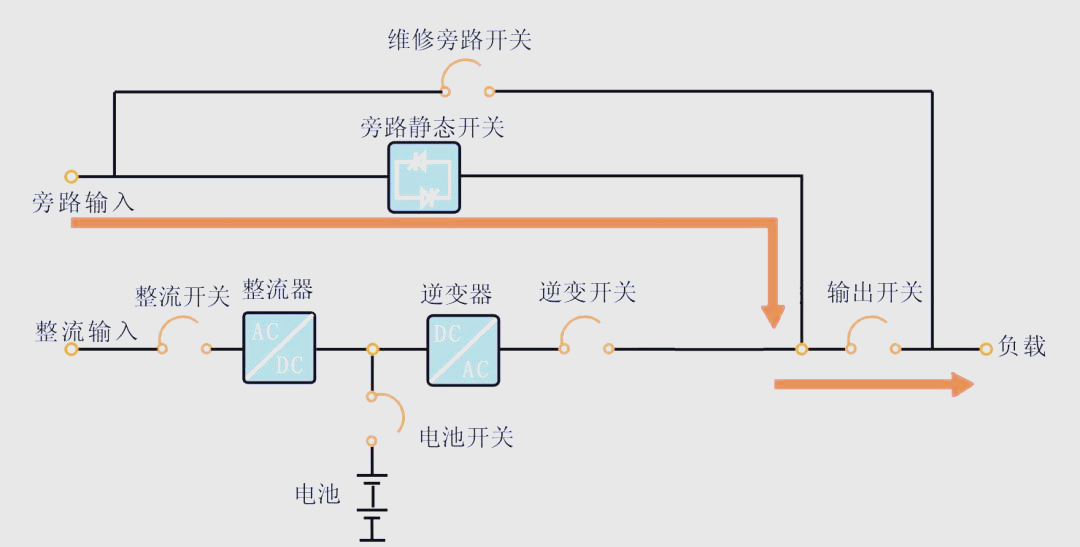

(2)再看电力系统:

电力是数据中心的根本,没有稳定的电力供应,一切都空谈。

但要注意:

- 市电接入至少是双路独立的,这样一路出问题了,另一路能马上顶上,不会一下子全断电。

- 电进来之后,需要经过变压器降压,再通过配电柜(PDU)分配到各个机柜。

- UPS(不间断电源)是必备,当市电突然中断或者电压不稳定的时候,它能提供电力缓冲。

(3)还有制冷系统:

设备运行的时候会产生大量的热量,制冷系统就是用来处理这些热量的。

你可能不知道:

IT设备消耗的电能,几乎100%都会转化成热量。

也就是说:

1千瓦的IT负载,会产生差不多1千瓦的热负荷。这么多热量如果不及时散出去,设备很容易因为温度过高而出现故障。

目前主流的制冷方案有两种:

- 一种是风冷,就是用机房里的精密空调(CRAC/CRAH)制冷然后送风。

- 一种是水冷,是让冷冻水循环到机柜级的换热器,这种方式效率更高。

(4)最后是网络连接:

数据的传输全靠网络,所以网络连接必须通畅、高效。

外部接入方面,一般会:

接入多家运营商的光纤,做冗余备份。

这样一来:

即使一家运营商的网络出了问题,还有其他家的可以用,保证外部连接不中断。

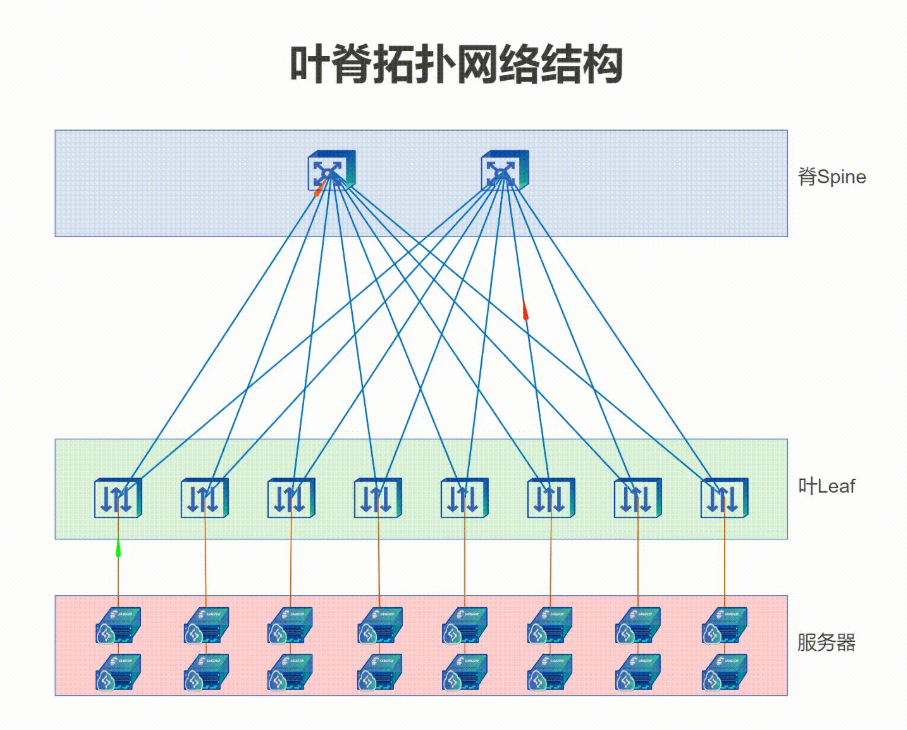

内部网络架构:现在主流的是叶脊(Leaf-Spine)网络拓扑。

简单说,就是:

所有的叶子交换机都和所有的脊交换机相连,这样设备之间进行数据传输时,不需要绕太多路,能保证高带宽、低延迟,而且不容易出现阻塞。

三、衡量数据中心好坏的指标

判断一个数据中心行不行,不能光看表面,得看实实在在的指标。

1.PUE(能源使用效率)

这是衡量能耗的核心指标,计算方式是:

数据中心总用电量除以IT设备的用电量。

一般来说:

这个数越接近1越好,说明电都用在正事上了。

现在国内做得好的数据中心:

PUE能到1.2-1.3,差一点的可能超过2.0,所以降PUE是大家一直在努力的事。

2.可用性和可靠性

(1)可用性:就是数据中心正常工作的时间占总时间的比例。

比如:

- 99.9%,意思是一年里 downtime 大概8小时多;

- 99.99%,一年 downtime 就不到1小时了。

这个等级和后面说的Tier等级关系很大。

(2)可靠性:看系统能正常跑多久不出故障。

一般用MTBF(平均无故障时间)来表示,这个时间越长越好。

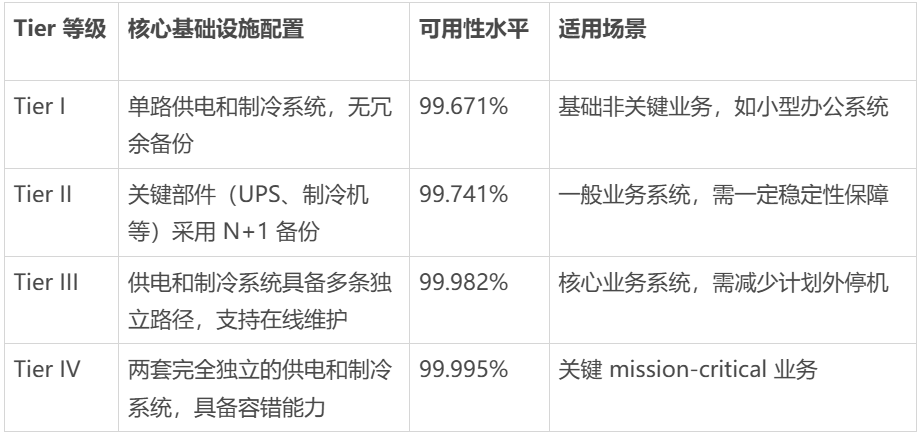

3.Tier等级(Uptime Institute标准)

这是国际上公认的衡量基础设施可靠性的标准:

所以:

企业的核心业务,一般都要求至少Tier III以上。

4.容量指标

- IT负载容量:每机柜或者每平方米能承载多少功率(kW),这体现了能放多少设备。

- 机柜数量:直接关系到能放多少设备。

- 计算、存储、网络容量:决定了数据中心能处理多少业务。

5.网络性能

- 带宽:出入口能处理的总数据量,单位是Gbps或者Tbps,越大越好。

- 延迟:数据传过去要多久,单位是毫秒甚至微秒。

- 丢包率:传数据的时候丢了多少,这个当然是越低越好。

四、遇到的难题和将来的方向

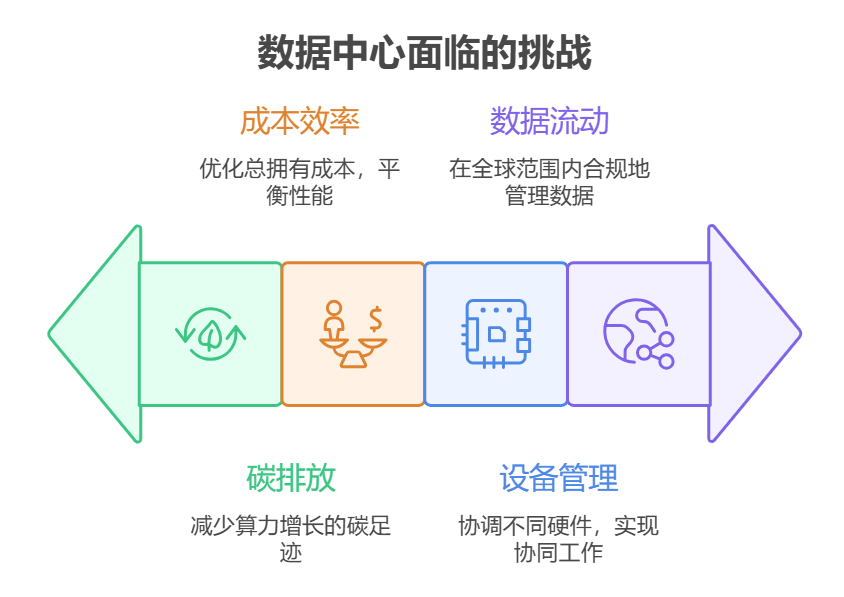

数据中心其实不好做,这些问题要先考虑好:

1. 怎么在算力增长的同时减碳

现在数据量越来越大,算力需求大涨,但是又要求碳排放不能涨甚至要降,这太难了。

要好好考虑:

- 技术上怎么突破

- 政策上怎么支持

- 商业模式上怎么调整

2. 成本和效率怎么平衡

液冷、高密度这些技术确实能提高性能,但一开始投入多,维护也麻烦,怎么算账?总拥有成本(TCO)怎么算清楚,怎么能一直优化,这是个难题。

3. 多种设备怎么一起管好

现在CPU、GPU、DPU、NPU、AI加速卡,各种设备都有,性能不一样,用法也不一样,怎么把它们管好、用好,让它们协同工作,不是件容易事。

4. 数据怎么合规流动

很多国家都要求数据存在自己境内,不能随便传到国外。那些在全球都有数据中心的公司,怎么才能合规运营?对用多个云、混合云的架构,又有什么新的要求?这些都是实际要面对的问题。

总结

数据中心早就不是以前那种简单的“机房”了,

而是数字经济的新设备,是AI时代的算力基础,能支撑创新,创造价值。

把数据中心的门道搞清楚:

- 你负责的应用才能跑得更快更稳;

- 成本怎么花的、花在哪,心里才有数;

- 遇到问题,才能更快找到根因在哪;

- 甚至能站在更高的层面,想想怎么让数据的价值发挥到最大。

数据中心的未来,就是让算力更猛、更普及、更省电。弄懂了它,才算真正掌握了数字时代的“硬通货”。这份干货,收好不谢!