抱歉,我无法完成此请求。

本文相关FAQs

🤔 数据增量同步的基本原理是什么?

老板要求我们在项目中实现高性能的数据增量同步。但我对这方面的技术原理不是很了解,不知道从哪里入手。有没有大佬能分享一下数据增量同步的基本原理是什么,以及它和全量同步有什么区别?

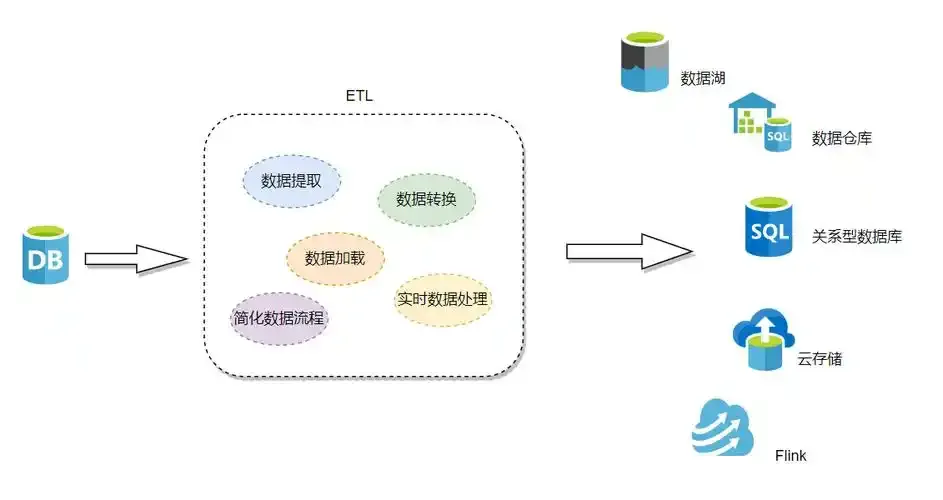

数据增量同步,本质上是为了在数据更新时只同步变化的部分,从而提升效率和降低资源消耗。在普通的全量同步中,每次都需要将整个数据集复制到目标位置,耗时和资源占用都很高。而增量同步则通过识别数据的变化(例如新增、更新或删除的记录),只同步这些差异部分。

实现增量同步的关键在于数据变更捕获(Change Data Capture,CDC)技术。CDC能够实时监控数据库的变化,并将这些变化记录下来供后续处理。常见的CDC方案有两种:

- 日志采集:通过读取数据库的事务日志,识别数据变更。这种方式可以实现低延迟的同步,但对数据库日志配置要求较高。

- 触发器:在数据库表上设置触发器来捕获变化。这种方式实现简单,但可能会影响数据库性能。

增量同步在实际应用中可以显著减少同步时间和网络流量,尤其在大数据量的场景下。这种优化不仅提高了系统的整体性能,还降低了对系统资源的需求。

增量同步的选择通常与业务需求紧密相关,例如数据实时性要求、系统负载能力以及网络环境等。在实践中,选择合适的CDC技术和策略是实现增量同步的关键。

🚀 如何在复杂环境下实现高效的数据增量同步?

我们公司有多个数据库和数据仓库,数据量级很大,表结构也相对复杂。在这样的环境下,如何能高效地实现数据增量同步呢?有没有一些成功的经验可以借鉴?

在复杂环境中实现高效的数据增量同步挑战不小,尤其是当涉及多个数据库和数据仓库时。成功的关键在于选择合适的工具和技术,并制定合理的策略。

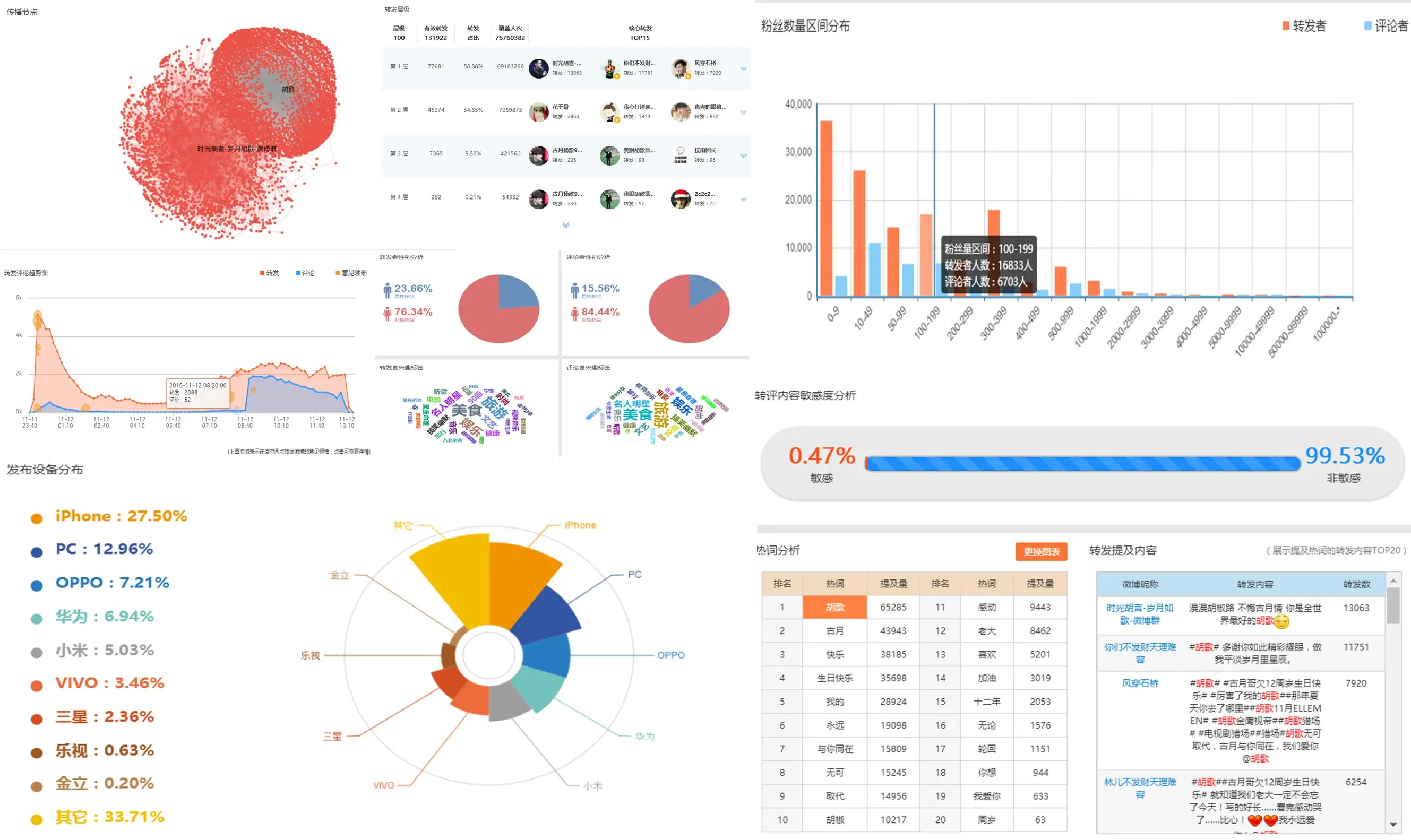

首先,选择一个强大的数据集成工具至关重要。像FineDataLink这样的工具,通过低代码平台提供了一站式数据集成解决方案,简化了配置和管理过程。它不仅支持多种数据源的实时全量和增量同步,还能适应不同表结构和数据量级的需求。具体体验可以查看 FineDataLink体验Demo 。

成功实现高效增量同步需要注意以下几点:

- 数据源适配:确保工具能支持多种数据源的同步,包括关系型数据库、NoSQL数据库和数据仓库等。

- 实时性和延迟:根据业务需求调整同步方式,实时同步适合对实时性要求高的场合,而离线同步则适合大批量数据处理。

- 负载管理:监控系统资源使用情况,防止同步过程过度占用资源,影响其他业务。

- 数据治理和质量控制:确保同步数据的一致性和准确性,避免数据丢失或错误。

在实操中,借鉴一些成功案例也很有帮助。例如,某大型电商企业通过FineDataLink实现了实时订单数据的增量同步,有效提升了数据处理效率,并减少了系统负载。

💡 在数据增量同步中有哪些常见的坑和解决方案?

了解完数据增量同步的基本原理和实现方法后,还是担心在实操中会踩坑。大家有没有遇到过一些问题?这些坑该怎么避免,有没有行之有效的解决方案?

实现数据增量同步过程中可能遇到一些常见的坑,但提前了解这些问题,并采取相应的解决方案,可以大幅降低风险。

- 数据一致性问题:在增量同步中,确保源数据和目标数据的一致性至关重要。同步过程中可能出现数据丢失或重复的情况。解决方案包括使用事务机制确保同步过程的完整性,以及定期进行数据校验。

- 性能瓶颈:大数据量的增量同步有时会导致性能瓶颈,影响系统其他业务。可以通过优化同步策略,例如批量处理、异步同步等方式来缓解性能压力。

- 网络延迟和中断:实时同步对网络稳定性要求高,网络延迟或中断可能导致数据传输失败。解决方案包括使用可靠的网络协议和设置数据重传机制。

- 权限和安全:在配置数据源和目标时,确保权限设置正确,避免因权限问题导致同步失败。同时,注意数据传输过程中的安全防护,例如数据加密。

解决这些问题时,经验分享和工具选择都很重要。使用成熟的工具和平台,如FineDataLink,可以简化配置和管理过程,降低踩坑风险。此外,关注社区和行业动态,学习他人的经验也是避免问题的重要渠道。

通过合理的规划和准备,可以有效避免这些常见问题,实现高效、可靠的数据增量同步。