在数字化转型的浪潮中,数据抽取成为了企业掌握市场动态、优化业务决策的关键。然而,面对海量数据和复杂的业务需求,不少企业在数据抽取过程中遇到了性能瓶颈和工具选择的困惑。尤其是对于使用R语言进行数据抽取的技术人员而言,如何选择合适的工具和方法,不仅关乎工作效率,更影响到数据的质量和实用性。这篇文章将深入探讨如何使用R语言进行数据抽取,提供实用的技术教程与工具推荐,帮助你在数据处理的道路上少走弯路。

🚀一、R语言数据抽取的基础概念与流程

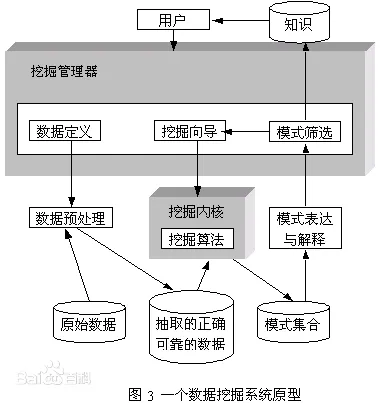

在进行数据抽取之前,理解相关的基础概念和流程是至关重要的。数据抽取不仅仅是从数据库或数据源获取信息的过程,更涉及到数据的清洗、转换和加载。这一过程通常被称为ETL(Extract, Transform, Load),而R语言提供了丰富的工具和包来支持这一过程。

1. 数据抽取的基本步骤

数据抽取通常包括以下几个步骤:

- 数据连接:与数据源建立连接以便访问数据。

- 数据读取:从数据源读取数据并加载到R环境中。

- 数据清洗:处理数据中的缺失值、重复值和异常值。

- 数据转换:根据分析需求对数据进行格式转换或聚合。

- 数据存储:将处理后的数据保存到数据库或文件中以备后续使用。

下表展示了数据抽取过程中的关键步骤及其作用:

| 步骤 | 作用 | 工具与方法 |

|---|---|---|

| 数据连接 | 建立与数据源的连接 | DBI, odbc |

| 数据读取 | 获取数据进入R环境 | readr, data.table |

| 数据清洗 | 修复数据质量问题 | dplyr, tidyr |

| 数据转换 | 格式转换、数据聚合 | dplyr, reshape2 |

| 数据存储 | 将数据保存到指定位置 | RSQLite, write.csv |

2. 数据连接与读取

在数据抽取过程中,首要任务是与数据源建立连接。R语言提供了多种包来支持与不同类型的数据源的连接,如DBI和odbc包,它们可以帮助你与SQL数据库、Excel文件等建立连接。

DBI包通常用于与SQL数据库的交互,它提供了一组统一的接口来执行SQL命令和提取数据。而odbc包则支持与ODBC兼容的数据源连接,这对于需要访问多种不同数据库的场景非常有用。

一旦连接建立,你可以使用readr或data.table包来读取数据。readr包提供了高效的数据导入功能,适合处理CSV文件等常见格式。而data.table则是处理大规模数据集的利器,因其内存效率和速度而广受欢迎。

3. 数据清洗与转换

在数据抽取过程中,清洗和转换是确保数据质量的关键步骤。R语言中的dplyr和tidyr包提供了强大的数据处理功能。

dplyr包提供了一套简单且高效的函数来进行数据筛选、排序和聚合。它的设计理念是让用户能够以最少的代码实现复杂的数据操作。而tidyr包则专注于数据整形,它可以帮助你将数据从宽格式转换为长格式,或反之。

对于数据转换,除了基本的清洗操作之外,reshape2包可以帮助你对数据进行复杂的聚合和转换。无论是将数据汇总到不同的维度,还是进行跨表的操作,reshape2都能提供灵活的解决方案。

4. 数据存储与管理

数据处理的最后一步是存储与管理。经过清洗和转换的数据通常需要保存至数据库或文件中,以供后续分析使用。R语言提供了多个包支持这一功能。

RSQLite是一个轻量级的数据库管理系统,它允许你在R环境中创建、查询和操作SQLite数据库。而对于文件存储,write.csv等函数可以帮助你将数据导出为CSV文件,方便共享和分发。

通过以上步骤,你可以在R语言中实现从数据连接到存储的完整数据抽取过程。理解这一流程不仅能帮助你提高工作效率,更能确保数据质量和实用性。

📊二、R语言数据抽取的工具推荐与对比

在选择R语言数据抽取工具时,了解各工具的优劣势和适用场景尤为重要。以下将介绍几款常用的R语言数据抽取工具,并进行详细对比。

1. 常用工具概览

在R语言中,有多种工具可以用于数据抽取,每种工具都有其独特的功能和适用场景。以下是几款常用的数据抽取工具:

- tidyverse:一个集合了多种数据处理包的综合性工具集。

- data.table:高效的数据处理包,适合大规模数据集。

- RODBC:用于与ODBC兼容数据库交互的工具。

- DBI:提供与多种数据库连接的通用接口。

- RSQLite:轻量级数据库管理工具,适合小型数据存储。

2. 工具功能对比

不同工具在功能、性能、易用性等方面各有优势。下表对比了几款常用R语言数据抽取工具的关键特性:

| 工具 | 功能 | 性能 | 易用性 | 适用场景 |

|---|---|---|---|---|

| tidyverse | 数据清洗与转换 | 中等 | 高 | 中小型数据集 |

| data.table | 高效数据处理 | 高 | 中 | 大规模数据集 |

| RODBC | 数据库连接 | 中等 | 中 | 多数据库连接 |

| DBI | 通用数据库接口 | 中等 | 高 | SQL数据库 |

| RSQLite | 数据库管理 | 低 | 高 | 小型数据存储 |

3. 工具适用性与选择建议

在选择合适的工具时,除了功能和性能外,还需考虑工具的适用性:

- tidyverse适合初学者和中小型数据处理任务,它的易用性高,可以快速上手。

- data.table则适合处理大规模数据集,尤其在内存使用和处理速度上表现优异。

- RODBC和DBI适合需要与多种数据库交互的场景,它们提供了灵活的数据库连接能力。

- RSQLite适合小型数据存储需求,尤其在需要轻量级数据库管理的场景中表现突出。

根据你的具体需求和数据规模,选择合适的工具可以最大化数据处理效率和结果质量。对于需要处理复杂的数据抽取任务的企业,推荐使用国产的低代码ETL工具FineDataLink,它支持高效的数据集成和管理: FineDataLink体验Demo 。

📈三、R语言数据抽取的实用技巧与案例分享

在实际应用中,掌握一些实用技巧和了解成功案例可以帮助你更好地进行数据抽取。以下将分享几个常见的R语言数据抽取技巧以及相关案例。

1. 高效数据处理技巧

在进行数据抽取时,掌握高效的数据处理技巧可以显著提高工作效率:

- 批量数据导入:使用data.table包的fread函数,可以快速导入大规模数据集。

- 并行处理:通过使用parallel包,实现数据的并行处理以提高速度。

- 数据缓存:利用R语言的缓存功能,避免重复计算,提高数据处理效率。

2. 数据清洗与转换的最佳实践

在数据清洗与转换过程中,以下最佳实践可以帮助你提高数据质量:

- 缺失值处理:使用tidyr包的fill函数填补缺失数据。

- 异常值检测:通过dplyr包的filter函数筛选异常数据。

- 数据格式转换:利用reshape2包的melt和cast函数进行数据格式转换。

3. 成功案例分享

通过以下成功案例,了解如何灵活应用R语言进行数据抽取:

- 市场分析:某电商公司使用tidyverse和data.table包进行市场数据分析,通过数据抽取优化了产品推荐策略。

- 客户行为分析:某金融机构通过RODBC与多个数据库连接,提取客户交易数据,实现了精准的客户行为分析。

- 生产数据监控:某制造企业利用DBI和RSQLite进行生产数据的实时监控,提高了生产效率和质量控制。

在这些案例中,企业通过R语言的数据抽取实现了业务优化和决策支持。掌握这些技巧和了解成功案例,可以帮助你在数据处理的道路上获得更多启发和提升。

📚四、结论与进一步阅读

本文介绍了如何使用R语言进行数据抽取的基础概念与流程、工具推荐与对比以及实用技巧与案例分享。通过理解数据抽取的基本步骤和选择合适的工具,你可以显著提高数据处理效率和质量。进一步阅读以下文献和书籍可以帮助你深入了解R语言的数据处理能力:

- 《R for Data Science》 by Hadley Wickham and Garrett Grolemund

- 《Advanced R》 by Hadley Wickham

- 《Introduction to Statistical Learning》 by Gareth James, Daniela Witten, Trevor Hastie, and Robert Tibshirani

这些资源提供了关于R语言数据处理的深刻见解和实用技巧,可以帮助你在数据科学领域不断进步和创新。

本文相关FAQs

🛠️ 如何用R语言连接数据库进行数据抽取?

最近公司项目需要处理大量数据,我听说R语言在数据分析方面很强,但还是个新手。想知道如何用R语言连接数据库进行数据抽取,比如连接MySQL或者PostgreSQL数据库。有大佬能分享一下详细的操作步骤和注意事项吗?

在数据分析领域,R语言一直备受推崇。为了连接数据库进行数据抽取,R提供了一系列工具包,其中最常用的是DBI和RMySQL或RPostgreSQL。这些包能够帮助我们实现与不同类型数据库的连接,并进行数据操作。

首先,确保本地安装了R和数据库相关的R包。比如,如果要连接MySQL数据库,则需要安装RMySQL包。可以通过运行以下命令来安装:

```R

install.packages("DBI")

install.packages("RMySQL")

```

安装完毕后,使用DBI包提供的接口来创建数据库连接。以下是一个连接MySQL数据库的基本示例:

```R

library(DBI)

con <- dbConnect(RMySQL::MySQL(),

dbname = "your_db_name",

host = "your_host_name",

port = 3306,

user = "your_username",

password = "your_password")

```

连接成功后,可以使用dbGetQuery函数来执行SQL查询并提取数据。例如,提取某个表的数据:

```R

data <- dbGetQuery(con, "SELECT * FROM your_table_name")

```

在使用过程中,注意网络连接、权限设置以及SQL语句的正确性。这些因素都可能导致连接失败或数据提取不完整。

此外,数据库连接需要谨慎管理。建议在完成数据提取后关闭连接,以释放资源:

```R

dbDisconnect(con)

```

通过这种方式,R不仅能高效地连接数据库,还能进行数据分析和可视化。对于大规模数据抽取,可以进一步优化SQL查询或使用数据库视图,以提高性能。

📊 如何在R中处理大规模数据抽取的性能问题?

用R连接数据库后,数据量一大性能就会下降。尤其是处理上百万行的数据时速度很慢。有没有什么技巧或工具可以帮助提高数据抽取效率?

处理大规模数据抽取时,性能确实是一个关键问题。R语言本身在处理数据方面有优势,但网络传输和内存管理可能成为瓶颈。以下是一些提高性能的方法:

- 批量数据抽取:避免一次性抽取所有数据。可以分批次抽取,并将每批数据处理后存储。例如,使用SQL中的

LIMIT和OFFSET进行分页查询。 - 优化SQL查询:确保SQL查询高效,避免复杂的联表操作,尽量使用索引。可以通过数据库管理工具分析查询计划,找到性能瓶颈。

- 数据缩减:在SQL层面先进行数据过滤和聚合,减少传输的数据量。例如,通过

WHERE条件过滤只需要的行。 - 使用数据格式优化:考虑使用二进制格式(如Parquet或Feather)传输数据。这些格式在传输和读取时效率更高。

- 内存管理:R语言中可以使用

data.table包代替data.frame,因为data.table在处理大规模数据时内存占用更少,速度更快。 - 并行处理:利用R中的并行处理包(如

parallel或future)分割任务,提高数据处理的速度。

如果企业需要频繁处理大规模数据,并且对实时性有高要求,可以考虑使用专门的数据集成工具,如 FineDataLink体验Demo 。这种工具可以帮助实现高效的数据同步和处理,减少开发和维护成本。

通过以上方法,不仅可以大幅提高数据抽取的效率,还能优化数据分析的整体流程。

🔍 如何在R中实现数据抽取后的数据治理?

抽取的数据质量参差不齐,分析起来很头疼。有没有什么工具或者方法可以帮助我在R中进行数据治理,确保数据质量?

数据治理是数据分析中至关重要的一环,确保数据质量是后续分析准确性的基础。在R中进行数据治理,可以借助一些工具和方法:

- 数据清洗:使用R中的

dplyr和tidyr包进行数据清洗。dplyr用于数据筛选、分组、变换,tidyr可以帮助整理数据结构。通过这些包,可以有效处理缺失值、重复值和异常值。

```R

library(dplyr)

cleaned_data <- raw_data %>%

filter(!is.na(column_name)) %>%

distinct()

```

- 一致性检查:确保数据格式统一。可以使用

lubridate包处理日期时间格式,确保所有日期列符合统一标准。 - 数据验证:设置规则验证数据,例如使用条件语句检查数据范围是否合理。

- 可视化检查:使用R中的

ggplot2包可视化数据,帮助发现潜在的异常和趋势。例如,通过箱线图观察数据分布。 - 数据标准化:在必要时,进行数据标准化处理,比如归一化或尺度化,确保各个数据字段在同一量纲下。

- 自动化脚本:编写R脚本自动进行上述治理步骤,减少人工操作的误差和工作量。

这些方法可以帮助提高数据质量,确保分析结果的可靠性和准确性。在数据治理过程中,如果觉得单纯靠R难以管理复杂的数据任务,也可以考虑使用一站式数据治理平台,比如FineDataLink。这种平台不仅可以简化数据治理流程,还能提供实时监控和报告功能。

通过合理的数据治理,企业能够更好地实现数据驱动的决策支持,提升业务价值。