在现代商业环境中,企业面临着海量的数据存储和分析需求。然而,选择一个合适的数据汇聚平台并不是一件轻松的事情。很多企业往往会遇到这样的困惑:如何在众多工具中找到那个可以有效提高数据分析深度与广度的解决方案?这不仅仅是技术上的问题,更是涉及到企业战略的关键决策。本文将帮助您厘清思路,找到适合的数据汇聚平台,为您的业务数字化转型提供坚实的基础。

📊 一、了解数据汇聚平台的重要性

1. 数据汇聚平台的定义与作用

数据汇聚平台是企业进行数据管理的核心环节。它不仅仅是一个简单的数据存储工具,而是一个能够整合、管理和分析多源数据的综合解决方案。在这个过程中,数据被从不同的数据源中提取、转换并加载到一个统一的存储系统中。这样的平台使得企业可以更好地理解客户行为、优化业务流程,并做出更明智的决策。

2. 数据汇聚平台的功能矩阵

在选择数据汇聚平台时,了解其功能矩阵是至关重要的。以下是一个典型的数据汇聚平台功能矩阵:

| 功能模块 | 作用描述 | 优势 | 劣势 |

|---|---|---|---|

| 数据集成 | 提供多源数据的统一整合 | 数据源多样,处理灵活 | 可能需要复杂的配置与开发 |

| 数据治理 | 确保数据质量和一致性 | 提高数据准确性和可靠性 | 需要持续的监控和管理 |

| 数据分析 | 提供实时和历史数据分析 | 深入洞察,支持决策 | 可能对计算能力要求较高 |

| 数据可视化 | 将数据转化为易于理解的图表和报告 | 直观展示,便于理解和沟通 | 可能需要专业的设计能力 |

3. 数据汇聚平台的市场趋势

随着大数据的普及,数据汇聚平台的市场也在迅速扩大。根据Gartner的研究报告,到2025年,超过80%的企业将通过数据汇聚平台进行数字化转型。这意味着企业在选择平台时,不仅要考虑当前的需求,还要考虑未来的扩展性和灵活性。

🔍 二、选择数据汇聚平台的关键因素

1. 业务需求与平台适配

选择合适的数据汇聚平台,首先需要明确业务需求。这包括数据量、数据类型、数据处理速度以及具体的分析需求。不同的业务需求决定了对平台功能的不同侧重。因此,企业需要从以下几个方面进行评估:

- 数据量与数据类型:确定需要处理的数据量以及数据的来源和类型。

- 实时性与历史数据:分析是否需要实时数据处理,还是主要依赖历史数据分析。

- 用户数量与权限管理:考虑使用平台的用户数量以及权限管理的复杂性。

2. 平台的技术架构与扩展性

技术架构直接影响平台的性能和扩展性。在选择平台时,需要关注以下技术特性:

- 可扩展性:平台能否支持业务的增长,是否可以轻松增加新的数据源和用户。

- 兼容性:平台是否兼容现有的IT环境和应用程序。

- 安全性:数据的安全性和隐私保护措施是否到位。

3. 成本与投资回报

成本是企业选择平台时的重要考虑因素。需要从以下几个方面进行评估:

- 初始部署成本:包括软硬件购买、实施和培训费用。

- 运营维护成本:持续的运营和维护费用。

- 投资回报率:通过使用平台带来的直接和间接收益。

🛠 三、数据汇聚平台的实施与优化

1. 实施流程与步骤

实施数据汇聚平台通常包括以下几个步骤:

- 需求分析:明确业务需求和目标。

- 平台选择:根据需求选择合适的平台。

- 测试与部署:进行平台测试,并在生产环境中部署。

- 用户培训:对用户进行培训,确保他们能够有效使用平台。

2. 数据治理与质量管理

数据治理是确保数据质量和一致性的关键。以下是数据治理的几个重要方面:

- 数据标准化:确保数据格式和定义的一致性。

- 数据清洗:去除错误和重复的数据。

- 数据监控:持续监控数据质量和一致性。

3. 持续优化与更新

数据汇聚平台的优化是一个持续的过程,需要不断更新和调整:

- 性能优化:通过调整技术架构和硬件配置,提高平台性能。

- 功能更新:根据业务需求,增加或调整平台功能。

- 用户反馈:通过收集用户反馈,不断改进用户体验。

🚀 结尾

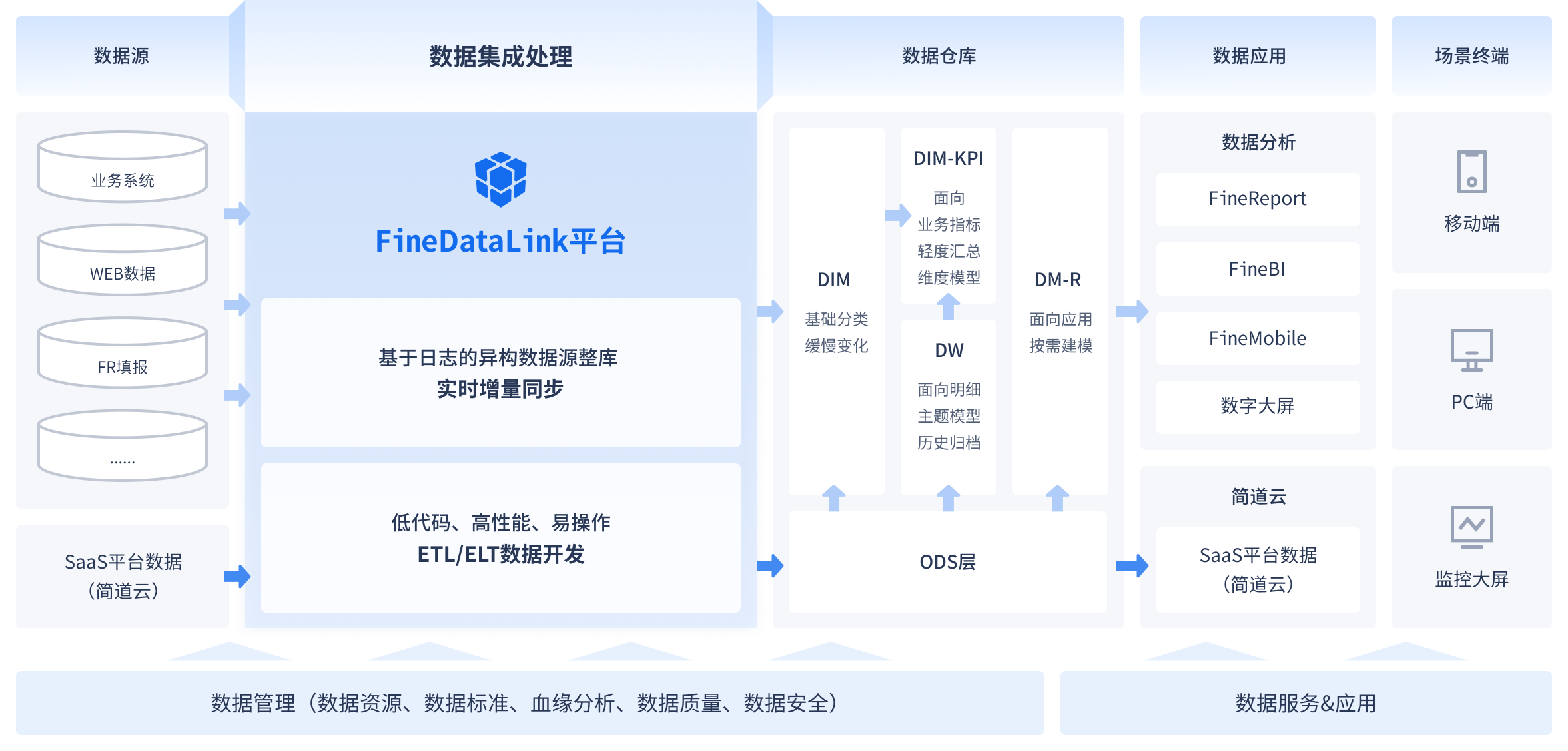

选择合适的数据汇聚平台是企业数字化转型的重要一步。通过对业务需求、技术架构、成本和投资回报的全面评估,企业可以找到最适合自己的平台。在实施和优化过程中,坚持数据治理和质量管理,确保平台的稳定运行和持续改进。FineDataLink作为国产低代码ETL工具,以其高效实用的特性,可以成为您在数据集成和治理方面的理想选择。

在您选择数据汇聚平台的过程中,FineDataLink提供了一种高效、实用的解决方案。通过其低代码平台,企业可以实现复杂的数据集成和治理任务,推动业务的数字化转型。 FineDataLink体验Demo 。

📚 参考文献

- Gartner. (2023). Data Management Solutions Market Trends.

- McKinsey & Company. (2022). The Importance of Data Integration in Digital Transformation.

- Harvard Business Review. (2021). Building a Data-Driven Organization.

本文相关FAQs

🚀 如何评估数据汇聚平台的基础能力?

老板要求我们选择一个数据汇聚平台,但市面上有太多选择。有没有大佬能分享一下,如何快速评估一个平台的基础能力?我需要一个简单明了的评估清单,以确保我们不会选错工具,导致后续一堆麻烦。

在选择数据汇聚平台时,评估其基础能力是一个至关重要的步骤。这些基础能力直接决定了平台能否支持企业的实际业务需求。以下是一些关键能力的评估要点:

- 数据连接能力:一个优秀的数据汇聚平台应该能够支持多种数据源,包括但不限于传统关系型数据库、NoSQL数据库、云服务、API接口等。灵活的连接能力保证了平台的适用性和扩展性。

- 实时与离线数据处理:随着业务需求的多样化,平台需要同时支持实时数据流处理和批量离线处理。这两种模式的结合,可以满足企业在不同场景下的不同需求。

- 扩展性:考虑未来的数据增长和业务扩展需求,平台是否能够轻松扩展以处理更大规模的数据?这包括横向扩展数据处理能力以及纵向增加功能模块的能力。

- 数据安全和合规性:确保平台在数据传输和存储过程中具有完善的安全机制,并符合行业及地区的合规要求,如GDPR、HIPAA等。

- 用户界面和易用性:平台的用户界面是否友好,能否通过低代码或无代码的方式实现复杂的数据操作?这直接影响到团队的学习曲线和使用效率。

- 社区和支持:平台是否有活跃的用户社区和良好的技术支持?这些资源在遇到问题时能够提供及时的帮助和解决方案。

通过以上几个方面的评估,企业可以更好地判断一个数据汇聚平台是否适合自身需求,避免后续可能出现的选型错误问题。

🕵️♂️ 如何解决大规模数据同步中的性能问题?

在现有业务环境中,我们的数据量非常大,批量同步已经越来越难以满足需求。有没有大佬能分享一些经验,如何解决大规模数据同步中的性能问题?我希望能找到一些实用的解决方案,避免目标表不可用或者同步时间过长的问题。

面对大规模数据的同步需求,企业常常遇到性能瓶颈。以下是一些解决这些问题的实用策略:

- 增量同步:相比全量同步,增量同步只传输变化的数据,从而大大降低了数据量和同步时间。实现增量同步的关键在于数据变化的捕获机制,常用的方法有日志挖掘和触发器。

- 并行处理:通过将数据分片并行处理,可以有效利用计算资源,提高同步速度。分片的策略可以根据业务逻辑或数据特性来设计,例如按日期、按地理位置等。

- 缓存机制:在同步过程中使用缓存,可以缓解目标数据库的压力。缓存的数据可以在内存中暂存,在适当时机批量写入目标数据库。

- 数据压缩:在传输前对数据进行压缩,可以减少网络带宽的占用,加快传输速度。常用的压缩算法有Gzip、Snappy等。

- 选择合适的工具:FineDataLink(FDL)作为一款低代码、高时效的数据集成平台,能够解决大规模数据同步中的诸多问题。它支持实时和离线数据的采集与集成,提供多种同步策略,并具备强大的扩展性和兼容性。 FineDataLink体验Demo 。

通过以上策略,企业能够在大规模数据同步中实现高性能和高效能,满足业务快速发展的需求。

🤔 如何提升数据汇聚平台中的数据分析深度与广度?

了解完基础能力和性能优化,下一步自然是提高数据分析的深度与广度。有没有大佬能分享一些经验,如何在已有平台上挖掘更深层次的价值?我们希望能将数据分析能力最大化,推动业务的数字化转型。

提升数据分析的深度与广度是企业充分利用数据价值的重要一步。以下是一些具体的方法和策略:

- 多维度数据整合:在数据汇聚平台上,整合来自不同数据源、不同维度的数据,形成统一的数据视图。这种整合可以打破数据孤岛,提供全局的业务洞察。

- 高级分析工具的使用:借助机器学习、深度学习等高级分析工具,深入挖掘数据中的潜在模式和趋势。这些工具可以自动化地处理复杂的数据关系,提供更具洞察力的分析结果。

- 自助式分析:鼓励业务用户通过自助式分析工具进行探索性分析。这种方式让用户能够根据自身的需求,自主发现问题和机会,而不依赖于数据团队的支持。

- 动态可视化:利用动态可视化工具,实时展示数据变化。通过可视化,复杂的数据分析结果可以直观地呈现给决策者,帮助他们快速理解和做出决策。

- 持续学习与优化:数据分析是一个持续的过程。定期回顾分析结果,并根据业务变化和市场反馈进行调整和优化,确保分析的前瞻性和实用性。

通过这些方法,企业可以大幅提升数据分析的深度与广度,为战略决策提供强有力的支持,推动数字化转型的进一步实现。